手动评估模型的性能

在生成式 AI 应用的早期开发阶段,你需要快速试验和迭代。 要想轻松评估你选择的使用提示流创建的语言模型和应用是否满足要求,可以在 Azure AI Foundry 门户中手动评估模型和流。

即使模型和应用已用于生产环境中,手动评估也是评估性能的关键部分。 由于人工评估是由人类完成的,因此它们可以提供自动化指标可能错过的见解。

让我们探索如何在 Azure AI Foundry 门户中手动评估所选的模型和应用。

准备你的测试提示语

若要开始手动评估过程,必须准备一组不同的测试提示语,以反映应用预计要处理的查询和任务的范围。 这些提示语应涵盖各种场景,包括常见用户问题、边缘情况和潜在故障点。 通过这样做,你可以全面评估应用的表现,并确定需要改进的地方。

在聊天操场中测试所选模型

在开发聊天应用程序时,可使用语言模型来生成回复。 可以通过开发一个包含聊天应用程序逻辑的提示流来创建聊天应用程序,它可以使用多种语言模型最终生成对用户问题的回复。

在测试应用的回复之前,可以测试所选语言模型的回复,以验证各个模型是否按预期工作。 可以通过在聊天操场中与之交互测试在 Azure AI Foundry men中部署的模型。

聊天操场非常适合早期开发。 你可以输入提示语,查看模型如何回复,并调整提示语或系统消息以做出改进。 应用更改后,你可以再次测试提示语,以评估模型的性能是否确实有所改进。

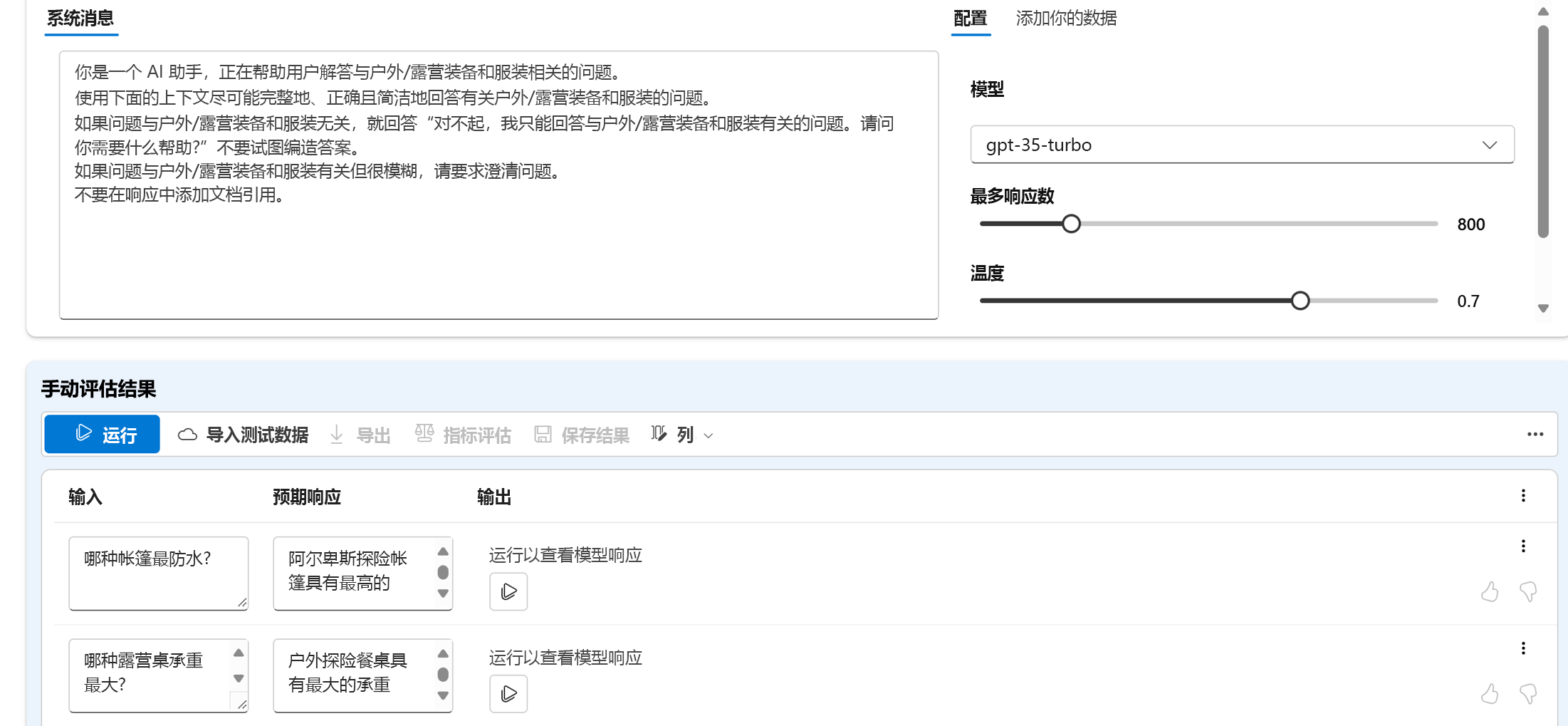

使用手动评估来评估多个提示语

聊天操场是一种简单的开始方法。 若想更快地手动评估多个提示语,可以使用手动评估功能。 此功能允许你上传包含多个问题的数据集,并可选择添加预期的回复,以评估模型在更大测试数据集上的性能。

你可以使用点赞或点踩功能对模型的回复进行评分。 根据整体评级,你可以通过更改输入提示语、系统消息、模型或模型的参数来尝试改进模型。

使用手动评估时,你可以根据不同的测试数据集更快地评估模型的性能,并根据测试结果改进模型。

手动评估单个模型后,你可以使用提示语流将模型集成到聊天应用程序中。 还可以手动或自动评估使用提示语流创建的任何流。 接下来,让我们探讨流评估。