使用 AKS 上的 Azure HDInsight 处理 Apache Flink® 上的实时 IoT 数据

Azure IoT 中心是云中托管的托管服务,充当中心消息中心,用于 IoT 应用程序与其附加设备之间的通信。 你可以可靠地安全地连接数百万台设备及其后端解决方案。 几乎任何设备都可以连接到 IoT 中心。

在此示例中,代码使用 Azure HDInsight 在 AKS 上通过 Apache Flink® 处理实时 IoT 数据,然后将数据下沉至 ADLS gen2 存储。

先决条件

- 创建 Azure IoTHub

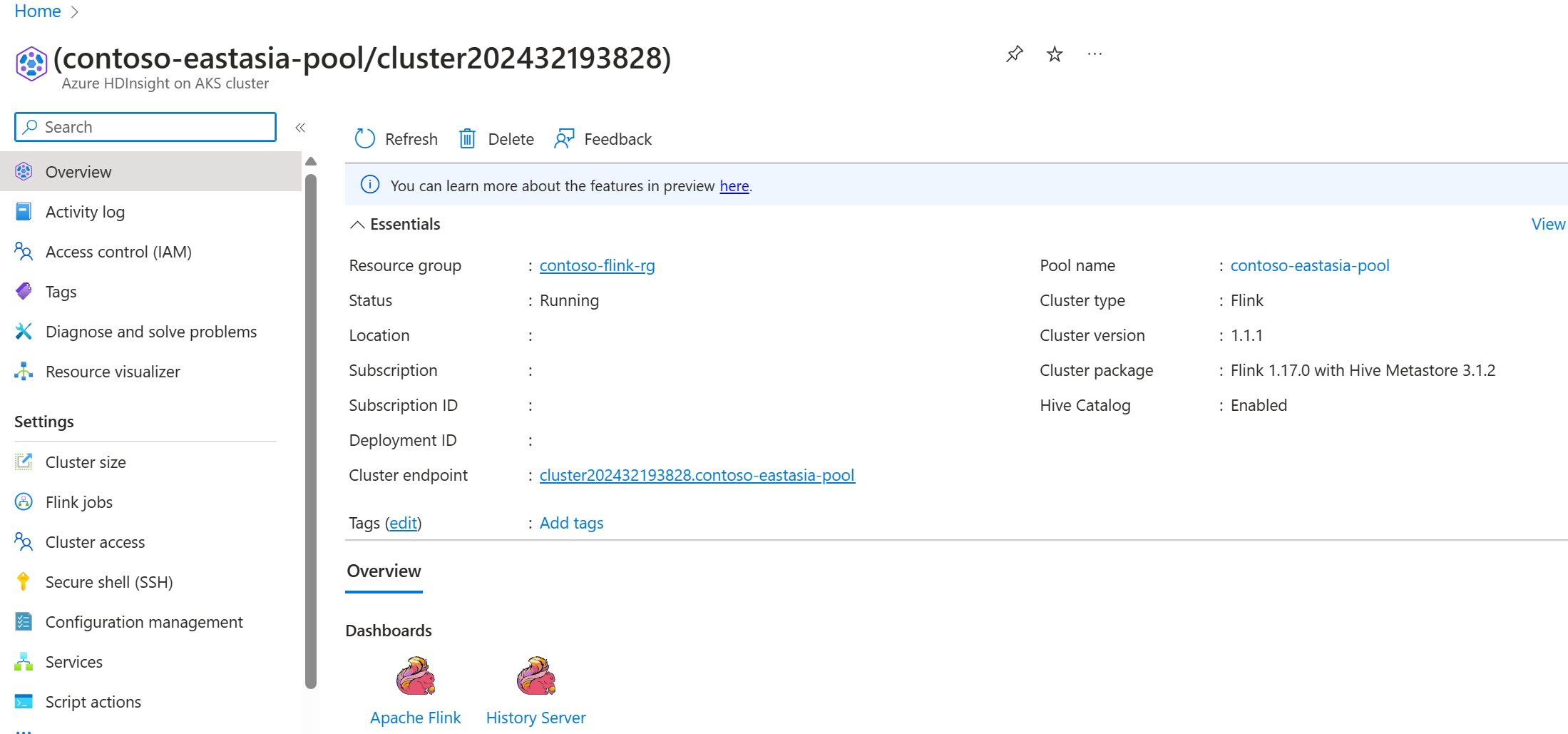

- 在 AKS 的 HDInsight 上创建 Flink 1.17.0 群集

- 使用 MSI 访问 ADLS Gen2

- 用于开发的 IntelliJ

注意

对于此演示,我们在 AKS 上的 HDInsight 所在的同一 VNET 中使用 Windows VM 作为 Maven 项目的开发环境。

AKS 上的 HDInsight 中的 Flink 群集 1.17.0

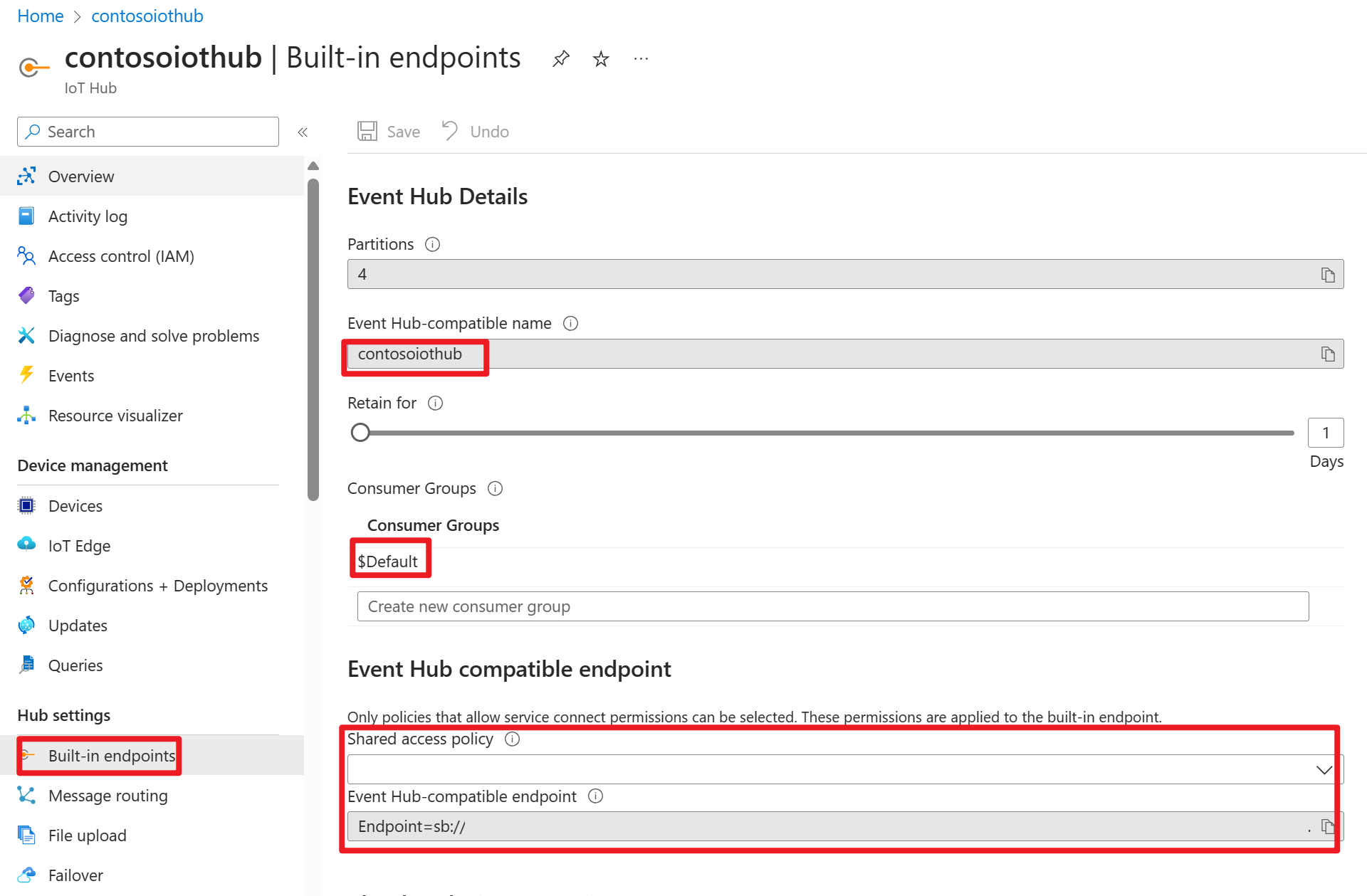

Azure 门户上的 Azure IOT 中心

在连接字符串中,可以找到服务总线 URL(基础事件中心命名空间的 URL),需要在 Kafka 源中将其添加为启动服务器。 在此示例中,它是 iothub-ns-contosoiot-55642726-4642a54853.servicebus.windows.net:9093。

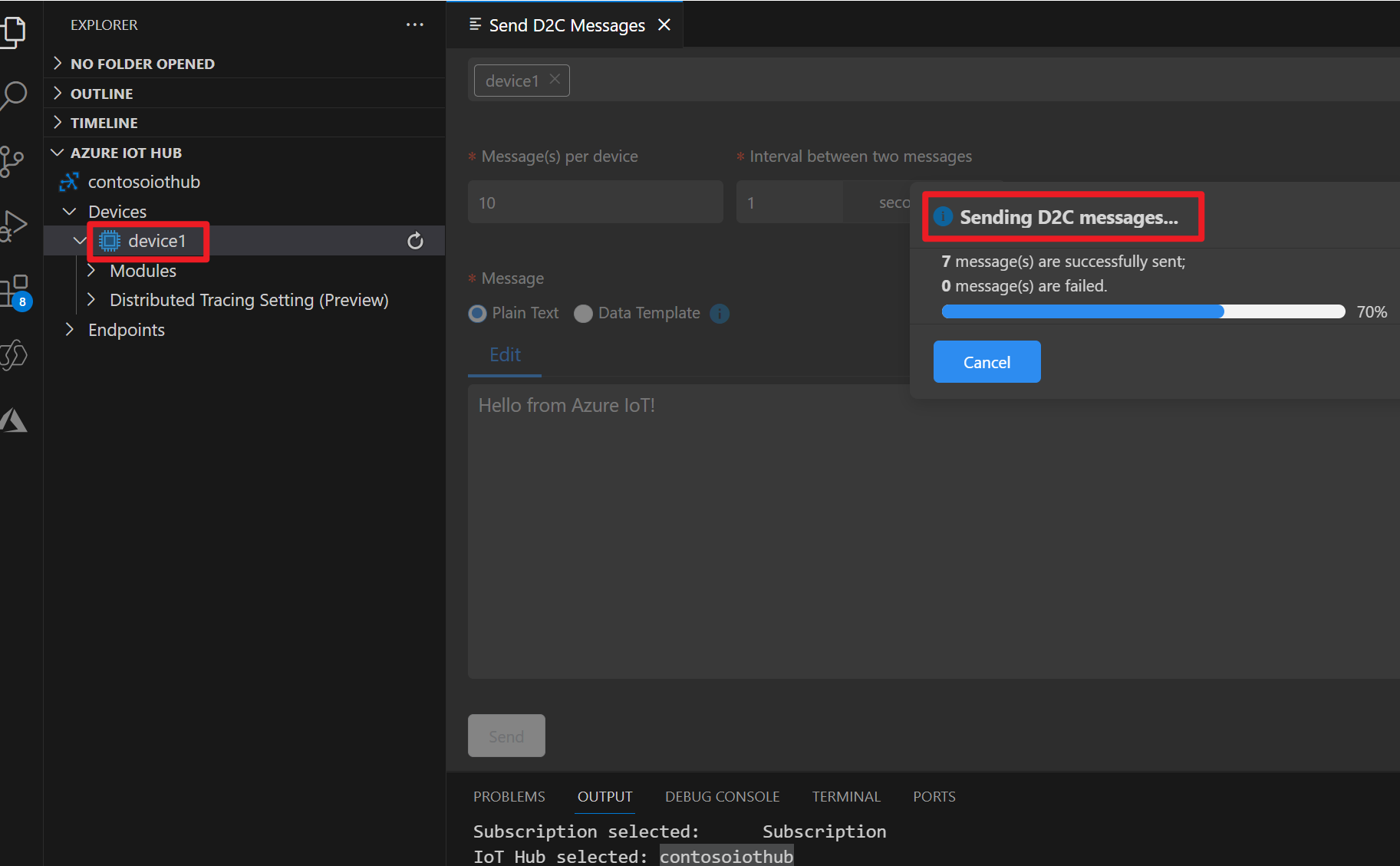

为 Azure IOT 设备准备消息

每个 IoT 中心都附带内置系统终结点,用于处理系统和设备消息。

有关详细信息,请参阅 如何将 VS Code 用作 IoT 中心设备模拟器。

Flink 中的代码

IOTdemo.java

KafkaSource:IoTHub 基于事件中心构建,因此支持类似于 kafka 的 API。 因此,在 Flink 作业中,我们可以使用适当的参数定义 KafkaSource,以使用来自 IoTHub 的消息。

FileSink:定义 ABFS 接收器。

package contoso.example

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.serialization.SimpleStringEncoder;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.client.program.StreamContextEnvironment;

import org.apache.flink.configuration.MemorySize;

import org.apache.flink.connector.file.sink.FileSink;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.core.fs.Path;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.sink.filesystem.rollingpolicies.DefaultRollingPolicy;

import org.apache.kafka.clients.consumer.OffsetResetStrategy;

import java.time.Duration;

public class IOTdemo {

public static void main(String[] args) throws Exception {

// create execution environment

StreamExecutionEnvironment env = StreamContextEnvironment.getExecutionEnvironment();

String connectionString = "<your iot hub connection string>";

KafkaSource<String> source = KafkaSource.<String>builder()

.setBootstrapServers("<your iot hub's service bus url>:9093")

.setTopics("<name of your iot hub>")

.setGroupId("$Default")

.setProperty("partition.discovery.interval.ms", "10000")

.setProperty("security.protocol", "SASL_SSL")

.setProperty("sasl.mechanism", "PLAIN")

.setProperty("sasl.jaas.config", String.format("org.apache.kafka.common.security.plain.PlainLoginModule required username=\"$ConnectionString\" password=\"%s\";", connectionString))

.setStartingOffsets(OffsetsInitializer.committedOffsets(OffsetResetStrategy.EARLIEST))

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

DataStream<String> kafka = env.fromSource(source, WatermarkStrategy.noWatermarks(), "Kafka Source");

String outputPath = "abfs://<container>@<account_name>.dfs.core.windows.net/flink/data/azureiothubmessage/";

final FileSink<String> sink = FileSink

.forRowFormat(new Path(outputPath), new SimpleStringEncoder<String>("UTF-8"))

.withRollingPolicy(

DefaultRollingPolicy.builder()

.withRolloverInterval(Duration.ofMinutes(2))

.withInactivityInterval(Duration.ofMinutes(3))

.withMaxPartSize(MemorySize.ofMebiBytes(5))

.build())

.build();

kafka.sinkTo(sink);

env.execute("Sink Azure IOT hub to ADLS gen2");

}

}

Maven pom.xml

<groupId>contoso.example</groupId>

<artifactId>FlinkIOTDemo</artifactId>

<version>1.0-SNAPSHOT</version>

<properties>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<flink.version>1.17.0</flink.version>

<java.version>1.8</java.version>

<scala.binary.version>2.12</scala.binary.version>

</properties>

<dependencies>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-streaming-java -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-clients -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<!-- https://mvnrepository.com/artifact/org.apache.flink/flink-connector-files -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-files</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>${flink.version}</version>

</dependency>

</dependencies>

<build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<appendAssemblyId>false</appendAssemblyId>

<descriptorRefs>

<descriptorRef>jar-with-dependencies</descriptorRef>

</descriptorRefs>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

</project>

打包 jar 并在 Flink 群集中提交作业

将 JAR 文件上传到 webssh Pod 中,并提交该 JAR 文件。

user@sshnode-0 [ ~ ]$ bin/flink run -c IOTdemo -j FlinkIOTDemo-1.0-SNAPSHOT.jar

SLF4J: Failed to load class "org.slf4j.impl.StaticLoggerBinder".

SLF4J: Defaulting to no-operation (NOP) logger implementation

SLF4J: See http://www.slf4j.org/codes.html#StaticLoggerBinder for further details.

Job has been submitted with JobID de1931b1c1179e7530510b07b7ced858

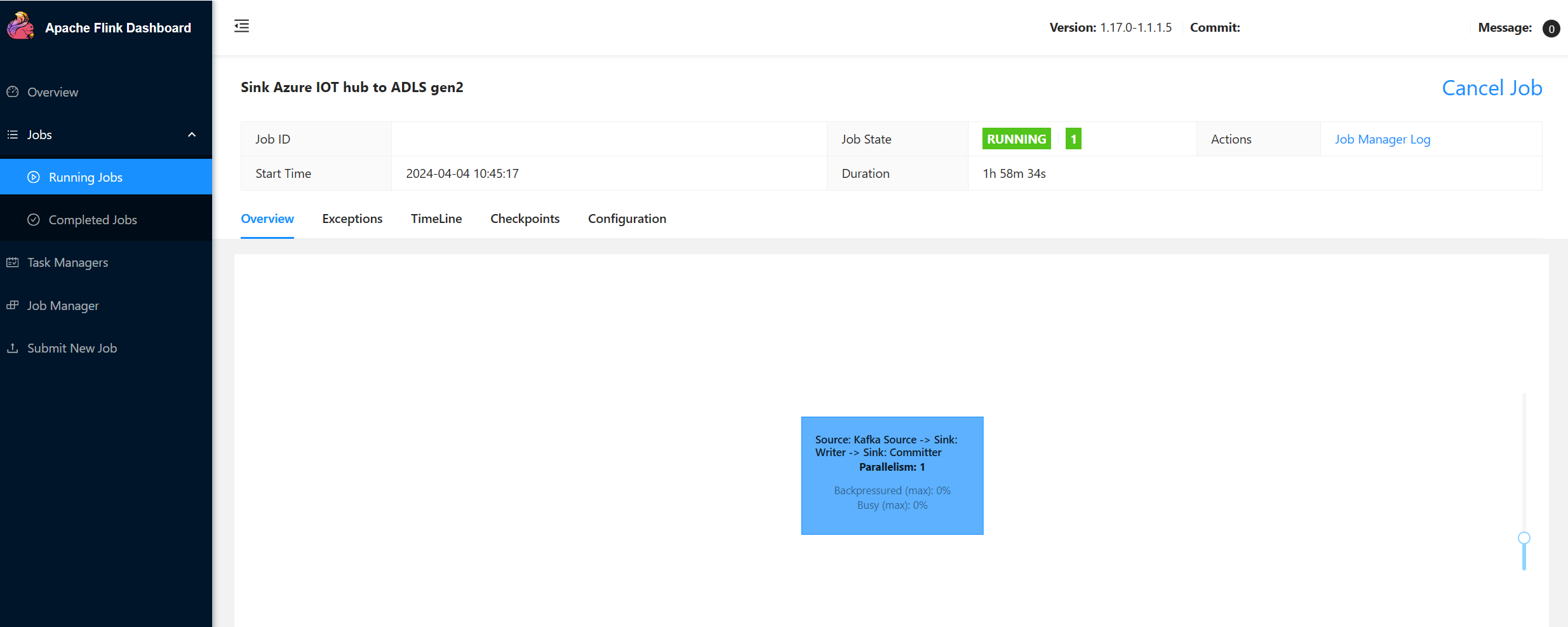

在 Flink 仪表板用户界面上检查作业

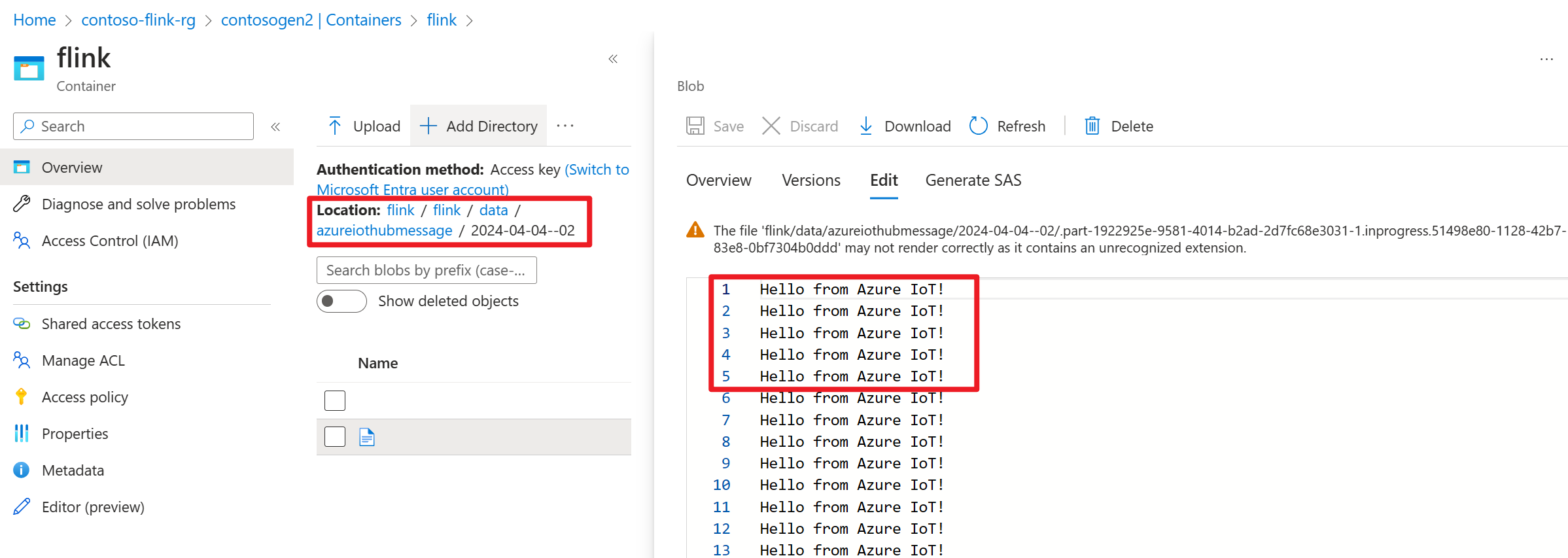

在 Azure 门户中查看 ADLS gen2 的结果

参考

- Apache Flink 网站

- Apache、Apache Kafka、Kafka、Apache Flink、Flink 和关联的开源项目名称是Apache Software Foundation(ASF) 的商标。