将 Apache Kafka 添加为 Fabric 实时中心的源(预览版)

本文介绍如何将 Apache Kafka 添加为 Fabric 实时中心的事件源。

先决条件

- 在 Fabric 容量许可证模式或具有参与者或更高权限的试用许可证模式下访问工作区。

- 正在运行的 Apache Kafka 群集。

- Apache Kafka 必须可供公开访问,并且不能位于防火墙后面或在虚拟网络中受到保护。

数据源页面

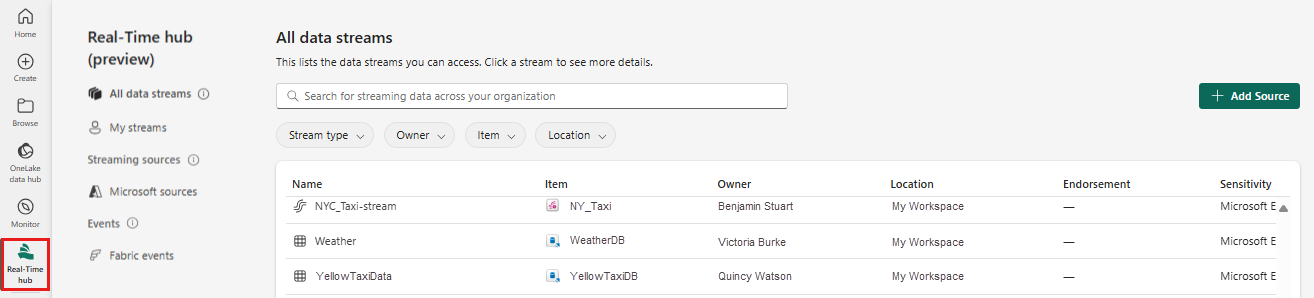

登录 Microsoft Fabric。

选择左侧导航栏上的“实时”。

在“实时中心”页上,选择左侧导航菜单上“连接到”下的“+ 数据源”。 还可以从“所有数据流”或“我的数据流”页面访问“数据源”页,方法是选择右上角的“+ 连接数据源”按钮。

将 Apache Kafka 添加为源

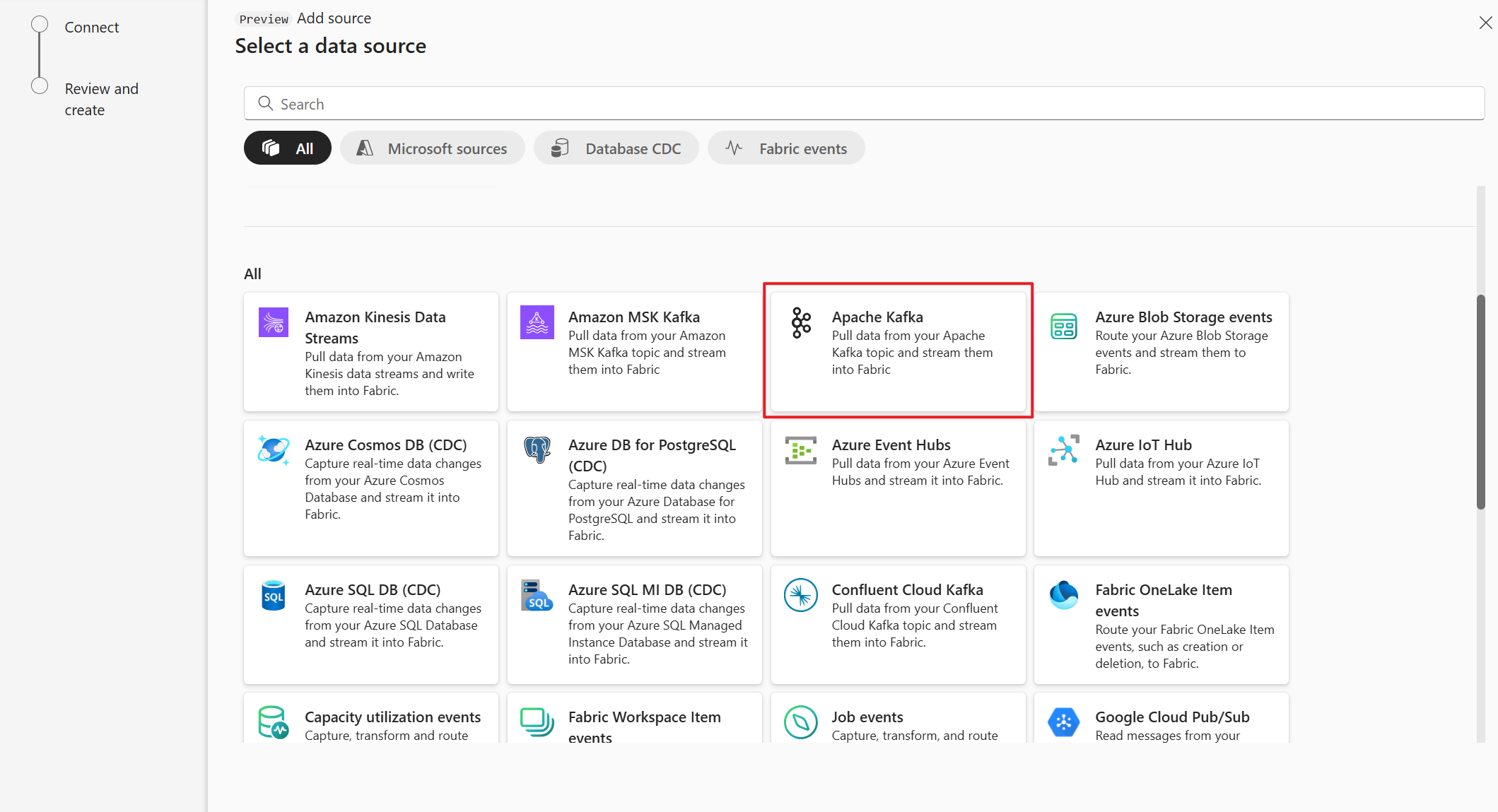

在“选择数据源”页面上,选择“Apache Kafka”。

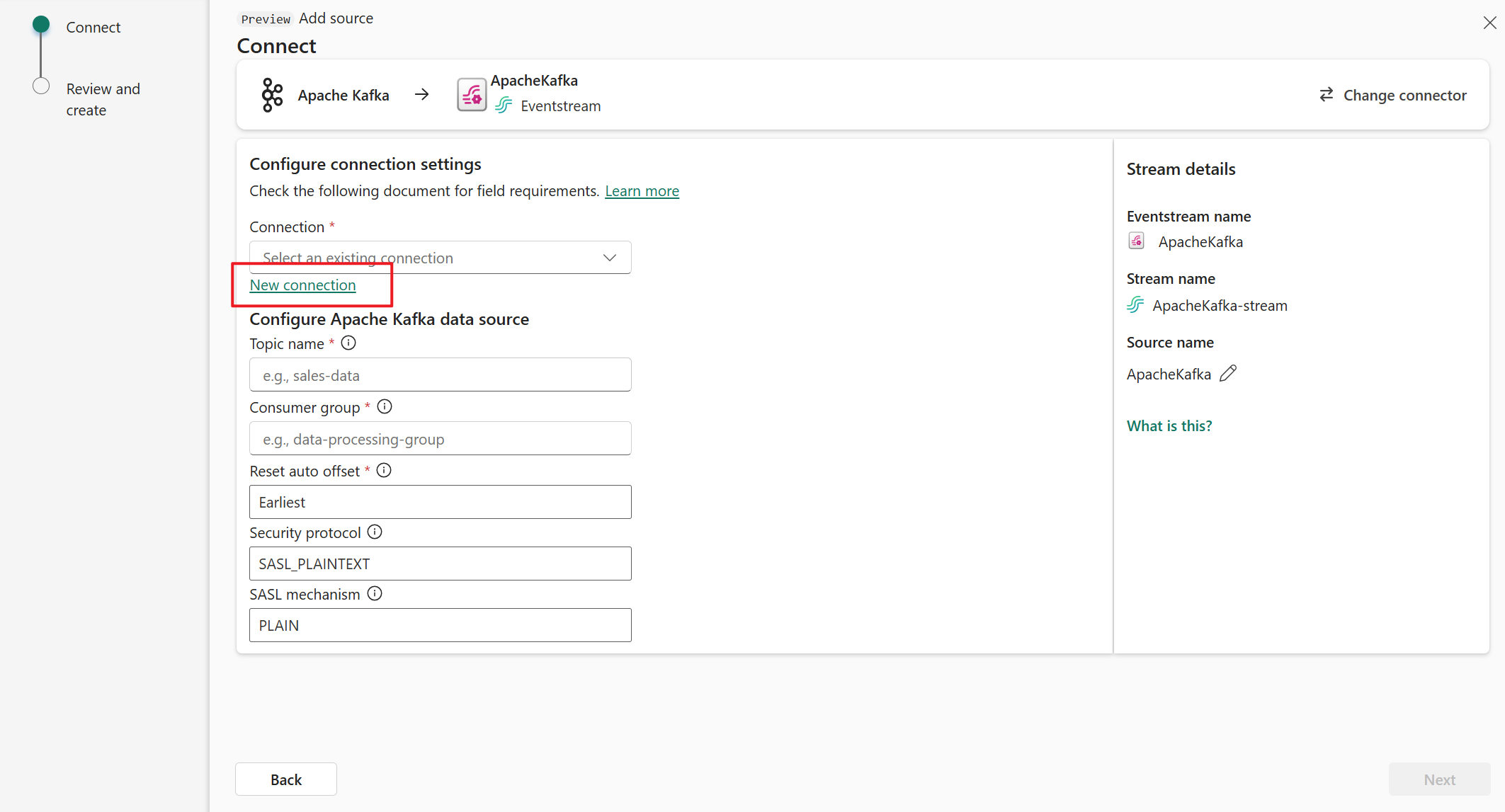

在“连接”页上,选择“新建连接”。

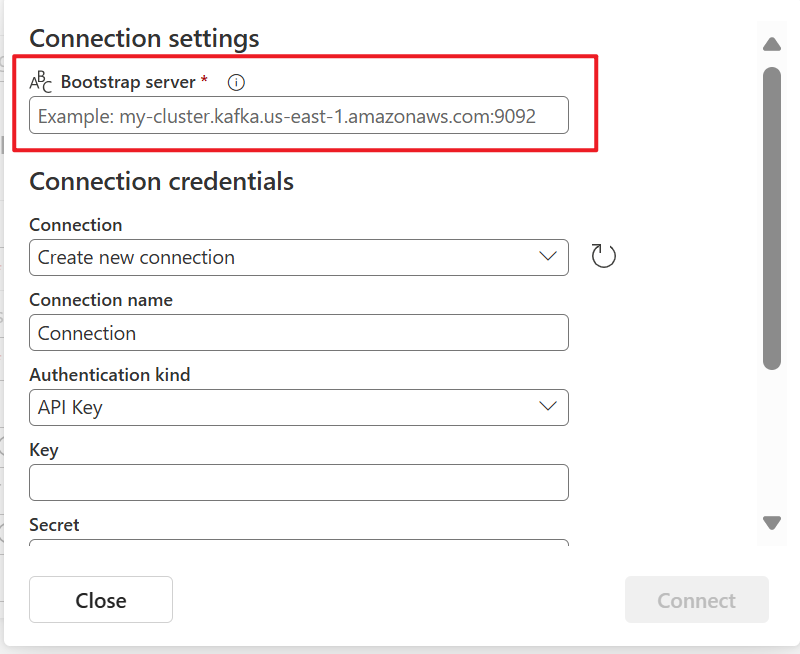

在“连接设置”部分中,针对“启动服务器”输入你的 Apache Kafka 服务器地址。

在“连接凭据”部分中,如果你已有到 Apache Kafka 群集的连接,请从“连接”的下拉列表中选择它。 否则,请执行以下步骤:

- 对于“连接名称”,为连接输入名称。

- 对于“身份验证类型”,请确认已选择“API 密钥”。

- 对于“密钥”和“机密”,输入 API 密钥和密钥机密。

选择“连接” 。

现在,在“连接”页上,按照以下步骤操作。

对于“主题”,输入 Kafka 主题。

对于“使用者组”,输入 Apache Kafka 群集的使用者组。 此字段提供用于获取事件的专用使用者组。

选择“重置自动偏移”以指定在没有提交的情况下从何处开始读取偏移。

对于“安全协议”,默认值是“SASL_PLAINTEXT”。

注意

Apache Kafka 源当前仅支持 Apache Kafka 群集与 Eventstream 之间进行未加密的数据传输(SASL_PLAINTEXT 和 PLAINTEXT)。 即将推出对通过 SSL 进行加密数据传输的支持。

默认的 SASL 机制通常是 PLAIN,除非另有配置。 可以选择符合你的安全要求的 SCRAM-SHA-256 或 SCRAM-SHA-512 机制。

选择下一步。 在“查看并创建”屏幕上,查看摘要,然后选择“添加”。

查看数据流详细信息

在“查看 + 连接”页上,如果选择“打开事件流”,向导会打开使用选定的 Apache Kafka 源为你创建的事件流。 要关闭向导,请选择页面底部的“关闭”。

在“实时中心”中,切换到实时中心的“数据流”选项卡。 刷新该页面。 应会看到为你创建的数据流。

有关详细步骤,请参阅在 Fabric 实时中心查看数据流的详细信息。

相关内容

若要了解有关使用数据流的信息,请参阅以下文章: