使用 Dataflow Gen2 将 2 GB 本地 CSV 数据加载到湖屋表的定价方案

此方案 使用 Dataflow Gen2 将 2 GB 的本地 CSV 数据加载到 Microsoft Fabric 中的湖屋表。

以下示例中使用的价格是假设的,并不意味着确切的实际定价。 这些只是为了演示如何在 Microsoft Fabric 中估算、规划和管理数据工厂项目的成本。 此外,由于 Fabric 容量在各个区域之间定价不同,因此我们使用美国西部 2(典型的 Azure 区域)的 Fabric 容量即用即付定价,即每小时每 CU 0.18 美元。 请参阅此处的 Microsoft Fabric - 定价,以了解其他 Fabric 容量定价选项。

配置

要完成此方案,需要通过以下步骤创建数据流:

- 初始化数据流:首先将 2 GB CSV 文件从本地环境上传到数据流中。

- 配置 Power Query:

- 导航到 Power Query。

- 禁用可用于暂存查询的选项。

- 继续操作以合并 CSV 文件。

- 数据转换:

- 为了清楚起见,提升标头。

- 移除不需要的列。

- 根据需要调整列数据类型。

- 定义输出数据目标:

- 将湖屋配置为数据输出目标。

- 在此示例中,已在 Fabric 中创建并使用了湖屋。

使用 Fabric 指标应用估算成本

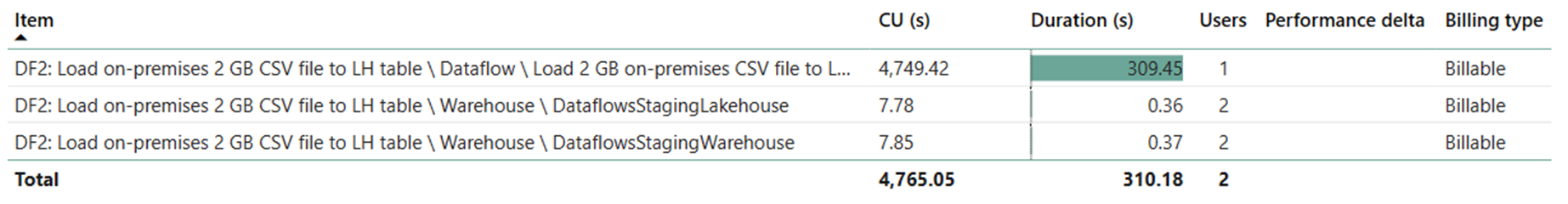

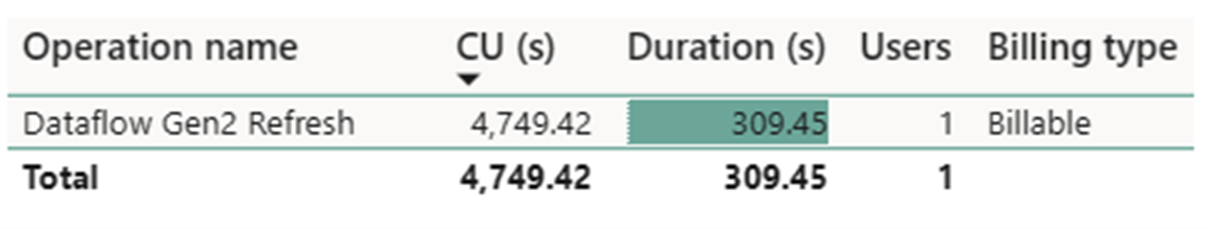

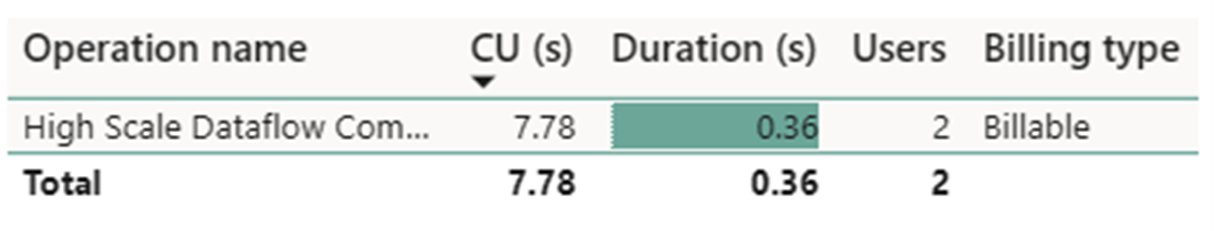

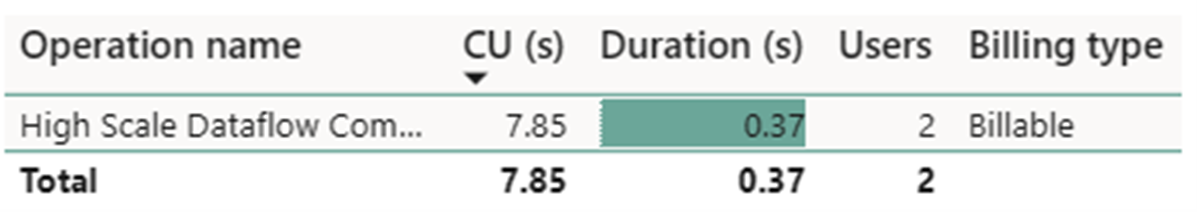

Dataflow Gen2 刷新操作消耗了 4749.42 CU 秒,两个大规模数据流计算操作则分别消耗了 7.78 CU 秒和 7.85 CU 秒。

注意

尽管报告为指标,但在使用 Fabric 指标应用计算有效 CU 小时数时,运行的实际持续时间并不相关,因为它同时报告的 CU 秒指标已考虑到其持续时间。

| 指标 | 计算消耗量 |

|---|---|

| Dataflow Gen2 刷新 CU 秒 | 4749.42 CU 秒 |

| 大规模数据流计算 CU 秒 | (7.78 + 7.85) 15.63 CU 秒 |

| 计费的有效 CU 小时数 | (4749.42 + 15.63) / (60*60) = 1.32 CU 小时 |

按 $0.18/CU 小时计算的总运行成本 =(1.32 CU 小时)*($0.18/CU 小时)~= 0.24 美元