你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

打开模型 LLM 工具

开放模型 LLM 工具支持利用各种开放模型和基础模型(如 Falcon 和 Llama 2),以便在Azure 机器学习提示流中处理自然语言。

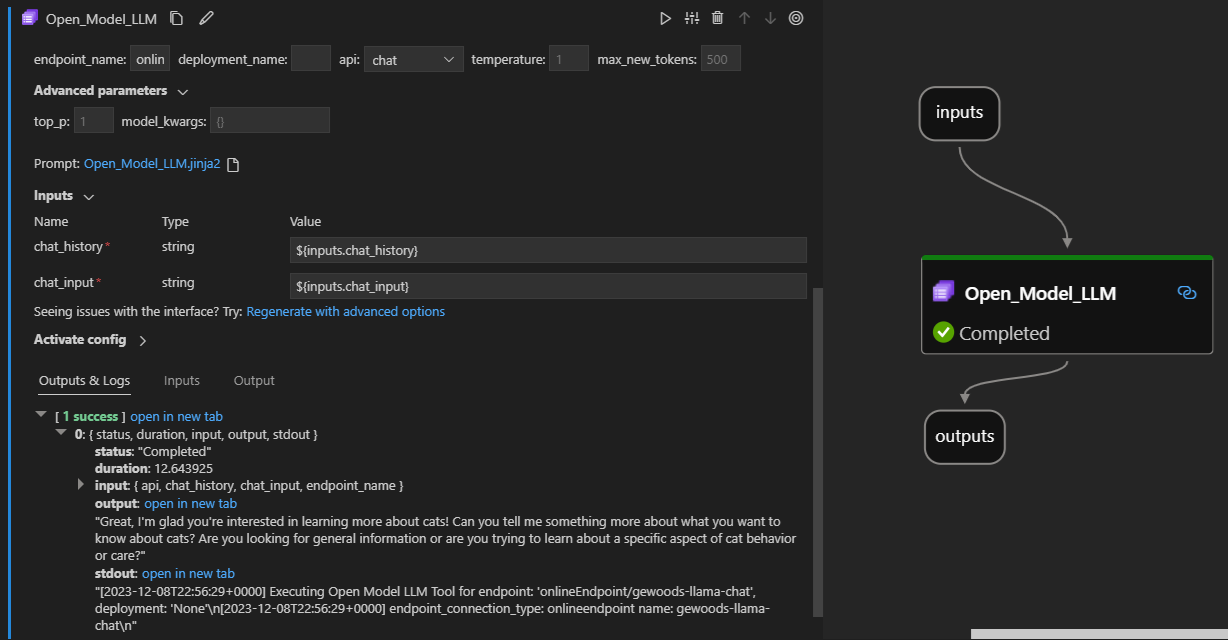

下面是它在 Visual Studio Code 提示流扩展上的工作方式。 在此示例中,该工具用于调用 LlaMa-2 聊天终结点,并询问“什么是 CI?”。

此提示流工具支持两种不同的 LLM API 类型:

- 聊天:如前面的示例所示。 聊天 API 类型通过基于文本的输入和响应促进交互式对话。

- 补全:补全 API 类型用于根据提供的提示输入生成单个响应文本补全。

快速概述:如何实现使用开放模型 LLM 工具?

- 从Azure 机器学习模型目录中选择一个模型并部署它。

- 连接到模型部署。

- 配置打开的模型 llm 工具设置。

- 准备提示。

- 运行流。

先决条件:模型部署

- 从 Azure 机器学习模型目录中选取与你的方案相匹配的模型。

- 使用“部署”按钮将模型部署到Azure 机器学习联机推理终结点。

- 使用“即用即付”部署选项之一。

若要了解详细信息,请参阅 将基础模型部署到用于推理的终结点。

先决条件:连接到模型

若要提示流使用已部署的模型,需要连接到该模型。 可通过两种方法进行连接。

终结点连接

将流关联到Azure 机器学习或 Azure AI Studio 工作区后,开放模型 LLM 工具可以使用该工作区上的终结点。

使用Azure 机器学习或 Azure AI Studio 工作区:如果在基于网页的浏览器工作区之一中使用提示流,则自动启动的工作区上可用的联机终结点。

首先使用 VS Code 或代码:如果在 VS Code 或 Code First 产品/服务中使用提示流,则需要连接到工作区。 Open Model LLM 工具使用 azure.identity DefaultAzureCredential 客户端进行授权。 一种方法是 设置环境凭据值。

自定义连接

Open Model LLM 工具使用 CustomConnection。 提示流支持两种类型的连接:

工作区连接 - 作为机密存储在Azure 机器学习工作区上的连接。 虽然可以使用这些连接,但在很多地方,通常会在 Studio UI 中创建和维护这些连接。 若要了解如何在 Studio UI 中创建自定义连接,请参阅 如何创建自定义连接。

本地连接 - 存储在计算机上的本地连接。 这些连接在 Studio UX 中不可用,但可用于 VS Code 扩展。 若要了解如何创建本地自定义连接,请参阅 如何创建本地连接。

要设置的必需密钥包括:

- endpoint_url

- 此值可在之前创建的推理终结点中找到。

- endpoint_api_key

- 确保将其设置为机密值。

- 此值可在之前创建的推理终结点中找到。

- model_family

- 支持的值:LLAMA、DOLLY、GPT2 或 FALCON

- 此值取决于要针对的部署的类型。

运行工具:输入

Open Model LLM 工具具有许多参数,其中一些参数是必需的。 有关详细信息,请参阅下表,你可以将这些参数与前面的屏幕截图匹配,以便直观地了解。

| 名称 | Type | 描述 | 必需 |

|---|---|---|---|

| api | string | 依赖于所用模型和所选方案的 API 模式。 支持的值:(补全 | 聊天) | 是 |

| endpoint_name | string | 联机推理终结点的名称,其中包含部署的受支持模型。 优先于连接。 | 是 |

| 温度 | FLOAT | 生成的文本的随机性。 默认值为 1。 | 否 |

| max_new_tokens | integer | 在完成中生成的最大令牌数。 默认值为 500。 | 否 |

| top_p | FLOAT | 使用所生成令牌中的最高选项的概率。 默认值为 1。 | 否 |

| model_kwargs | dictionary | 此输入用于提供特定于所用模型的配置。 例如,Llama-02 模型可能使用 {“temperature”:0.4}。 违约: {} | 否 |

| deployment_name | string | 要针对联机推理终结点的部署的名称。 如果未传递任何值,将使用推理负载均衡器流量设置。 | 否 |

| prompt | string | 语言模型用于生成其响应的文本提示。 | 是 |

Outputs

| API | 返回类型 | 说明 |

|---|---|---|

| Completion | 字符串 | 一个预测完成的文本 |

| 聊天 | string | 对话中一个响应的文本 |

部署到联机终结点

将包含开放模型 LLM 工具的流部署到联机终结点时,需要执行额外的步骤来设置权限。 在通过网页进行部署时,可以在系统分配的标识类型与用户分配的标识类型之间进行选择。 无论哪种方式,使用Azure 门户(或类似功能)将“读取者”作业函数角色添加到托管终结点的 Azure 机器学习 工作区或 Ai Studio 项目中的标识。 可能需要刷新提示流部署。