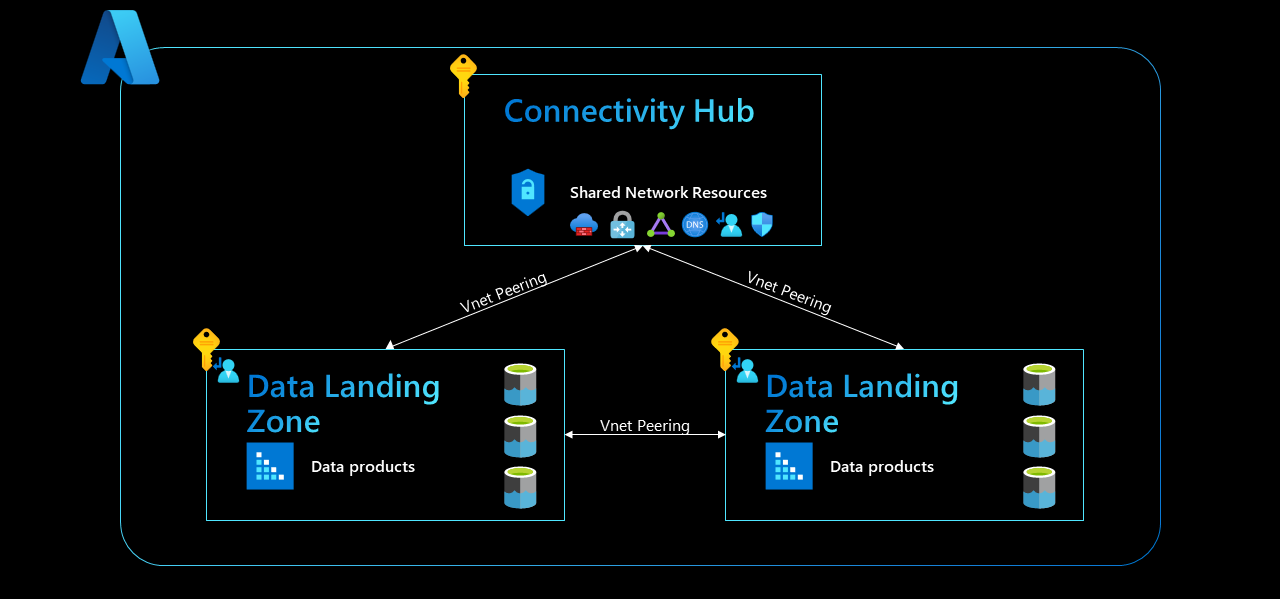

数据管理登陆区域、数据登陆区域以及其中的所有服务都设置在单区域设置中的同一区域中。 所有登陆区域都在同一个连接中心订阅内。 此订阅托管共享网络资源,其中可以包括网络虚拟设备(如 Azure 防火墙)、ExpressRoute 网关、虚拟专用网络 (VPN) 网关、集线器虚拟网络或虚拟 WAN(vWAN 中心)。

图 1:单区域连接。

根据 Azure 网络服务的当前功能,我们建议你使用网状网络体系结构。 应在以下之间设置 Vnet 对等互连:

- 连接中心和数据管理区域

- 连接中心和每个数据登陆区域

- 数据管理区域和每个数据登陆区域

- 每个数据登陆区域

本文描述了我们为云规模分析考虑的每个网络架构选项的优缺点。

本文第一节重点介绍单区域模式,其中数据管理区和所有数据登陆区域都托管在同一区域中。

每个设计模式都使用以下标准进行评估:

- 成本

- 用户访问管理

- 服务管理

- 带宽

- 延迟

我们将在分析每个设计选项时考虑以下跨数据登陆区域用例:

注意

托管在数据登陆区域 B 中的虚拟机 B (VM B) 从托管在数据登陆区域 A 中的存储帐户 A 加载数据集。然后 VM B 处理该数据集并将其存储在托管在数据登陆区域 B 中的存储帐户 B 中。

重要

本文和网络部分的其他文章概述了共享数据的跨业务部门。 但是,这可能不是你的初始策略,你需要首先从基本级别开始。

设计网络,以便最终可以在数据域之间实现建议的设置。 确保将数据管理登陆区域直接连接到登陆区域进行治理。

网格型网络体系结构(推荐)

我们建议你在采用云规模分析时使用网络网格体系结构。 除了在租户中设置的现有中心和辐射网络设计外,还必须执行两项操作来实现网络网格体系结构:

- 在所有数据登陆区域 Vnet 之间添加 Vnet 对等互连。

- 在你的数据管理登陆区域和所有数据登陆区域之间添加 Vnet 配对。

在我们的示例方案中,从存储帐户 A 加载的数据通过在两个数据登陆区域 Vnet 之间设置的 Vnet 对等连接 (2)。 它由 VM B((3) 和 (4))加载和处理,然后通过本地 Private Endpoint (5) 发送到存储帐户 B 中。

在这种方案中,数据不会通过连接中心。 它保留在数据平台中,由数据管理登陆区域和一个或多个数据登陆区域组成的。

图 2:网格型网络体系结构成本。

网格型网络体系结构中的用户访问管理

在网格网络架构设计中,数据应用团队只需要两件事就可以创建新服务(包括专用终结点):

- 对数据登陆区域中的专用资源组的写入权限

- 加入对其指定子网的访问权限

在此设计中,数据应用程序团队可以自己部署专用终结点。 只要团队具有将专用终结点连接到给定分支中的子网的必要访问权限,它们在设置必要的连接时便无需支持。

摘要:![]()

![]()

![]()

网格型网络体系结构中的服务管理

在网格网络体系结构设计中,没有任何网络虚拟设备充当单点故障或带宽限制。 如果你不需要横向扩展该虚拟设备,则无需通过连接中心发送数据集即可减少中心 Azure 平台团队的开销。

这意味着,中心 Azure 平台团队无法再检查和记录在数据登陆区域之间发送的所有流量。 然而,云规模分析是一个跨多个订阅的连贯平台,它允许规模并克服平台级别的限制,因此这不是一个缺点。

由于所有资源都托管在单个订阅中,因此你的中央 Azure 平台团队也不再检查中央连接中心中的所有数据。 仍然可以使用网络安全组流日志来捕获网络日志。 可以使用特定于服务的诊断设置来整合和存储其他应用程序和服务级别日志。

可以使用 Azure Policy 的诊断设置定义来大规模捕获所有这些日志。

此设计还允许创建基于专用 DNS 区域的 Azure 本机 DNS 解决方案。 可以通过 Azure 的专用 DNS 组策略定义来自动化 DNS A 记录生命周期。

摘要:![]()

![]()

![]()

网格型网络体系结构成本

注意

当跨对等互连网络之间访问专用终结点时,客户只需为专用终结点本身付费,不需要为 VNet 对等互连付费。 可以在常见问题解答:从对等互连网络访问专用终结点时将如何计费?中阅读官方声明。

在这种网络设计中,只需支付以下费用:

- 专用终结点(每小时)

- 通过专用终结点发送的入口和出口流量加载原始数据集(1)并存储已处理的数据集(6)

不会对 Vnet 对等互连收费 (2),这就是此选项成本最低的原因。

摘要:![]()

![]()

![]()

网格网络体系结构中的带宽和延迟

此设计没有已知的带宽或延迟限制,因为没有网络虚拟设备限制其跨数据登陆区域数据交换的吞吐量。 该设计的唯一限制因素是我们数据中心的物理限制(光纤电缆的速度)。

摘要:![]()

![]()

![]()

网格型网络体系结构摘要

如果你计划采用云规模分析,我们建议你使用网格网络设计。 网格网络以最低的成本提供最大的带宽和低延迟,但在用户访问管理或 DNS 层方面没有妥协。

如果你需要在数据平台内实施其他网络策略,请使用网络安全组而不是中央网络虚拟设备。

传统的中心辐射型体系结构(不推荐)

中心辐射型网络架构设计是最明显的选择,并且已被许多企业采用。 其中,网络可传递性在连接性中心内设置,以从 VM B 访问存储帐户 A 中的数据。数据遍历两个 Vnet 对等互连((2) 和 (5))和托管在连接性中心内的网络虚拟设备((3 ) 和 (4))。 然后数据由虚拟机 (6) 加载并存储回存储帐户 B (8)。

图 3:中心辐射型体系结构。

传统中心辐射型体系结构中的用户访问管理

在传统的中心辐射型设计中,数据应用程序团队只需要执行两项操作就可以创建新服务(包括专用终结点):

- 对数据登陆区域中的资源组的写入权限

- 加入对其指定子网的访问权限

在此设计中,数据应用程序团队可以自己部署专用终结点。 只要团队具有将专用终结点连接到给定分支中的子网的必要访问权限,它们在设置必要的连接时便无需支持。

摘要:![]()

![]()

![]()

传统中心辐射型体系结构中的服务管理

这种网络设计是众所周知的,并且与大多数组织的现有网络设置一致。 这使得设计易于解释和实施。 还可以使用具有专用 DNS 区域的集中式 Azure 本机 DNS 解决方案在 Azure 租户中提供 FQDN 解析。 使用专用 DNS 区域可让你通过 Azure 策略自动化 DNS A 记录生命周期。

这种设计的另一个好处是流量通过中央网络虚拟设备路由,因此可以记录和检查从一个分支发送到另一个分支的网络流量。

这种设计有一个缺点,你的中央 Azure 平台团队必须手动管理路由表。 这对于确保分支之间的可传递性是必要的,这样可以跨多个数据登陆区域共享数据资产。 路线管理可能会逐渐变得复杂且容易出错,因此必须提前考虑。

此网络设置还有一个缺点是你的中央网络虚拟设备的设置方式。 网络虚拟设备充当单一故障点,如果发生故障,可能会导致数据平台内严重停机。 此外,随着数据平台内数据集大小的增加和跨数据登陆区域用例数量的增加,更多流量通过中央网络虚拟设备发送。

随着时间的推移,这会导致 GB 级甚至 TB 级的数据通过中心实例发送。 由于现有网络虚拟设备的带宽通常仅限于几 GB 或几十 GB 吞吐量,因此中央网络虚拟设备可能成为一个瓶颈,严重限制数据登陆区域之间的流量并限制数据资产可共享能力。

避免此问题的唯一方法是跨多个实例横向扩展你的中央网络虚拟设备,这对该设计具有重大成本影响。

摘要:![]()

传统的中心辐射型体系结构成本

注意

通过对等互连网络访问专用终结点时,只需为专用终结点本身付费,无需为 VNet 对等互连付费。 可以在常见问题解答:从对等互连网络访问专用终结点时将如何计费?中阅读官方声明。

对于此网络,你需要为存储帐户的专用终结点按小时付费。 你还需要为通过专用终结点发送的入口和出口流量付费才能加载原始数据集 (1) 并存储处理后的数据集 (8)。

你的客户需要为一个 Vnet 对等互连 (5) 的入口和出口流量付费。 如前所述,第一个 Vnet 对等互连是免费的 (2)。

如果使用这种网络设计((3) 和 (4)),将导致高昂的中央网络虚拟设备成本。 你必须购买额外的许可证并根据需求扩展中央网络虚拟设备,或者像使用 Azure 防火墙一样支付每 GB 处理的费用。

摘要:![]()

![]()

![]()

传统中心辐射型体系结构中的带宽和延迟

这种网络设计具有严重的带宽限制。 随着平台的增长,中央网络虚拟设备成为一个关键瓶颈,限制了跨数据登陆区域用例和数据集共享。 随着时间的推移,还可能会创建多个数据集副本。

这种设计也会严重影响延迟,这在实时分析方案中变得尤为重要。

摘要:![]()

![]()

![]()

传统的中心辐射型体系结构总结

这种中心辐射型网络设计在访问管理和某些服务管理方面具有优势,但由于服务管理和带宽和延迟的严重限制,我们不推荐将这种网络设计用于跨数据登陆区域的用例。

专用终结点投影体系结构(不推荐)

另一个设计选项是在每个登陆区域生成专用终结点的投影。 在这种设计中,存储帐户 A 的专用终结点在每个登录区域中创建。 这将导致数据登陆区域 A 中的第一个专用终结点连接到数据登陆区域 A 中的 Vnet,第二个专用终结点连接到数据登陆区域 B 中的 Vnet,依此类推。

这同样适用于存储帐户 B,还可能适用于数据登陆区域中的其他服务。 如果我们将数据登陆区域的数量定义为 n,则最终会为至少所有存储帐户以及数据登陆区域内的其他潜在服务提供 n 个专用终结点。 这导致专用终结点的数量呈指数增长。

图 4:专用终结点投影体系结构。

特定服务(例如存储帐户 A)的所有专用终结点具有相同的 FQDN(例如 storageaccounta.privatelink.blob.core.windows.net),因此该解决方案在 DNS 层上带来了无法使用专用 DNS 区域解决的难题。 相反,你需要一个能够根据请求者的源/IP 地址解析 DNS 名称的自定义 DNS 解决方案。 这样,就可以使 VMA 连接到连接到数据登陆区域 A 中的 Vnet 的专用终结点,并使 VM B 连接到连接到数据登陆区域 B 中的 Vnet 的专用终结点。可以使用基于 Windows Server 的设置执行此操作,而可以通过活动日志和 Azure Functions 的组合自动执行 DNS A 记录生命周期。

在此设置中,可以通过本地专用端点 (1) 访问数据集,将存储帐户 A 中的原始数据集加载到 VM B 中。 加载和处理数据集((2) 和 (3))后,你可以通过直接访问本地专用终结点 (4) 将其存储在存储帐户 B 上。 在该方案中,数据不得遍历任何 VNet 对等互连。

专用终结点投影体系结构中的用户访问管理

这种设计的用户访问管理方法类似于网格网络体系结构的用户访问管理。 但在此设计中,你可以要求其他数据登陆区域的访问权限,以便不仅在指定的数据登陆区域和 Vnet 内,而且在其他数据登陆区域及其各自的 Vnet 中创建专用终结点。

因此,你的数据应用程序团队需要完成三相操作(而不是两项操作)才能自己创建新服务:

- 对指定数据登陆区域中的资源组的写入访问权限

- 加入对其指定子网的访问权限

- 访问所有其他数据登陆区域中的资源组和子网,以创建各自的本地专用终结点

这种网络设计增加了访问管理层的复杂性,因为你的数据应用程序团队需要每个数据登陆区域的权限。 随着时间的推移,设计也可能令人困惑并导致 RBAC 不一致。

如果数据登陆区域团队和数据应用团队没有获得必要的访问权限,就会出现传统中心辐射型体系结构(不推荐)中描述的问题。

摘要:![]()

专用终结点投影体系结构中的服务管理

虽然再次类似于网格网络体系结构的设计,但这种网络设计的好处是没有网络虚拟设备充当单点故障或限制吞吐量。 由于不通过连接中心发送数据集,因此也减少了中央 Azure 平台团队的管理开销,因为无需横向扩展虚拟设备。 这意味着,中心 Azure 平台团队无法再检查和记录在数据登陆区域之间发送的所有流量。 然而,云规模分析是一个跨多个订阅的连贯平台,它允许规模并克服平台级别的限制,因此这不是一个缺点。

由于所有资源都托管在单个订阅中,因此不会在中央连接中心检查流量。 仍然可以使用网络安全组流日志捕获网络日志,并且可以使用特定于服务的诊断设置来整合和存储其他应用程序和服务级别日志。 可以使用 Azure 策略大规模捕获所有这些日志。 另一方面,数据平台所需的网络地址空间会因所需专用终结点的指数级增长而增加,这并不是最佳的。

关于这个网络体系结构的主要问题是它前面提到的 DNS 挑战。 不能使用专用 DNS 区域形式的 Azure 本机解决方案,因此这种体系结构需要能够根据请求者的源/IP 地址解析 FQDNS 的第三方解决方案。 你还必须开发和维护工具和工作流来自动化专用 DNS A 记录,与提议的 Azure Policy 驱动的解决方案相比,这大大增加了管理开销。

你可以使用专用 DNS 区域创建分布式 DNS 基础设施,但这会创建 DNS 孤岛,当你尝试访问托管在租户内其他登陆区域中的专用链接服务时,这最终会导致问题。 因此,这种设计不是可行的选择。

摘要:![]()

![]()

![]()

专用终结点投影体系结构成本

注意

当跨对等互连网络访问专用终结点时,你只需为专用终结点本身付费,无需为 VNet 对等互连付费。 可以在常见问题解答:从对等互连网络访问专用终结点时将如何计费?中阅读官方声明。

在这种网络设计中,你只需为专用终结点(每小时)和通过这些专用终结点发送的入口和出口流量付费即可加载原始数据集 (1) 并存储处理后的数据集 (4)。 但是,由于数据平台的专用终结点数量呈指数级增长,因此必然会产生额外成本。 由于是按小时收费,因此额外费用的金额很大程度上取决于创建的专用终结点数量。

摘要:![]()

专用终结点投影体系结构中的带宽和延迟

此设计没有已知的带宽和延迟限制,因为没有网络虚拟设备限制跨数据登陆区域数据交换的吞吐量。 该设计的唯一限制因素是我们数据中心的物理限制(光纤电缆的速度)。

摘要:![]()

![]()

![]()

专用终结点投影体系结构总结

此网络体系结构中专用终结点呈指数级增长,这可能会让你忘记哪些专用终结点在哪个位置用于什么目的。 你还受到访问管理问题和 DNS 层复杂性的限制。 由于这些问题,我们不建议将这种网络设计用于跨数据登陆区域的用例。

连接中心体系结构中的专用终结点(不推荐)

另一个网络选项是在你的连接中心中托管专用终结点并将它们连接到中心 Vnet。 在此解决方案中,你为公司 Vnet 上的每个服务托管一个专用终结点。 由于大多数公司现有的中心辐射型网络体系结构,并且你的连接中心在此解决方案中托管你的专用终结点,因此不需要传递性。 连接中心和数据登陆区域之间的 Vnet 对等允许直接访问。

数据遍历连接中心和数据登陆区域之间的单个 Vnet 对等互连,以便加载存储在 VM B 中的存储帐户 A 中的数据集。加载和处理该数据集后((3) 和 (4)),它会遍历相同的数据集 Vnet 第二次对等互连 (5),然后通过连接到中心 Vnet (6) 的专用终结点最终存储在存储帐户 B 中。

图 5:连接中心体系结构中的专用终结点。

连接中心体系结构中的用户访问管理

在此网络设计中,你的数据登陆区团队和数据应用程序团队需要两件事才能将专用终结点连接到中心 Vnet:

- 向连接中心订阅中的资源组写入权限

- 将权限加入中心 Vnet

你的连接中心是为你组织的 Azure 平台团队指定的,专门用于托管你组织的必要和共享网络基础架构(包括防火墙、网关和网络管理工具)。 此网络选项会使设计不一致,因为它不遵循企业级登陆区域基本原则中的访问管理原则。 因此,大多数 Azure 平台团队不会批准此设计选项。

摘要:![]()

![]()

![]()

连接中心架构中的服务管理

虽然类似于网格网络体系结构的设计,但这种设计没有网络虚拟设备充当单点故障或限制吞吐量。 由于不通过连接中心发送数据集,因此也减少了中央 Azure 平台团队的管理开销,因为无需横向扩展虚拟设备。 这意味着,中心 Azure 平台团队无法再检查和记录在数据登陆区域之间发送的所有流量。 然而,云规模分析是一个跨多个订阅的连贯平台,它允许规模并克服平台级别的限制,因此这不是一个缺点。

由于所有资源都托管在单个订阅中,因此不会在中央连接中心检查流量。 仍然可以使用网络安全组流日志捕获网络日志,并且可以使用特定于服务的诊断设置来整合和存储其他应用程序和服务级别日志。 可以使用 Azure 策略大规模捕获所有这些日志。

此设计还允许你基于专用 DNS 区域创建 Azure 本机 DNS 解决方案,并允许你通过 Azure 策略自动执行 DNS A 记录生命周期。

摘要:![]()

![]()

![]()

连接中心体系结构成本

注意

通过对等互连网络访问专用终结点时,只需为专用终结点本身付费,无需为 VNet 对等互连付费。 可以在常见问题解答:从对等互连网络访问专用终结点时将如何计费?中阅读官方声明。

在这种网络设计中,你只需为专用终结点(每小时)和通过这些专用终结点发送的入口和出口流量付费即可加载原始数据集 (1) 并存储处理后的数据集 (6)。

摘要:![]()

![]()

![]()

连接中心体系结构中的带宽和延迟

此设计没有已知的带宽和延迟限制,因为没有网络虚拟设备限制跨数据登陆区域数据交换的吞吐量。 该设计的唯一限制因素是我们数据中心的物理限制(光纤电缆的速度)。

摘要:![]()

![]()

![]()

连接中心体系结构中的专用终结点摘要

虽然这种网络体系结构设计具有多种优势,但其前面提到的访问管理不一致使其低于标准。 因此,我们不能推荐这种设计方法。

单区域数据落地区连接结语

在所有审查过的网络体系结构选项及其优缺点中,网格网络体系结构显然是赢家。 这种体系结构在吞吐量、成本和管理方面具有巨大优势,正因此如,我们建议你在部署云规模分析时使用这种体系结构。 对等互连辐射虚拟网络以前并不常见,而这导致了跨域和业务部门共享数据集的问题。

可以将云规模分析视为跨多个订阅的连贯解决方案。 在单个订阅设置中,网络流量等于网状网络架构中的流量。 在单个订阅设置中,用户很可能会达到平台的订阅级别限制和配额,这是云规模分析竭力避免的情况。