你当前正在访问 Microsoft Azure Global Edition 技术文档网站。 如果需要访问由世纪互联运营的 Microsoft Azure 中国技术文档网站,请访问 https://docs.azure.cn。

适用于 Azure VMware 解决方案的 Azure NetApp 文件数据存储性能基准

本文介绍 Azure NetApp 文件数据存储为 Azure VMware 解决方案 (AVS) 上的虚拟机提供的性能基准。

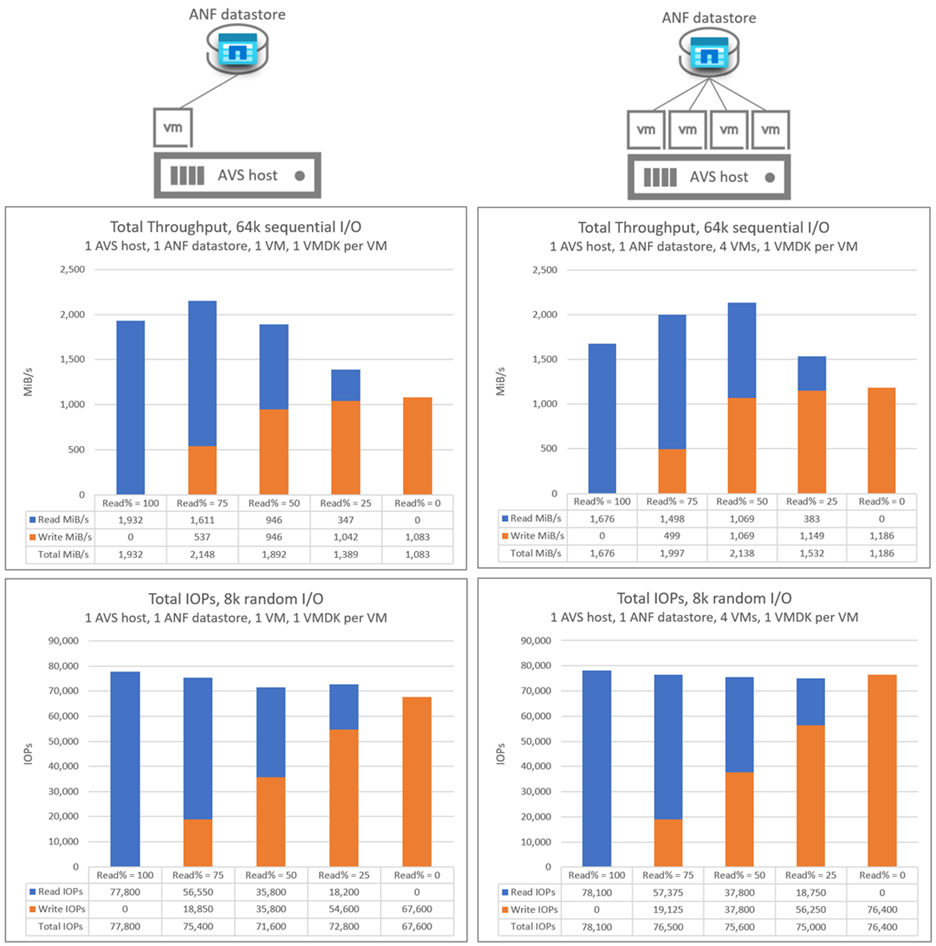

测试的方案如下所述:

- 在单个 AVS 主机和单个 Azure NetApp 文件数据存储上运行的一对多虚拟机

- 具有单个 AVS 主机的一对多 Azure NetApp 文件数据存储

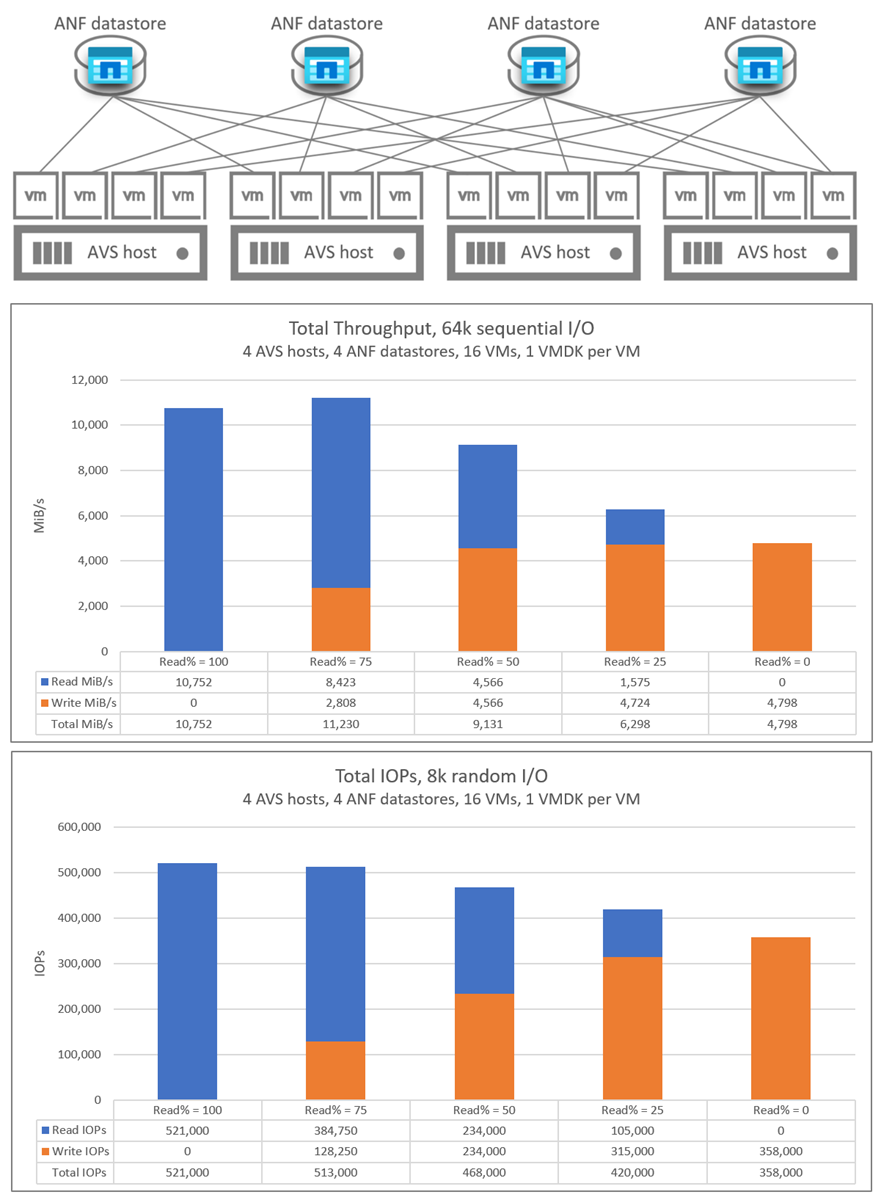

- 具有多个 AVS 主机的横向扩展 Azure NetApp 文件数据存储

针对每个方案测试的 read:write I/O 比如下:100:0, 75:25, 50:50, 25:75, 0:100

本文中记录的基准是在卷吞吐量充足的情况下执行的,以防止软限制影响性能。 可以使用 Azure NetApp 文件的“高级”和“超级”服务级别实现基准,某些情况下也使用“标准”服务级别。 有关卷吞吐量的详细信息,请参阅 Azure NetApp 文件的性能考虑因素。

请参阅适用于 Azure VMware 解决方案的 Azure NetApp 文件数据存储 TCO 估算器,了解 Azure NetApp 文件数据存储的大小调整和相关成本优势。

延迟

AVS 到 Azure NetApp 文件数据存储的流量延迟从亚毫秒级(对于低负载环境)到 2-3 毫秒不等(对于中高负载环境)。 对于尝试超出各种组件的吞吐量限制的环境,延迟可能更高。 延迟和吞吐量可能会有所不同,影响因素包括 I/O 大小、读/写比率、流量竞争等。

性能缩放

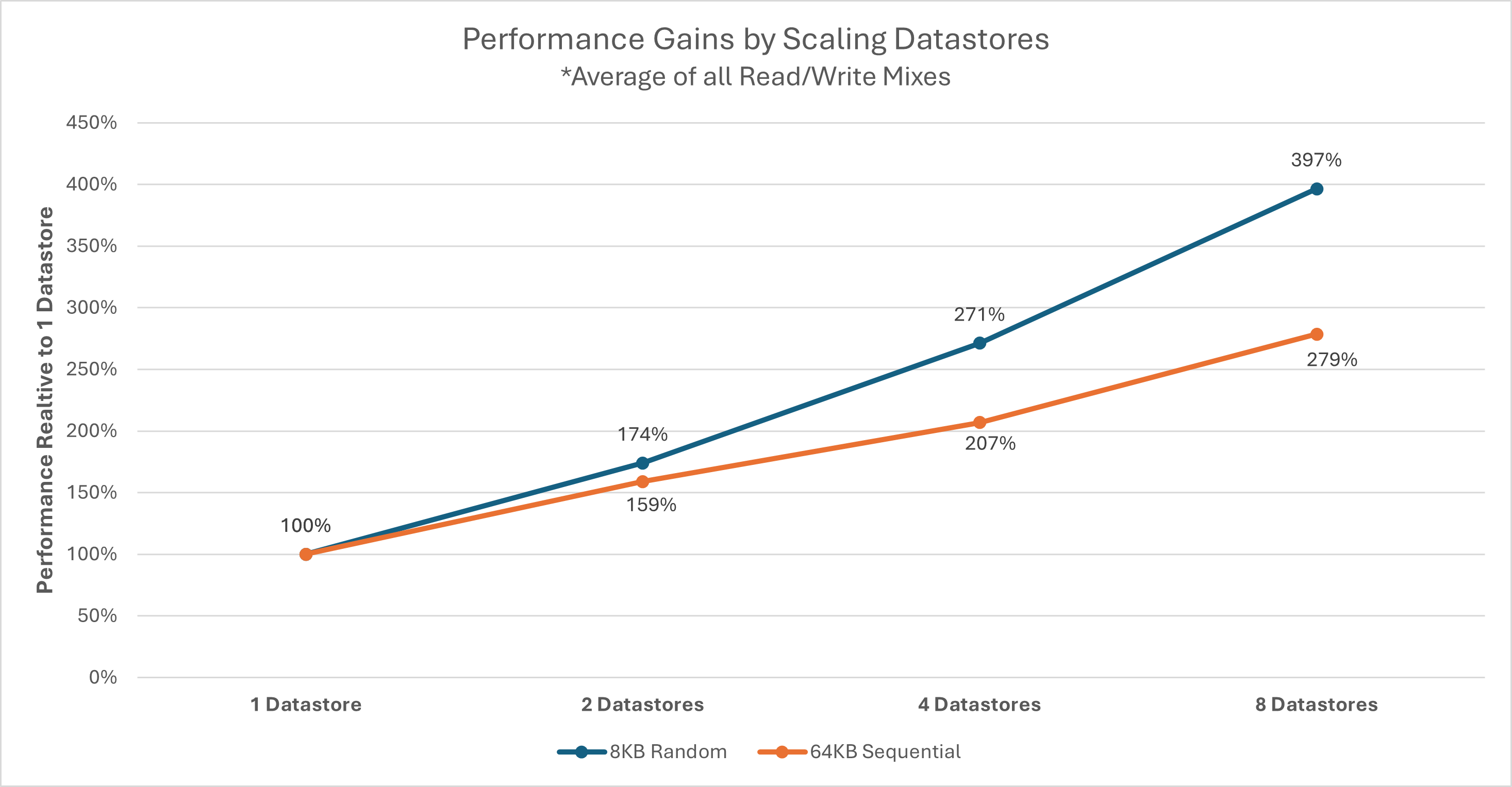

每个 AVS 主机连接到每个 Azure NetApp 文件数据存储,且网络流数量固定,可将单个 VM 磁盘 (VMDK) 或 AVS 主机的吞吐量限定在每个数据存储的范围内。 根据给定的一组工作负载及其性能需求,有可能需要多个数据存储。 可通过将工作负载分散到多个数据存储中来提升每个 AVS 主机的整体存储性能。 也可以通过将工作负载分散到不同 AVS 主机中的每个数据存储来提高性能。 下图显示了有更多数据存储时的相对性能缩放。

注意

外部数据存储的吞吐量上限可能受其他因素限制,包括网络带宽、SKU 限制或 Azure NetApp 文件卷的服务级别上限。

每个主机的吞吐量可能受所选 AVS SKU 的影响。 AV64 SKU 提供 100 千兆位以太网 (GbE) 网络接口卡 (NIC)。 其他 SKU 提供 25-GbE NIC。 单个网络流(如 NFS 装载)可能受 25-GbE NIC 的限制。

AV64 环境详细信息

本文的结果是使用以下环境配置实现的:

- Azure VMware 解决方案主机大小:运行 VMware ESXi 版本 7u3 的 AV64

- Azure VMware 解决方案私有云连接:具有 FastPath 的 UltraPerformance 网关

- 来宾虚拟机:Rocky Linux 9、16 vCPU、64 GB 内存

- 工作负载生成器:

fio3.35

注意

AV64 测试仅关注单个 ESXi 主机的评估。 AV36 部分讨论了横向扩展 ESXi 主机的数量。

单个 AV64 主机的一对多 Azure NetApp 文件数据存储

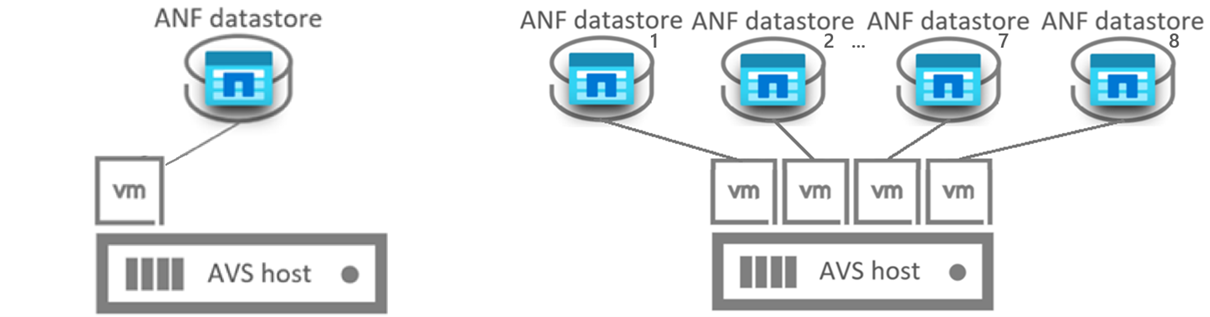

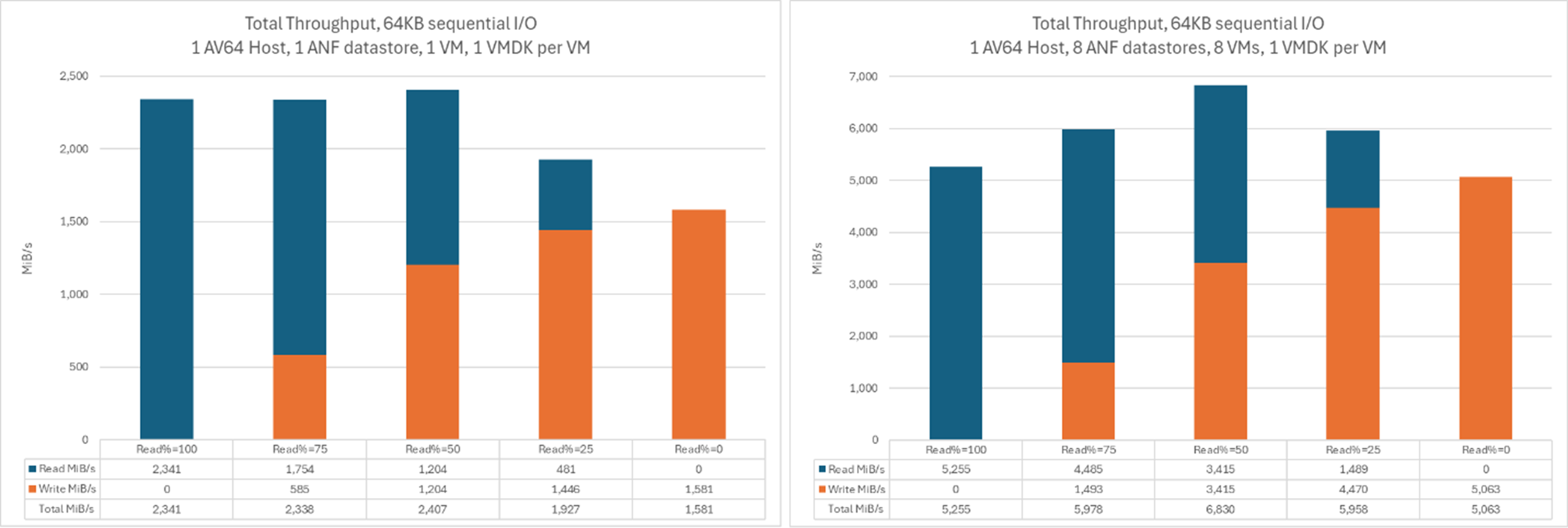

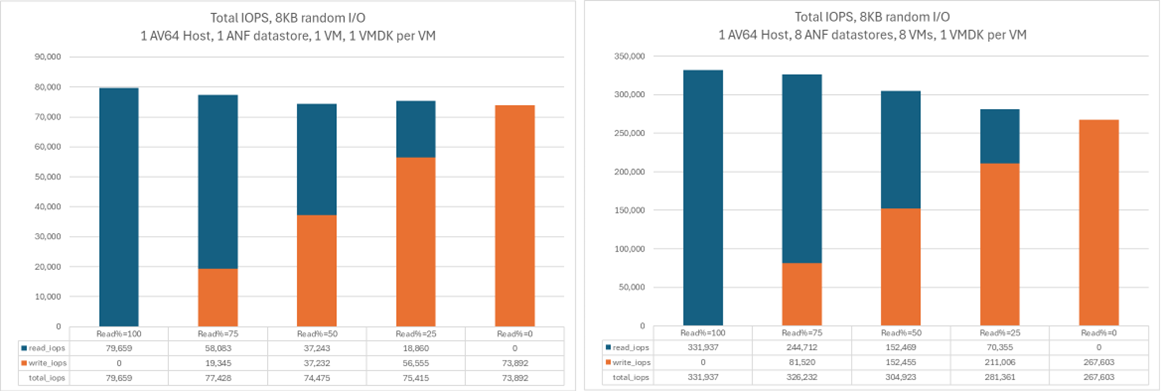

下图将单个 Azure NetApp 文件数据存储上单个虚拟机的吞吐量与分别位于各自的 Azure NetApp 文件数据存储上的八个 VM 的聚合吞吐量进行比较。 通过在相同数量的数据存储中散布更多 VMDK,可以使用更少的 VM 来实现类似的吞吐量。

此图比较吞吐量:

此图比较 I/OPS:

AV36 环境详细信息

这些测试是使用以下环境配置进行的:

- Azure VMware 解决方案主机大小:运行 VMware ESXi 版本 7u3 的 AV36

- Azure VMware 解决方案私有云连接:具有 FastPath 的 UltraPerformance 网关

- 来宾虚拟机:Ubuntu 21.04,16 vCPU,64 GB 内存

- 工作负载生成器:

fio

在单个 AV36 主机和单个 Azure NetApp 文件数据存储上运行的一对多虚拟机

在单个 AVS 主机方案中,AVS 到 Azure NetApp 文件数据存储 I/O 发生在单个网络流上。 这些图表将单个虚拟机的吞吐量和 I/OPs 与四个虚拟机的聚合吞吐量和 I/OPS 进行比较。 在后续方案中,随着添加更多的主机和数据存储,网络流的数量也会增加。

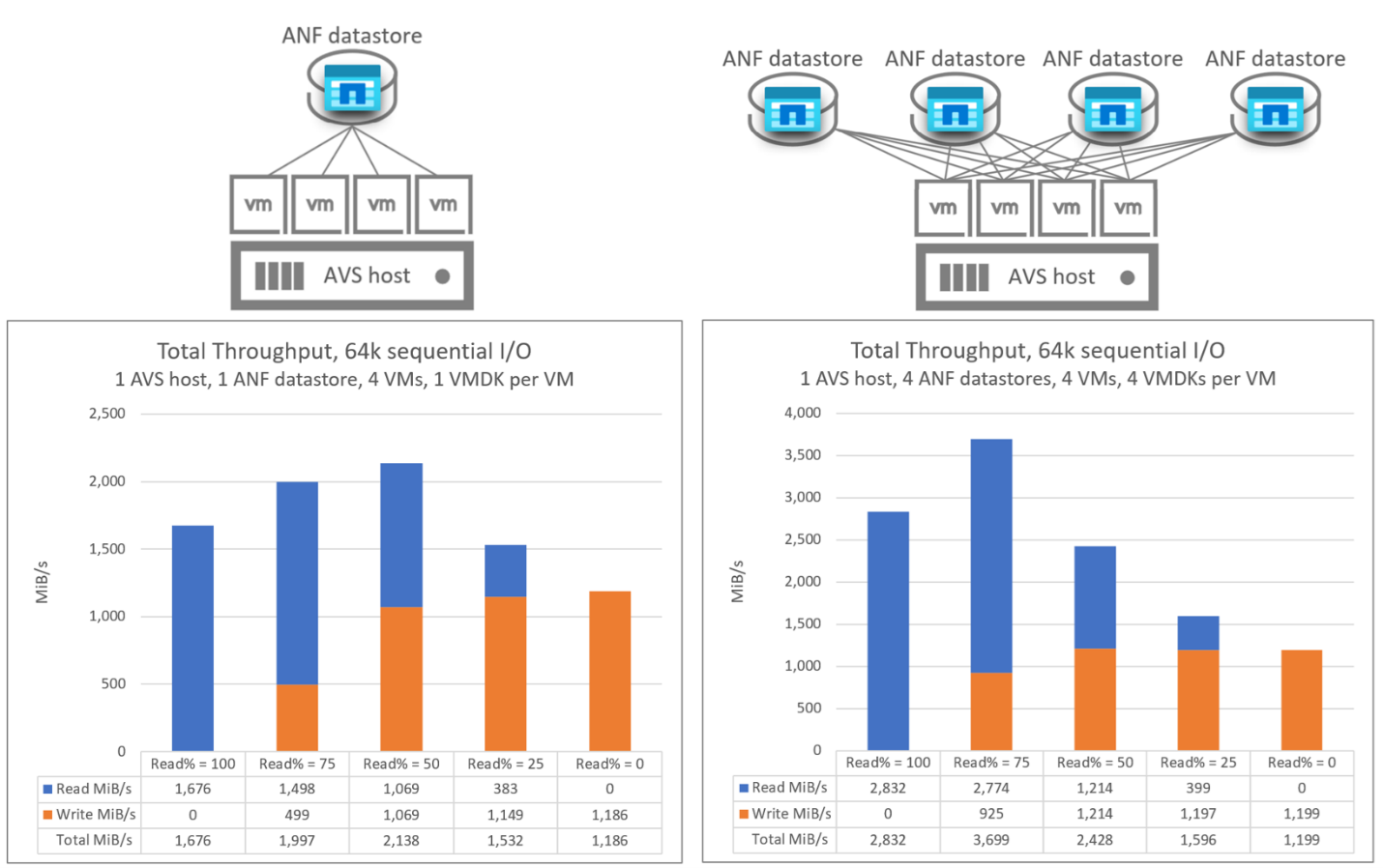

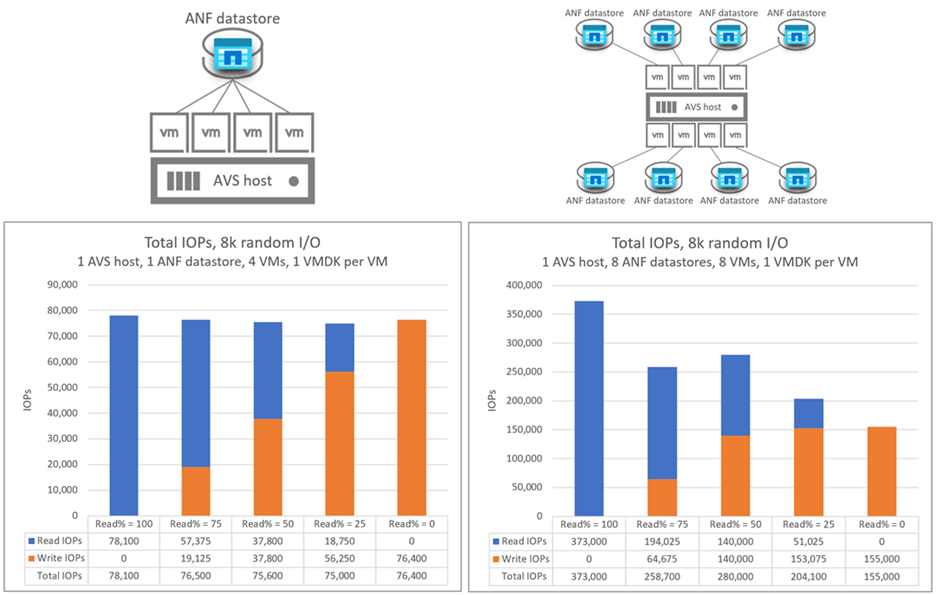

单个 AV36 主机的一对多 Azure NetApp 文件数据存储

下图将单个 Azure NetApp 文件数据存储上单个虚拟机的吞吐量与四个 Azure NetApp 文件数据存储的聚合吞吐量进行比较。 在这两个方案中,每个虚拟机在每个 Azure NetApp 文件数据存储上都有一个 VMDK。

下图将单个 Azure NetApp 文件数据存储上单个虚拟机的 I/OPS 与八个 Azure NetApp 文件数据存储的聚合 I/OPS 进行比较。 在这两个方案中,每个虚拟机在每个 Azure NetApp 文件数据存储上都有一个 VMDK。

使用多个 AV36 主机横向扩展 Azure NetApp 文件数据存储

下图显示了分布在四个 AVS 主机上的 16 个虚拟机的聚合吞吐量和 I/OPS。 每个 AVS 主机有四个虚拟机,每个虚拟机都位于不同的 Azure NetApp 文件数据存储上。 每个主机上有单个虚拟机且每个虚拟机有四个 VMDK 与这些 VMDK 中的每一个都在单独数据存储上所取得的结果几乎相同。