วิธีการอ่านและเขียนข้อมูลด้วย Pandas ใน Microsoft Fabric

สมุดบันทึก Microsoft Fabric รองรับการโต้ตอบแบบไร้รอยต่อกับข้อมูลของ Lakehouse โดยใช้ Pandas ไลบรารี Python ที่ได้รับความนิยมมากที่สุดสําหรับการสํารวจและประมวลผลข้อมูล ภายในสมุดบันทึก คุณสามารถอ่านข้อมูลจาก และเขียนข้อมูลกลับไปยัง ทรัพยากรของ Lakehouse ในรูปแบบไฟล์ต่าง ๆ ได้อย่างรวดเร็ว คู่มือนี้มีตัวอย่างรหัสเพื่อช่วยให้คุณเริ่มต้นใช้งานในสมุดบันทึกของคุณเอง

ข้อกำหนดเบื้องต้น

รับการสมัครใช้งาน Microsoft Fabric หรือลงทะเบียนเพื่อทดลองใช้งาน Microsoft Fabric ฟรี

ลงชื่อเข้าใช้ Microsoft Fabric

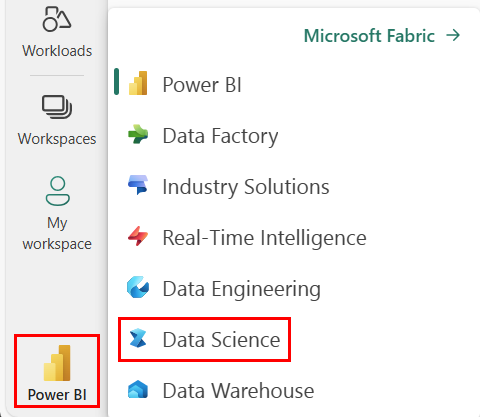

ใช้ตัวสลับประสบการณ์การใช้งานที่ด้านล่างซ้ายของหน้าหลักของคุณเพื่อเปลี่ยนเป็น Fabric

โหลดข้อมูลเลคเฮ้าส์ลงในสมุดบันทึก

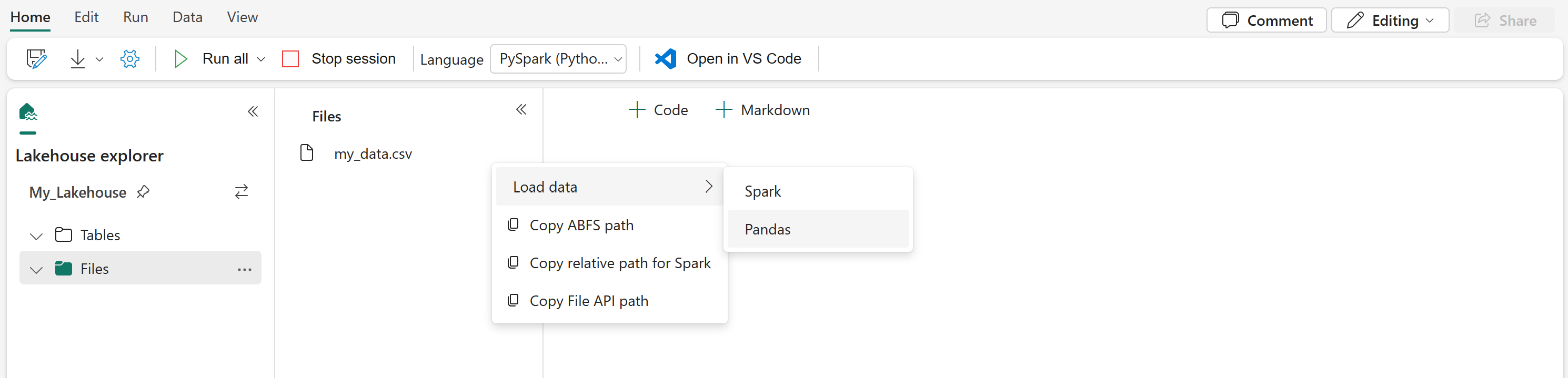

เมื่อคุณแนบ Lakehouse เข้ากับสมุดบันทึก Microsoft Fabric ของคุณ คุณสามารถสํารวจข้อมูลที่จัดเก็บไว้โดยไม่ต้องออกจากหน้า และอ่านลงในสมุดบันทึกของคุณได้ทั้งหมดด้วยขั้นตอนไม่กี่ขั้นตอน การเลือกใช้ตัวเลือกพื้นผิวไฟล์ของ Lakehouse เพื่อ "โหลดข้อมูล" ลงใน Spark หรือ Pandas DataFrame คุณยังสามารถคัดลอกเส้นทาง ABFS แบบเต็มของไฟล์หรือเส้นทางสัมพัทธ์ที่เรียกง่าย

การเลือกหนึ่งในพร้อมท์ "โหลดข้อมูล" จะสร้างเซลล์โค้ดเพื่อโหลดไฟล์นั้นลงใน DataFrame ในสมุดบันทึกของคุณ

การแปลง Spark DataFrame เป็น DataFrame ของ Pandas

สําหรับการอ้างอิง คําสั่งนี้แสดงวิธีการแปลง Spark DataFrame เป็น Pandas DataFrame:

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

การอ่านและการเขียนรูปแบบไฟล์ต่าง ๆ

หมายเหตุ

การปรับเปลี่ยนเวอร์ชันของแพคเกจเฉพาะอาจทําลายแพคเกจอื่น ๆ ที่ขึ้นอยู่กับแพคเกจนั้นได้ ตัวอย่างเช่น การazure-storage-blobดาวน์เกรดอาจทําให้เกิดปัญหากับ Pandas และไลบรารีอื่นๆ ที่ขึ้นกับ Pandasรวมถึง mssparkutilsfsspec_wrapper, และnotebookutils

คุณสามารถดูรายการของแพคเกจที่ติดตั้งไว้ล่วงหน้าและเวอร์ชันของแต่ละรันไทม์ได้ที่นี่

ตัวอย่างรหัสเหล่านี้อธิบายการดําเนินการของ Pandas เพื่ออ่านและเขียนรูปแบบไฟล์ต่าง ๆ

หมายเหตุ

คุณต้องแทนที่พาธของไฟล์ในตัวอย่างโค้ดเหล่านี้ Pandas สนับสนุนทั้งเส้นทางสัมพัทธ์ ดังที่แสดงที่นี่และเส้นทาง ABFS แบบเต็ม เส้นทางของชนิดใดชนิดหนึ่งสามารถดึงและคัดลอกจากอินเทอร์เฟซตามขั้นตอนก่อนหน้าได้

อ่านข้อมูลจากไฟล์ CSV

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

เขียนข้อมูลเป็นไฟล์ CSV

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

อ่านข้อมูลจากไฟล์ Parquet

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

เขียนข้อมูลเป็นไฟล์ Parquet

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

อ่านข้อมูลจากไฟล์ Excel

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values. Also need to add correct filepath after Files/ if file is placed in different folders

# if using default lakehouse that attached to the notebook use the code to replace below: df = pandas.read_excel("/lakehouse/default/Files/FILENAME.xlsx")

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

เขียนข้อมูลเป็นไฟล์ Excel

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

อ่านข้อมูลจากไฟล์ JSON

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

เขียนข้อมูลเป็นไฟล์ JSON

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

เนื้อหาที่เกี่ยวข้อง

- ใช้ Data Wrangler เพื่อ ทําความสะอาดและเตรียมข้อมูลของคุณ

- เริ่มต้น แบบจําลอง ML การฝึกอบรม