Översikt över WebNN

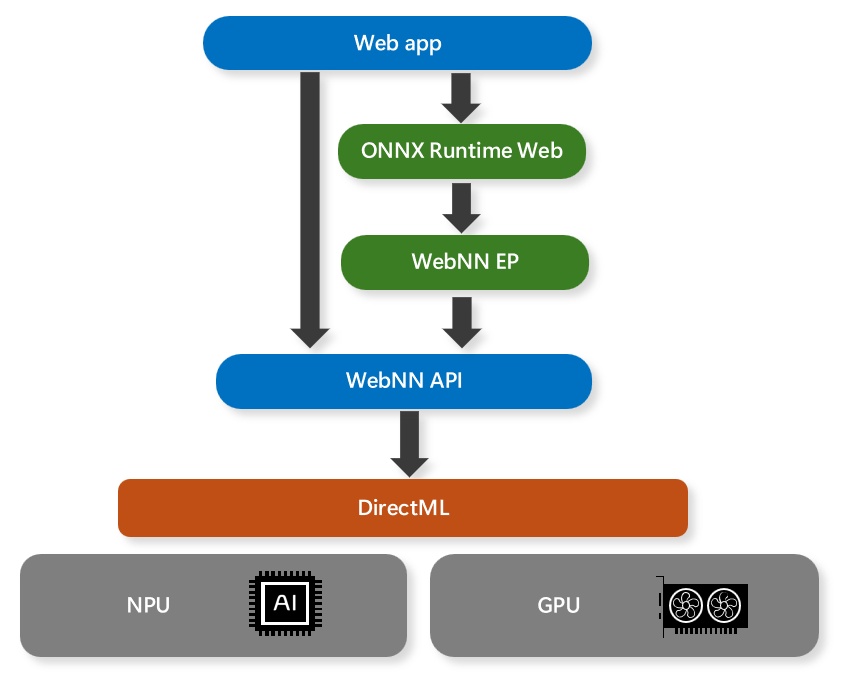

WEBNN-API:et (Web Neural Network) är en framväxande webbstandard som gör att webbappar och ramverk kan påskynda djupa neurala nätverk med GPU:er, processorer eller specialbyggda AI-acceleratorer som NPU:er. WebNN-API:et använder DirectML-API:et i Windows för att få åtkomst till de inbyggda maskinvarufunktionerna och optimera körningen av neurala nätverksmodeller.

När användningen av AI/ML i appar blir mer populär ger WebNN-API:et följande fördelar:

- prestandaoptimeringar – Genom att använda DirectML hjälper WebNN till att göra det möjligt för webbappar och ramverk att dra nytta av de bästa tillgängliga maskin- och programvaruoptimeringarna för varje plattform och enhet, utan att kräva komplex och plattformsspecifik kod.

- låg latens – In-browser-slutsatsdragning hjälper till att möjliggöra nya användningsfall med lokala mediekällor, till exempel videoanalys i realtid, ansiktsigenkänning och taligenkänning, utan att behöva skicka data till fjärrservrar och vänta på svar.

- Sekretessbevarande – Användardata förblir på enheten och bevarar användarsekretess eftersom webbappar och ramverk inte behöver ladda upp känslig eller personlig information till molntjänster för bearbetning.

- hög tillgänglighet – Inget beroende av nätverket efter inledande cachelagring av tillgångar för offlinefall, eftersom webbappar och ramverk kan köra neurala nätverksmodeller lokalt även när Internetanslutningen är otillgänglig eller otillförlitlig.

- låg serverkostnad – Databehandling på klientenheter innebär att inga servrar behövs, vilket hjälper webbappar att minska drift- och underhållskostnaderna för att köra AI/ML-tjänster i molnet.

AI/ML-scenarier som stöds av WebNN omfattar generativ AI, personidentifiering, ansiktsigenkänning, semantisk segmentering, skelettidentifiering, formatöverföring, superupplösning, bildtexter, maskinöversättning och brusreducering.

Notera

WebNN-API:et pågår fortfarande, med GPU- och NPU-stöd i förhandsversionstillstånd. WebNN-API:et bör för närvarande inte användas i en produktionsmiljö.

Ramverksstöd

WebNN är utformat som ett serverdels-API för webbramverk. För Windows rekommenderar vi att du använder ONNX Runtime Web. Detta ger en välbekant upplevelse av att använda DirectML och ONNX Runtime internt så att du kan ha en konsekvent upplevelse av att distribuera AI i ONNX-format i webbprogram och interna program.

WebNN-krav

Du kan kontrollera information om din webbläsare genom att navigera till about://version i din Chromium-webbläsares adressfält.

| Hårdvara | Webbläsare | Windows-version | ONNX Runtime för webbversionen | Drivrutinsversion |

|---|---|---|---|---|

| GPU | WebNN kräver en Chromium-webbläsare*. Använd den senaste versionen av Microsoft Edge Beta. | Lägsta version: Windows 11, version 21H2. | Lägsta version: 1.18 | Installera den senaste drivrutinen för maskinvaran. |

| NPU | WebNN kräver en Chromium-webbläsare*. Använd den senaste versionen av Microsoft Edge Canary. Se kommentaren nedan för hur du inaktiverar GPU-blocklistan. | Lägsta version: Windows 11, version 21H2. | Lägsta version: 1.18 | Intel-drivrutinsversion: 32.0.100.2381. Se Vanliga frågor och svar om hur du uppdaterar drivrutinen. |

Obs

Chromium-baserade webbläsare kan för närvarande stödja WebNN, men beror på den enskilda webbläsarens implementeringsstatus.

Notera

För NPU-stöd startar du Edge från kommandoraden med följande flagga: msedge.exe --disable_webnn_for_npu=0

Modellstöd

GPU (förhandsversion):

När det körs på GPU:er stöder WebNN för närvarande följande modeller:

- Stabil Diffusion Turbo

- Stable Diffusion 1.5

- Whisper-base

- MobileNetv2

- segmentera allt

- ResNet

- EfficientNet

- SqueezeNet

WebNN fungerar också med anpassade modeller så länge operatorstöd är tillräckligt. Kontrollera status för operatörer här.

NPU (förhandsversion):

På Intels® Core™ Ultra-processorer med Intel® AI Boost NPU stöder WebNN:

FAQ

Hur skapar jag ett problem med WebNN?

För allmänna problem med WebNN kan du skicka in ett problem på vår WebNN Developer Preview GitHub

Om du har problem med ONNX Runtime Web eller "WebNN Execution Provider" går du till ONNXRuntime Github.

Hur felsöker jag problem med WebNN?

WebNN W3C Spec har information om felspridning, vanligtvis via DOM-undantag. Loggen i slutet av about://gpu kan också ha användbar information. För ytterligare problem kan du skicka in ett problem som länkade ovan.

Stöder WebNN andra operativsystem?

WebNN stöder för närvarande bäst Windows-operativsystemet. Versioner för andra operativsystem pågår.

Vilka maskinvarubackends är för närvarande tillgängliga? Stöds vissa modeller endast med specifika maskinvarudelar?

Du hittar information om operatörsstöd i WebNN på Implementeringsstatus för WebNN-åtgärder | Web Machine Learning.

Vilka är stegen för att uppdatera Intel-drivrutinen för NPU-stöd (förhandsversion)?

- Leta upp den uppdaterade drivrutinen från Intels drivrutinswebbplats.

- Avkomprimera ZIP-filen.

- Öppna dialogrutan Kör genom att trycka på Win+R.

- Skriv devmgmt.msc i textfältet.

- Tryck på Retur eller klicka på OK.

- Öppna noden "Neurala processorer" i Enhetshanteraren

- Högerklicka på den NPU vars drivrutin du vill uppdatera.

- Välj "Uppdatera drivrutin" på snabbmenyn

- Välj "Bläddra på datorn efter drivrutiner"

- Välj "Låt mig välja från en lista över tillgängliga drivrutiner på datorn"

- Tryck på knappen "Välj diskett"

- Tryck på knappen "Bläddra"

- Navigera till den plats där du dekomprimerade den ovan nämnda zip-filen.

- Tryck på OK.