Integrerade funktioner och tekniker för programvara och maskinvara (SH)

Dessa funktioner har både programvaru- och maskinvarukomponenter. Programvaran är intimt kopplad till maskinvarufunktioner som krävs för att funktionen ska fungera. Exempel på dessa är VMMQ, VMQ, Send-side IPv4 Checksum Offload och RSS. Mer information finns i Värdnätverkskrav för Azure Local.

Tips

SH- och HO-funktioner är tillgängliga om det installerade nätverkskortet stöder det. Funktionsbeskrivningarna nedan beskriver hur du ser om ditt nätverkskort stöder funktionen.

Konvergerat nätverkskort

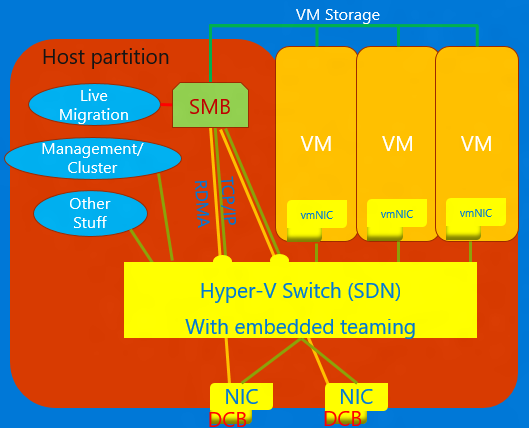

Konvergerat nätverkskort är en teknik som gör att virtuella nätverkskort i den Hyper-V värden kan exponera RDMA-tjänster för värdprocesser. Windows Server 2016 kräver inte längre separata nätverkskort för RDMA. Med funktionen Konvergerat nätverkskort kan virtuella nätverkskort i värdpartitionen (vNICs) exponera RDMA för värdpartitionen och dela bandbredden för nätverkskorten mellan RDMA-trafiken och den virtuella datorn och annan TCP/UDP-trafik på ett rättvist och hanterbart sätt.

Du kan hantera konvergerade NIC-åtgärder via VMM eller Windows PowerShell. PowerShell-cmdletarna är samma cmdletar som används för RDMA (se nedan).

Så här använder du den konvergerade NIC-funktionen:

Se till att konfigurera värden för DCB.

Se till att aktivera RDMA på nätverkskortet, eller om det gäller ett SET-team, är nätverkskorten bundna till Hyper-V växeln.

Se till att aktivera RDMA på de virtuella nätverkskort som är avsedda för RDMA i värddatorn.

Mer information om RDMA och SET finns i RDMA (Remote Direct Memory Access) och Switch Embedded Teaming (SET).

Data Center Bridging (DCB)

DCB är en uppsättning IEEE-standarder (Institute of Electrical and Electronics Engineers) som möjliggör konvergerade nätverksstrukturer i datacenter. DCB tillhandahåller maskinvaruköbaserad bandbreddshantering på en värd med samarbete från den intilliggande växeln. All trafik för lagring, datanätverk, kluster Inter-Process Kommunikation (IPC) och hantering delar samma Ethernet-nätverksinfrastruktur. I Windows Server 2016 kan DCB tillämpas på valfritt nätverkskort individuellt och nätverkskort som är bundna till Hyper-V växeln.

För DCB använder Windows Server prioritetsbaserad flödeskontroll (PFC), standardiserad i IEEE 802.1Qbb. PFC skapar en (nästan) förlustfri nätverksinfrastruktur genom att förhindra spill i trafikklasser. Windows Server använder också Enhanced Transmission Selection (ETS), standardiserat i IEEE 802.1Qaz. ETS möjliggör uppdelning av bandbredden i reserverade delar för upp till åtta trafikklasser. Varje trafikklass har en egen överföringskö och kan med hjälp av PFC starta och stoppa överföring i en klass.

Hyper-V Nätverksvirtualisering

| Version | Beskrivning |

|---|---|

| v1 (HNVv1) | Hyper-V Network Virtualization (HNV) introducerades i Windows Server 2012 och möjliggör virtualisering av kundnätverk ovanpå en delad, fysisk nätverksinfrastruktur. Med minimala ändringar som krävs i den fysiska nätverksinfrastrukturen ger HNV tjänsteleverantörer flexibiliteten att distribuera och migrera klientarbetsbelastningar var som helst i de tre molnen: tjänstleverantörsmolnet, det privata molnet eller det offentliga Microsoft Azure-molnet. |

| v2 NVGRE (HNVv2 NVGRE) | I Windows Server 2016 och System Center Virtual Machine Manager tillhandahåller Microsoft en lösning för nätverksvirtualisering från slutpunkt till slutpunkt som innehåller RAS Gateway, Belastningsutjämning för programvara, nätverksstyrenhet med mera. Mer information finns i Hyper-V Översikt över nätverksvirtualisering i Windows Server 2016. |

| v2 VxLAN (HNVv2 VxLAN) | I Windows Server 2016 ingår SDN-tillägget som du hanterar via nätverksstyrenheten. |

IPsec Task Offload (IPsecTO)

IPsec-uppgiftsavlastning är en NIC-funktion som gör att operativsystemet kan använda processorn på nätverkskortet för IPsec-krypteringsarbetet.

Viktig

IPsec Task Offload är en äldre teknik som inte stöds av de flesta nätverkskort, och där den finns är den inaktiverad som standard.

Privat virtuellt lokalt nätverk (PVLAN).

PVLAN tillåter endast kommunikation mellan virtuella datorer på samma virtualiseringsserver. Ett privat virtuellt nätverk är inte bundet till ett fysiskt nätverkskort. Ett privat virtuellt nätverk är isolerat från all extern nätverkstrafik på virtualiseringsservern, samt all nätverkstrafik mellan hanteringsoperativsystemet och det externa nätverket. Den här typen av nätverk är användbar när du behöver skapa en isolerad nätverksmiljö, till exempel en isolerad testdomän. Stackarna Hyper-V och SDN stöder endast PVLAN-isolerat portläge.

Mer information om PVLAN-isolering finns i System Center: Virtual Machine Manager Engineering Blog.

Fjärråtkomst till direkt minne (RDMA)

RDMA är en nätverksteknik som tillhandahåller kommunikation med högt dataflöde och låg svarstid som minimerar CPU-användningen. RDMA stöder nollkopieringsnätverk genom att möjliggöra för nätverkskortet att överföra data direkt till eller från programminnet. RDMA-kompatibel innebär att nätverkskortet (fysiskt eller virtuellt) kan exponera RDMA för en RDMA-klient. RDMA-aktiverat innebär å andra sidan att ett RDMA-kompatibelt nätverkskort exponerar RDMA-gränssnittet i stacken.

Mer information om RDMA finns i RDMA (Remote Direct Memory Access) och Switch Embedded Teaming (SET).

Ta emot sidoskalning (RSS)

RSS är en NIC-funktion som separerar olika uppsättningar av strömmar och levererar dem till olika processorer för bearbetning. RSS parallelliserar nätverksbearbetningen, vilket gör det möjligt för en värd att skala till mycket höga datahastigheter.

För mer information, se Receive Side Scaling (RSS).

Virtualisering med enkel rot Input-Output (SR-IOV)

SR-IOV gör att VM-trafik kan röra sig direkt från nätverkskortet till den virtuella datorn utan att gå via Hyper-V-värden. SR-IOV är en otrolig förbättring av prestanda för en virtuell dator men saknar möjligheten för värden att hantera det röret. Använd endast SR-IOV när arbetsbelastningen är stabil, betrodd och i allmänhet den enda VM:n på värden.

Trafik som använder SR-IOV kringgår Hyper-V växeln, vilket innebär att principer, till exempel ACL:er eller bandbreddshantering, inte tillämpas. SR-IOV trafik kan inte heller skickas via någon nätverksvirtualiseringsfunktion, så NV-GRE eller VxLAN-inkapsling kan inte tillämpas. Använd endast SR-IOV för välbetrodda arbetslaster i specifika situationer. Dessutom kan du inte använda värdprinciper, bandbreddshantering och virtualiseringstekniker.

I framtiden skulle två tekniker tillåta SR-IOV: Allmänna flödestabeller (GFT) och QoS-avlastning för maskinvara (bandbreddshantering i nätverkskortet) – när nätverkskorten i vårt ekosystem har stöd för dem. Kombinationen av dessa två tekniker skulle göra SR-IOV användbar för alla virtuella datorer, tillåta att principer, virtualisering och bandbreddshanteringsregler tillämpas och kan leda till stora framsteg i den allmänna tillämpningen av SR-IOV.

Mer information finns i Översikt över enkel rot-I/O-virtualisering (SR-IOV).

TCP Chimney avlastning

TCP Chimney Offload, även kallat TCP Engine Offload (TOE), är en teknik som gör att värden kan avlasta all TCP-bearbetning till NIC:en. Eftersom Windows Server TCP-stacken nästan alltid är effektivare än TOE-motorn rekommenderas inte användning av TCP Chimney-avlastning.

Viktig

TCP Chimney Offload är en inaktuell teknik. Vi rekommenderar att du inte använder TCP Chimney Offload eftersom Microsoft kan sluta stödja det i framtiden.

Virtuellt lokalt nätverk (VLAN)

VLAN är ett tillägg till Ethernet-ramrubriken för att aktivera partitionering av ett LAN i flera VLAN, var och en med sitt eget adressutrymme. I Windows Server 2016 ställs VLAN in på portarna för Hyper-V-växeln eller genom att konfigurera teamgränssnitt i NIC-team.

VmQ (Virtual Machine Queue)

VMQ är en NIC-funktion som allokerar en kö för varje virtuell dator. När du har Hyper-V aktiverat; du måste också aktivera VMQ. I Windows Server 2016 använder VMQs NIC Switch vPorts med en enda kö tilldelad till vPort för att tillhandahålla samma funktionalitet.

Virtuell maskin med flera köer (VMMQ)

VMMQ är en NIC-funktion som gör att trafik för en virtuell dator kan spridas över flera köer, var och en bearbetas av en annan fysisk processor. Trafiken skickas sedan till flera IP-adresser på den virtuella datorn som i vRSS, vilket gör det möjligt att leverera betydande nätverksbandbredd till den virtuella datorn.