Använda Spark i notebook-filer

Du kan köra många olika typer av program på Spark, inklusive kod i Python- eller Scala-skript, Java-kod som kompilerats som javaarkiv (JAR) och andra. Spark används ofta i två typer av arbetsbelastningar:

- Batch- eller dataströmbearbetningsjobb för att mata in, rensa och transformera data – som ofta körs som en del av en automatiserad pipeline.

- Interaktiva analyssessioner för att utforska, analysera och visualisera data.

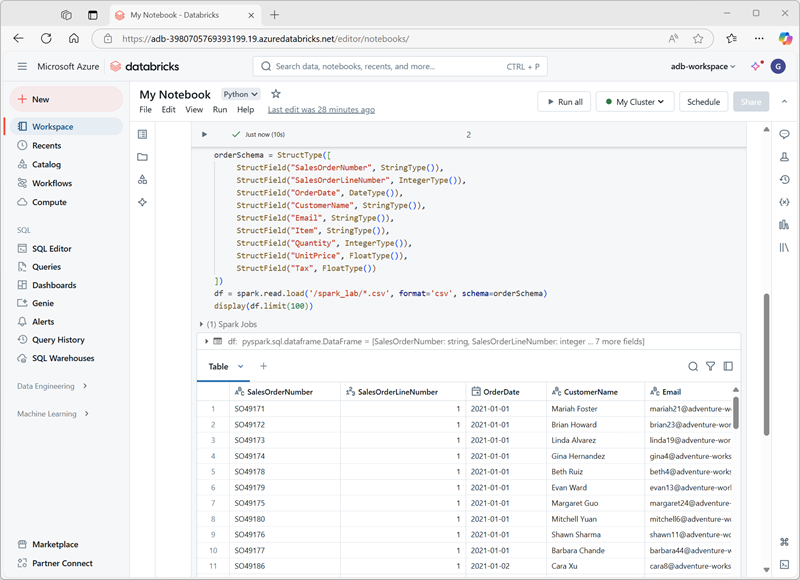

Köra Spark-kod i notebook-filer

Azure Databricks innehåller ett integrerat notebook-gränssnitt för att arbeta med Spark. Notebook-filer är ett intuitivt sätt att kombinera kod med Markdown-anteckningar, som ofta används av dataforskare och dataanalytiker. Utseendet och känslan i den integrerade notebook-upplevelsen i Azure Databricks liknar Jupyter Notebooks – en populär öppen källkod notebook-plattform.

Notebook-filer består av en eller flera celler som var och en innehåller antingen kod eller markdown. Kodceller i notebook-filer har några funktioner som kan hjälpa dig att bli mer produktiv, inklusive:

- Syntaxmarkering och felstöd.

- Automatisk slutförande av kod.

- Interaktiva datavisualiseringar.

- Möjligheten att exportera resultat.

Dricks

Mer information om hur du arbetar med notebook-filer i Azure Databricks finns i artikeln Notebooks i Azure Databricks-dokumentationen.