Använda en notebook-aktivitet i en pipeline

När du har skapat en länkad tjänst i Azure Data Factory för din Azure Databricks-arbetsyta kan du använda den för att definiera anslutningen för en Notebook-aktivitet i en pipeline.

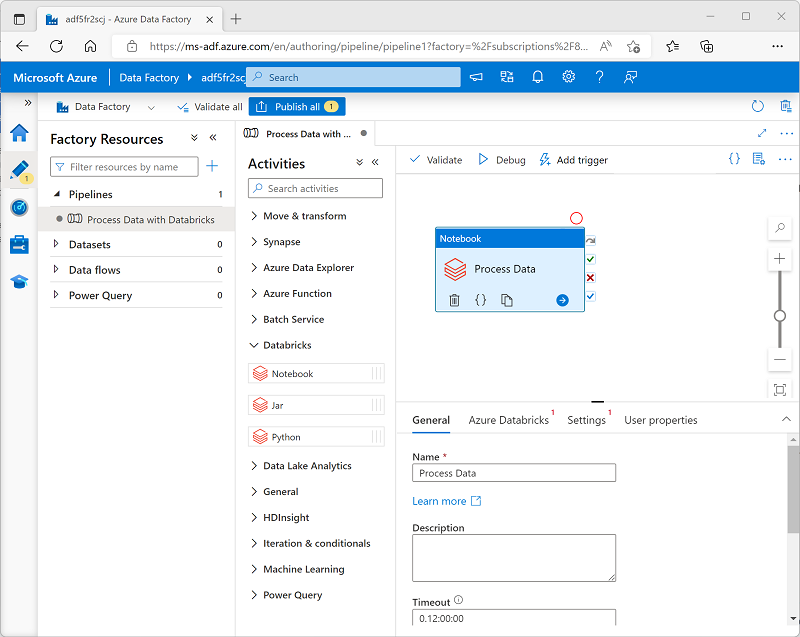

Om du vill använda en Notebook-aktivitet skapar du en pipeline och från kategorin Databricks lägger du till en Notebook-aktivitet på pipelinedesignytan.

Använd följande egenskaper för notebook-aktiviteten för att konfigurera den:

| Kategori | Inställning | Beskrivningar |

|---|---|---|

| Allmänt | Namn | Ett unikt namn för aktiviteten. |

| beskrivning | En beskrivande beskrivning. | |

| Timeout | Hur länge aktiviteten ska köras innan den avbryts automatiskt. | |

| Försök | Hur många gånger ska Azure Data Factory försöka innan det misslyckas. | |

| Återförsöksintervall | Hur lång tid det tar att vänta innan du försöker igen. | |

| Säkra indata och utdata | Avgör om indata- och utdatavärden loggas. | |

| Azure Databricks | Länkad Azure Databricks-tjänst | Den länkade tjänsten för Azure Databricks-arbetsytan som innehåller notebook-filen. |

| Inställningar | Notebook-sökväg | Sökvägen till notebook-filen på arbetsytan. |

| Basparametrar | Används för att skicka parametrar till notebook-filen. | |

| Tilläggsbibliotek | Obligatoriska kodbibliotek som inte är installerade som standard. | |

| Användaregenskaper | Anpassade användardefinierade egenskaper. |

Köra en pipeline

När pipelinen som innehåller notebook-aktiviteten publiceras kan du köra den genom att definiera en utlösare. Du kan sedan övervaka pipelinekörningar i avsnittet Övervaka i Azure Data Factory Studio.