Förstå Notebook-filer och pipelines för Azure Databricks

I Azure Databricks kan du använda notebook-filer för att köra kod som skrivits i Python, Scala, SQL och andra språk för att mata in och bearbeta data. Notebook-filer tillhandahåller ett interaktivt gränssnitt där du kan köra enskilda kodceller och använda Markdown för att inkludera anteckningar och anteckningar.

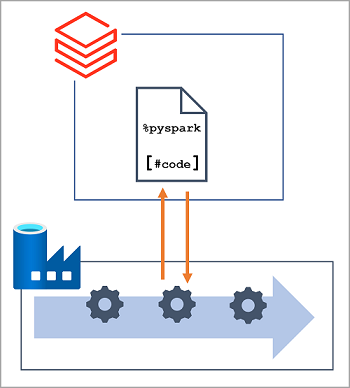

I många datatekniklösningar kan kod som skrivs och testas interaktivt senare införlivas i en automatiserad databehandlingsarbetsbelastning. I Azure implementeras sådana arbetsbelastningar ofta som pipelines i Azure Data Factory, där en eller flera aktiviteter används för att samordna en serie uppgifter som kan köras på begäran, med schemalagda intervall eller som svar på en händelse (till exempel nya data som läses in i en mapp i en datasjö). Azure Data Factory stöder en Notebook-aktivitet som kan användas för att automatisera obevakad körning av en notebook-fil på en Azure Databricks-arbetsyta.

Kommentar

Samma notebook-aktivitet är tillgänglig i pipelines som är inbyggda i Azure Synapse Analytics.