De tre kategorierna av AI-röd teamindelning

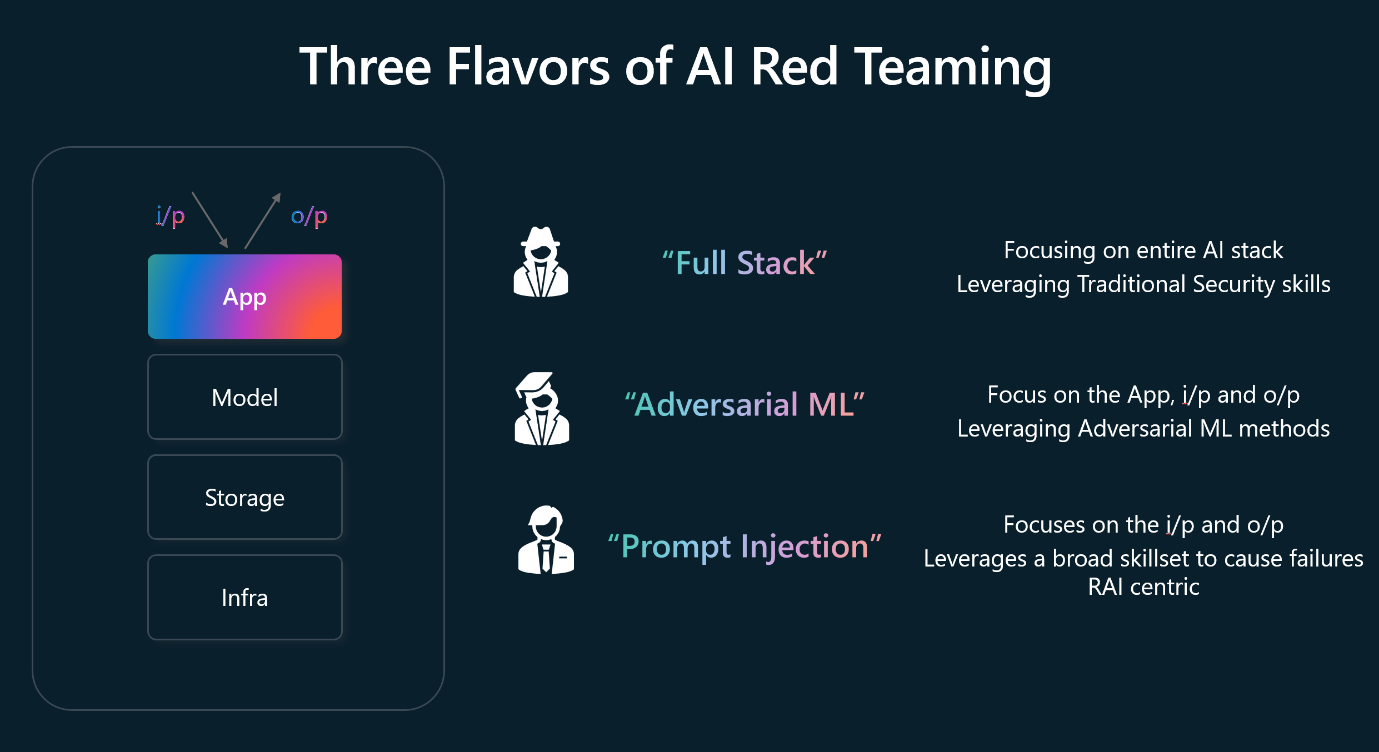

Genom processen att utföra AI-red teamindelning mot LLM:er och AI-aktiverade program som används av organisationen har Microsoft utvecklat tre olika kategorier, kallade smaker, för att beskriva olika typer av AI-röda teamindelning. Dessa smaker är:

- Full stack röd teamindelning

- Kontradiktorisk maskininlärning

- Snabbinmatning

Diagrammet ger en översikt över dessa tre smaker:

Full stack röd teamindelning

Full stack red teaming innebär avsökning för säkerhetsskador i hela AI-systemet, med fokus på att analysera hela teknikstacken. Detta inkluderar att utföra tester mot utvecklarens miljö ända fram till värdinfrastrukturen. Den röda teamindelningsmetoden för fullständig stack omfattar utvärdering av sårbarheter och potentiella attackvektorer, till exempel att identifiera svagheter i datapipelines, API:er och distributionskonfigurationer.

Kontradiktorisk maskininlärning

AML (Adversarial Machine Learning) är avsett för att studera maskininlärningsmodellattacker för att identifiera svaga punkter och skydda mot skadliga indata. AML betonar sårbarhetsbedömning och använder taktiker som black-box-attacker, där modeller manipuleras utan åtkomst till deras kod och white box-attacker, där modeller styrs med åtkomst till sin kod. Ett exempel på dess tillämpning är att göra små ändringar av vägskyltar för att lura självkörande fordons ML-modeller.

Snabbinmatning

Snabbinmatning syftar till att utnyttja LLM genom att injicera noggrant utformade uppmaningar. Det här fokuset ligger på att manipulera generativa AI-system till att läcka känsliga data eller sprida felaktig information. Till exempel skapar du en uppmaning på ett sådant sätt att LLM genererar känslig företagsinformation. En viktig utmaning är att skilja mellan utvecklarinstruktioner och användarindata, ett exempel på detta är att lura Bing Chat att avslöja sin programmering endast genom att ifrågasätta den via prompterna.