Scenarier för HPC- och Batch-tekniker

Varje HPC-utmaning (databehandling med höga prestanda) har sina egna krav och kräver ofta en unik lösning.

Som lösningsarkitekt för den tekniska organisationen måste du använda HPC-lösningar i Azure för att lösa de komplexa uppgifter som organisationen står inför. Dessa uppgifter omfattar återgivning av 3D-modeller av de anläggningar som företaget utformar och lagring av stora mängder statistiska data. Kärnan i HPC är att använda många datorer eller datorer som har högt angivna processor-, GPU- och minneskonfigurationer för att hantera komplexa, tidskrävande uppgifter.

Här får du lära dig mer om några vanliga HPC-användningsfall. Den här kunskapen bör hjälpa dig att identifiera framtida problem som kan åtgärdas med hjälp av HPC-lösningar.

Vanliga HPC-användningsfall

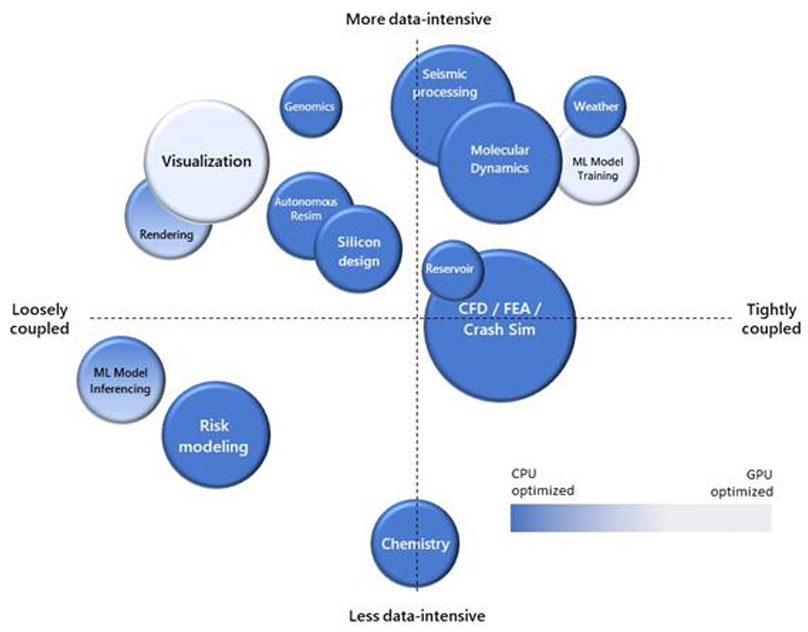

Organisationer använder HPC för att lösa olika affärsproblem. Dina krav kan vara unika, men ofta ingår ett användningsfall i ett av flera vanliga scenarier.

Analys av ändliga element

Finita elementanalyser handlar om problem som rör komplexa frågor inom teknisk fysik. Sådana problem kan omfatta värmeöverföring, strukturell analys, masstransport och elektromagnetisk potential. För att lösa dessa problem delas stora system in i mindre segment som kallas ändliga element och monteras ihop till ett större system med ekvationer.

Exempel är bilkraschsimulering och väderförutsägelse. Du kan betona de mest intressanta aspekterna av systemet. Bilkraschsimulering kan till exempel fokusera på fordonets framsida, medan vädersimuleringar kan optimeras för att identifiera extrema väderhändelser. Att använda finita elementanalyser för att modellera bilolyckor kräver bara specifikationen av fordonets strukturella geometri och materialsammansättning. De matematiska variationerna för vad som kan hända i en bilolycka under ett par sekunder är så stora att du kan behöva HPC för att modellera det korrekt.

3D-modellåtergivning

3D-återgivning är ett klassiskt användningsfall för HPC i molnet. En enskild dator kan ta timmar eller dagar att helt återge en 3D-videofil eller bild från statiska tillgångar. Du kan köpa en dyr och väl angiven dator för att hantera det här problemet. Men på grund av den hastighet med vilken tekniken åldras kan det vara mer ekonomiskt och effektivt att hyra den nödvändiga kraften i molnet. Använd Azure Batch för att hyra så mycket ström som du behöver för renderingen under den tid du har och stäng sedan av den när jobbet är klart. Du kan använda den här processen när du ofta har liknande jobb att slutföra.

Den underliggande infrastrukturen förbättras när teknikuppgraderingar blir tillgängliga. Med Batch kan du också använda några av de viktigaste 3D-renderingspaketen, till exempel Maya, 3D Studio Max och Chaos V-Ray. Du betalar eventuella licensavgifter per timme. Eftersom rendering är särskilt beskattande för processorn är det en effektiv lösning att distribuera virtuella datorer i H-serien till Batch-pooler.

Följande diagram visar en typisk Batch-arkitektur som du kan använda för att stödja 3D-återgivning.

DNA-analys

Genomics, studien av en enskild organisms fullständiga dna-uppsättning, är också väl lämpad för molnbaserade HPC-tekniker. Genomforskning omfattar vanligtvis stora mängder data. Konfigurationen av DNA spåras över ett tillräckligt stort antal individer för att identifiera betydande variation. I genomsnitt finns det cirka 25 000 gener i människokroppen, var och en består av instruktioner på mellan 500 och 2,3 miljoner bokstäver. Med HPC i molnet kan enorma mängder data lagras och arbetas effektivt, utan större kapitalutgifter för teknik som snabbt blir inaktuell.

Datorstödd design

Datorstödd design (CAD), som har vissa likheter med både finita elementanalyser och 3D Batch-rendering, är ett annat bra användningsfall för HPC i molnet. CAD påskyndar produktdesign och testning och gör att komplexa visualiseringar och simuleringar kan göras på de resulterande artefakterna.

Det här diagrammet visar en möjlig arkitektur som du kan använda för att publicera en CAD-programvara som en tjänstprodukt (SaaS), baserad på virtuella datorer i N- och H-serien i Azure.

Beräkningsströmningsdynamik

Beräkningsströmningsdynamik använder matematik för att modellera vätskeflöden, både fritt flödande och i interaktion med fasta ytor. Dessa simuleringar beskattas ur beräkningssynpunkt. De ger ett bra användningsfall för några av de mer invecklade aspekterna av de virtuella datorerna i H-serien som du såg tidigare. Dessa aspekter omfattar InfiniBand-nätverksfunktioner och en möjlighet att interagera via MPI (Message Passing Interface).

Beslutsvillkor

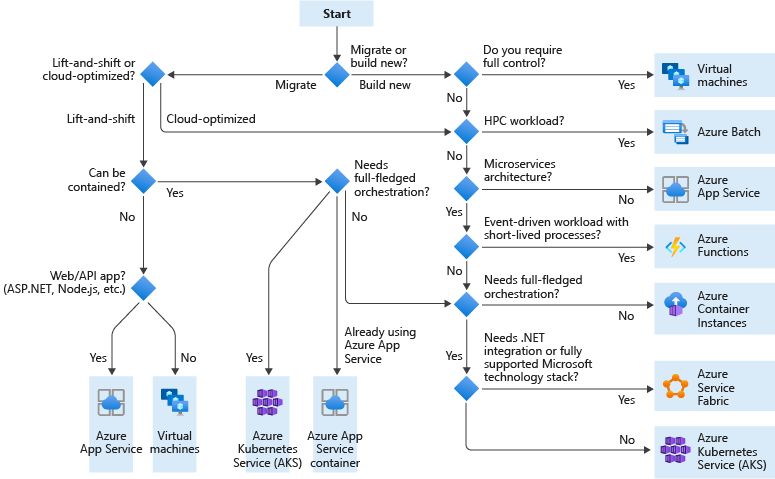

Vilken kandidattjänst använder jag?

Lift and Shift är en strategi för att migrera en arbetsbelastning till molnet utan att göra om programmet eller göra kodändringar. Kallas även för rehosting. Mer information finns i Azure Migration Center.

Molnoptimerad är en strategi för att migrera till molnet genom att omstrukturera ett program för att dra nytta av molnbaserade funktioner.

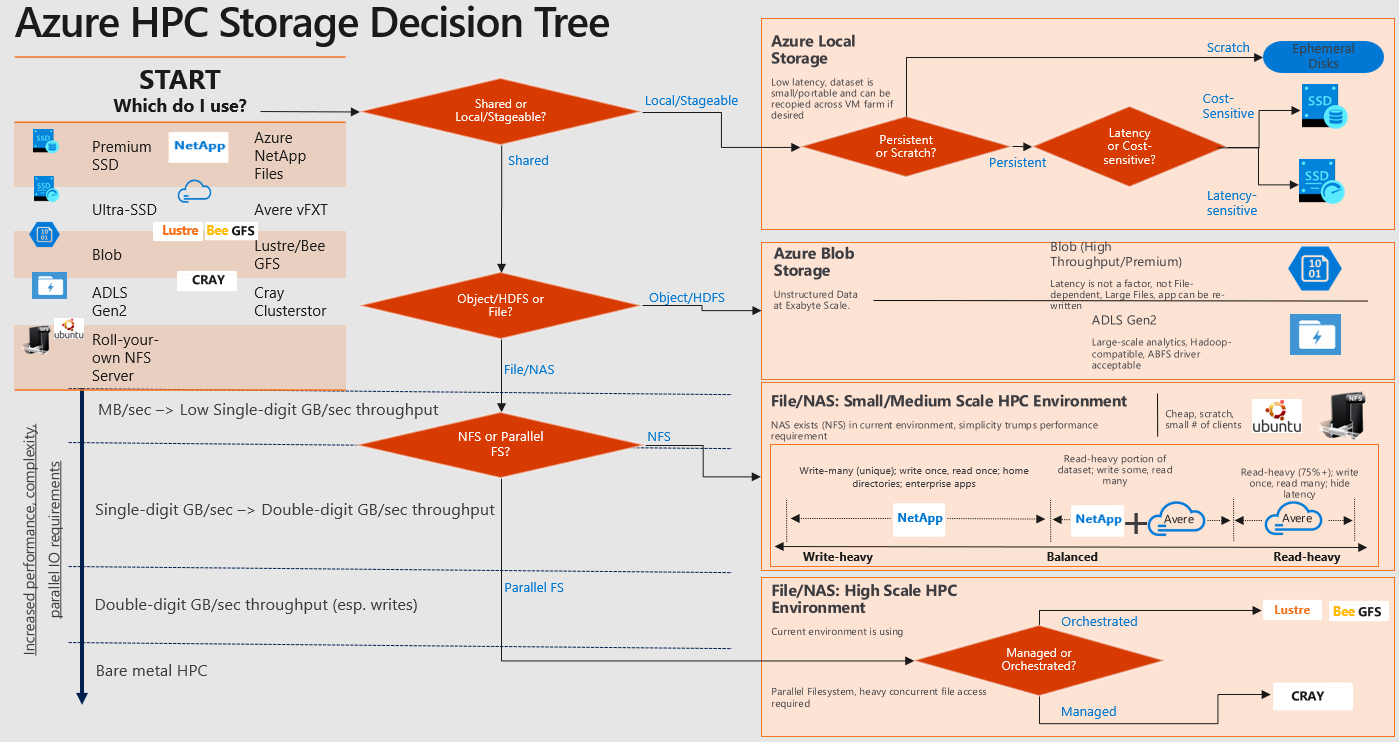

Vilken Azure HPC Storage-tjänst använder jag?

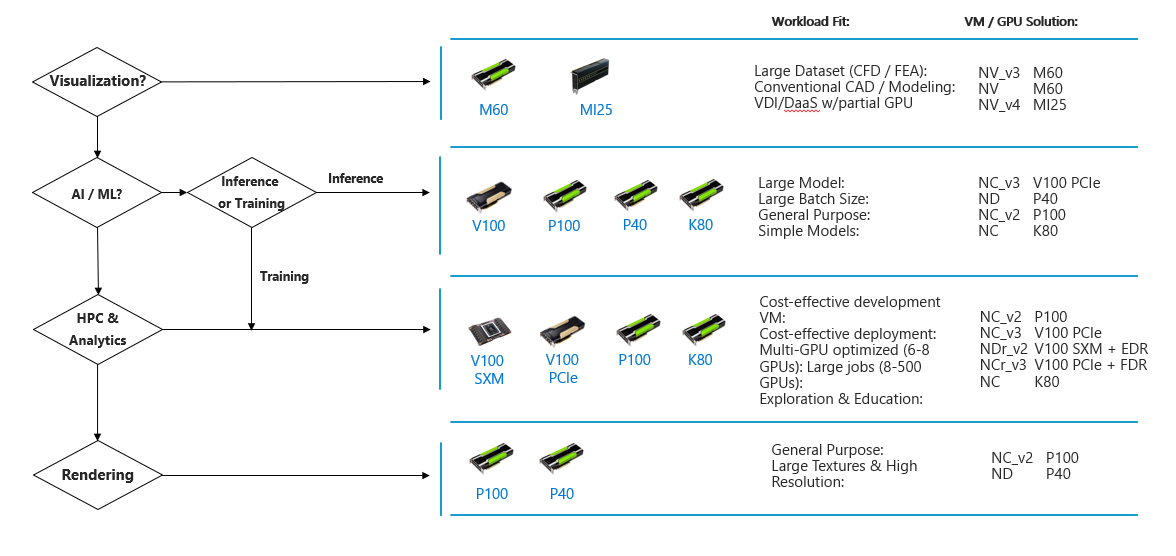

CPU-baserad jämfört med GPU-baserad databehandling

En processor (hjärnan) kan arbeta med olika beräkningar, medan en GPU (brawn) är bäst på att fokusera alla databehandlingsfunktioner på en specifik uppgift.

Även om enskilda CPU-kärnor är snabbare, mätt med CPU-klockhastighet, och smartare, mätt med tillgängliga instruktionsuppsättningar. Det stora antalet GPU-kärnor och den enorma mängd parallellitet som de erbjuder utgör skillnaden i klockhastighet med en kärna och begränsade instruktionsuppsättningar.

CPU

- CPU består av några kärnor som är optimerade för sekventiell seriebearbetning. Den är utformad för att maximera prestandan för en enskild uppgift i ett jobb.

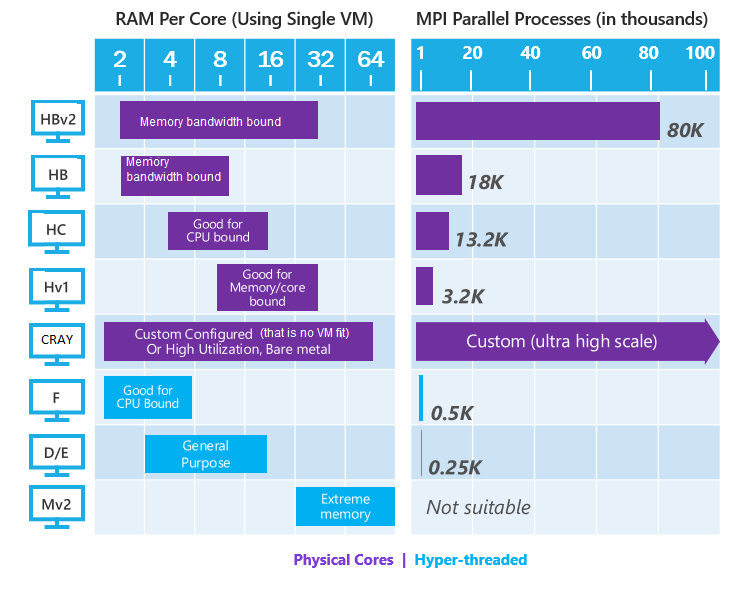

- Steg för att hitta rätt virtuell CPU-dator:

- Kontrollera om ett jobb för HPC-programmet körs på mindre än en dator eller använder MPI på flera datorer.

- Fastställ jobbets RAM-minne per kärnanvändning (till exempel 6 GB RAM per kärna) och jämför de instanser som passar.

- Om arbetsbelastningen kräver fysiska kärnor använder du de virtuella datorfamiljerna (visas i lila).

- Kontrollera tillgängligheten för önskade datorer.

- Cray gäller för alla arbetsbelastningar:

- Där en fungerande VM-typ inte är regionalt tillgänglig

- Vilka servrar har hög användning, används över 80%%

- Där vi inte har någon fungerande VM-konfiguration

GPU

- En GPU använder tusentals mindre och effektivare kärnor för en massivt parallell arkitektur som syftar till att hantera flera funktioner samtidigt.

- Moderna GPU:er ger överlägsen processorkraft, minnesbandbredd och effektivitet jämfört med cpu-motsvarigheterna. De är 50–100 gånger snabbare i uppgifter som kräver flera parallella processer.

Varför är nätverk med låg fördröjning viktigt för nära kopplade jobb?

Många HPC-program är mycket parallella och har nära kopplad kommunikation. Innebär att under en parallell simulering av program måste alla parallella processer kommunicera med varandra ofta.

Dessa typer av program presterar vanligtvis bäst när kommunikationen mellan de parallella processerna utförs på nätverk med hög bandbredd/låg latens, till exempel InfiniBand.

De här programmens nära kopplade karaktär innebär att om en enskild virtuell dator inte fungerar optimalt kan det leda till att jobbet har sämre prestanda.

Noder kräver betydande överlappning (chatt) med varandra för att fungera korrekt.