Förstå Azure Data Factory

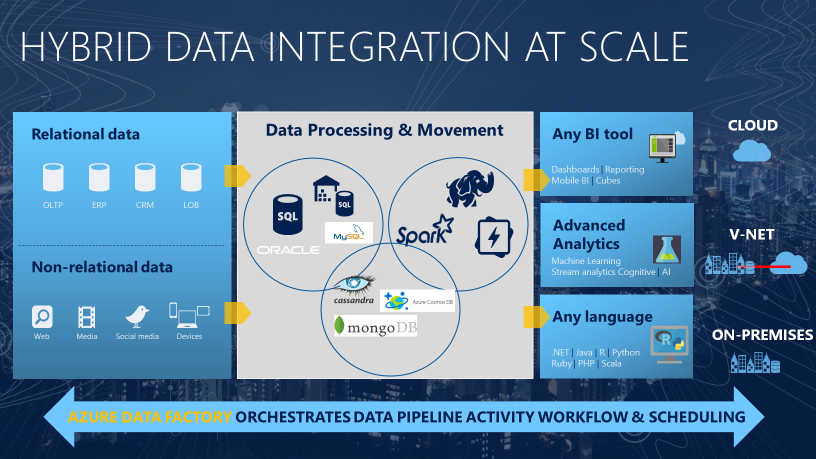

Behovet av att utlösa batchförflyttning av data eller att konfigurera ett regelbundet schema är ett krav för de flesta analyslösningar. Azure Data Factory (ADF) är den tjänst som kan användas för att uppfylla ett sådant krav. ADF tillhandahåller en molnbaserad dataintegreringstjänst som samordnar förflyttning och omvandling av data mellan olika datalager och beräkningsresurser.

Azure Data Factory är den molnbaserade ETL- och dataintegreringstjänsten som gör att du kan skapa datadrivna arbetsflöden för att orkestrera dataflytt och transformera data i stor skala. Med Azure Data Factory kan du skapa och schemalägga datadrivna arbetsflöden (så kallade ”pipelines”) som kan mata in data från olika datalager. Du kan skapa komplexa ETL-processer som transformerar data visuellt med dataflöden eller med hjälp av beräkningstjänster som Azure HDInsight Hadoop, Azure Databricks och Azure Synapse Analytics.

Mycket av funktionerna i Azure Data Factory visas i Azure Synapse Analytics som en funktion som kallas pipelines, som gör att du kan integrera datapipelines mellan SQL-pooler, Spark-pooler och SQL Serverless, vilket ger en enda kontaktpunkt för alla dina analytiska behov.

Vad menas med orkestrering

Tänk på en symfoniorkester för att använda en analogi. Den centrala medlemmen i orkestern är dirigenten. Dirigenten spelar inte instrumenten, de leder helt enkelt symfonimedlemmarna genom hela musikstycket som de framför. Musikerna använder sina egna färdigheter för att producera vissa ljud i olika skeden av symfonin, så de kanske bara lär sig vissa delar av musiken. Dirigenten orkestrerar hela musikstycket och är därför medveten om hela musiken som framförs. De kommer också att använda specifika armrörelser som ger instruktioner till musikerna hur ett musikstycke ska spelas.

ADF kan använda en liknande metod, även om den har inbyggda funktioner för att mata in och transformera data, men ibland instruerar den en annan tjänst att utföra det faktiska arbete som krävs för dess räkning, till exempel en Databricks för att köra en transformeringsfråga. Så i det här fallet skulle det vara Databricks som utför arbetet, inte ADF. ADF samordnar bara körningen av frågan och tillhandahåller sedan pipelines för att flytta data till nästa steg eller mål.

Den innehåller också omfattande visualiseringar för att visa härkomst och beroenden mellan dina datapipelines och övervaka alla datapipelines från en enda enhetlig vy för att enkelt hitta problem och konfigurera övervakningsaviseringar.