Övning – Integrera och använda taligenkänning och transkription

I den här modulen skapar du ett Mixed Reality-program som utforskar användningen av Azure Speech Services med HoloLens 2. När du har slutfört den här serien kan du använda enhetens mikrofon för att transkribera tal till text i realtid, översätta ditt tal till andra språk och använda funktionen Avsiktsigenkänning för att förstå röstkommandon med artificiell intelligens.

Skapa och förbereda Unity-projektet

I det här avsnittet ska du skapa ett nytt Unity-projekt och förbereda det för MRTK-utveckling.

Som en förutsättning kontrollerar du att du har slutfört stegen nedan för att initiera projektet och programmet:

- Skapa Unity-projektet och ge det ett lämpligt namn, till exempel MRTK-handledningar

- Byta byggplattform

- Importerar nödvändiga TextMeshPro-resurser

- Importera Mixed Reality Verktygssats

- Konfigurera Unity-projektet

- Skapa och konfigurera scenen och ge den ett lämpligt namn; till exempel AzureSpeechServices

Not

Du kan lära dig hur du konfigurerar ditt mixed reality-projekt i modulen Introduction to Mixed Reality Toolkit.

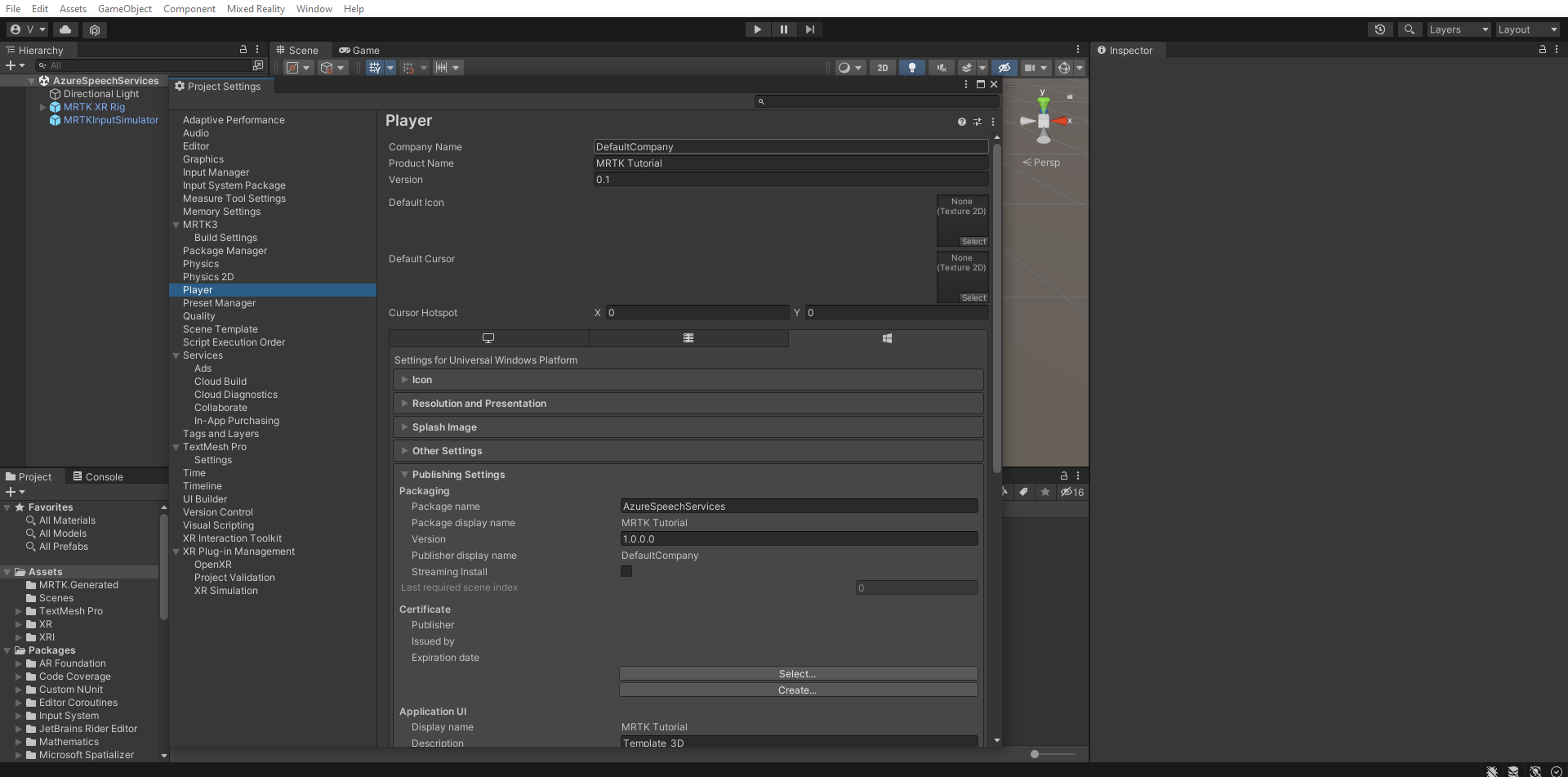

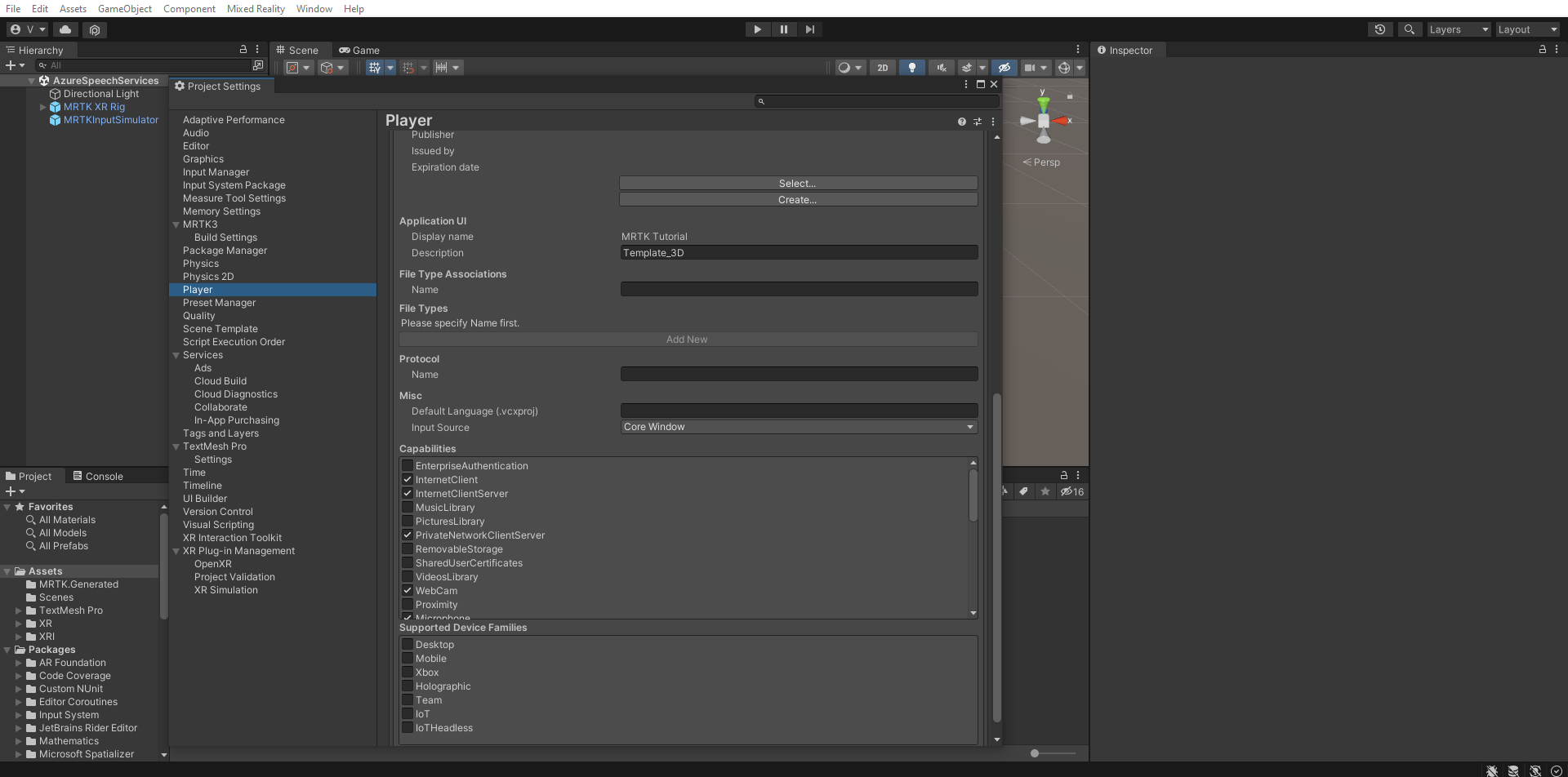

Konfigurera funktionerna

I Unity-menyn väljer du Redigera>Projektinställningar... för att öppna fönstret Spelarinställningar och leta upp avsnittet Player>Publishing Settings:

I avsnittet Publiceringsinställningarrullar du ned till avsnittet Funktioner och dubbelkollar att InternetClient, Microphoneoch SpatialPerception funktioner (som du aktiverade när du skapade projektet i början av självstudien) fortfarande är aktiverade. Aktivera sedan funktionerna InternetClientServer och PrivateNetworkClientServer.

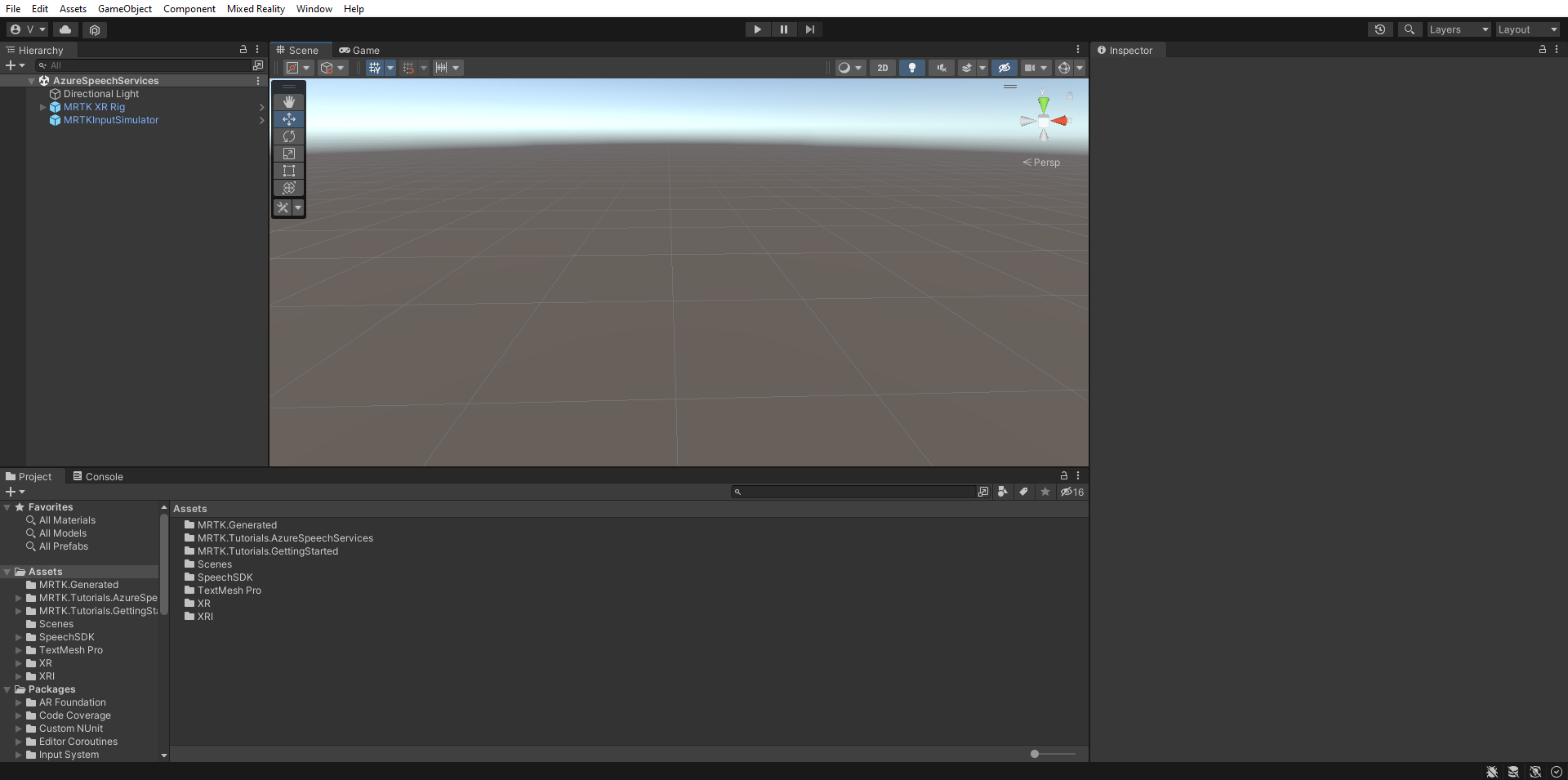

Importera handledningstillgångarna

Ladda ned och importera följande anpassade Unity-paket i den ordning de är listade:

När du har importerat självstudietillgångarna bör projektfönstret se ut så här:

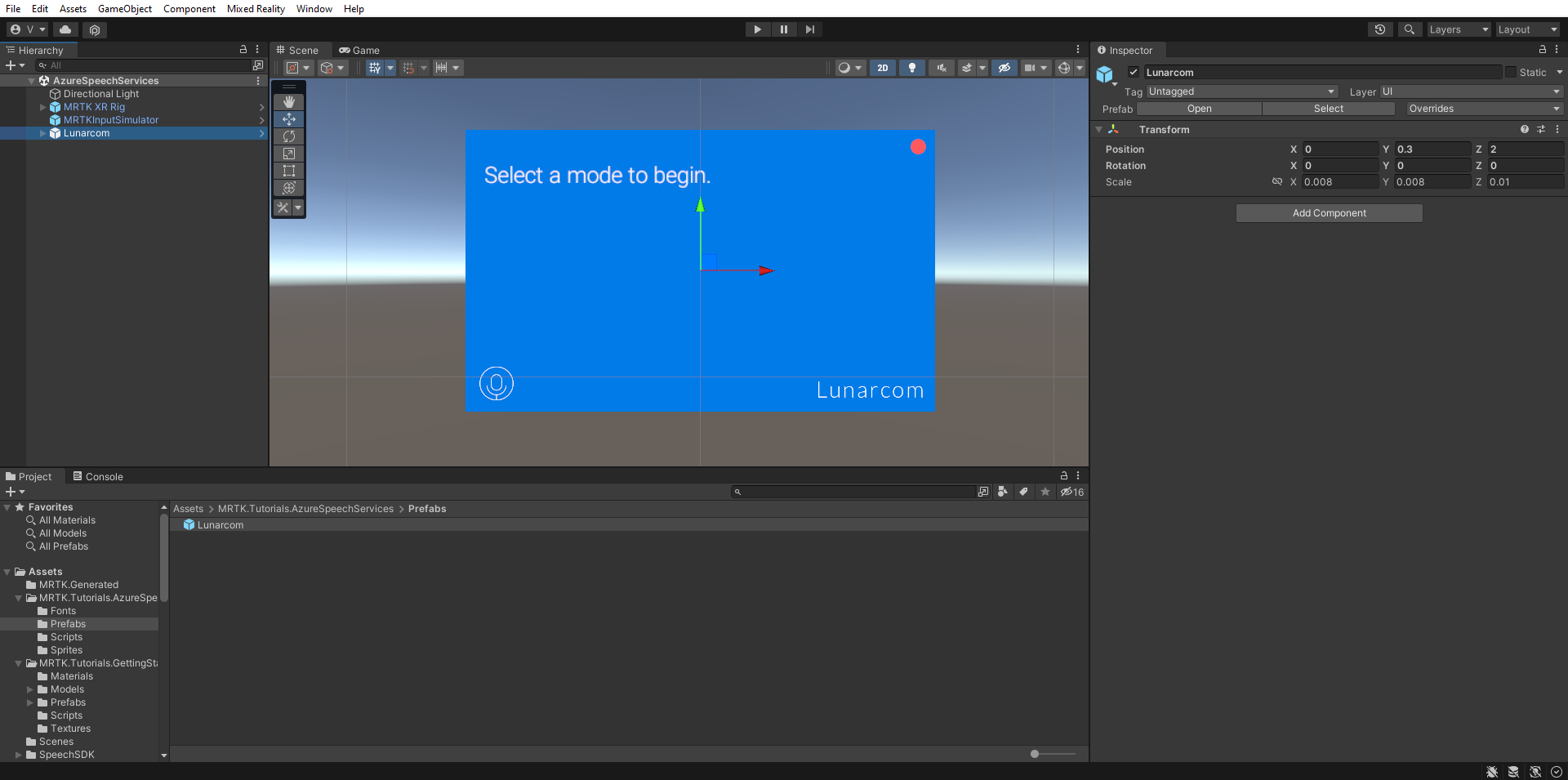

Förbereda scenen

I det här avsnittet förbereder du scenen genom att lägga till prefaben från självstudiekursen och konfigurera komponenten Lunarcom Controller (Script) för att styra din scen.

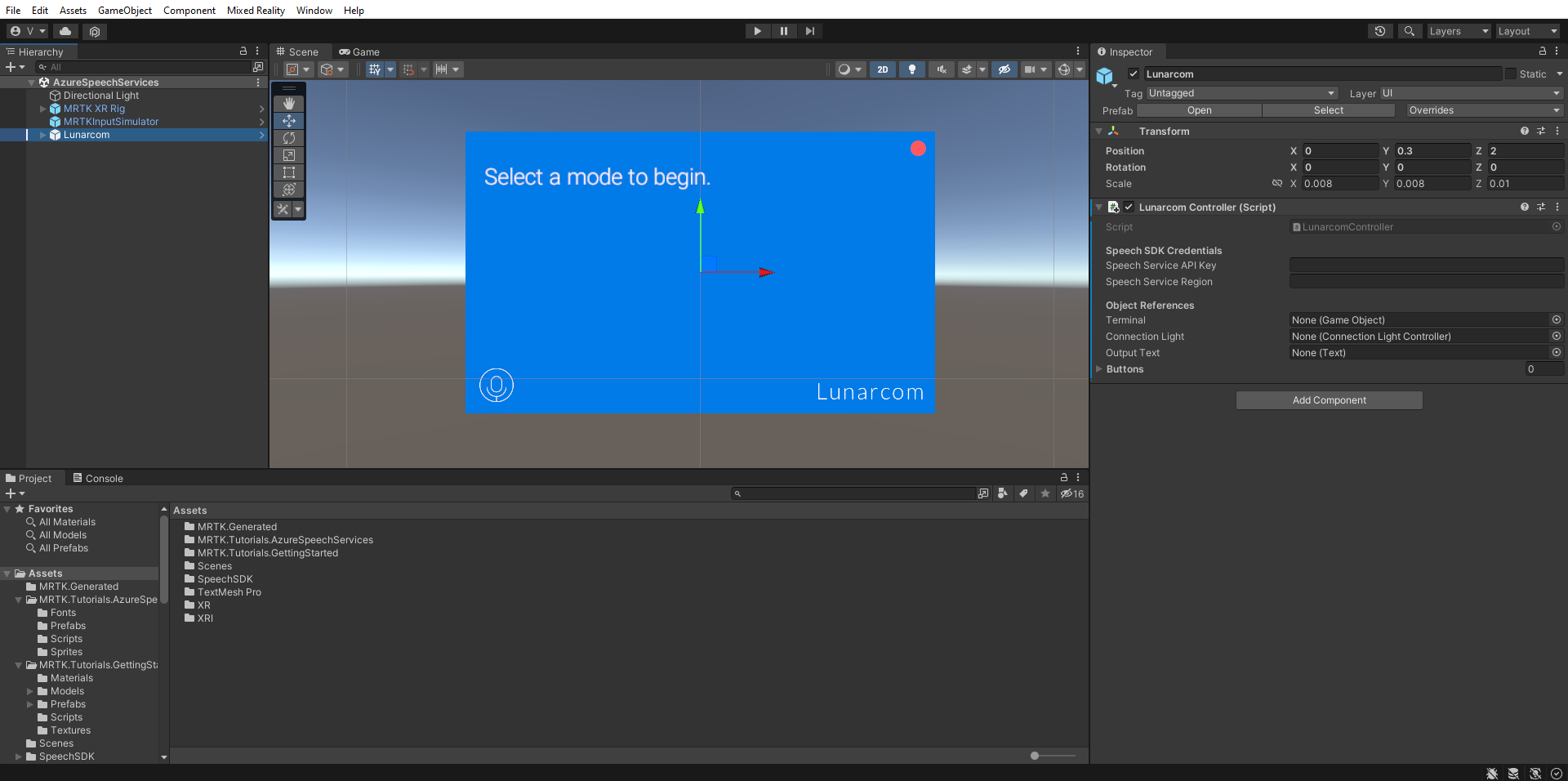

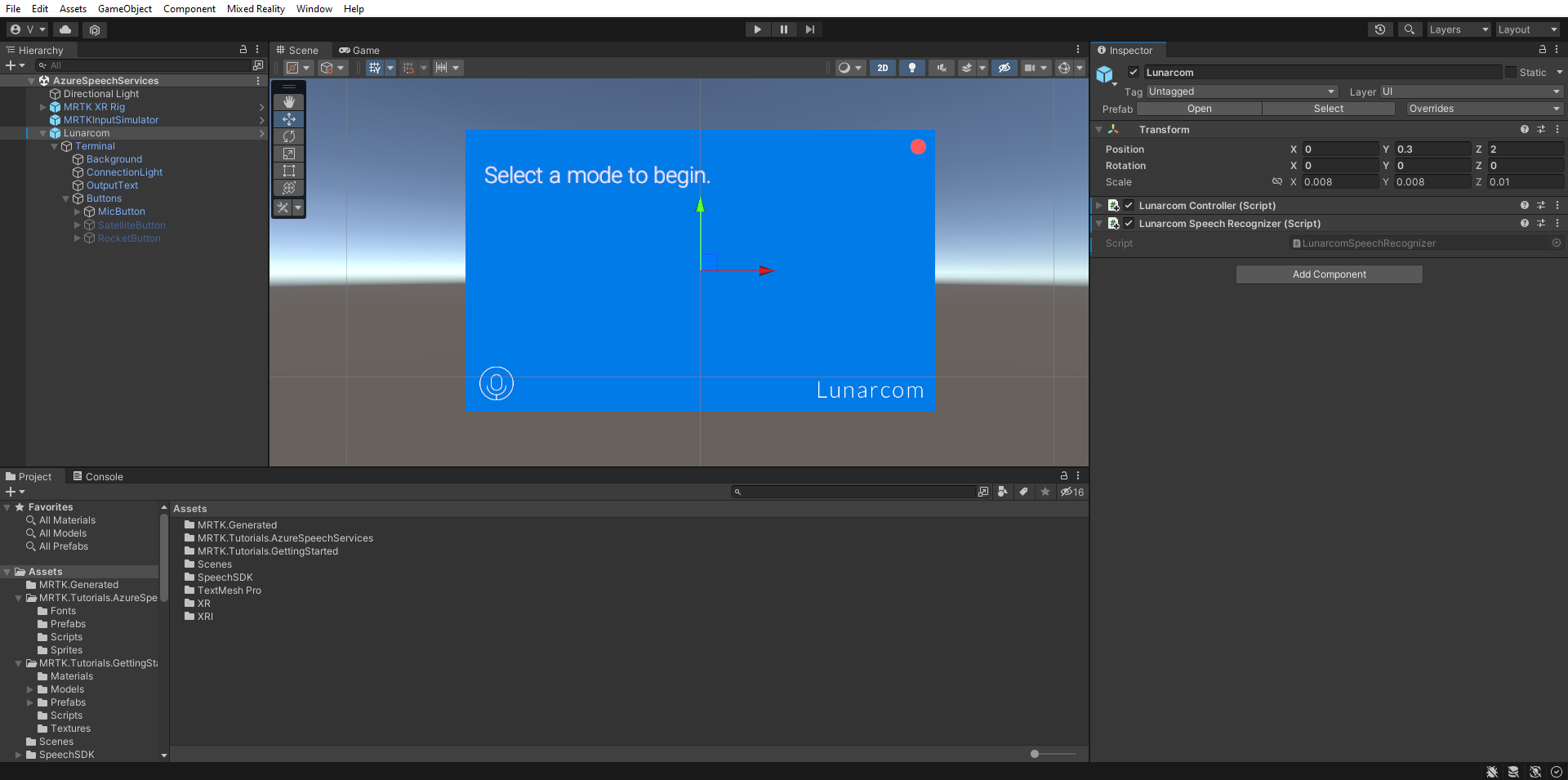

I Projektfönstret navigerar du till Assets>MRTK.Tutorials.AzureSpeechServices>Prefabs-mappen och dra prefaben Lunarcom till Hierarkifönstret för att lägga till den i scenen.

Med det fortfarande markerade Lunarcom-objektet i hierarkifönstret använder du knappen Lägg till komponent för att lägga till Lunarcom Controller (skript)-komponenten till Lunarcom-objektet.

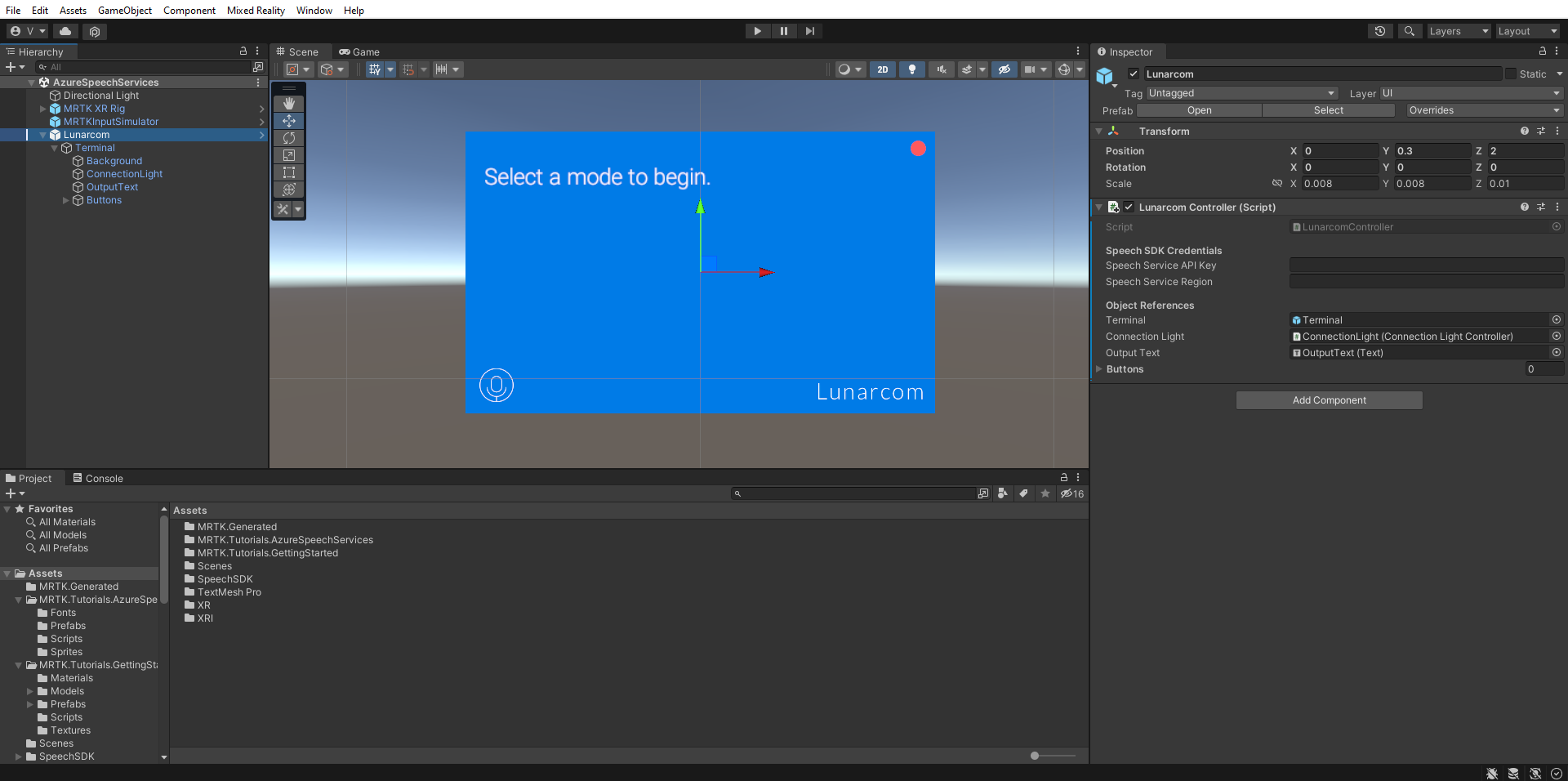

När Lunarcom- objekt fortfarande är markerat expanderar du det för att visa dess underordnade objekt och drar sedan objektet Terminal till komponenten Lunarcom Controller (Skript) Terminal-fältet.

När Lunarcom- objekt fortfarande är markerat expanderar du terminalobjektet för att visa dess underordnade objekt och drar sedan objektet ConnectionLight till komponenten Lunarcom Controller (Skript) Anslutningsljus och objektet OutputText till fältet Utdatatext.

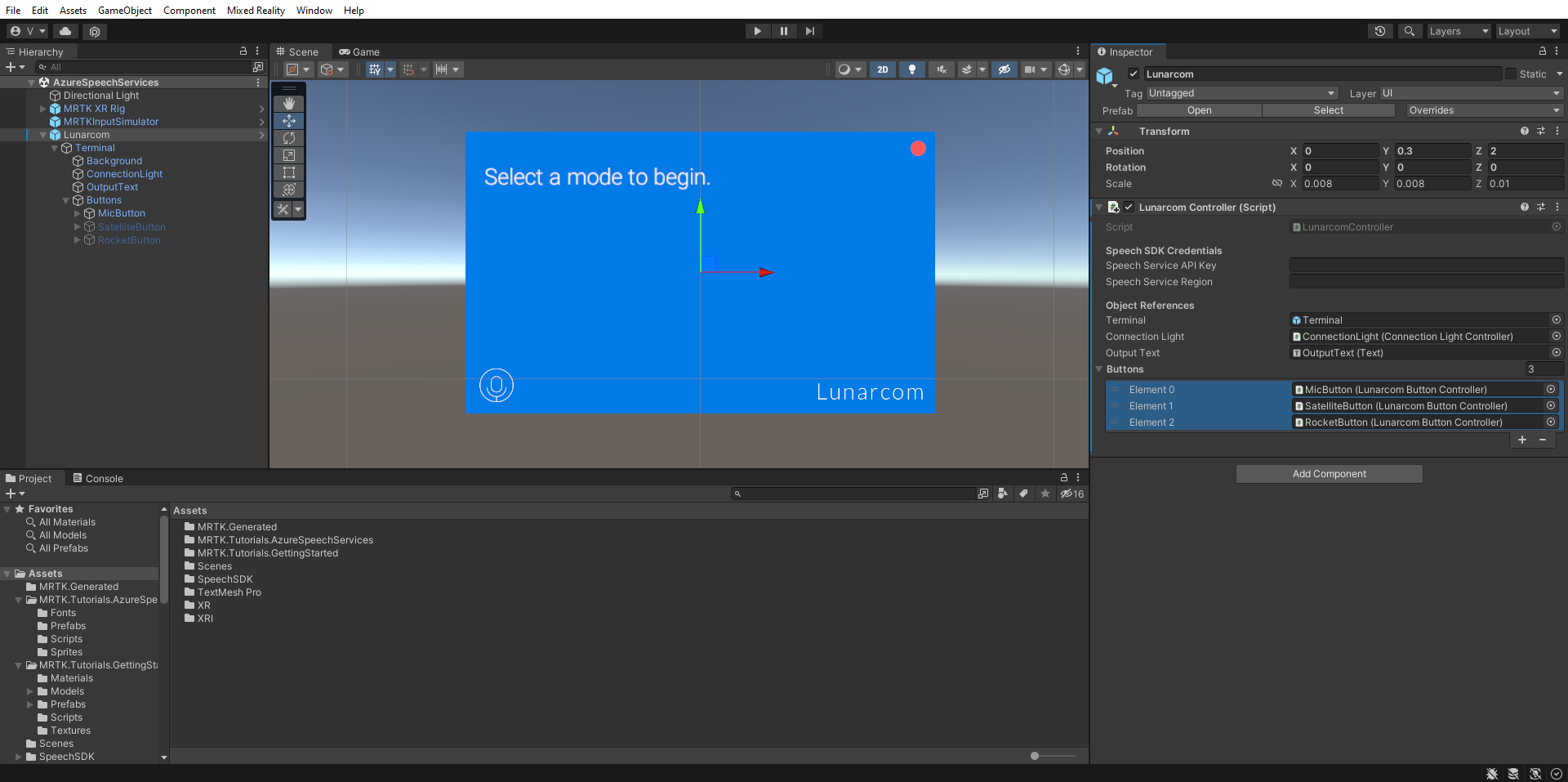

Med Lunarcom-objektet fortfarande markerat, expandera objektet Knappar för att visa dess underordnade objekt och expandera sedan listan Knappar i fönstret Inspektör, ange fältet Knappar till 3och dra MicButton, SatelliteButtonoch RocketButton-objekten till fälten Element 0, 1 och 2 respektive.

Ansluta Unity-projektet till Azure-resursen

Om du vill använda Azure Speech Services måste du skapa en Azure-resurs och hämta en API-nyckel för Speech Service. Följ snabbstartsanvisningarna och anteckna tjänstregionen (kallas även Plats) och API-nyckel (kallas även Key1 eller Key2).

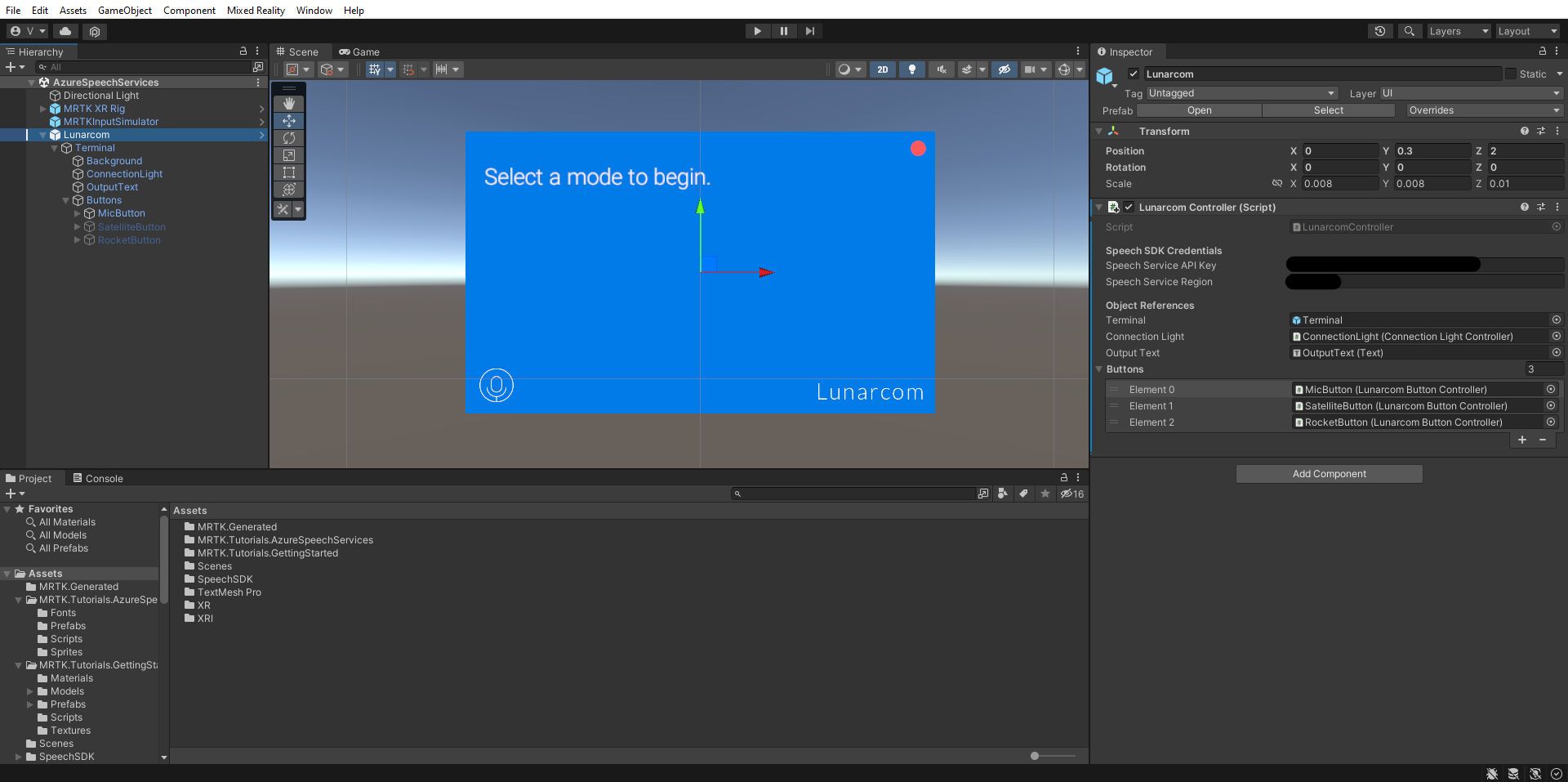

I hierarkifönstret väljer du objektet Lunarcom. Leta sedan i inspektörfönstret efter komponenten Lunarcom Controller (skript) och dess sektion Speech SDK-autentiseringsuppgifterna, och konfigurera det på följande sätt:

- I fältet SPEECH Service API Key anger du din API-nyckel (Key1 eller Key2).

- I fältet Speech Service Region anger du din tjänstregion (plats) med små bokstäver och utan mellanslag.

Använda taligenkänning för att transkribera tal

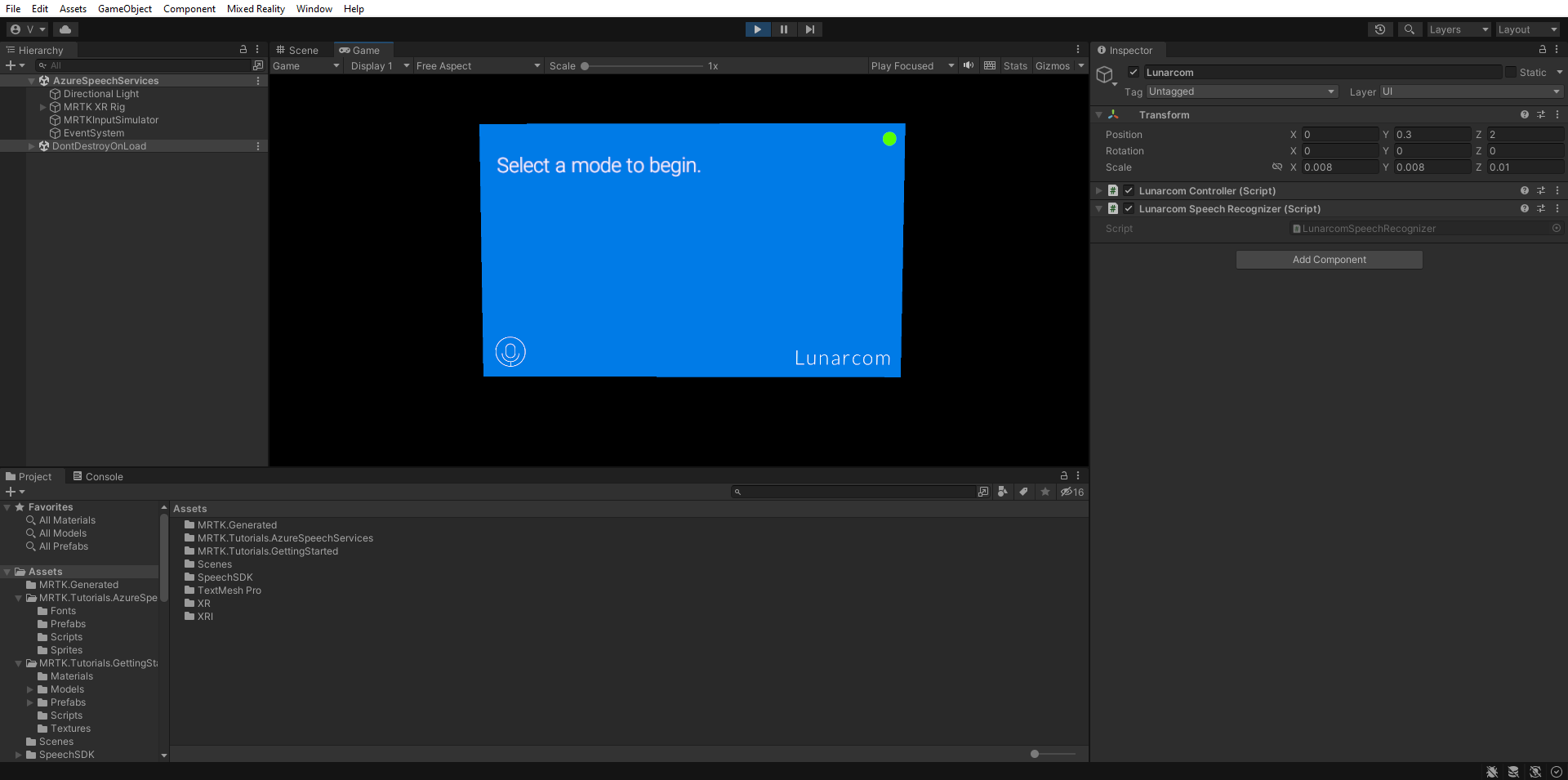

I hierarkifönstret väljer du objektet Lunarcom och i fönstret Inspector använder du sedan knappen Lägg till komponent för att lägga till Lunarcom Speech Recognizer (Skript) komponent till Lunarcom-objektet.

Om du nu anger Spelläge och väljer knappen Spela upp kan du testa taligenkänningen genom att först trycka på mikrofonknappen:

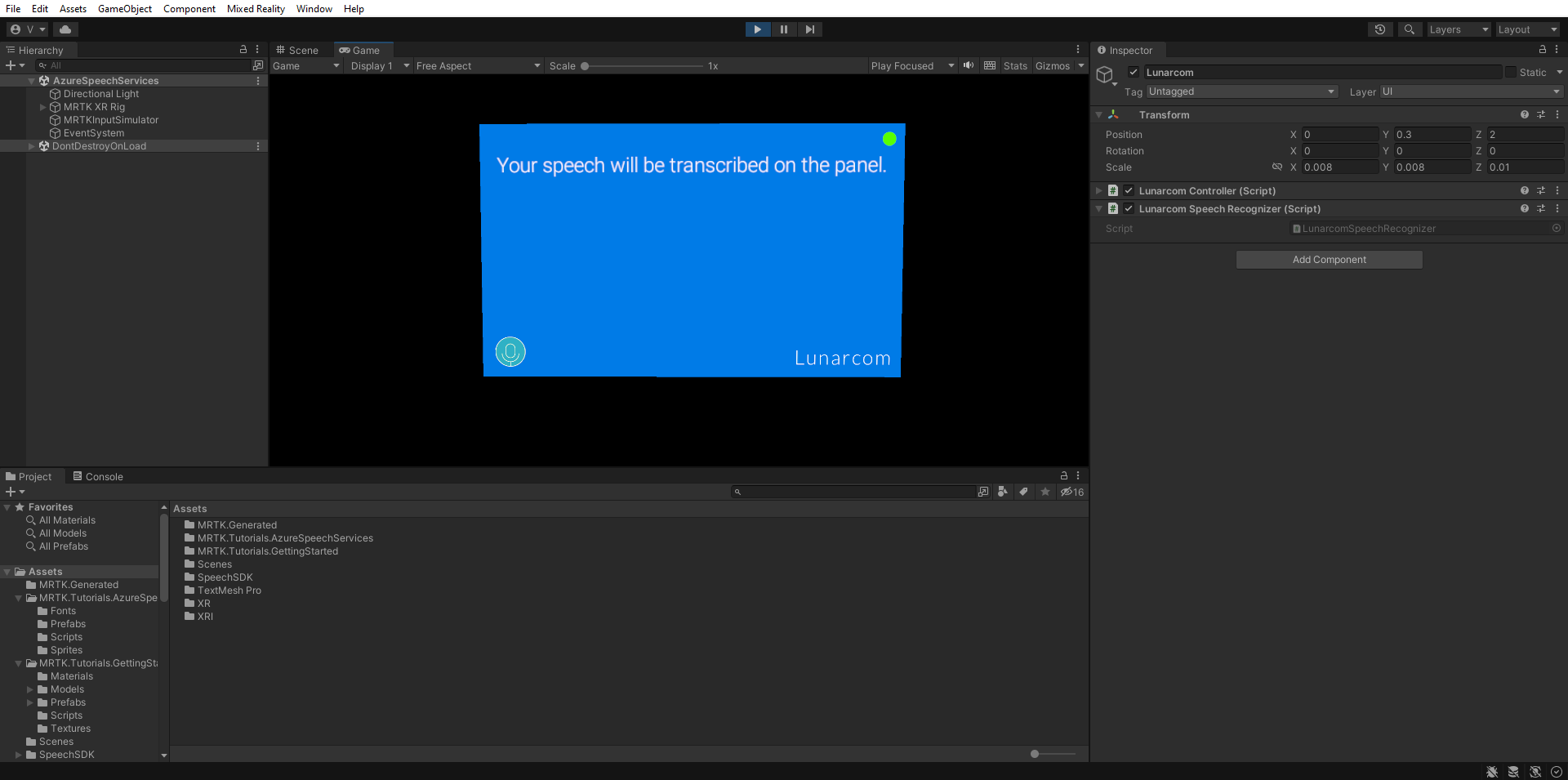

Sedan, förutsatt att datorn har en mikrofon, kommer ditt tal att transkriberas på terminalpanelen när du säger något:

Försiktighet

Programmet måste ansluta till Azure, så se till att datorn/enheten är ansluten till Internet.