Förstå skillnaderna mellan dataflödestyper

Dataflöden används för att extrahera, transformera och läsa in data till ett lagringsmål där de kan användas för olika scenarier. Eftersom inte alla lagringsmål har samma egenskaper skiljer sig vissa dataflödesfunktioner och beteenden beroende på lagringsmålet som dataflödet läser in data i. Innan du skapar ett dataflöde är det viktigt att förstå hur data ska användas och välja lagringsmål enligt kraven i din lösning.

Om du väljer ett lagringsmål för ett dataflöde avgörs dataflödets typ. Ett dataflöde som läser in data i Dataverse-tabeller kategoriseras som ett standarddataflöde. Dataflöden som läser in data till analystabeller kategoriseras som ett analytiskt dataflöde.

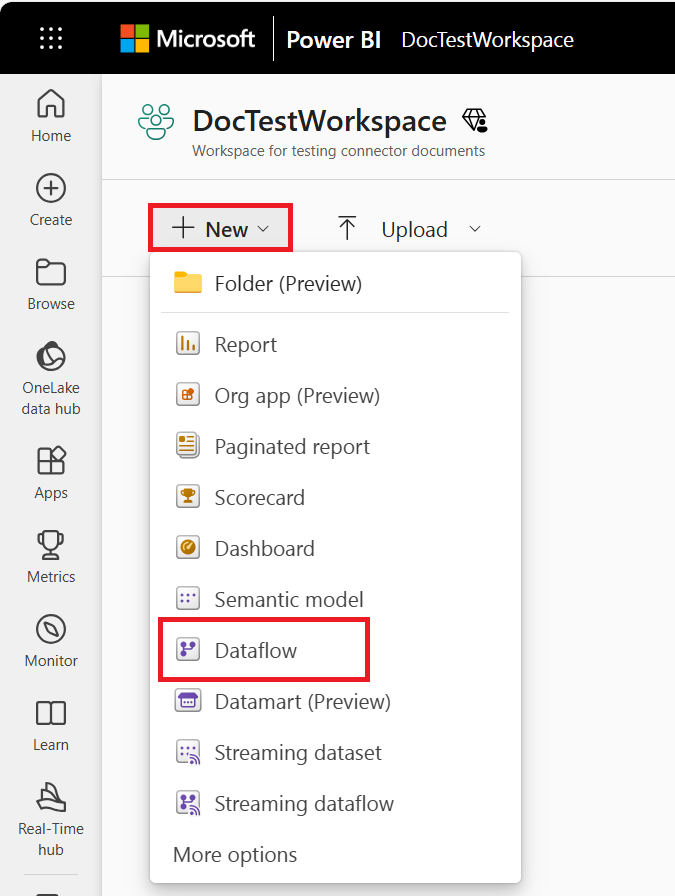

Dataflöden som skapas i Power BI är alltid analytiska dataflöden. Dataflöden som skapas i Power Apps kan antingen vara standard eller analytiska, beroende på ditt val när du skapar dataflödet.

Standarddataflöden

Ett standarddataflöde läser in data till Dataverse-tabeller. Standarddataflöden kan bara skapas i Power Apps. En fördel med att skapa den här typen av dataflöde är att alla program som är beroende av data i Dataverse kan fungera med data som skapas av standarddataflöden. Vanliga program som använder Dataverse-tabeller är Power Apps, Power Automate, AI Builder och Power Virtual Agents.

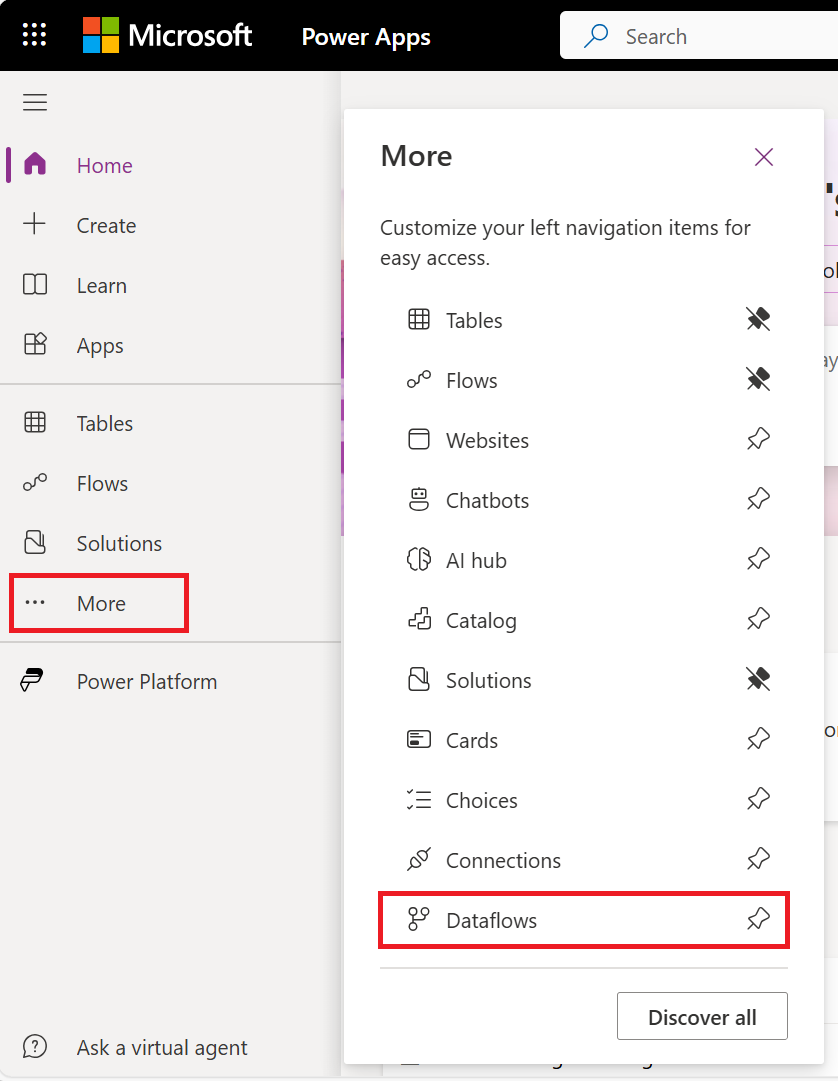

Så här skapar du ett dataflöde i Power Apps:

På power apps-flikarna väljer du Mer.

Välj Dataflöden.

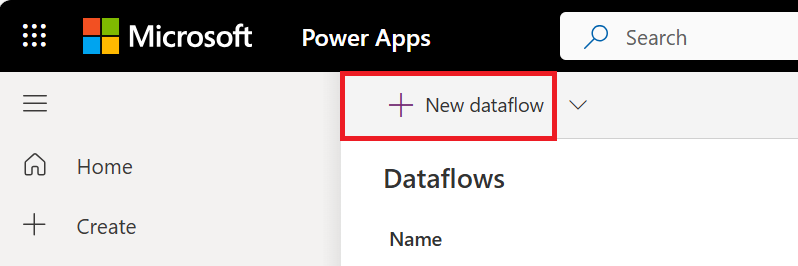

Välj Nytt dataflöde.

Om du skapar ditt första dataflöde kan du också välja knappen Skapa ett dataflöde .

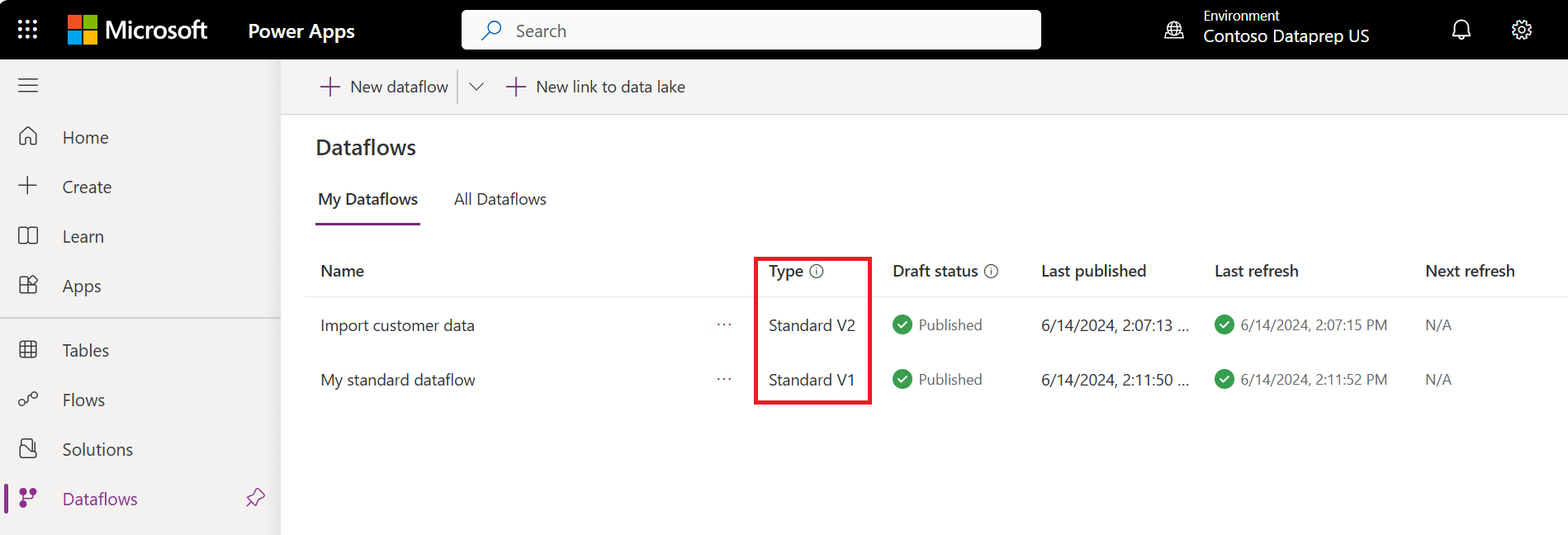

Standardversioner av dataflöden

Kommentar

Vi rekommenderar att Power Platform-dataflödesanvändare migrerar från V1-standarddataflöden till V2-standarddataflöden. Standard V1-dataflöden är på väg att avbryta supporten inom en snar framtid. Mer information om hur du migrerar till V2-standarddataflöden finns i Migrera ett V1-standarddataflöde till ett standard-V2-dataflöde.

Vi har arbetat med betydande uppdateringar av standarddataflöden för att förbättra deras prestanda och tillförlitlighet. Dessa förbättringar blir så småningom tillgängliga för alla standarddataflöden. Men under tiden skiljer vi mellan befintliga standarddataflöden (version 1) och nya standarddataflöden (version 2) genom att lägga till en versionsindikator i Power Apps.

Funktionsjämförelse för standarddataflödesversioner

I följande tabell visas de viktigaste funktionsskillnaderna mellan standarddataflödena V1 och V2 och innehåller information om varje funktions beteende i varje version.

| Funktion | Standard V1 | Standard V2 |

|---|---|---|

| Maximalt antal dataflöden som kan sparas med automatiskt schema per kundklientorganisation | 50 | Obegränsat |

| Maximalt antal poster som matas in per fråga/tabell | 500,000 | Obegränsad. Det maximala antalet poster som kan matas in per fråga eller tabell beror nu på dataverse-tjänstskyddsgränser vid tidpunkten för inmatningen. |

| Inmatningshastighet i Dataverse | Baslinjeprestanda | Förbättrade prestanda med några faktorer. Faktiska resultat kan variera och beror på egenskaperna för de data som matas in och belastningen på Dataverse-tjänsten vid tidpunkten för inmatningen. |

| Inkrementell uppdateringsprincip | Stöds inte | Stöds |

| Motståndskraft | När dataverse-tjänstskyddsgränser påträffas görs en post på nytt upp till tre gånger. | När dataverse-tjänstskyddsgränser påträffas görs en post på nytt upp till tre gånger. |

| Power Automate integrering | Stöds inte | Stöds |

Analytiska dataflöden

Ett analytiskt dataflöde läser in data till lagringstyper som är optimerade för analys – Azure Data Lake Storage. Microsoft Power Platform-miljöer och Power BI-arbetsytor ger kunderna en hanterad lagringsplats för analys som paketeras med dessa produktlicenser. Dessutom kan kunder länka organisationens Azure Data Lake-lagringskonto som mål för dataflöden.

Analytiska dataflöden kan ha ytterligare analysfunktioner. Till exempel integrering med Power BI:s AI-funktioner eller användning av beräknade tabeller, som beskrivs senare.

Du kan skapa analytiska dataflöden i Power BI. Som standard läser de in data till Power BI:s hanterade lagring. Men du kan också konfigurera Power BI för att lagra data i organisationens Azure Data Lake Storage.

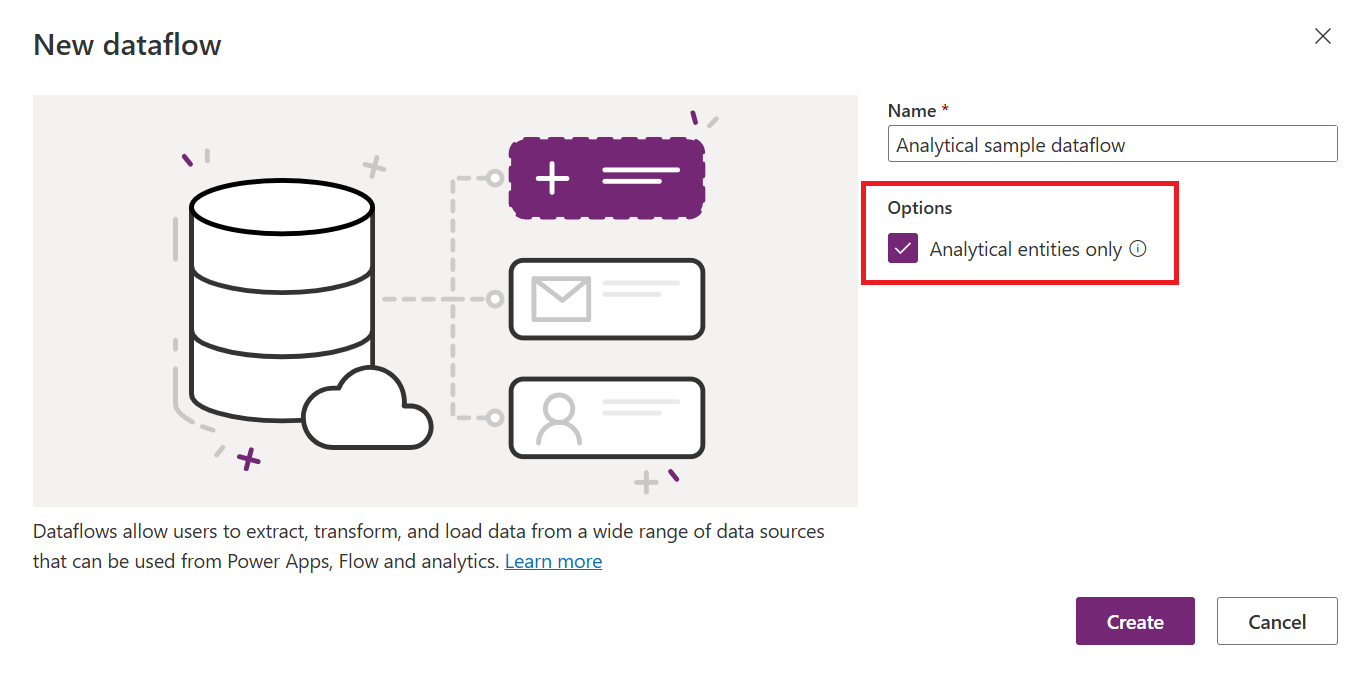

Du kan också skapa analytiska dataflöden i Power Apps- och Dynamics 365-kundinsiktsportaler. När du skapar ett dataflöde i Power Apps-portalen kan du välja mellan Dataverse-hanterad analyslagring eller i organisationens Azure Data Lake Storage-konto.

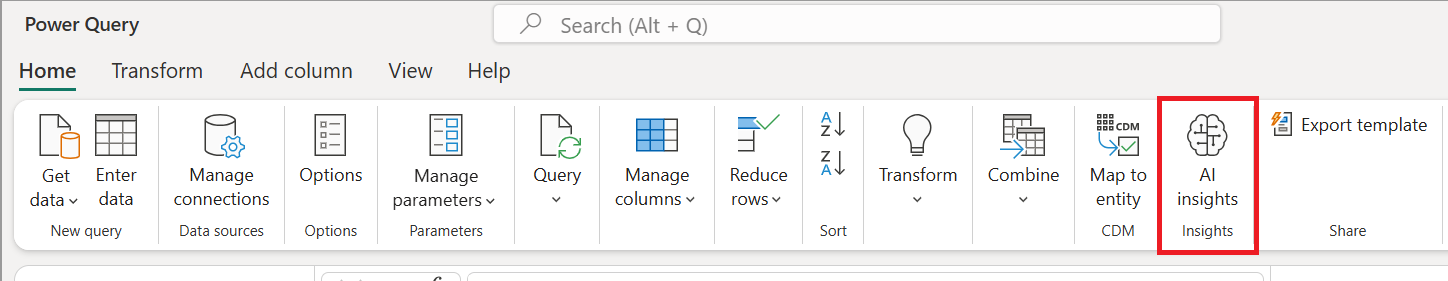

AI-integrering

Ibland kan du, beroende på kravet, behöva tillämpa vissa AI- och maskininlärningsfunktioner på data via dataflödet. Dessa funktioner är tillgängliga i Power BI-dataflöden och kräver en Premium-arbetsyta.

I följande artiklar beskrivs hur du använder AI-funktioner i ett dataflöde:

- Azure Machine Learning-integrering i Power BI

- Cognitive Services i Power BI

- Automatiserad maskininlärning i Power BI

De funktioner som anges i de föregående två avsnitten är specifika för Power BI och är inte tillgängliga när du skapar ett dataflöde i Power Apps- eller Dynamics 365-kundinsiktsportalerna.

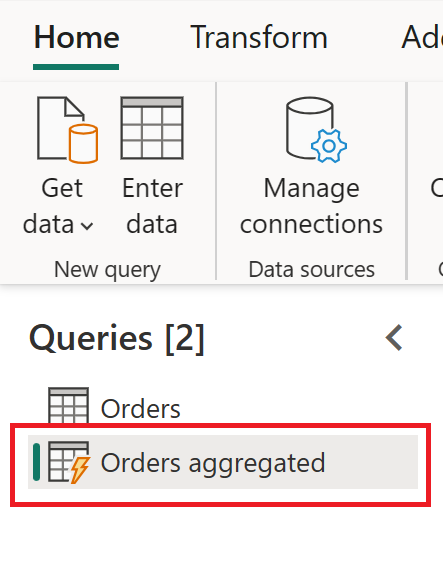

Beräknade tabeller

En av anledningarna till att använda en beräknad tabell är möjligheten att bearbeta stora mängder data. Den beräknade tabellen hjälper till i dessa scenarier. Om du har en tabell i ett dataflöde, och en annan tabell i samma dataflöde använder den första tabellens utdata, skapar den här åtgärden en beräknad tabell.

Den beräknade tabellen hjälper till med prestanda för datatransformeringar. I stället för att göra om de transformeringar som behövs i den första tabellen flera gånger görs omvandlingen bara en gång i den beräknade tabellen. Sedan används resultatet flera gånger i andra tabeller.

Mer information om beräknade tabeller finns i Skapa beräknade tabeller i dataflöden.

Beräknade tabeller är endast tillgängliga i ett analytiskt dataflöde.

Standard- eller analysdataflöden

I följande tabell visas några skillnader mellan en standardtabell och en analystabell.

| Åtgärd | Standard | Analytisk |

|---|---|---|

| Så här skapar du | Power Platform-dataflöden | Power BI-dataflöden Power Platform-dataflöden genom att markera kryssrutan Analytiska entiteter endast när du skapar dataflödet |

| Lagringsalternativ | Dataverse | Power BI tillhandahöll Azure Data Lake-lagring för Power BI-dataflöden, Dataverse tillhandahöll Azure Data Lake-lagring för Power Platform-dataflöden eller kunden tillhandahöll Azure Data Lake Storage |

| Power Query-transformeringar | Ja | Ja |

| AI-funktioner | Nej | Ja |

| Beräknad tabell | Nej | Ja |

| Kan användas i andra program | Ja, via Dataverse | Power BI-dataflöden: Endast i Power BI Power Platform-dataflöden eller externa Power BI-dataflöden: Ja, via Azure Data Lake Storage |

| Mappa till standardtabell | Ja | Ja |

| Stegvis inläsning | Standardinkrementell inläsning Det går att ändra med kryssrutan Ta bort rader som inte längre finns i frågeutdata i inläsningsinställningarna |

Standard full belastning Det går att konfigurera inkrementell uppdatering genom att konfigurera inkrementell uppdatering i dataflödesinställningarna |

| Schemalagd uppdatering | Ja | Ja, möjligheten att meddela dataflödesägarna om felet |

Scenarier för att använda varje dataflödestyp

Här följer några exempelscenarier och rekommendationer för bästa praxis för varje typ av dataflöde.

Plattformsoberoende användning – standarddataflöde

Om din plan för att skapa dataflöden är att använda lagrade data på flera plattformar (inte bara Power BI, utan även andra Microsoft Power Platform-tjänster, Dynamics 365 och så vidare), är ett standarddataflöde ett bra val. Standarddataflöden lagrar data i Dataverse, som du kan komma åt via många andra plattformar och tjänster.

Tunga datatransformeringar i stora datatabeller – analytiskt dataflöde

Analytiska dataflöden är ett utmärkt alternativ för bearbetning av stora mängder data. Analytiska dataflöden förbättrar också databehandlingskraften bakom omvandlingen. Om data lagras i Azure Data Lake Storage ökar skrivhastigheten till ett mål. Jämfört med Dataverse (som kan ha många regler att kontrollera vid tidpunkten för datalagring) är Azure Data Lake Storage snabbare för läs-/skrivtransaktioner på en stor mängd data.

AI-funktioner – analytiskt dataflöde

Om du planerar att använda AI-funktioner via datatransformeringssteget är det bra att använda ett analytiskt dataflöde eftersom du kan använda alla AI-funktioner som stöds med den här typen av dataflöde.