Så här använder du Data Wrangler på Spark DataFrames

Data Wrangler, ett notebook-baserat verktyg för undersökande dataanalys, stöder nu både Spark DataFrames och Pandas DataFrames. Den genererar PySpark-kod, förutom Python-kod. En allmän översikt över Data Wrangler, som beskriver hur du utforskar och transformerar Pandas DataFrames, finns i huvudguiden. Den här självstudien visar hur du använder Data Wrangler för att utforska och transformera Spark DataFrames.

Förutsättningar

Skaffa en Microsoft Fabric-prenumeration. Eller registrera dig för en kostnadsfri utvärderingsversion av Microsoft Fabric.

Logga in på Microsoft Fabric.

Använd upplevelseväxlaren längst ned till vänster på din hemsida för att växla till Fabric.

Begränsningar

- Anpassade kodåtgärder stöds för närvarande endast för Pandas DataFrames.

- Data Wrangler-skärmen fungerar bäst på stora bildskärmar, även om du kan minimera eller dölja olika delar av gränssnittet för att hantera mindre skärmar.

Starta Data Wrangler med en Spark DataFrame

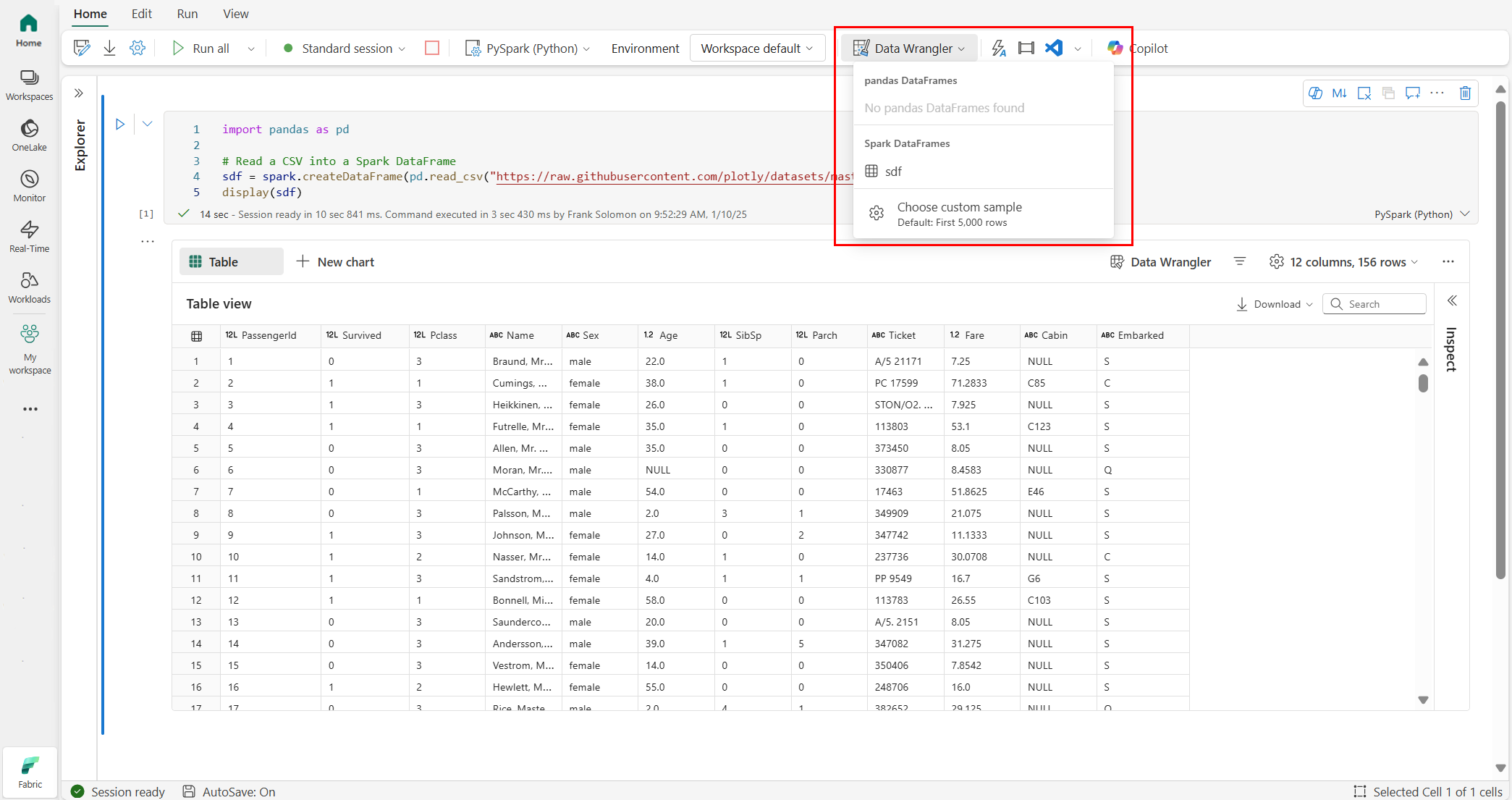

Användare kan öppna Spark DataFrames i Data Wrangler direkt från en Microsoft Fabric-notebook-fil genom att gå till samma listruta där Pandas DataFrames visas. En lista över aktiva Spark DataFrames visas i listrutan under listan över aktiva Pandas-variabler.

Det här kodfragmentet skapar en Spark DataFrame med samma exempeldata som används i pandas Data Wrangler-självstudien:

import pandas as pd

# Read a CSV into a Spark DataFrame

sdf = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(sdf)

På menyfliken Start i notebook-menyfliken använder du listrutan Data Wrangler för att bläddra bland aktiva dataramar som är tillgängliga för redigering. Välj den som du vill öppna i Data Wrangler.

Dricks

Det går inte att öppna Data Wrangler när notebook-kerneln är upptagen. En cell som körs måste slutföra körningen innan Data Wrangler kan startas, vilket visas i den här skärmbilden:

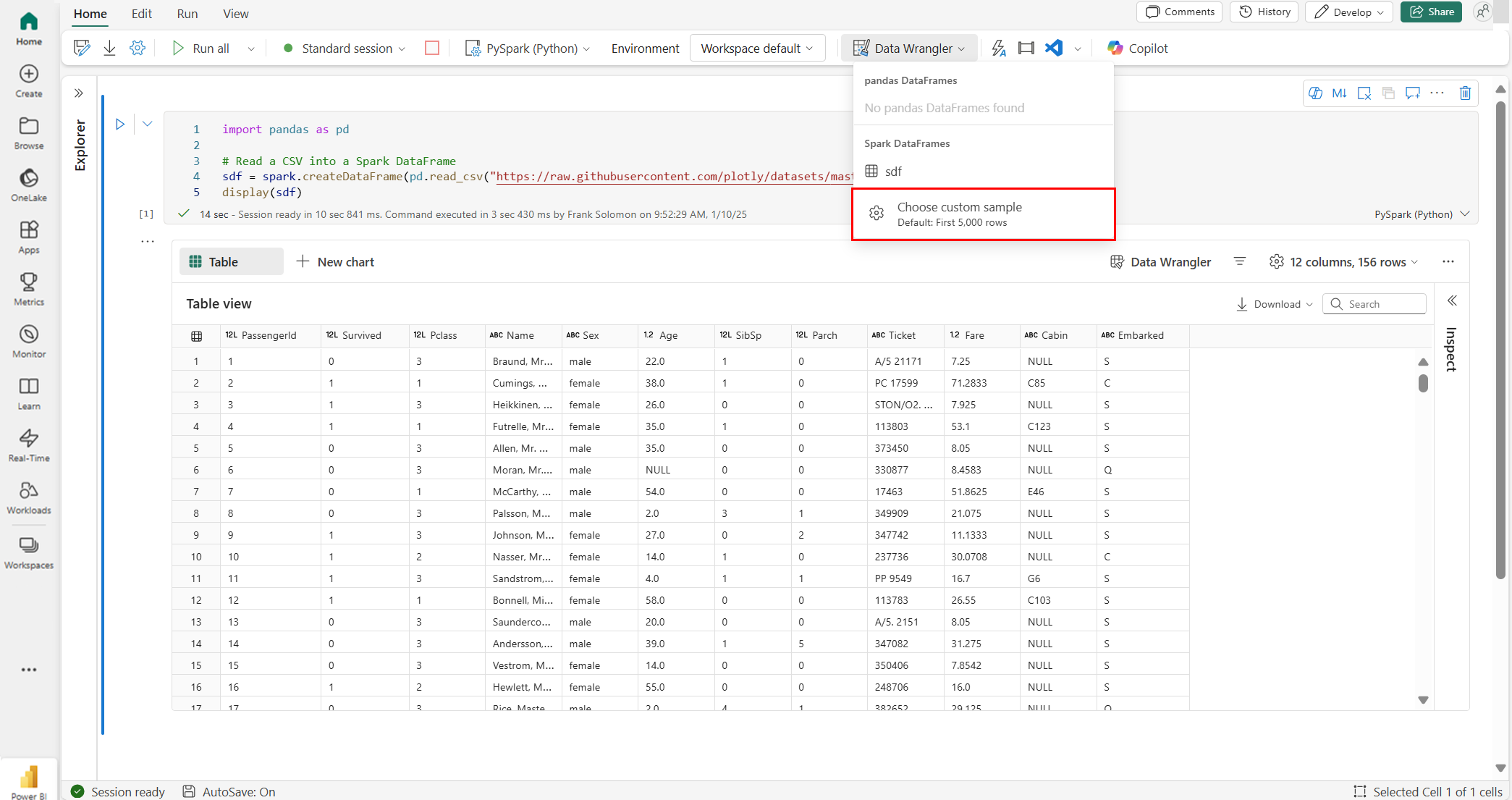

Välja anpassade exempel

Data Wrangler konverterar automatiskt Spark DataFrames till Pandas-exempel av prestandaskäl. Men all kod som verktyget genererar översätts slutligen till PySpark när den exporteras tillbaka till notebook-filen. Precis som med alla Pandas DataFrame kan du anpassa standardexemplet. Om du vill öppna ett anpassat exempel på en aktiv DataFrame med Data Wrangler väljer du "Välj anpassat exempel" i listrutan, som du ser i den här skärmbilden:

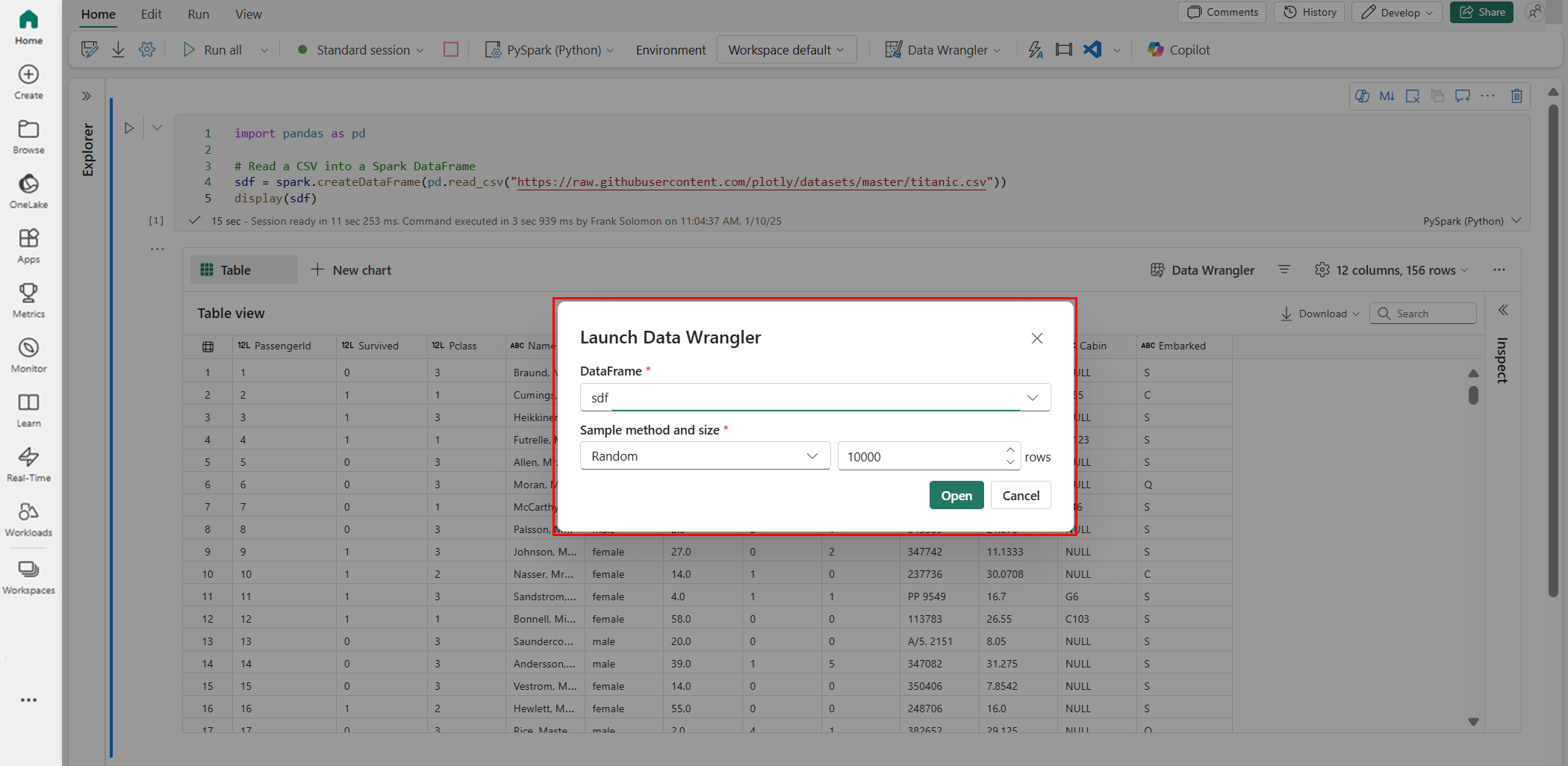

Detta startar ett popup-fönster med alternativ för att ange storleken på det önskade exemplet (antal rader) och samplingsmetoden (första poster, sista poster eller en slumpmässig uppsättning), som du ser i den här skärmbilden:

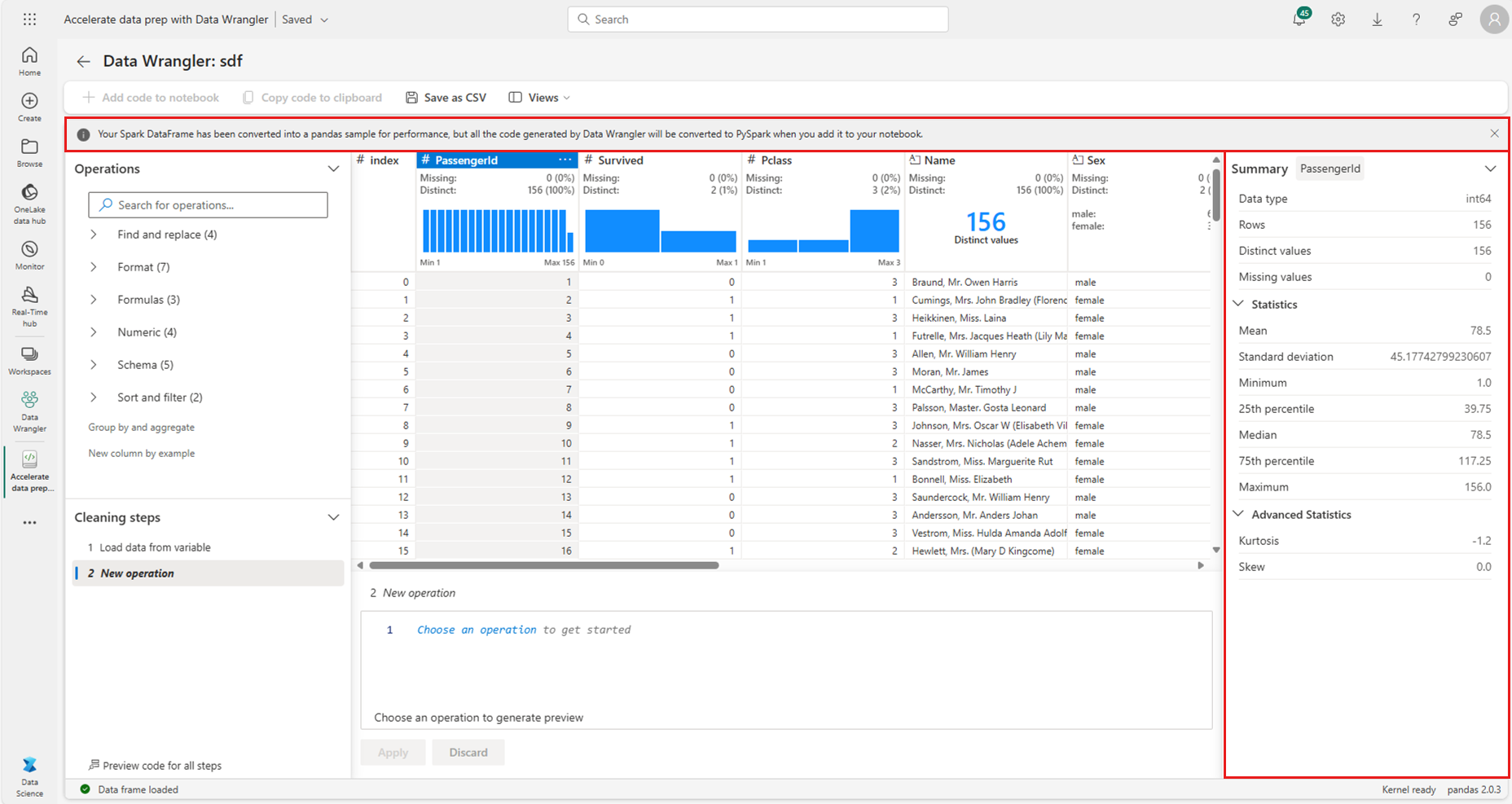

Visa sammanfattningsstatistik

När Data Wrangler läses in visas en informationsbanderoll ovanför förhandsgranskningsrutnätet. Den här banderollen förklarar att Spark DataFrames tillfälligt konverteras till Pandas-exempel, men all genererad kod konverteras slutligen till PySpark. Tidigare är det inte annorlunda att använda Data Wrangler på Spark DataFrames än att använda det på Pandas DataFrames. En beskrivande översikt på panelen Sammanfattning visar information om exemplets dimensioner, saknade värden med mera. Val av valfri kolumn i rutnätet Data Wrangler uppmanar panelen Sammanfattning att uppdatera och visa beskrivande statistik om den specifika kolumnen. Snabbinsikter om varje kolumn är också tillgängliga i rubriken.

Dricks

Kolumnspecifik statistik och visuella objekt (både i panelen Sammanfattning och i kolumnrubrikerna) beror på kolumndatatypen. Till exempel visas ett histogram med flera intervall för en numerisk kolumn endast i kolumnrubriken om kolumnen är gjuten som en numerisk typ, som du ser i den här skärmbilden:

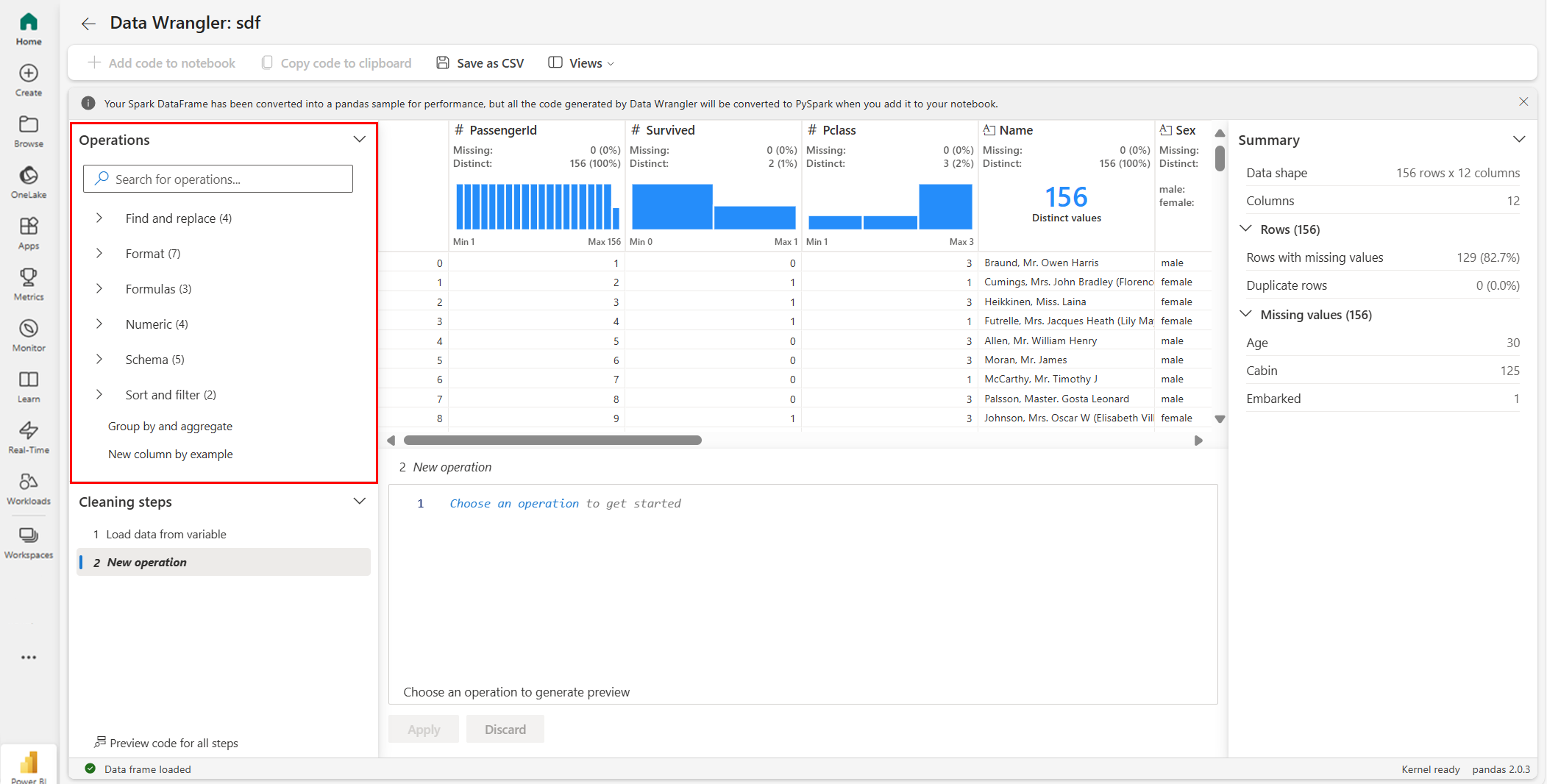

Bläddra bland datarensningsåtgärder

En sökbar lista över datarensningssteg finns på panelen "Åtgärder". I panelen "Åtgärder" uppmanar valet av ett datarensningssteg dig att ange en målkolumn eller kolumner, tillsammans med eventuella nödvändiga parametrar för att slutföra steget. Till exempel kräver uppmaningen att numeriskt skala en kolumn ett nytt värdeintervall, som du ser i den här skärmbilden:

Dricks

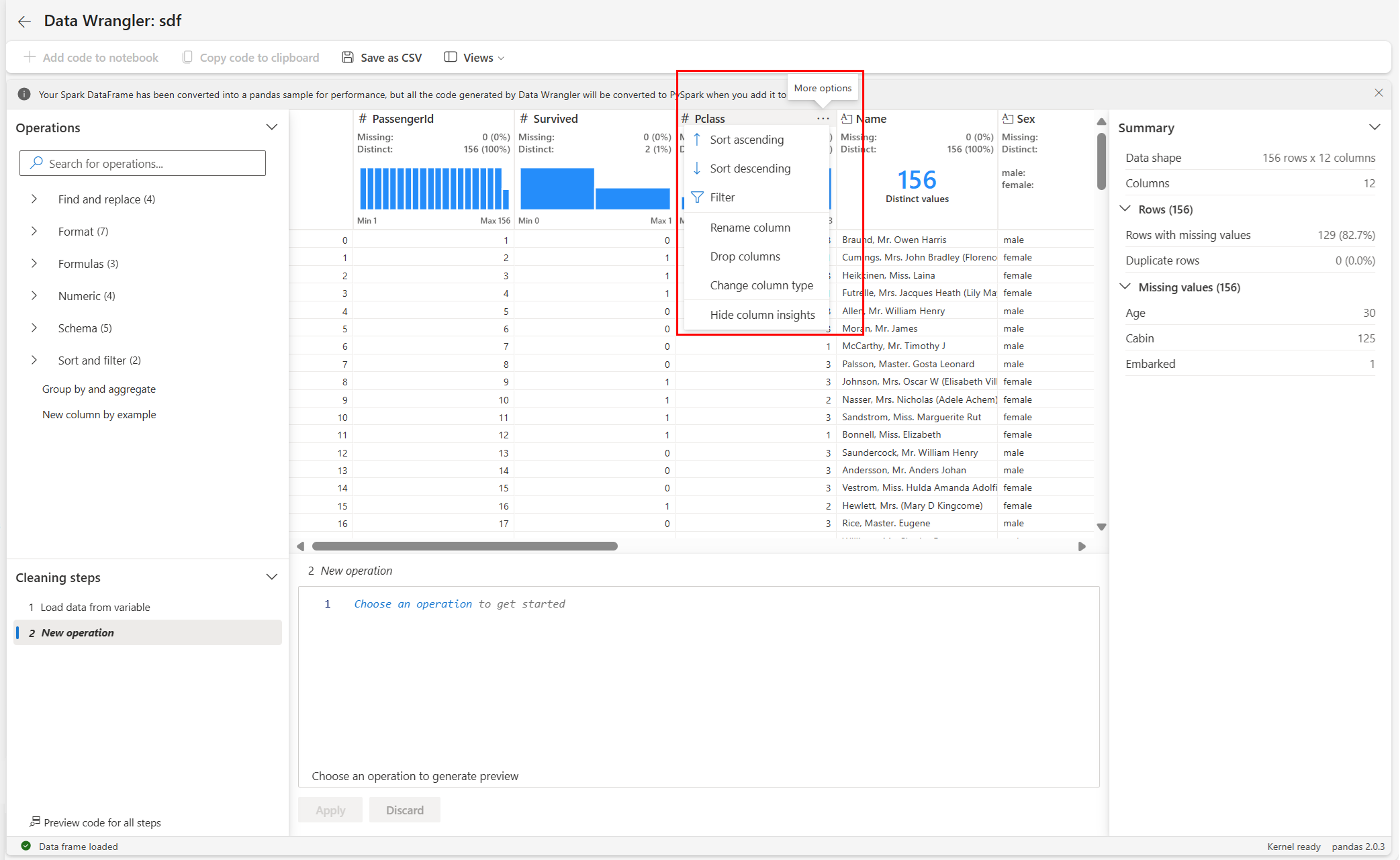

Du kan använda ett mindre urval av åtgärder från menyn i varje kolumnrubrik, som du ser i den här skärmbilden:

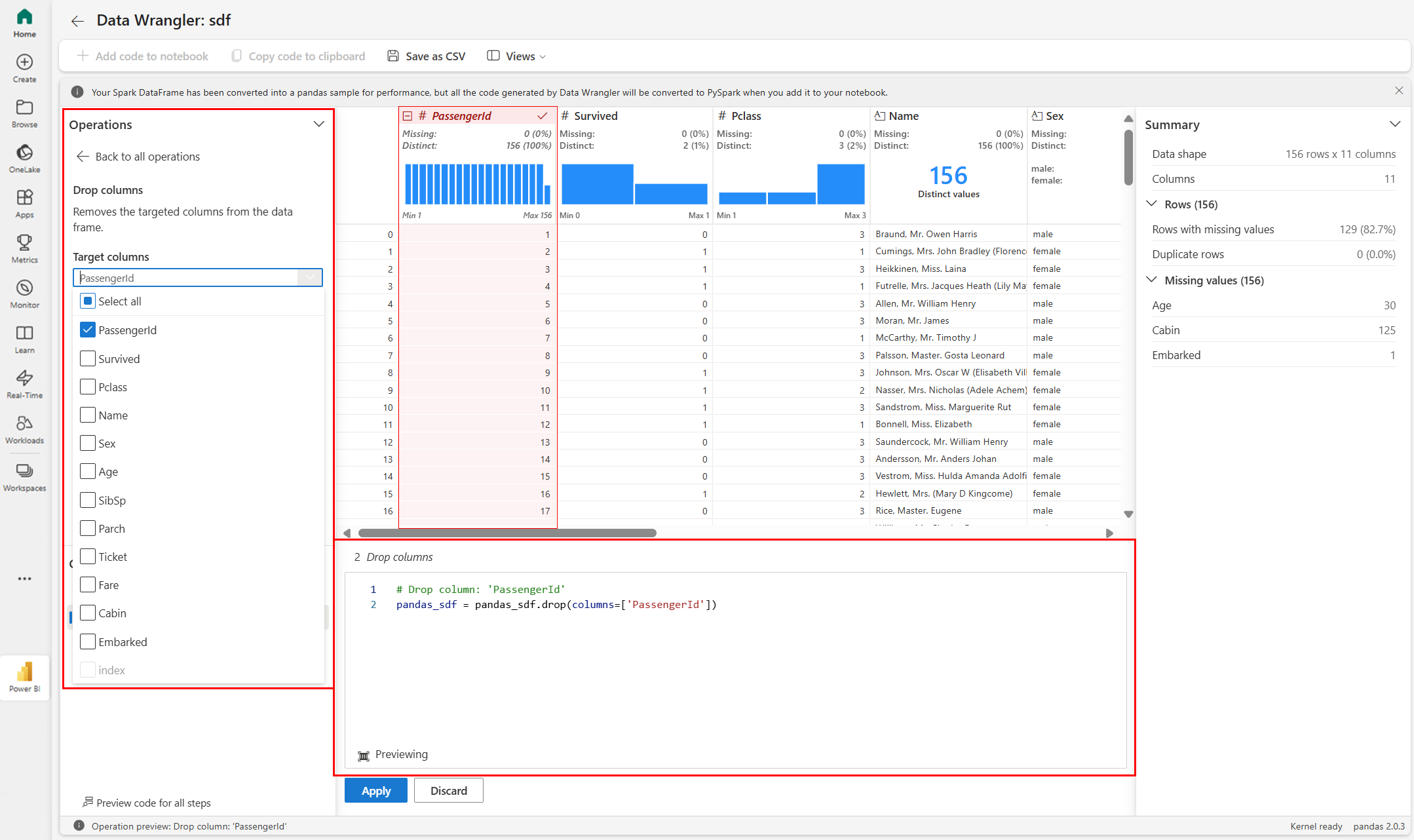

Förhandsgranska och tillämpa åtgärder

Data Wrangler-visningsrutnätet förhandsgranskar automatiskt resultatet av en vald åtgärd och motsvarande kod visas automatiskt i panelen under rutnätet. Om du vill checka in den förhandsgranskade koden väljer du "Tillämpa" på någon av platserna. Om du vill ta bort den förhandsgranskade koden och prova en ny åtgärd väljer du "Ignorera" enligt den här skärmbilden:

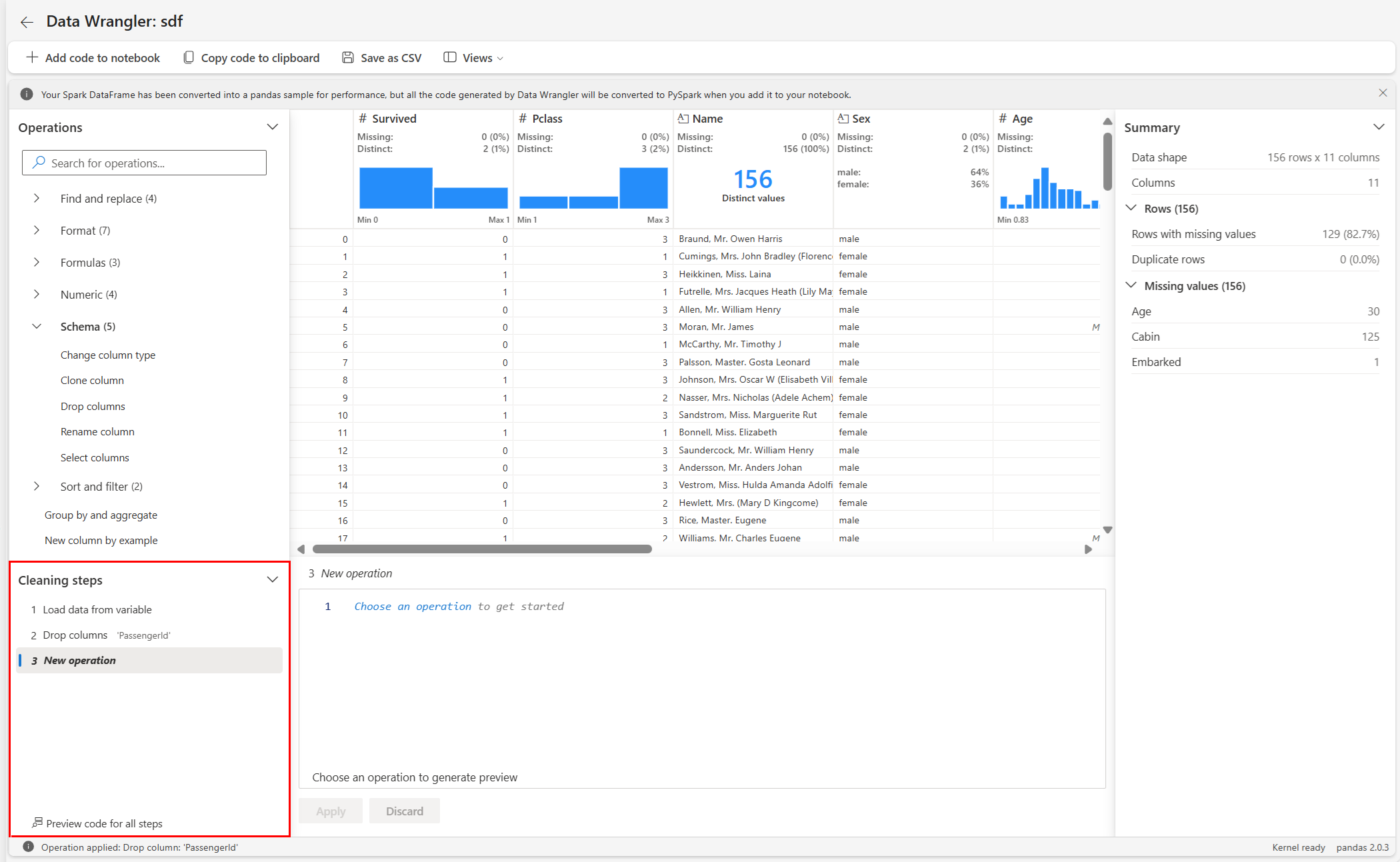

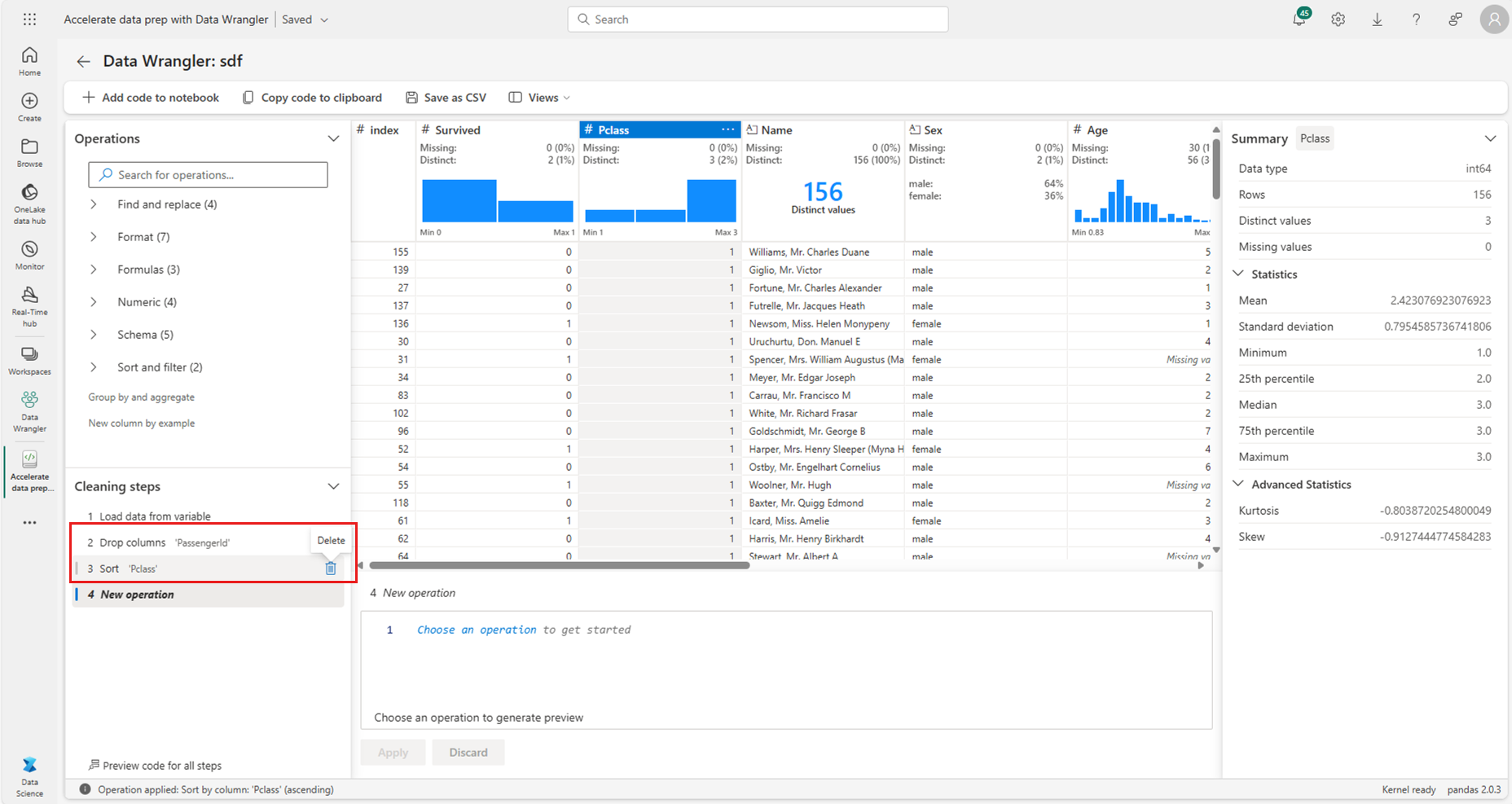

När en åtgärd har tillämpats uppdateras Data Wrangler-visningsrutnätet och sammanfattningsstatistiken för att återspegla resultatet. Koden visas i listan över åtgärder som körs, som finns i panelen "Rengöringssteg", som du ser i den här skärmbilden:

Dricks

Du kan alltid ångra det senast tillämpade steget. I panelen "Rengöringssteg" visas en papperskorgsikon om du hovra markören över det senast tillämpade steget, som du ser i den här skärmbilden:

Den här tabellen sammanfattar de åtgärder som Data Wrangler för närvarande stöder:

| Åtgärd | Beskrivning |

|---|---|

| Sortera | Sortera en kolumn i stigande eller fallande ordning |

| Filter | Filtrera rader baserat på ett eller flera villkor |

| Koda med en frekvent kodning | Skapa nya kolumner för varje unikt värde i en befintlig kolumn, vilket anger förekomsten eller frånvaron av dessa värden per rad |

| En frekvent kodning med avgränsare | Dela upp och koda kategoriska data med en avgränsare |

| Ändra kolumntyp | Ändra datatypen för en kolumn |

| Ta bort kolumn | Ta bort en eller flera kolumner |

| Välj kolumn | Välj en eller flera kolumner att behålla och ta bort resten |

| Byt namn på kolumn | Byt namn på en kolumn |

| Ta bort saknade värden | Ta bort rader med saknade värden |

| Ta bort dubblettrader | Släpp alla rader som har duplicerade värden i en eller flera kolumner |

| Fyll saknade värden | Ersätt celler med saknade värden med ett nytt värde |

| Hitta och ersätt | Ersätt celler med ett exakt matchande mönster |

| Gruppera efter kolumn och aggregering | Gruppera efter kolumnvärden och aggregera resultat |

| Ta bort tomt utrymme | Ta bort blanksteg från början och slutet av texten |

| Dela upp text | Dela upp en kolumn i flera kolumner baserat på en användardefinierad avgränsare |

| Konvertera text till gemener | Konvertera text till gemener |

| Konvertera text till versaler | Konvertera text till VERSALER |

| Skala min/max-värden | Skala en numerisk kolumn mellan ett lägsta och högsta värde |

| Flash-fyllning | Skapa automatiskt en ny kolumn baserat på exempel som härletts från en befintlig kolumn |

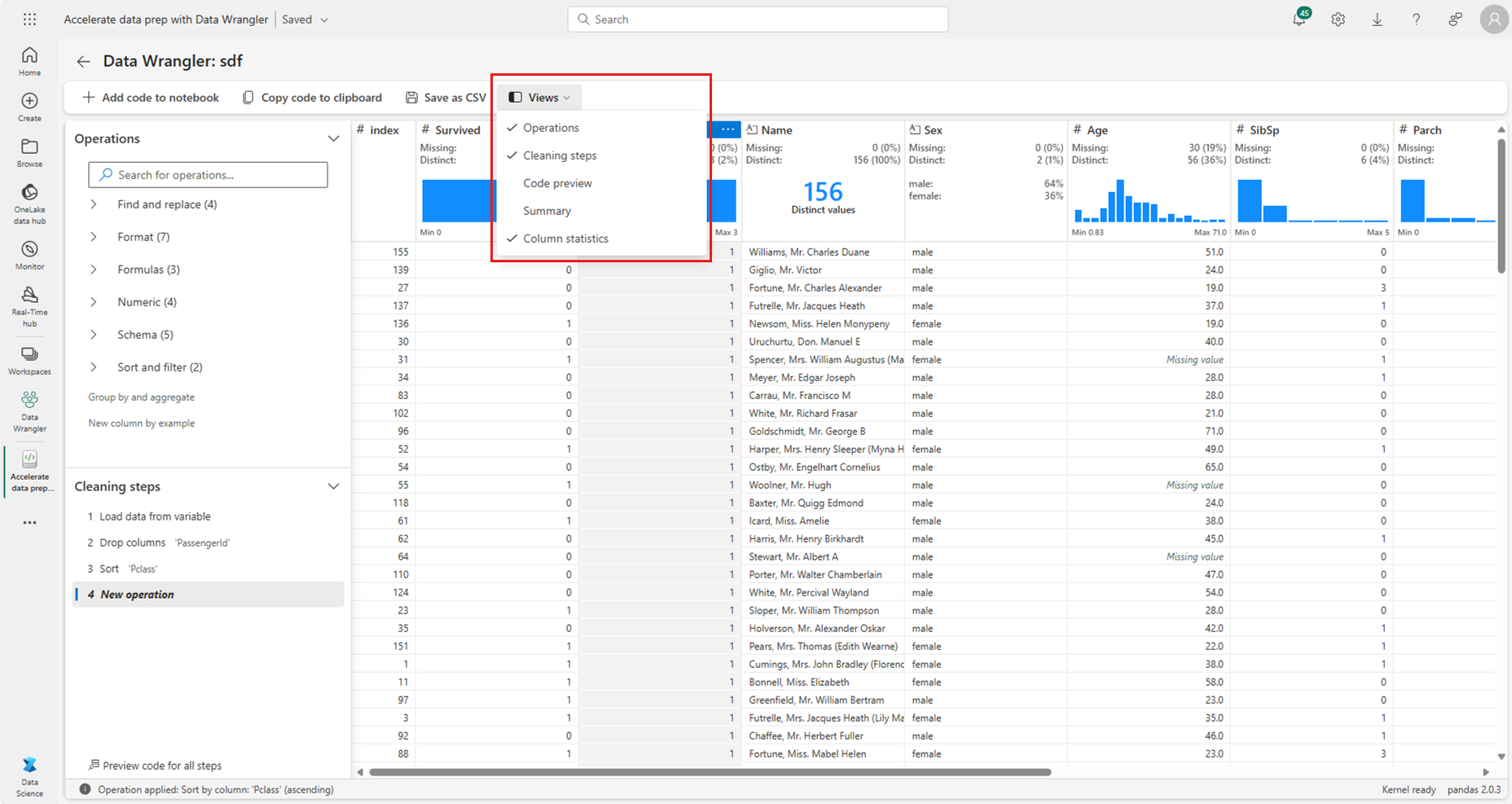

Ändra bildskärmen

När som helst kan du anpassa gränssnittet med fliken Vyer i verktygsfältet ovanför visningsrutnätet för Data Wrangler. Detta kan dölja eller visa olika fönster baserat på dina inställningar och skärmstorlek, som du ser i den här skärmbilden:

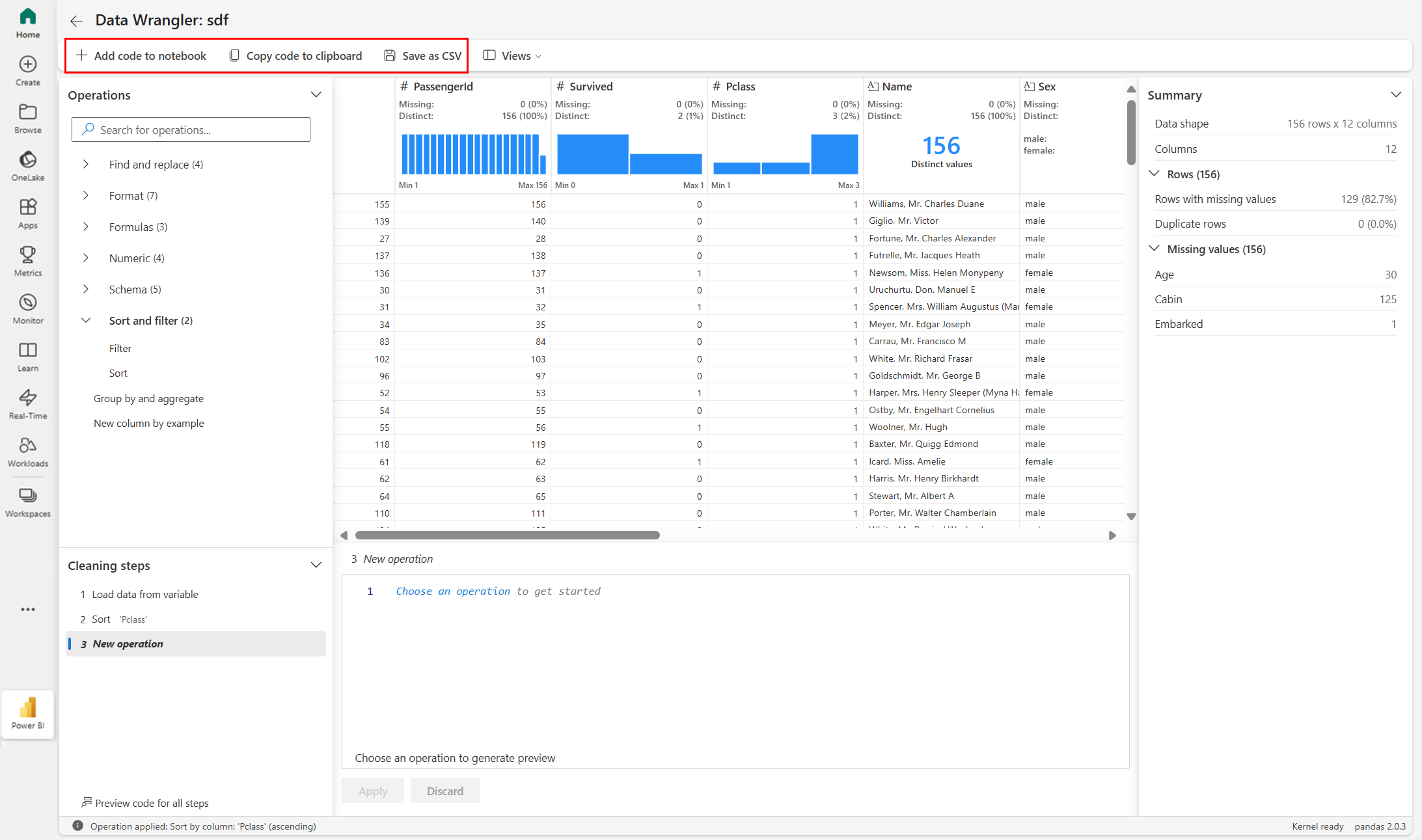

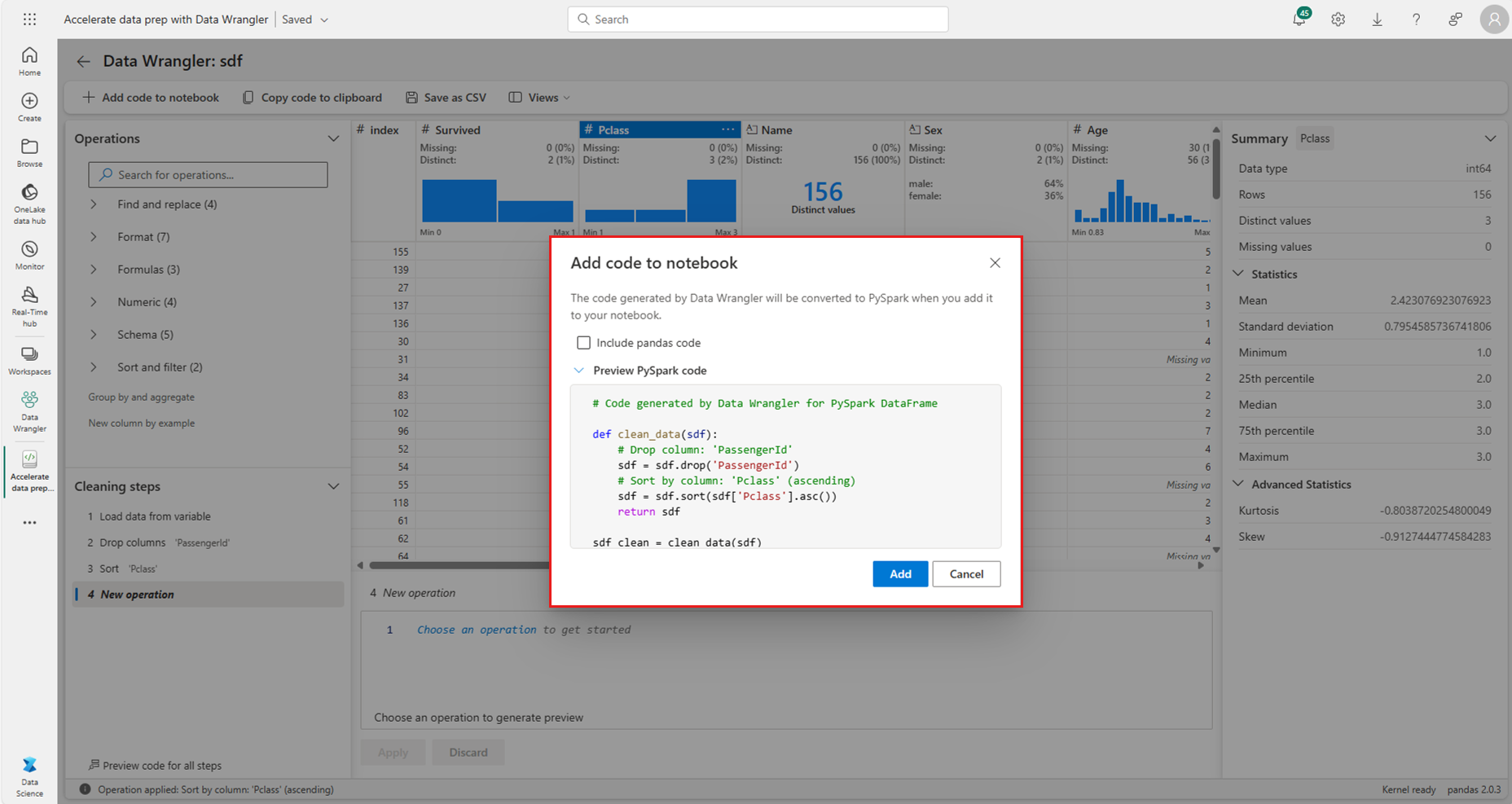

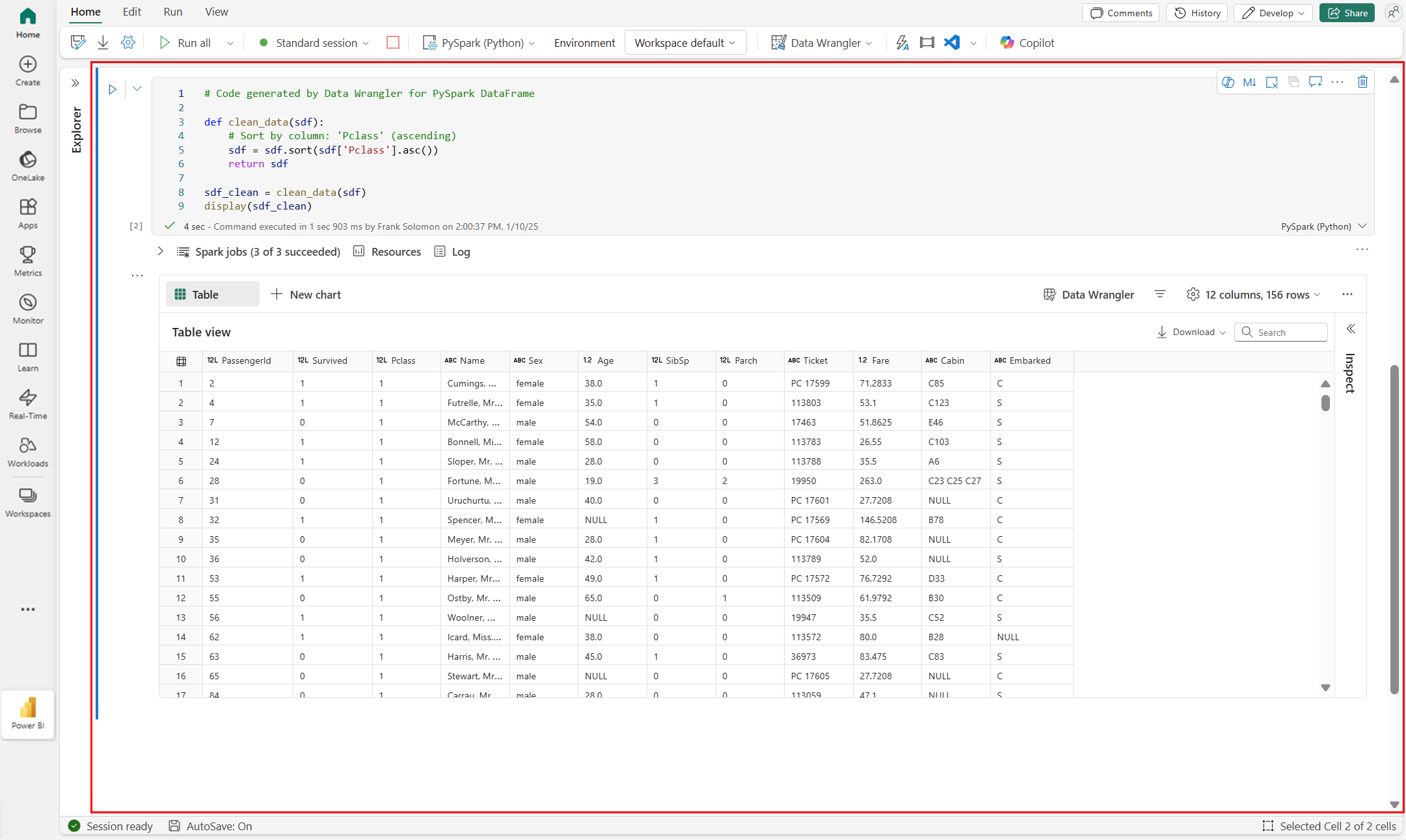

Spara och exportera kod

Verktygsfältet ovanför visningsrutnätet för Data Wrangler innehåller alternativ för att spara den genererade koden. Du kan kopiera koden till Urklipp eller exportera den till notebook-filen som en funktion. För Spark DataFrames översätts all kod som genereras i Pandas-exemplet till PySpark innan den hamnar i notebook-filen igen. Innan Data Wrangler stängs visar verktyget en förhandsgranskning av den översatta PySpark-koden, och det ger ett alternativ för att exportera den mellanliggande Pandas-koden också.

Dricks

Data Wrangler genererar kod som endast tillämpas när du kör den nya cellen manuellt, och den skriver inte över din ursprungliga DataFrame, som du ser i den här skärmbilden:

Koden konverteras till PySpark, som du ser i den här skärmbilden:

Du kan sedan köra den exporterade koden, som du ser i den här skärmbilden:

Relaterat innehåll

- En översikt över Data Wrangler finns i den här kompletterande artikeln

- Om du vill testa Data Wrangler i Visual Studio Code går du till Data Wrangler i VS Code

- Missade vi en funktion som du behöver? Berätta för oss! Föreslå det på forumet för infrastrukturidéer