Vad är kopieringsjobbet (förhandsversion) i Data Factory för Microsoft Fabric

Data Factory i Fabric gör det möjligt för användare att sömlöst integrera data från över 100 inbyggda anslutningsappar – både källor och mål – via ett visuellt intuitivt gränssnitt. Aktiviteten Kopiera, som arbetar inom datapipelines, underlättar datainmatning. Under tiden stöder Dataflow Gen2 datatransformeringar och pipelines samordnar integrationsflödet.

Fördelar med kopieringsjobbet

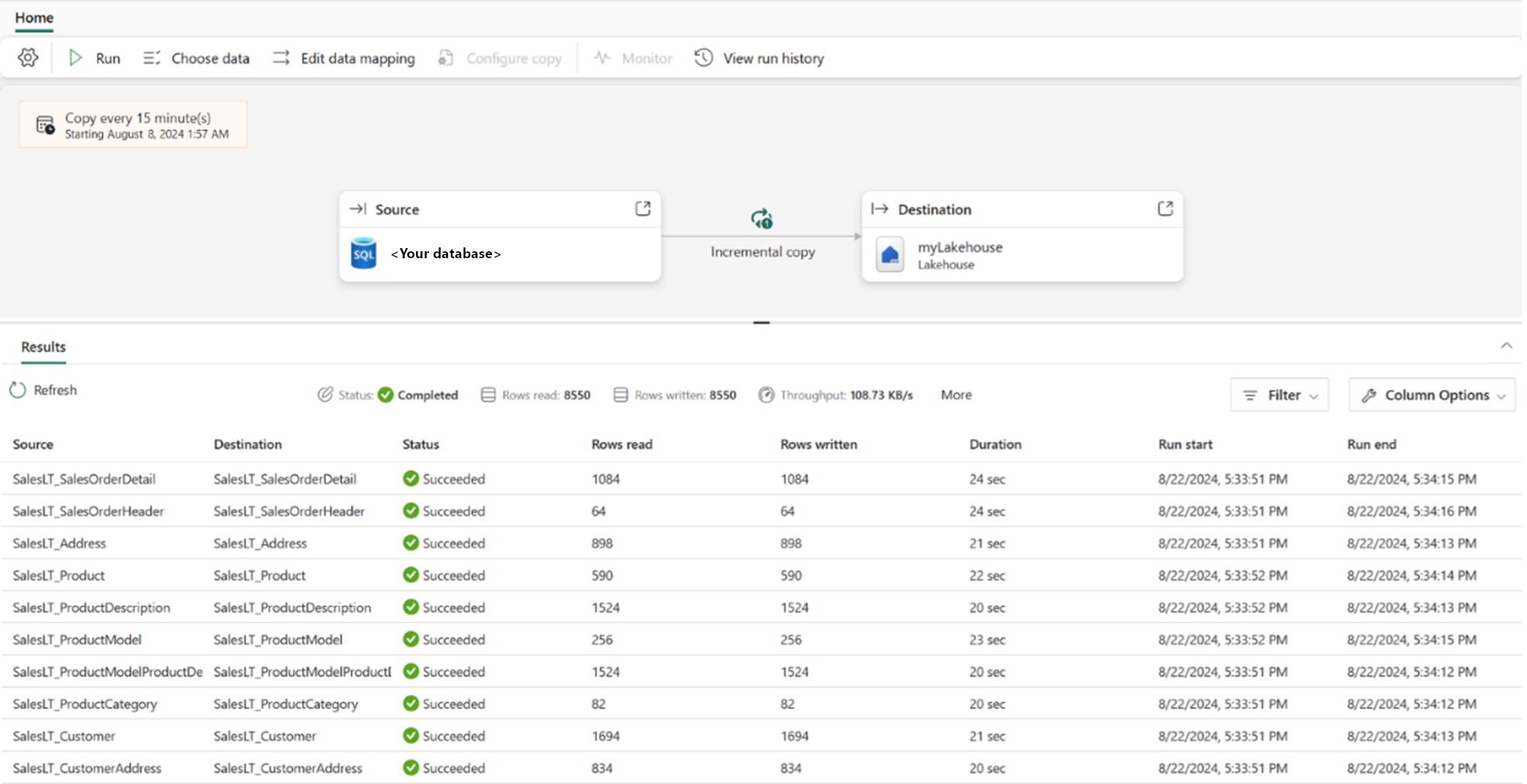

Även om aktiviteten Kopiera i datapipelines hanterar datainmatning med mass-/batchåtgärder, är det fortfarande svårt att skapa datapipelines i Data Factory för många användare som är nya i fältet, med en brantare inlärningskurva. Därför är vi glada över att kunna introducera kopieringsjobbet och höja datainmatningsupplevelsen till en mer effektiviserad och användarvänlig process från alla källor till alla mål. Nu är det enklare än någonsin att kopiera dina data. Dessutom stöder Kopieringsjobb olika dataleveransformat, inklusive både batchkopiering och inkrementell kopiering, vilket ger flexibilitet för att uppfylla dina specifika behov.

Några fördelar med kopieringsjobbet jämfört med andra dataförflyttningsmetoder är:

- Intuitiv upplevelse: Upplev sömlös datakopiering utan kompromisser, vilket gör det enklare än någonsin.

- Effektivitet: Aktivera inkrementell kopiering utan problem, vilket minskar manuella åtgärder. Den här effektiviteten innebär mindre resursanvändning och snabbare kopieringstid.

- Flexibilitet: Även om du tycker om enkelheten har du också flexibiliteten att styra din dataflytt. Välj vilka tabeller och kolumner som ska kopieras, mappa data, definiera läs-/skrivbeteende och ange scheman som passar dina behov, oavsett om det gäller en engångsaktivitet eller återkommande åtgärd.

- Robust prestanda: En serverlös installation som möjliggör dataöverföring med storskalig parallellitet, vilket maximerar dataflyttens dataflöde för systemet.

Anslutningsappar som stöds

För närvarande kan du använda kopieringsjobbet för molndataöverföring eller kopiering av data från ett lokalt datalager via gateway. Kopieringsjobbet stöder följande datalager som både källa och mål:

- Azure SQL-databas

- Lokal SQL Server

- Infrastrukturlager

- Fabric Lakehouse

- Amazon S3

- Azure Data Lake Storage Gen2

- Azure Blob Storage

- Amazon RDS för SQL Server

Produktteamet undersöker ytterligare stöd för anslutningsprogram, så håll utkik efter uppdateringar.

Kopiera beteende

Du kan välja mellan följande dataleveransformat.

- Fullständigt kopieringsläge: Varje kopieringsjobb kopierar alla data från källan till målet samtidigt.

- Inkrementellt kopieringsläge: Den första jobbkörningen kopierar alla data och efterföljande jobb kör endast ändringar sedan den senaste körningen. De ändrade data läggs till i målarkivet.

Du kan också välja hur data skrivs till målarkivet.

Som standard lägger Kopiera jobb till data till ditt mål, så att du inte missar någon ändringshistorik. Men du kan också justera skrivbeteendet till upsert eller overwrite.

- När du kopierar data till lagringsarkivet: Nya rader från tabellerna eller filerna kopieras till nya filer i målet. Om det redan finns en fil med samma namn i målarkivet skrivs den över.

- När du kopierar data till databasen: Nya rader från tabellerna eller filerna läggs till i måltabellerna. Du kan ändra skrivbeteendet till upsert (på SQL DB eller SQL Server) eller skriva över (i Fabric Lakehouse-tabeller).

Inkrementell kolumn

I inkrementellt kopieringsläge måste du välja en inkrementell kolumn för varje tabell för att identifiera ändringar. Kopieringsjobbet använder den här kolumnen som en vattenstämpel och jämför dess värde med samma värde från den senaste körningen för att endast kopiera nya eller uppdaterade data. Den inkrementella kolumnen måste vara en tidsstämpel eller en ökande INT.

Region tillgänglighet

Kopieringsjobbet har samma regionala tillgänglighet som pipelinen.

Prissättning

Kopieringsjobbet använder samma faktureringsmätare: Dataflytt, med en identisk förbrukningstakt.