Git-integrering för Spark-jobbdefinition

Den här artikeln förklarar hur Git-integrering för Spark-jobbdefinitioner (SJD) i Microsoft Fabric fungerar. Lär dig hur du konfigurerar en lagringsplatsanslutning, hanterar Definitionsändringar för Spark-jobb via källkontroll och distribuerar dem på olika arbetsytor.

Genom att aktivera Git-integrering för Spark-jobbdefinitioner i Azure DevOps kan du spåra ändringar via fullständig git-historik. Om PySpark eller SparkR har valts inkluderas huvuddefinitionsfilen och referensfilen som en del av incheckningen. Ändringarna i källkoden i dessa filer spåras också.

Viktigt!

Den här funktionen är i förhandsversion.

Konfigurera en anslutning

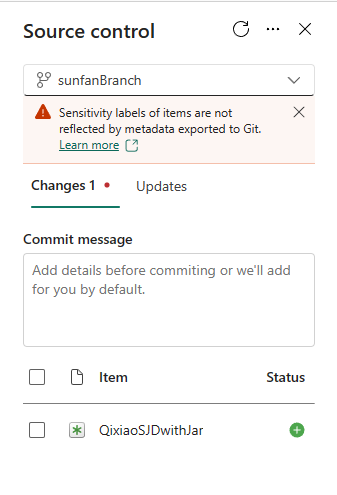

Från inställningarna för arbetsytan kan du enkelt konfigurera en anslutning till lagringsplatsen för att checka in och synkronisera ändringar. Information om hur du konfigurerar anslutningen finns i artikeln Kom igång med Git-integrering. När du är ansluten visas dina objekt, till exempel Spark-jobbdefinitioner, på kontrollpanelen Källa.

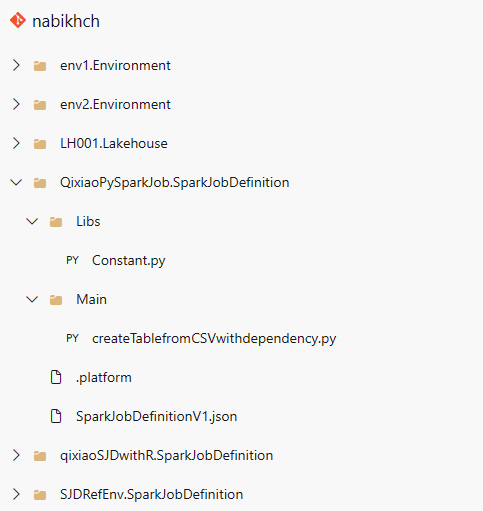

När du har checkat in Spark-jobbdefinitionen på Git-lagringsplatsen visas mappstrukturen för jobbdefinitionen på lagringsplatsen.

Representation av Spark-jobbdefinition i Git

Följande bild är ett exempel på filstrukturen för varje Spark-jobbdefinitionsobjekt på lagringsplatsen:

När du checkar in Spark-jobbdefinitionsobjektet på lagringsplatsen skapas en git-mapp för varje objekt och namnges enligt det här schemat: <Objektnamn> + "SparkJobDefinition". Byt inte namn på mappen eftersom den används för att spåra objektet på arbetsytan. Om objektnamnet till exempel är "sjd1" skulle git-mappnamnet vara "sjd1SparkJobDefinition".

Det finns två undermappar i git-mappen. De är huvud- och referensen. Huvudmappen innehåller huvuddefinitionsfilen och referensmappeninnehåller referensfilen.

Förutom huvud- och referensfilerna finns det också en SparkJobDefinitionV1.json fil. Den innehåller metadata för Spark-jobbdefinitionsobjektet, så ändra det inte. .platform-filen>bör inte heller ändras.

Kommentar

- Om du väljer Java eller Scala som språk kommer huvud- och referensfilerna inte att checkas in när de laddas upp som en .jar fil.

- Den anslutna miljön finns kvar i en Spark-jobbdefinition efter synkronisering från lagringsplatsen till en Infrastrukturarbetsyta. För närvarande stöds inte referensmiljöer för flera arbetsytor. Du måste ansluta till en ny miljö manuellt eller använda standardinställningarna för arbetsytan för att köra jobbdefinitionen.

- Spark-jobbdefinitionen behåller standard lakehouse-ID:t när du synkroniserar från lagringsplatsen till en Infrastruktur-arbetsyta. Om du checkar in en notebook-fil med standard lakehouse måste du manuellt referera till ett nyskapat lakehouse-objekt. Mer information finns i Lakehouse Git-integrering.