Microsoft Fabric-integreringsvägar för ISV:er

Microsoft Fabric erbjuder tre olika vägar för oberoende programvaruleverantörer (ISV:er) för sömlös integrering med Fabric. För en ISV som börjar på den här resan vill vi gå igenom olika resurser som vi har tillgängliga under var och en av dessa vägar.

Interop med Fabric OneLake

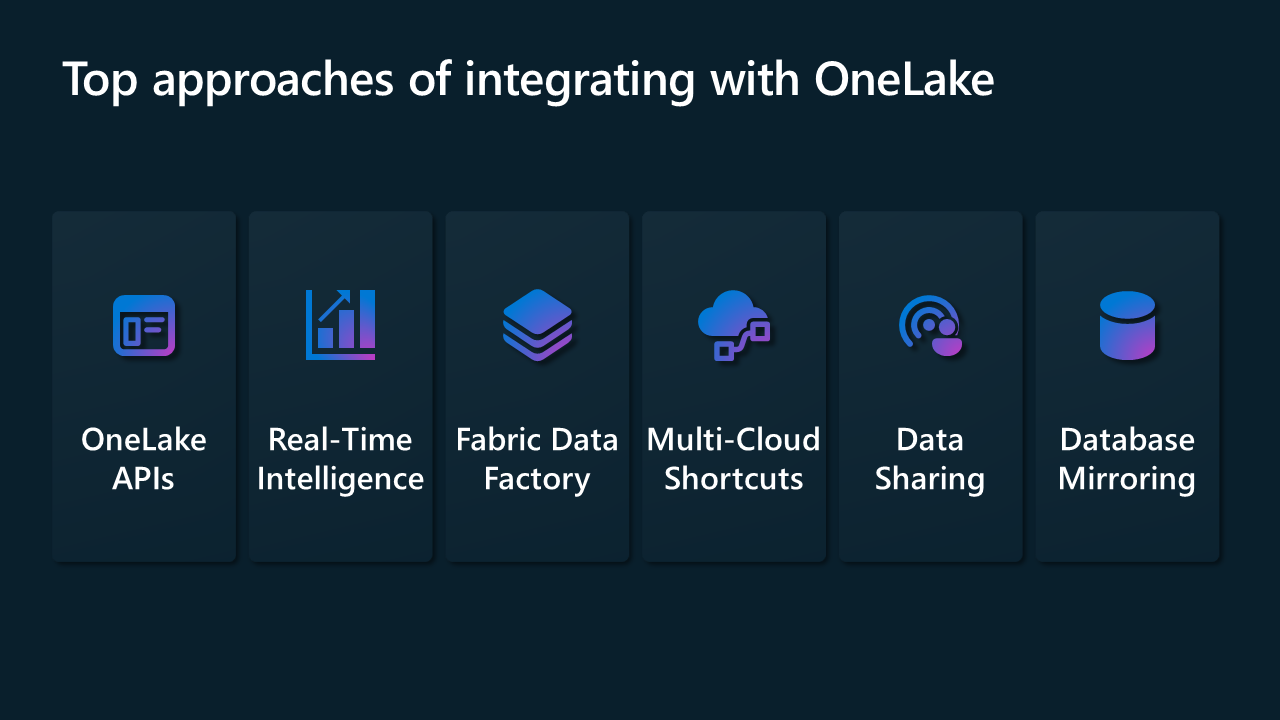

Det primära fokuset med Interop-modellen är att göra det möjligt för ISV:er att integrera sina lösningar med OneLake Foundation. Till Interop med Microsoft Fabric tillhandahåller vi integrering med hjälp av en mängd olika anslutningsappar i Data Factory och i Realtidsinformation, REST-API:er för OneLake, genvägar i OneLake, datadelning mellan Fabric-klienter och databasspegling.

I följande avsnitt beskrivs några av de sätt som du kan komma igång med den här modellen på.

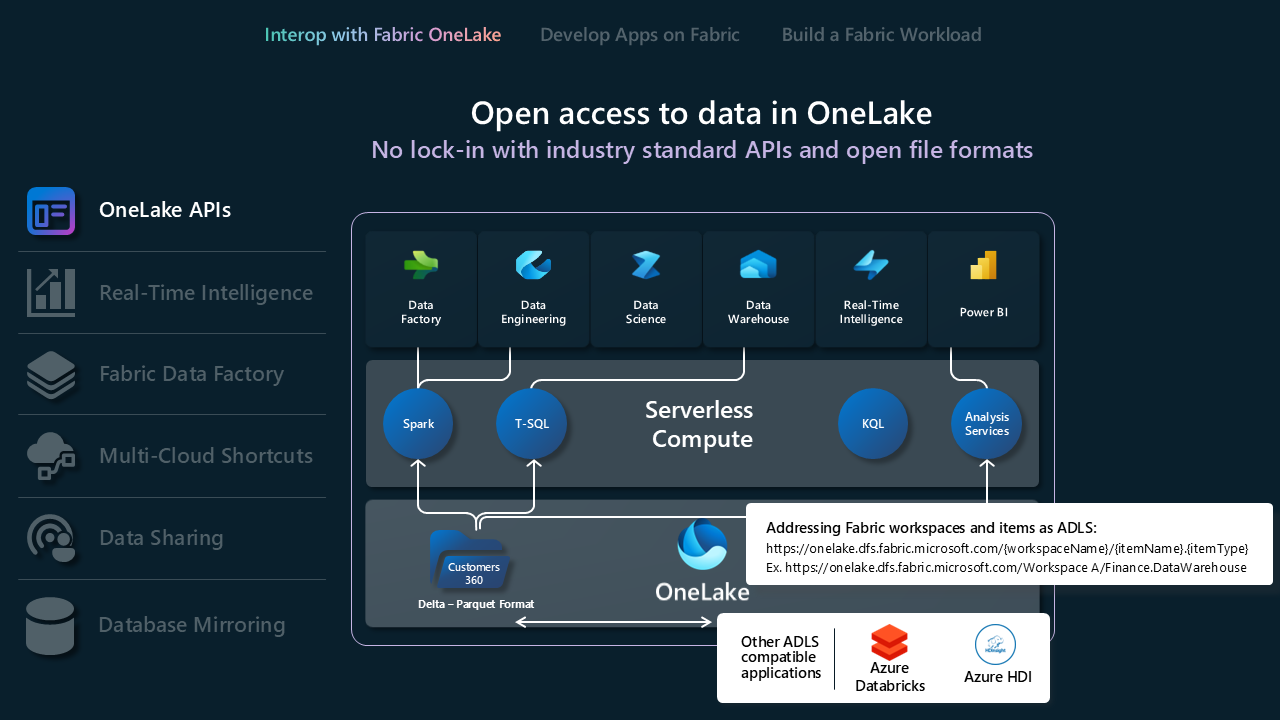

OneLake-API:er

- OneLake stöder befintliga Api:er och SDK:er för Azure Data Lake Storage (ADLS) Gen2 för direkt interaktion, så att utvecklare kan läsa, skriva och hantera sina data i OneLake. Läs mer om REST API:er för ADLS Gen2 och hur du ansluter till OneLake.

- Eftersom inte alla funktioner i ADLS Gen2 mappar direkt till OneLake, framtvingar OneLake också en uppsättning mappstruktur för att stödja Infrastrukturarbetsytor och objekt. En fullständig lista över olika beteenden mellan OneLake och ADLS Gen2 när du anropar dessa API:er finns i OneLake API-paritet.

- Om du använder Databricks och vill ansluta till Microsoft Fabric fungerar Databricks med ADLS Gen2-API:er. Integrera OneLake med Azure Databricks.

- Om du vill dra full nytta av vad Delta Lake-lagringsformatet kan göra åt dig kan du granska och förstå formatet, tabelloptimeringen och V-Order. Delta Lake-tabelloptimering och V-Order.

- När data är i OneLake kan du utforska lokalt med hjälp av OneLake Utforskaren. OneLake-utforskaren integrerar sömlöst OneLake med Windows Utforskaren. Det här programmet synkroniserar automatiskt alla OneLake-objekt som du har åtkomst till i Windows Utforskaren. Du kan också använda andra verktyg som är kompatibla med ADLS Gen2 som Azure Storage Explorer.

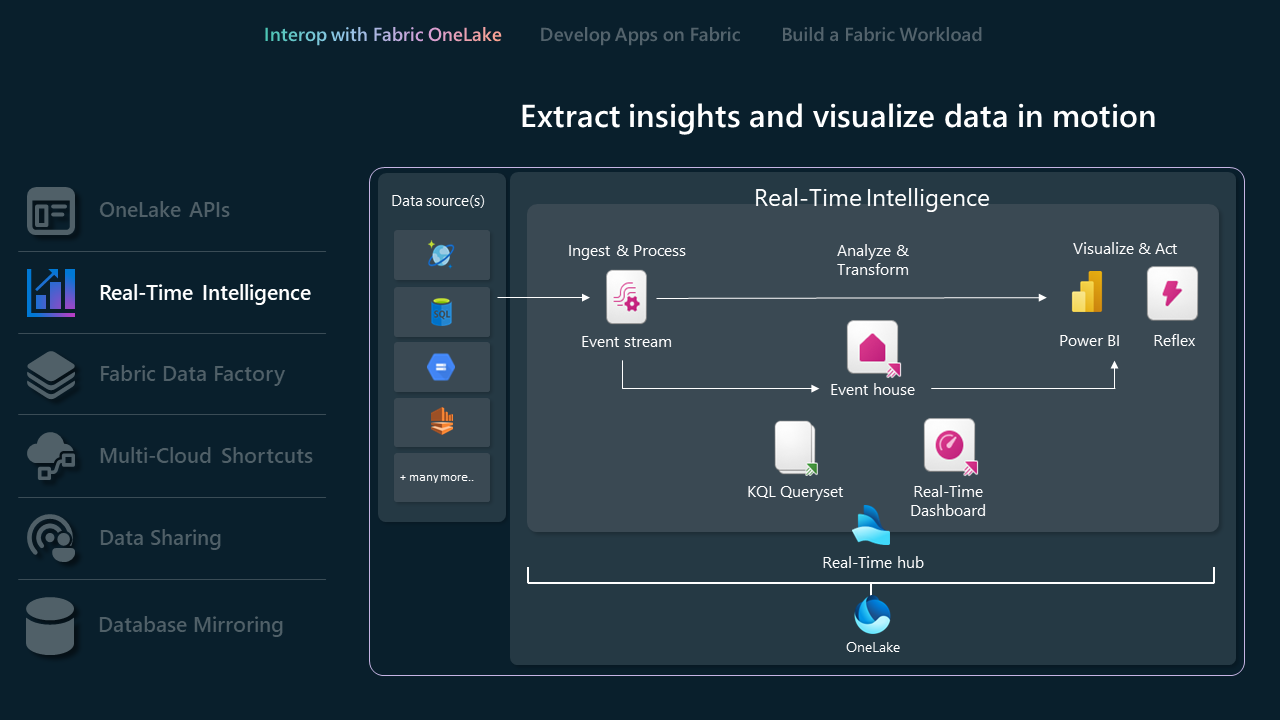

API:er för realtidsinformation

Realtidsinformation effektiviserar dataanalys och visualisering och erbjuder en centraliserad lösning för omedelbara insikter och åtgärder för data i rörelse inom en organisation. Den hanterar effektivt stora mängder data genom robusta fråge-, transformerings- och lagringsfunktioner.

- Eventhouses är särskilt utformade för strömmande data, kompatibla med realtidshubben och idealiska för tidsbaserade händelser. Data indexeras och partitioneras automatiskt baserat på inmatningstid, vilket ger dig otroligt snabba och komplexa analysfrågor på data med hög kornighet som kan nås i OneLake för användning i Fabrics upplevelsepaket. Eventhouses stöder befintliga Eventhouse-API:er och SDK:er för direkt interaktion, så att utvecklare kan läsa, skriva och hantera sina data i Eventhouses. Läs mer om REST API.

- Med eventstreams kan du ta med realtidshändelser från olika källor och dirigera dem till olika destinationer, till exempel OneLake, KQL-databaser i eventhouses och Fabric Activator. Läs mer om eventstreams och eventstreams API.

- Om du använder Databricks eller Jupyter Notebooks kan du använda Kusto Python-klientbiblioteket för att arbeta med KQL-databaser i Infrastrukturresurser. Läs mer om Kusto Python SDK.

- Du kan använda befintliga Microsoft Logic Apps-, Azure Data Factory- eller Microsoft Power Automate-anslutningsappar för att interagera med dina Eventhouses- eller KQL-databaser.

- Databasgenvägar i Realtidsinformation är inbäddade referenser i ett händelsehus till en källdatabas. Källdatabasen kan antingen vara en KQL-databas i realtidsinformation eller en Azure Data Explorer-databas. Genvägar kan användas för delning av data i samma klientorganisation eller mellan klienter. Läs mer om hur du hanterar databasgenvägar med hjälp av API:et.

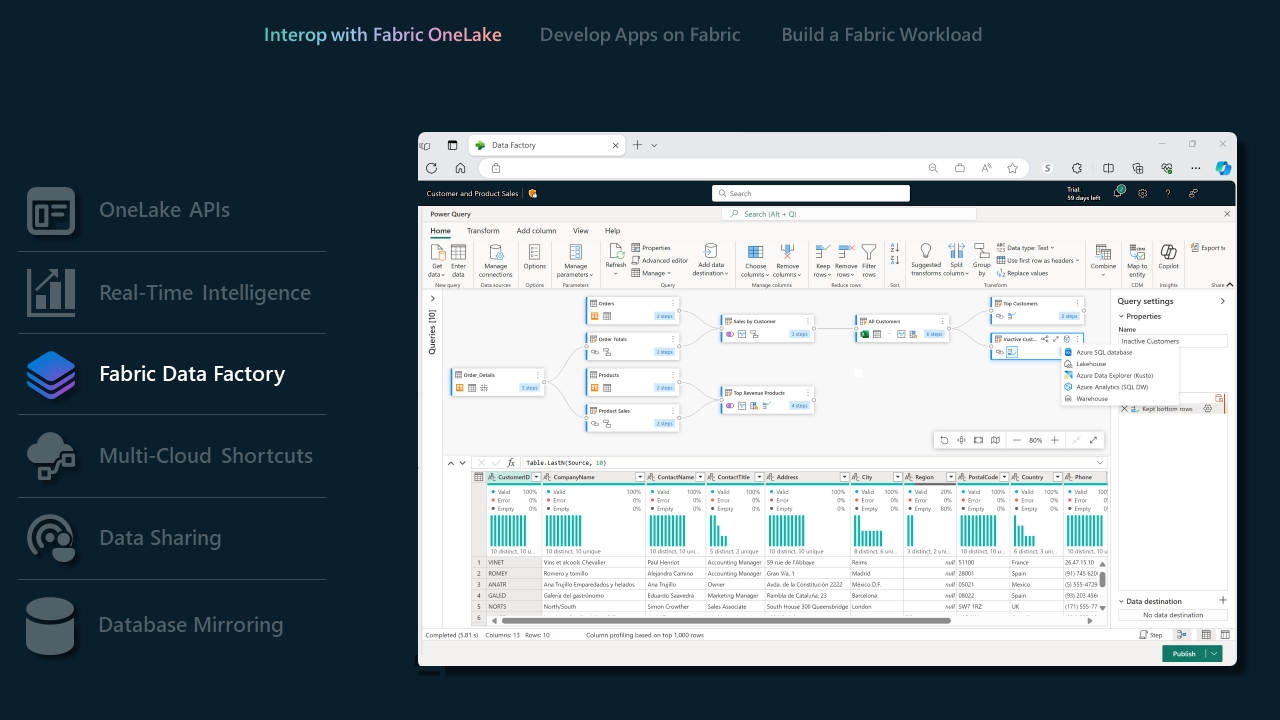

Data Factory i infrastrukturresurser

- Datapipelines har en omfattande uppsättning anslutningsappar som gör det möjligt för ISV:er att enkelt ansluta till en mängd olika datalager. Oavsett om du samverkar med traditionella databaser eller moderna molnbaserade lösningar säkerställer våra anslutningsappar en smidig integreringsprocess. Översikt över anslutningsappen.

- Med våra Dataflow Gen2-anslutningsappar som stöds kan ISV:er utnyttja kraften i Fabric Data Factory för att hantera komplexa dataarbetsflöden. Den här funktionen är särskilt fördelaktig för ISV:er som vill effektivisera databearbetnings- och transformeringsuppgifter. Dataflow Gen2-anslutningsappar i Microsoft Fabric.

- En fullständig lista över funktioner som stöds av Data Factory i Fabric checkar ut den här Data Factory i Fabric-bloggen.

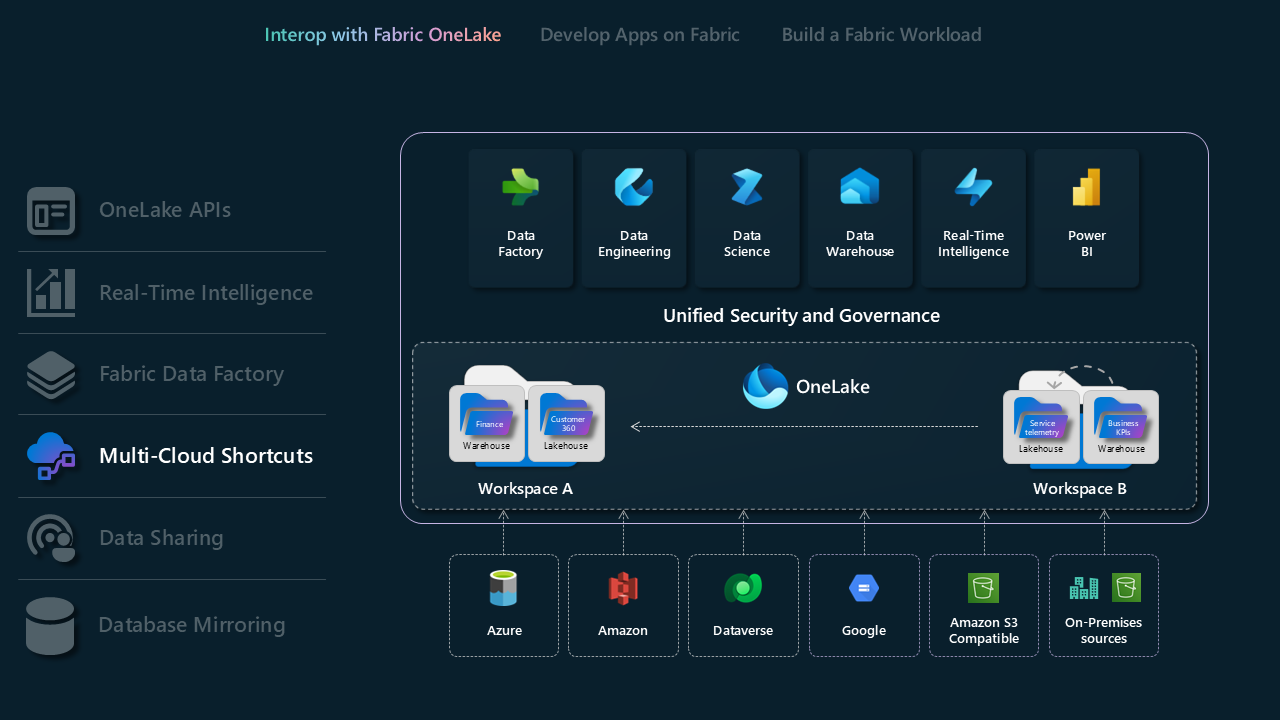

Genvägar för flera moln

Med genvägar i Microsoft OneLake kan du förena dina data mellan domäner, moln och konton genom att skapa en enda virtuell datasjö för hela företaget. Alla infrastrukturresurser och analysmotorer kan direkt peka på dina befintliga datakällor, till exempel OneLake i olika klientorganisationer, Azure Data Lake Storage (ADLS) Gen2, Amazon S3-lagringskonton, Google Cloud Storage (GCS), S3-kompatibla datakällor och Dataverse via ett enhetligt namnområde. OneLake presenterar ISV:er med en transformerande dataåtkomstlösning som sömlöst överbryggar integreringen mellan olika domäner och molnplattformar.

- Läs mer om OneLake-genvägar

- Läs mer om OneLake one logical copy

- Läs mer om genvägar för KQL-databaser

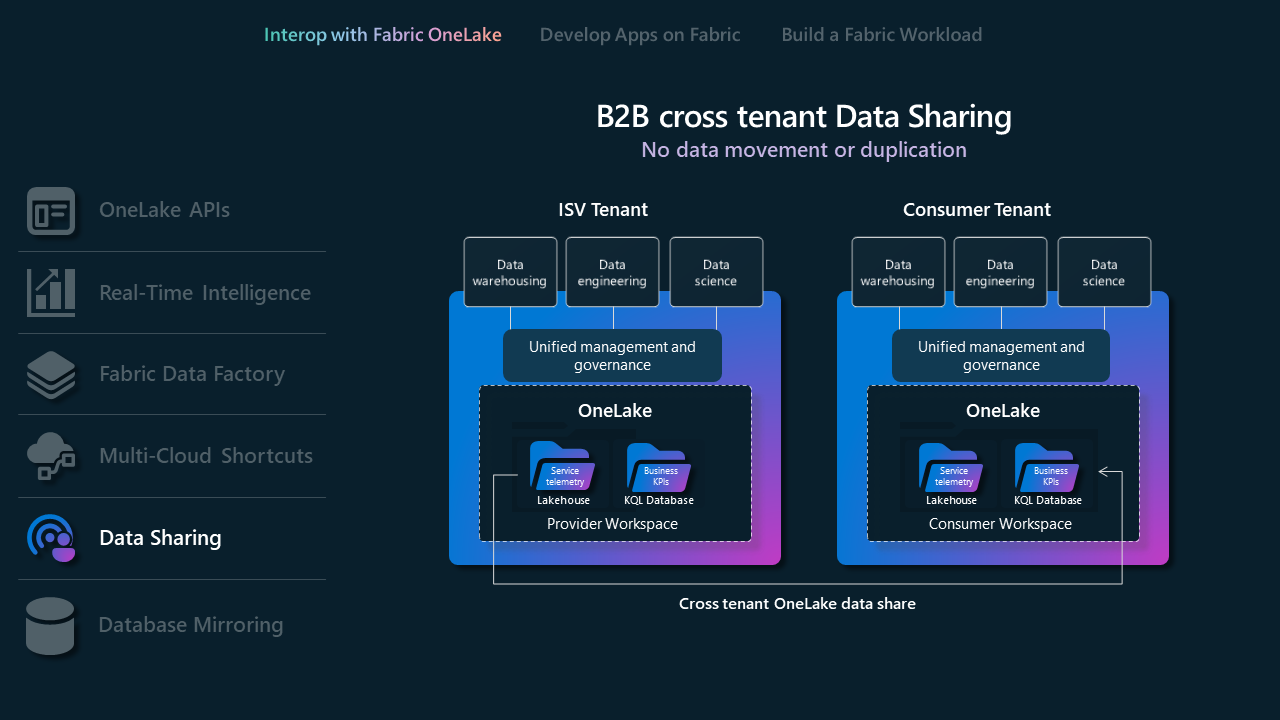

Dela data

Datadelning gör det möjligt för Fabric-användare att dela data mellan olika Fabric-klienter utan att duplicera dem. Den här funktionen förbättrar samarbetet genom att göra det möjligt att dela data "på plats" från OneLake-lagringsplatser. Data delas som skrivskyddade, tillgängliga via olika Infrastrukturberäkningsmotorer, inklusive SQL, Spark, KQL och semantiska modeller. Om du vill använda den här funktionen måste Infrastrukturadministratörer aktivera den i både delnings- och mottagarklientorganisationer. Processen omfattar att välja data i OneLake-datahubben eller arbetsytan, konfigurera delningsinställningar och skicka en inbjudan till den avsedda mottagaren.

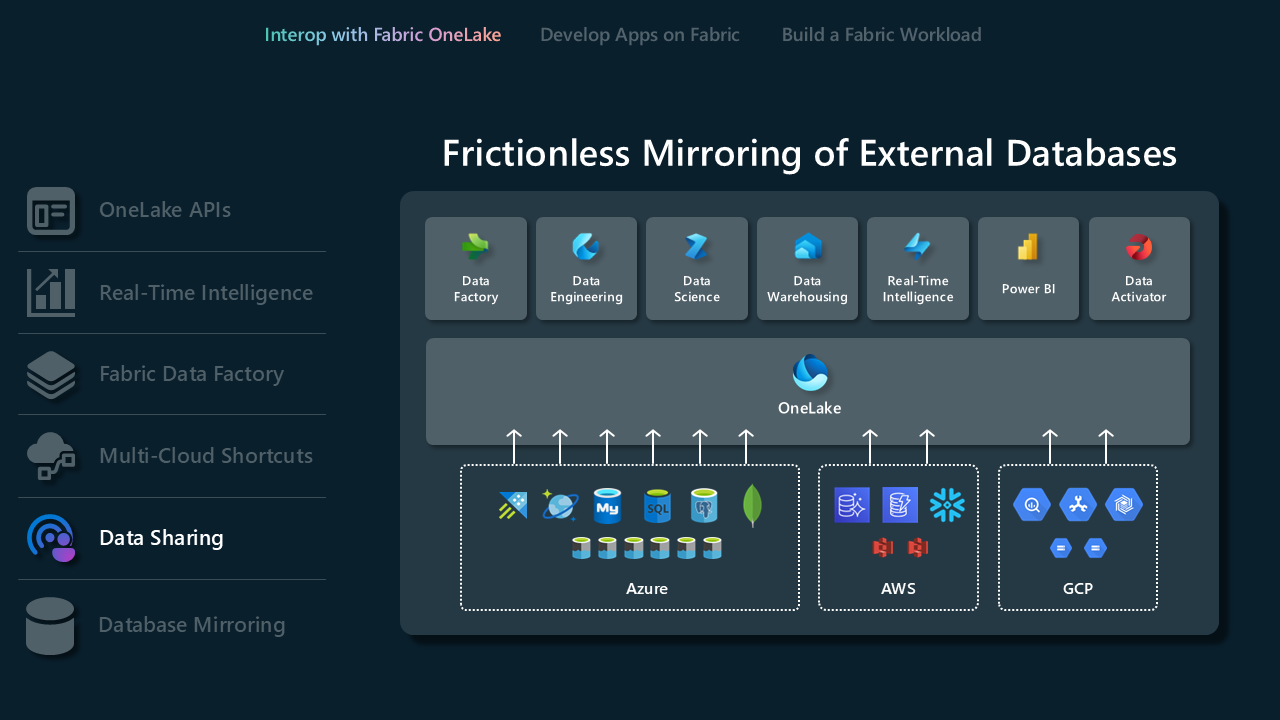

Databasspegling

Spegling ger ett modernt sätt att komma åt och mata in data kontinuerligt och sömlöst från externa databaser eller informationslager till datalagerupplevelsen i Microsoft Fabric. Spegling sker nästan i realtid och ger användarna omedelbar åtkomst till ändringar i källan. Läs mer om spegling och databaser som stöds.

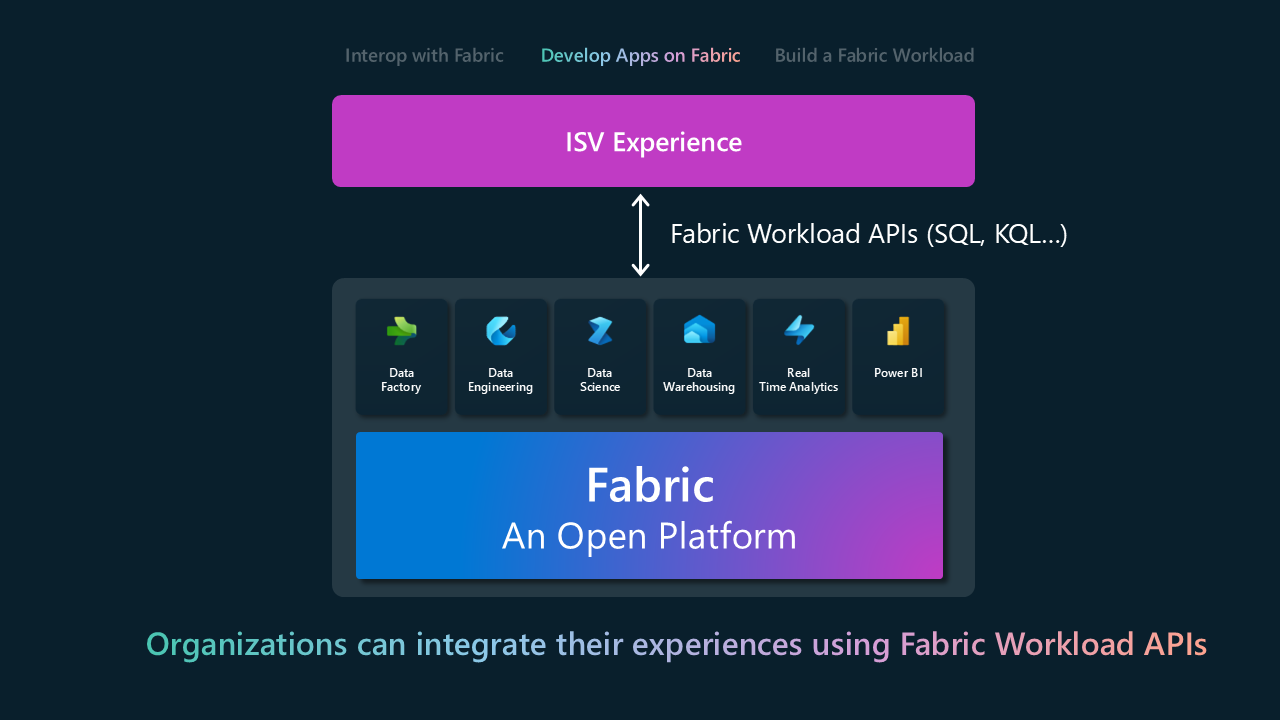

Utveckla på infrastrukturresurser

Med ISV:er för att utveckla på infrastrukturresurser kan de bygga sina produkter och tjänster ovanpå Fabric eller sömlöst bädda in Fabrics funktioner i sina befintliga program. Det är en övergång från grundläggande integrering till att aktivt tillämpa de funktioner som Fabric erbjuder. Den huvudsakliga integrationsytan är via REST-API:er för olika infrastrukturresurser. I följande tabell visas en delmängd rest-API:er grupperade efter fabric-upplevelsen. En fullständig lista finns i dokumentationen för REST API för infrastrukturresurser.

| Infrastrukturupplevelse | API |

|---|---|

| Informationslager |

-

Dist.lager - Speglat lager |

| Datateknik |

-

Sjöhus - Spark - Definition av Spark-jobb - Tabeller - Jobb |

| Data Factory |

-

DataPipeline |

| Realtidsinformation |

-

Händelsehus - KQL-databas - KQL-frågeuppsättning - Händelseström |

| Datavetenskap |

-

Notebook-fil - ML-experiment - ML-modell |

| OneLake |

-

Genväg - ADLS Gen2-API:er |

| Power BI |

-

Rapport - Instrumentpanel - Semantisk modell |

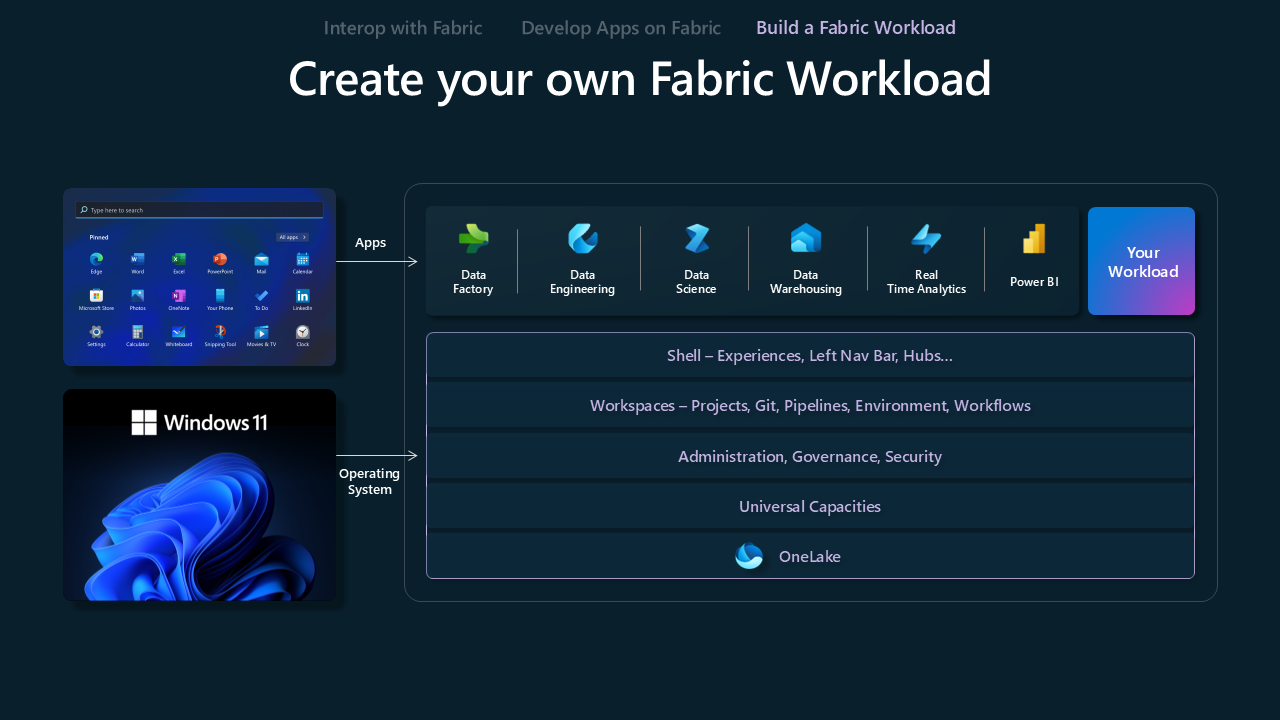

Skapa en infrastrukturarbetsbelastning

Skapa en fabric-arbetsbelastningsmodell är utformad för att ge ISV:er möjlighet att skapa anpassade upplevelser på Fabric-plattformen. Det ger ISV:er de verktyg och funktioner som krävs för att anpassa sina erbjudanden till Fabric-ekosystemet, vilket optimerar kombinationen av deras unika värdeförslag med Fabrics omfattande funktioner.

Microsoft Fabric Workload Development Kit erbjuder en omfattande verktygslåda för utvecklare för att integrera program i Microsoft Fabric-hubben. Med den här integreringen kan du lägga till nya funktioner direkt på arbetsytan Infrastruktur, vilket förbättrar användarnas analysresa. Det ger utvecklare och ISV:er en ny väg för att nå kunder, leverera både välbekanta och nya upplevelser och utnyttja befintliga dataprogram. Infrastrukturadministratörer får möjlighet att hantera åtkomst till arbetsbelastningshubben, aktivera den för hela klientorganisationen eller tilldela den med ett specifikt omfång för att kontrollera åtkomsten inom organisationen.