Översikt över virtuella datorer i HBv4-serien

Gäller för: ✔️ Virtuella Linux-datorer ✔️ med virtuella Windows-datorer ✔️ – flexibla skalningsuppsättningar ✔️ Enhetliga skalningsuppsättningar

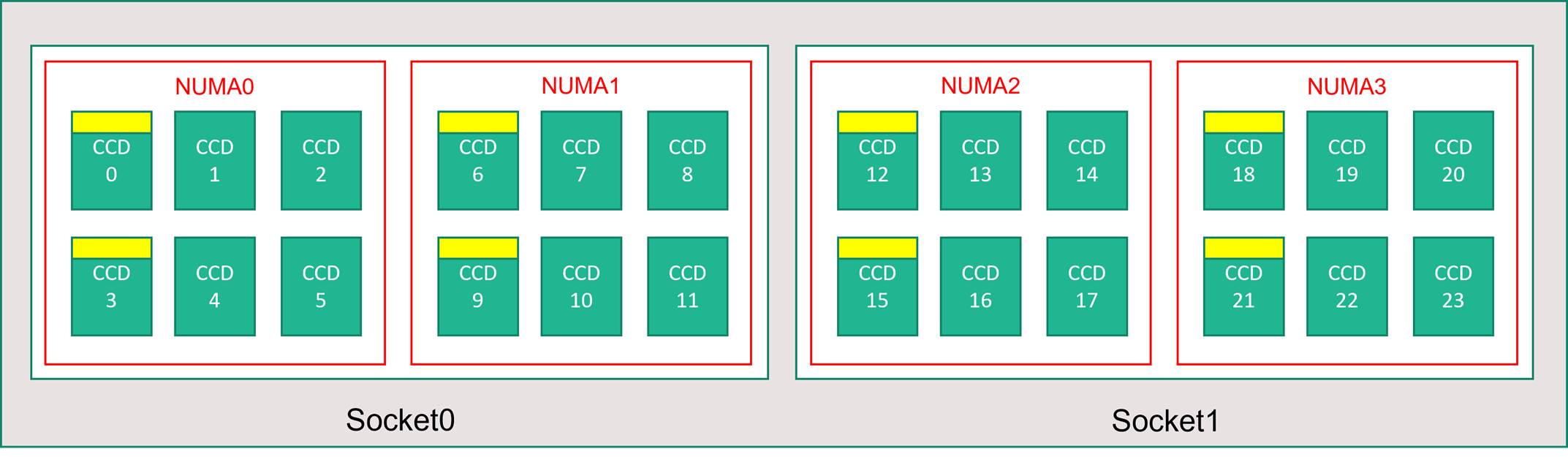

En HBv4-serieserver har 2 * 96-kärniga EPYC 9V33X-processorer för totalt 192 fysiska "Zen4"-kärnor med AMD 3D-V Cache. Samtidig multitrådning (SMT) är inaktiverat på HBv4. Dessa 192 kärnor är indelade i 24 sektioner (12 per socket), varje avsnitt som innehåller 8 processorskärnor med enhetlig åtkomst till en 96 MB L3-cache. Azure HBv4-servrar kör också följande AMD BIOS-inställningar:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

Därför startar servern med 4 NUMA-domäner (2 per socket) var 48-kärnor i storlek. Varje NUMA har direkt åtkomst till 6 kanaler med fysisk DRAM.

För att ge utrymme för Azure-hypervisor-programmet att fungera utan att störa den virtuella datorn reserverar vi 16 fysiska kärnor per server.

Topologi för virtuell dator

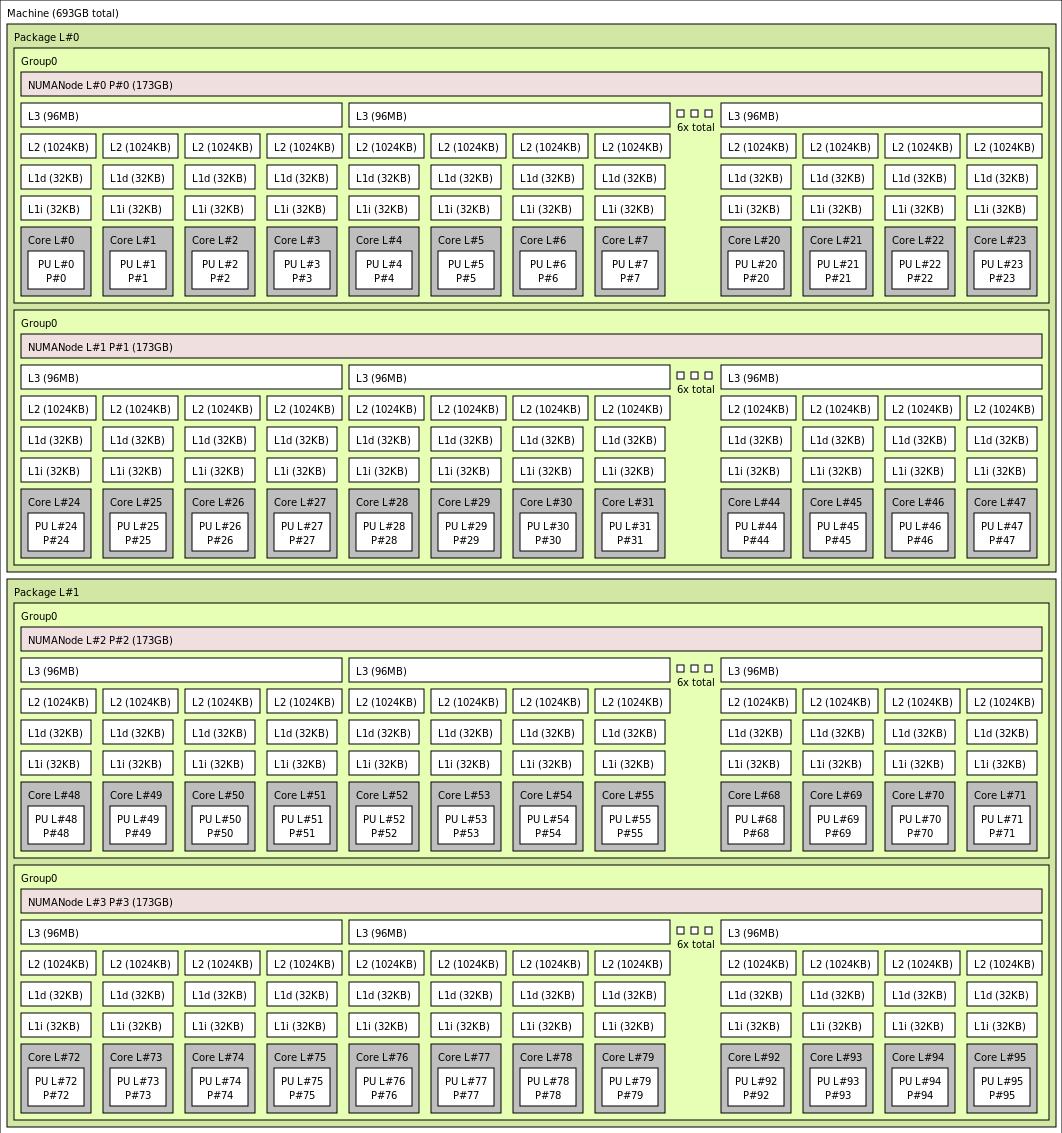

Följande diagram visar serverns topologi. Vi reserverar dessa 16 hypervisor-värdkärnor (gula) symmetriskt över båda CPU-socketarna och tar de första 2 kärnorna från specifika Core Complex Dies (CCD) i varje NUMA-domän, med de återstående kärnorna för den virtuella datorn i HBv4-serien (grön).

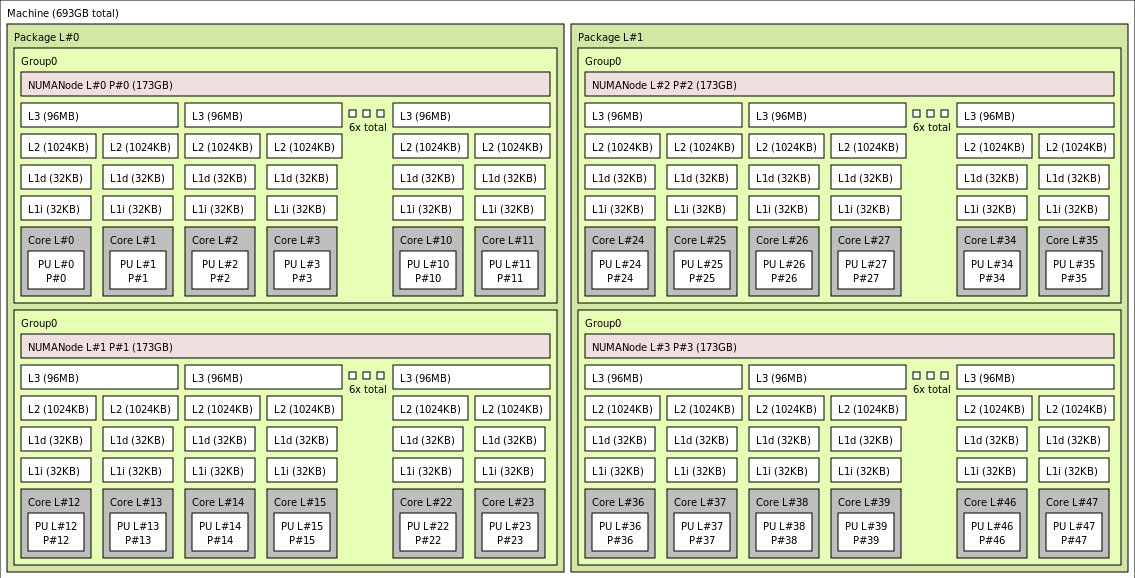

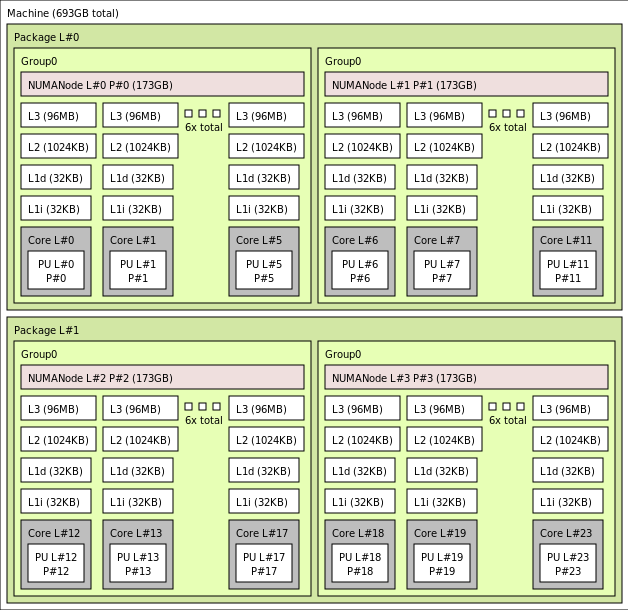

CCD-gränsen skiljer sig från en NUMA-gräns. På HBv4 konfigureras en grupp på sex (6) på varandra följande CCD:er som en NUMA-domän, både på värdservernivå och på en virtuell gästdator. Därför exponerar alla HBv4 VM-storlekar 4 enhetliga NUMA-domäner som visas för ett operativsystem och program enligt nedan, var och en med olika antal kärnor beroende på den specifika HBv4 VM-storleken.

Varje HBv4 VM-storlek liknar den fysiska layouten, funktionerna och prestandan för en annan PROCESSOR än AMD EPYC 9V33X enligt följande:

| Storlek på virtuella datorer i HBv4-serien | NUMA-domäner | Kärnor per NUMA-domän | Likhet med AMD EPYC |

|---|---|---|---|

| Standard_HB176rs_v4 | 4 | 44 | EPYC 9V33X med dubbla socketar |

| Standard_HB176-144rs_v4 | 4 | 36 | EPYC 9V33X med dubbla socketar |

| Standard_HB176-96rs_v4 | 4 | 24 | EPYC 9V33X med dubbla socketar |

| Standard_HB176-48rs_v4 | 4 | 12 | EPYC 9V33X med dubbla socketar |

| Standard_HB176-24rs_v4 | 4 | 6 | EPYC 9V33X med dubbla socketar |

Kommentar

Vm-storlekarna med begränsade kärnor minskar bara antalet fysiska kärnor som exponeras för den virtuella datorn. Alla globala delade tillgångar (RAM, minnesbandbredd, L3-cache, GMI- och xGMI-anslutning, InfiniBand, Azure Ethernet-nätverk och lokal SSD) förblir konstanta. På så sätt kan en kund välja en VM-storlek som är bäst anpassad efter en viss uppsättning arbetsbelastnings- eller programvarulicensieringsbehov.

Den virtuella NUMA-mappningen för varje HBv4 VM-storlek mappas till den underliggande fysiska NUMA-topologin. Det finns ingen potentiell missvisande abstraktion av maskinvarutopologin.

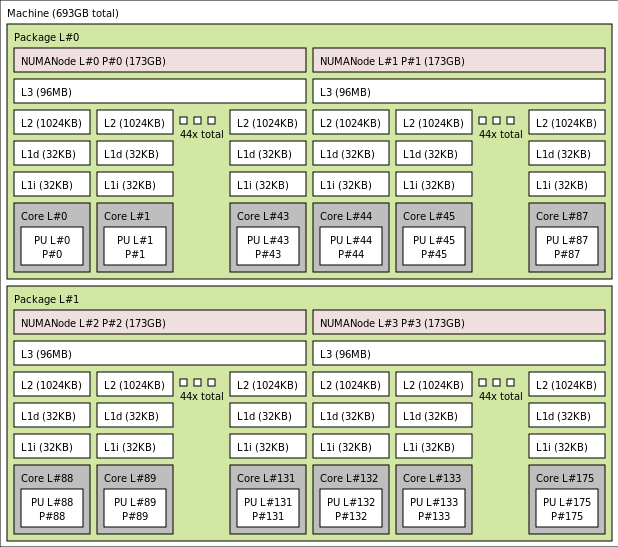

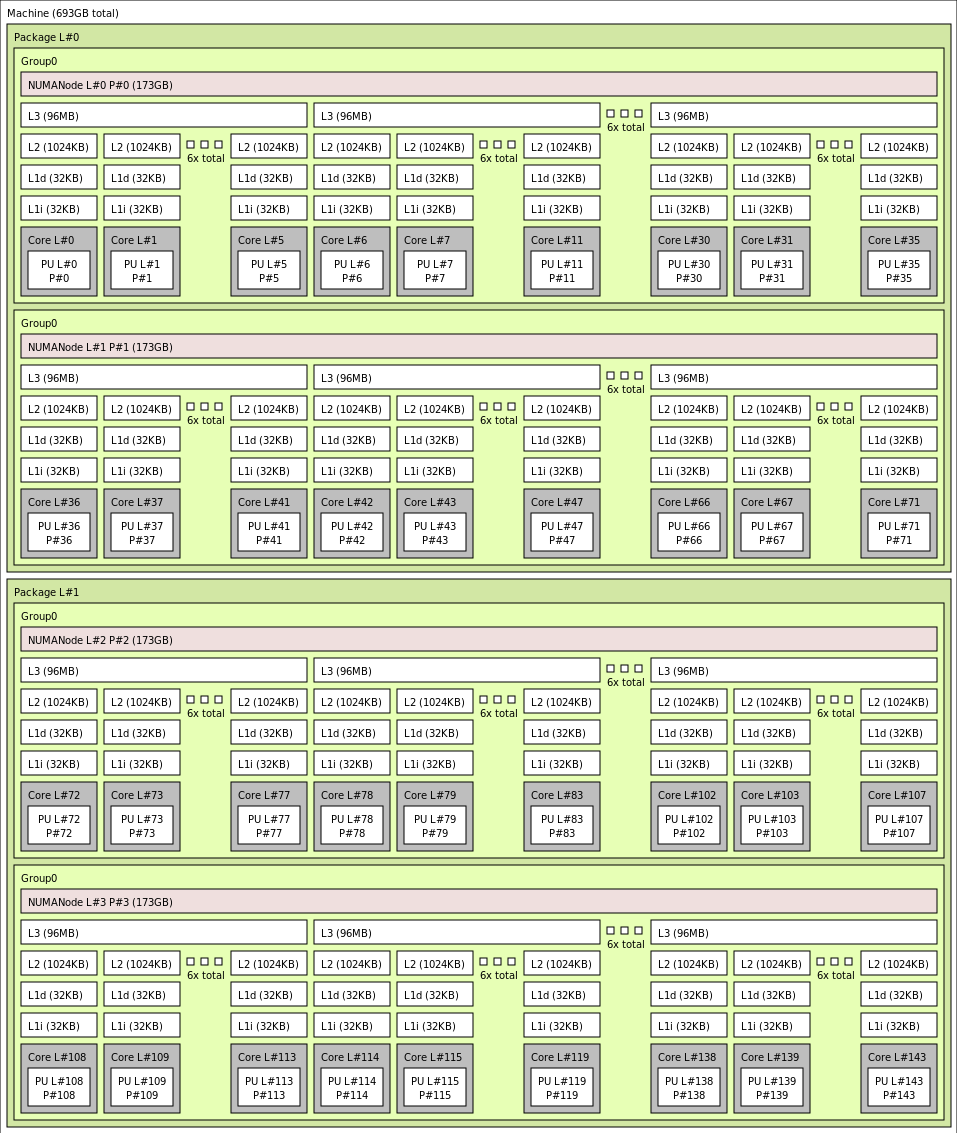

Den exakta topologin för den olika storleken på den virtuella HBv4-datorn visas på följande sätt med hjälp av utdata från lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Klicka om du vill visa lstopo-utdata för Standard_HB176rs_v4

Klicka om du vill visa lstopoutdata för Standard_HB176-144rs_v4

Klicka om du vill visa lstopoutdata för Standard_HB176-96rs_v4

Klicka om du vill visa lstopoutdata för Standard_HB176-48rs_v4

Klicka om du vill visa lstopoutdata för Standard_HB176-24rs_v4

InfiniBand-nätverk

Virtuella HBv4-datorer har även NVIDIA Mellanox NDR InfiniBand-nätverkskort (ConnectX-7) som körs i upp till 400 Gigabits per sekund. Nätverkskortet skickas till den virtuella datorn via SRIOV, vilket gör att nätverkstrafiken kan kringgå hypervisor-programmet. Därför läser kunderna in Mellanox OFED-standarddrivrutiner på virtuella HBv4-datorer på samma sätt som i en bare metal-miljö.

Virtuella HBv4-datorer stöder adaptiv routning, dynamisk ansluten transport (DCT, utöver standardtransporterna för RC och UD) och maskinvarubaserad avlastning av MPI-kollektiv till registreringsprocessorn för ConnectX-7-adaptern. Dessa funktioner förbättrar programmets prestanda, skalbarhet och konsekvens och användning av dem rekommenderas.

Tillfällig lagring

Virtuella HBv4-datorer har 3 fysiskt lokala SSD-enheter. En enhet är förformaterad för att fungera som en sidfil och den visades i den virtuella datorn som en allmän "SSD"-enhet.

Två andra, större SSD:er tillhandahålls som oformaterade block-NVMe-enheter via NVMeDirect. När block-NVMe-enheten kringgår hypervisor-programmet har den högre bandbredd, högre IOPS och lägre svarstid per IOP.

När NVMe SSD är parkopplat i en randig matris ger det upp till 12 GB/s läsningar och 7 GB/s skrivningar, och upp till 186 000 IOPS (läsningar) och 201 000 IOPS (skrivningar) för djupködjup.

Maskinvaruspecifikationer

| Maskinvaruspecifikationer | Virtuella datorer i HBv4-serien |

|---|---|

| Kärnor | 176, 144, 96, 48 eller 24 (SMT inaktiverat) |

| Processor | AMD EPYC 9V33X |

| CPU-frekvens (icke-AVX) | 2,4 GHz bas, 3,7 GHz toppökning |

| Minne | 768 GB (RAM per kärna beror på VM-storlek) |

| Lokal disk | 2 * 1,8 TB NVMe (block), 480 GB SSD (sidfil) |

| InfiniBand | 400 Gb/s Mellanox ConnectX-7 NDR InfiniBand |

| Nätverk | 80 Gb/s Ethernet (40 Gb/s kan användas) Azure second Gen SmartNIC |

Programvaruspecifikationer

| Programvaruspecifikationer | Virtuella datorer i HBv4-serien |

|---|---|

| Maximal MPI-jobbstorlek | 52 800 kärnor (300 virtuella datorer i en enda vm-skalningsuppsättning med singlePlacementGroup=true) |

| MPI-support | HPC-X (2,13 eller senare), Intel MPI (2021.7.0 eller senare), OpenMPI (4.1.3 eller senare), MVAPICH2 (2.3.7 eller senare), MPICH (4.1 eller senare) |

| Ytterligare ramverk | UCX, libfabric, PGAS eller andra InfiniBand-baserade runtimes |

| Stöd för Azure Storage | Standard- och Premium-diskar (högst 32 diskar), Azure NetApp Files, Azure Files, Azure HPC Cache, Azure Managed Lustre File System |

| Operativsystem som stöds och verifieras | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| Rekommenderat operativsystem för prestanda | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Stöd för Orchestrator | Azure CycleCloud, Azure Batch, AKS; konfigurationsalternativ för kluster |

Kommentar

- Dessa virtuella datorer stöder endast generation 2.

- Officiellt stöd på kernelnivå från AMD börjar med RHEL 8.6 och AlmaLinux 8.6, som är ett derivat av RHEL.

- Windows Server 2012 R2 stöds inte på HBv4 och andra virtuella datorer med fler än 64 (virtuella eller fysiska) kärnor. Mer information finns i Windows-gästoperativsystem som stöds för Hyper-V på Windows Server. Windows Server 2022 krävs för 144 och 176 kärnstorlekar, Windows Server 2016 fungerar också för 24, 48 och 96 kärnstorlekar, Windows Server fungerar endast för 24 och 48 kärnstorlekar.

Viktigt!

Rekommenderad avbildnings-URN: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, Om du vill distribuera den här avbildningen via Azure CLI kontrollerar du att följande parametrar ingår --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux. För skalningstester använder du det rekommenderade URN tillsammans med den nya HPC-X-tarballen.

Kommentar

- NDR-stöd läggs till i UCX 1.13 eller senare. Äldre UCX-versioner rapporterar ovanstående körningsfel. UCX-fel: Ogiltig aktiv hastighet

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat visar låg hastighet (SDR): Äldre Mellanox OFED-versioner (MOFED) stöder inte NDR och kan rapportera långsammare IB-hastigheter. Använd MOFED-versionerna MOFED 5.6-1.0.3.3 eller senare.

Nästa steg

- Läs om de senaste meddelandena, HPC-arbetsbelastningsexempel och prestandaresultat på Azure Compute Tech Community-bloggarna.

- En arkitekturvy på högre nivå för att köra HPC-arbetsbelastningar finns i HPC (High Performance Computing) på Azure.