Arbetsytepaket

Arbetsytepaket kan vara anpassade eller privata hjul (Python), jar-filer (Scala/Java) eller tar.gz (R). Du kan ladda upp dessa paket till din arbetsyta och senare tilldela dem till en specifik Spark-pool.

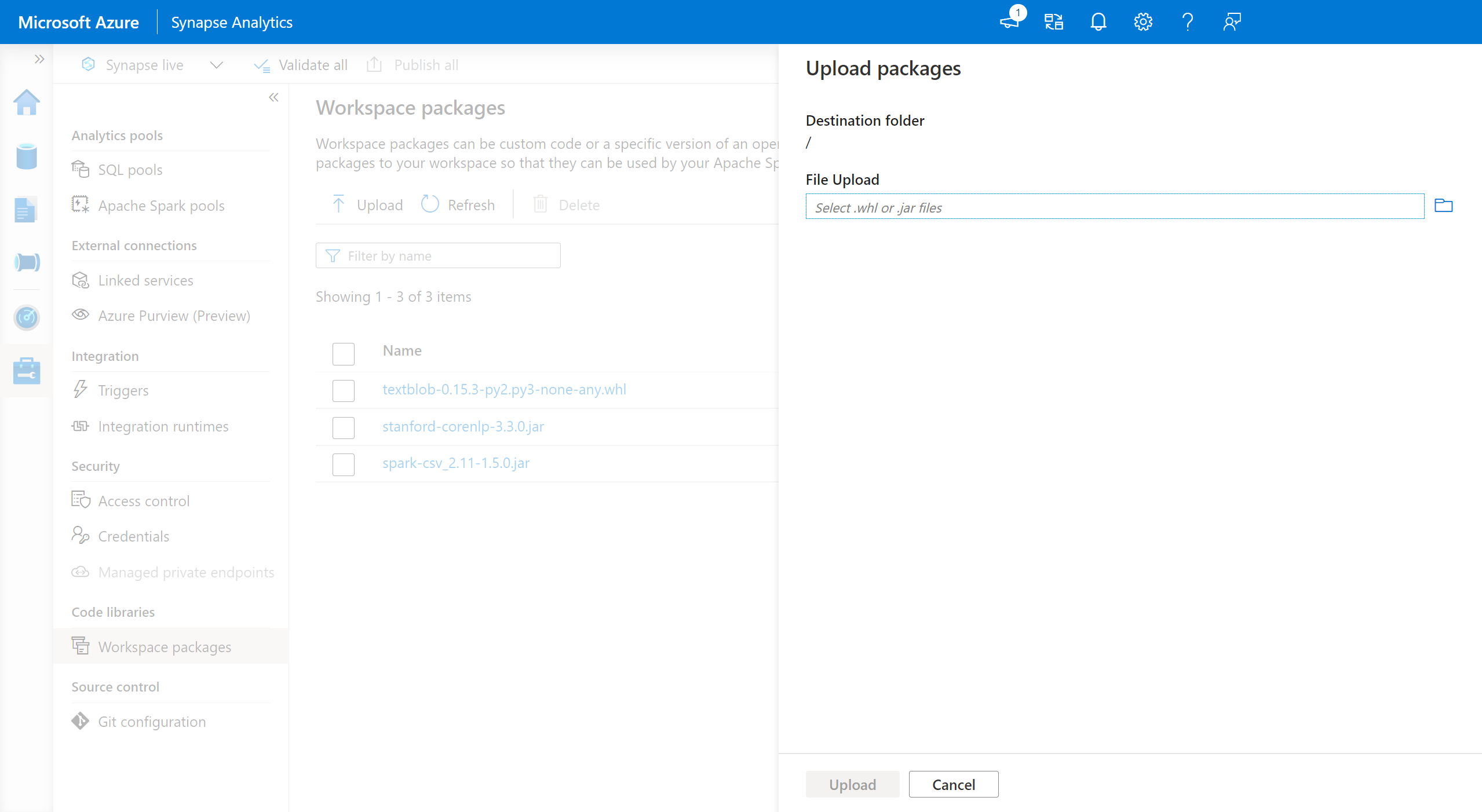

Så här lägger du till arbetsytepaket:

- Gå till fliken Hantera>arbetsytepaket .

- Ladda upp dina filer med hjälp av filväljaren.

- När filerna har laddats upp till Azure Synapse-arbetsytan kan du lägga till dessa paket i en Apache Spark-pool.

Varning

I Azure Synapse kan en Apache Spark-pool använda anpassade bibliotek som antingen laddas upp som arbetsytepaket eller laddas upp inom en välkänd Azure Data Lake Storage-sökväg. Båda dessa alternativ kan dock inte användas samtidigt i samma Apache Spark-pool. Om paket tillhandahålls med båda metoderna installeras endast de hjulfiler som anges i listan Arbetsytepaket.

När arbetsytepaket används för att installera paket i en viss Apache Spark-pool finns det en begränsning att du inte längre kan ange paket med hjälp av lagringskontosökvägen i samma pool.

Kommentar

Vi rekommenderar att du inte har flera paket med samma namn på en arbetsyta. Om du vill använda en annan version av samma paket måste du ta bort den befintliga versionen och ladda upp den nya.

Lagringskonto

Anpassade paket kan installeras i Apache Spark-poolen genom att ladda upp alla filer till Azure Data Lake Storage-kontot (Gen2) som är länkat till Synapse-arbetsytan.

Filerna ska laddas upp till följande sökväg i lagringskontots standardcontainer:

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

Varning

- I vissa fall kan du behöva skapa filsökvägen baserat på strukturen ovan om den inte redan finns. Du kan till exempel behöva lägga

pythontill mappen i mappen om denlibrariesinte redan finns. - Den här metoden för att hantera anpassade filer stöds inte på Azure Synapse Runtime för Apache Spark 3.0. Se funktionen Arbetsytepaket för att hantera anpassade filer.

Viktigt!

Om du vill installera anpassade bibliotek med azure DataLake Storage-metoden måste du ha behörigheten Storage Blob Data Contributor eller Storage Blob Data Owner för det primära Gen2 Storage-kontot som är länkat till Azure Synapse Analytics-arbetsytan.

Nästa steg

- Visa standardbiblioteken: Stöd för Apache Spark-version

- Felsöka installationsfel för bibliotek: Felsöka biblioteksfel

- Skapa en privat Conda-kanal med ditt Azure Data Lake Storage-konto: Privata Conda-kanaler