Snabbstart: Transformera data med hjälp av mappning av dataflöden

I den här snabbstarten använder du Azure Synapse Analytics för att skapa en pipeline som transformerar data från en Azure Data Lake Storage Gen2-källa (ADLS Gen2) till en ADLS Gen2-mottagare med hjälp av mappningsdataflöde. Konfigurationsmönstret i den här snabbstarten kan utökas vid transformering av data med hjälp av dataflödesmappning

I den här snabbstarten gör du följande:

- Skapa en pipeline med en Dataflöde aktivitet i Azure Synapse Analytics.

- Skapa ett mappningsdataflöde med fyra transformeringar.

- Testkör pipelinen.

- Övervaka en Dataflöde aktivitet

Förutsättningar

Azure-prenumeration: Om du inte har en Azure-prenumeration skapar du ett kostnadsfritt Azure-konto innan du börjar.

Azure Synapse-arbetsyta: Skapa en Synapse-arbetsyta med hjälp av Azure Portal enligt anvisningarna i Snabbstart: Skapa en Synapse-arbetsyta.

Azure Storage-konto: Du använder ADLS-lagring som käll- och mottagardatalager . Om du inte har ett lagringskonto finns det anvisningar om hur du skapar ett i Skapa ett Azure Storage-konto.

Filen som vi transformerar i den här självstudien är MoviesDB.csv, som du hittar här. Om du vill hämta filen från GitHub kopierar du innehållet till valfri textredigerare för att spara lokalt som en .csv fil. Information om hur du laddar upp filen till ditt lagringskonto finns i Ladda upp blobar med Azure Portal. Exemplen refererar till en container med namnet "sample-data".

Navigera till Synapse Studio

När din Azure Synapse-arbetsyta har skapats kan du öppna Synapse Studio på två sätt:

- Öppna Synapse-arbetsytan i Azure Portal. Välj Öppna på kortet Öppna Synapse Studio under Komma igång.

- Öppna Azure Synapse Analytics och logga in på din arbetsyta.

I den här snabbstarten använder vi arbetsytan med namnet "adftest2020" som exempel. Den navigerar automatiskt till Synapse Studio-startsidan.

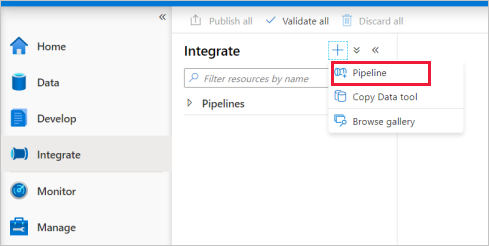

Skapa en pipeline med en Dataflöde aktivitet

En pipeline innehåller det logiska flödet för en körning av en uppsättning aktiviteter. I det här avsnittet skapar du en pipeline som innehåller en Dataflöde aktivitet.

Gå till fliken Integrera . Välj plusikonen bredvid pipelinehuvudet och välj Pipeline.

På sidan Egenskaperinställningar i pipelinen anger du TransformMovies som Namn.

Under Flytta och transformera i fönstret Aktiviteter drar du Dataflöde till pipelinearbetsytan.

På popup-fönstret Lägg till dataflöde väljer du Skapa nytt dataflöde –> Dataflöde. Välj OK när du är klar.

Ge dataflödet namnet TransformMovies på sidan Egenskaper .

Skapa transformeringslogik på dataflödesarbetsytan

När du har skapat din Dataflöde skickas du automatiskt till dataflödesarbetsytan. I det här steget skapar du ett dataflöde som tar MoviesDB.csv i ADLS-lagring och aggregerar det genomsnittliga omdömet för komedier från 1910 till 2000. Sedan skriver du tillbaka den här filen till ADLS-lagringen.

Ovanför dataflödesarbetsytan skjuter du skjutreglaget för felsökning av dataflöde på. Felsökningsläget möjliggör interaktiv testning av omvandlingslogik mot ett Live Spark-kluster. Dataflöde kluster tar 5–7 minuter att värma upp och användarna rekommenderas att aktivera felsökning först om de planerar att utföra Dataflöde utveckling. Mer information finns i Felsökningsläge.

Lägg till en källa i dataflödesarbetsytan genom att klicka på rutan Lägg till källa .

Ge källan namnet MoviesDB. Välj Ny för att skapa en ny källdatauppsättning.

Välj Azure Data Lake Storage Gen2. Välj Fortsätt.

Välj AvgränsadText. Välj Fortsätt.

Ge datauppsättningen namnet MoviesDB. I listrutan länkad tjänst väljer du Ny.

På skärmen för att skapa länkad tjänst namnger du den länkade ADLS Gen2-tjänsten ADLSGen2 och anger din autentiseringsmetod. Ange sedan dina autentiseringsuppgifter för anslutningen. I den här snabbstarten använder vi kontonyckeln för att ansluta till vårt lagringskonto. Du kan välja Testa anslutning för att kontrollera att dina autentiseringsuppgifter har angetts korrekt. Välj Skapa när du är klar.

När du är tillbaka på skärmen för att skapa datauppsättningen går du till fältet Filsökväg och anger var filen finns. I den här snabbstarten finns filen "MoviesDB.csv" i containern "sample-data". Eftersom filen har rubriker markerar du Första raden som rubrik. Välj Från anslutning/arkiv för att importera rubrikschemat direkt från filen i lagringen. Välj OK när du är klar.

Om felsökningsklustret har startat går du till fliken Förhandsgranskning av data i källomvandlingen och väljer Uppdatera för att få en ögonblicksbild av data. Du kan använda förhandsversionen av data för att kontrollera att omvandlingen är korrekt konfigurerad.

Bredvid källnoden på dataflödesarbetsytan väljer du plusikonen för att lägga till en ny transformering. Den första omvandlingen som du lägger till är ett filter.

Ge filtertransformeringen namnet FilterYears. Välj uttrycksrutan bredvid Filtrera på för att öppna uttrycksverktyget. Här anger du filtreringsvillkoret.

Med dataflödesuttrycksverktyget kan du interaktivt skapa uttryck som ska användas i olika transformeringar. Uttryck kan innehålla inbyggda funktioner, kolumner från indataschemat och användardefinierade parametrar. Mer information om hur du skapar uttryck finns i Dataflöde uttrycksverktyget.

I den här snabbstarten vill du filtrera filmer av genrekomik som kom ut mellan åren 1910 och 2000. Eftersom år för närvarande är en sträng måste du konvertera den till ett heltal med hjälp av

toInteger()funktionen. Använd operatorerna större än eller lika med (>=) och mindre än eller lika med (<=) för att jämföra med läsårsvärdena 1910 och 200-. Koppla dessa uttryck tillsammans med operatorn&&(och). Uttrycket kommer ut som:toInteger(year) >= 1910 && toInteger(year) <= 2000Om du vill ta reda på vilka filmer som är komedier kan du använda

rlike()funktionen för att hitta mönstret "Comedy" i kolumngenren. Union uttrycketrlikemed årsjämförelsen för att få:toInteger(year) >= 1910 && toInteger(year) <= 2000 && rlike(genres, 'Comedy')

Om du har ett felsökningskluster aktivt kan du verifiera logiken genom att klicka på Uppdatera för att se uttrycksutdata jämfört med de indata som används. Det finns mer än ett rätt svar på hur du kan åstadkomma den här logiken med hjälp av dataflödesuttrycksspråket.

Välj Spara och Slutför när du är klar med uttrycket.

Hämta en dataförhandsgranskning för att kontrollera att filtret fungerar korrekt.

Nästa transformering som du lägger till är en aggregeringstransformering under Schemamodifierare.

Ge din aggregerade omvandling namnet AggregateComedyRatings. På fliken Gruppera efter väljer du år i listrutan för att gruppera aggregeringarna efter året då filmen kom ut.

Gå till fliken Aggregeringar . I den vänstra textrutan namnger du samlingskolumnen AverageComedyRating. Välj den högra uttrycksrutan för att ange samlingsuttrycket via uttrycksverktyget.

Om du vill få medelvärdet av kolumnklassificering använder du aggregeringsfunktionen

avg(). Eftersom Klassificering är en sträng ochavg()tar in numeriska indata måste vi konvertera värdet till ett tal viatoInteger()funktionen. Det här uttrycket ser ut så här:avg(toInteger(Rating))Välj Spara och Slutför när du är klar.

Gå till fliken Dataförhandsgranskning för att visa transformeringsutdata. Observera att endast två kolumner finns där, year och AverageComedyRating.

Sedan vill du lägga till en sink-transformering under Mål.

Ge mottagaren namnet Sink. Välj Ny för att skapa datauppsättningen för mottagare.

Välj Azure Data Lake Storage Gen2. Välj Fortsätt.

Välj AvgränsadText. Välj Fortsätt.

Ge mottagarens datauppsättning namnet MoviesSink. För länkad tjänst väljer du den länkade ADLS Gen2-tjänst som du skapade i steg 7. Ange en utdatamapp att skriva dina data till. I den här snabbstarten skriver vi till mappen "output" i containern "sample-data". Mappen behöver inte finnas i förväg och kan skapas dynamiskt. Ange Första raden som rubrik som true och välj Ingen för importschema. Välj OK när du är klar.

Nu har du skapat dataflödet. Du är redo att köra den i pipelinen.

Köra och övervaka Dataflöde

Du kan felsöka en pipeline innan du publicerar den. I det här steget ska du utlösa en felsökningskörning av dataflödespipelinen. Dataförhandsvisning skriver inte data, men en felsökningskörning skriver data till målmottagaren.

Gå till pipelinearbetsytan. Välj Felsök för att utlösa en felsökningskörning.

Pipelinefelsökning av Dataflöde-aktiviteter använder det aktiva felsökningsklustret, men det tar ändå minst en minut att initiera. Du kan spåra förloppet via fliken Utdata . När körningen är klar väljer du glasögonikonen för att öppna övervakningsfönstret.

I övervakningsfönstret kan du se antalet rader och den tid som spenderas i varje transformeringssteg.

Välj en transformering för att få detaljerad information om kolumnerna och partitioneringen av data.

Om du har följt den här snabbstarten korrekt bör du ha skrivit 83 rader och 2 kolumner i mappen mottagare. Du kan verifiera data genom att kontrollera bloblagringen.

Nästa steg

Gå vidare till följande artiklar för att lära dig mer om Azure Synapse Analytics-stöd: