Filtrera och mata in till Azure Data Lake Storage Gen2 med Stream Analytics utan kodredigerare

Den här artikeln beskriver hur du kan använda redigeringsprogrammet utan kod för att enkelt skapa ett Stream Analytics-jobb. Den läser kontinuerligt från dina eventhubbar, filtrerar inkommande data och skriver sedan resultatet kontinuerligt till Azure Data Lake Storage Gen2.

Förutsättningar

- Dina Azure Event Hubs-resurser måste vara offentligt tillgängliga och inte ligga bakom en brandvägg eller skyddas i ett virtuellt Azure-nätverk

- Data i dina Event Hubs måste serialiseras i antingen JSON-, CSV- eller Avro-format.

Utveckla ett Stream Analytics-jobb för att filtrera och mata in realtidsdata

Leta upp och välj Azure Event Hubs-instansen i Azure Portal.

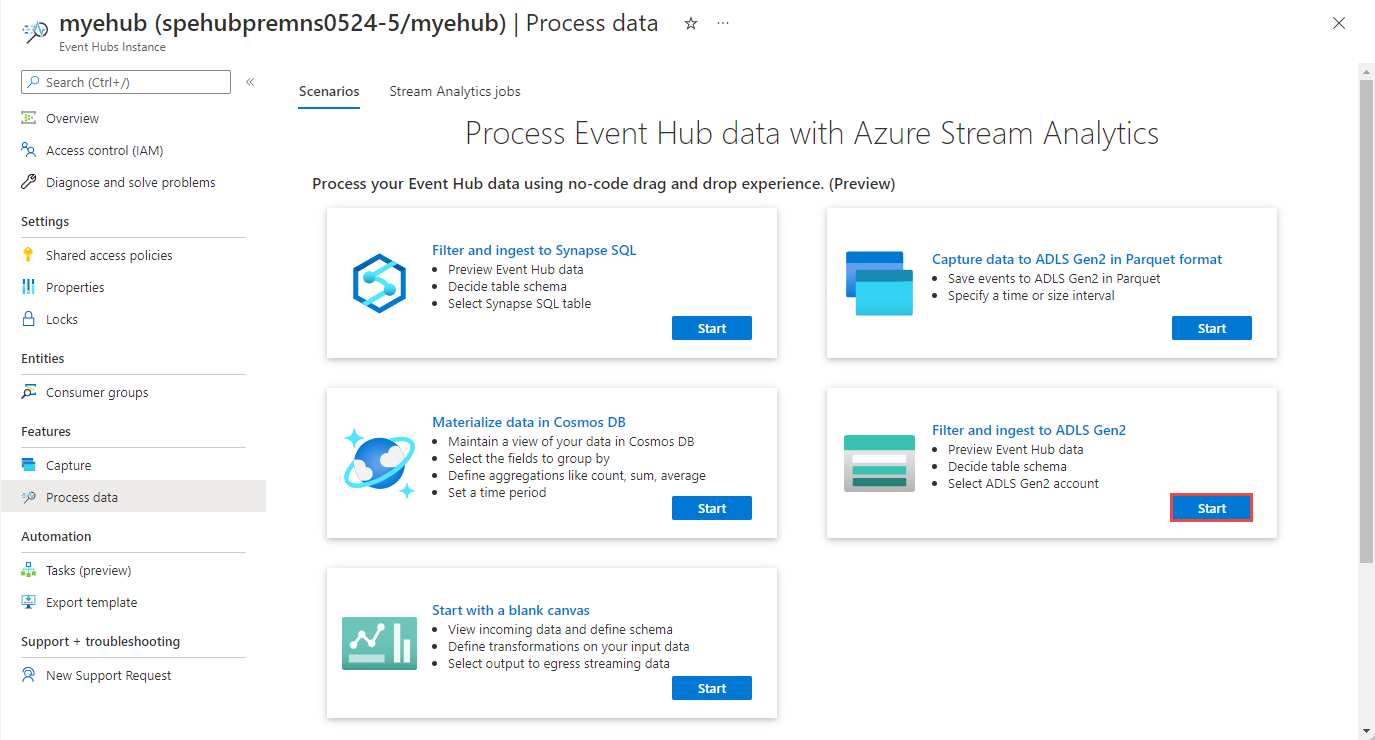

Välj Funktioner>Bearbeta data och välj sedan Starta på kortet Filter och mata in till ADLS Gen2.

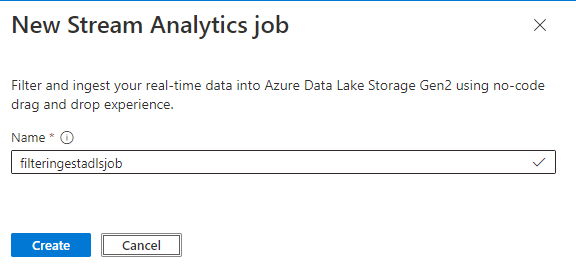

Ange ett namn för Stream Analytics-jobbet och välj sedan Skapa.

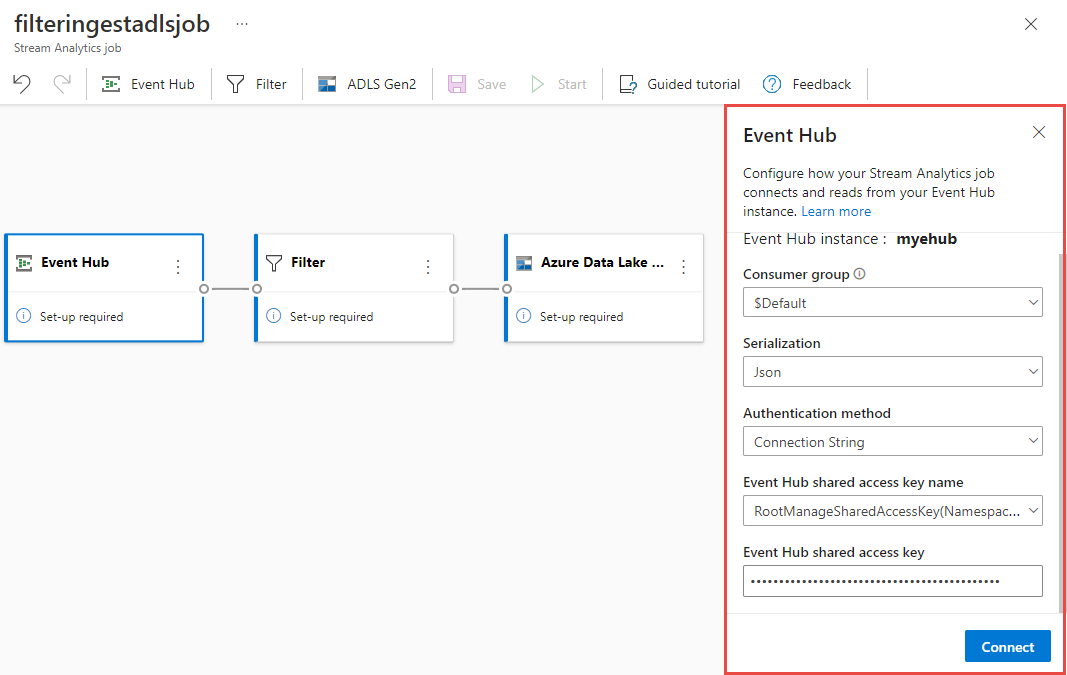

Ange serialiseringstypen för dina data i fönstret Event Hubs och den autentiseringsmetod som jobbet ska använda för att ansluta till Händelsehubbar. Välj sedan Anslut.

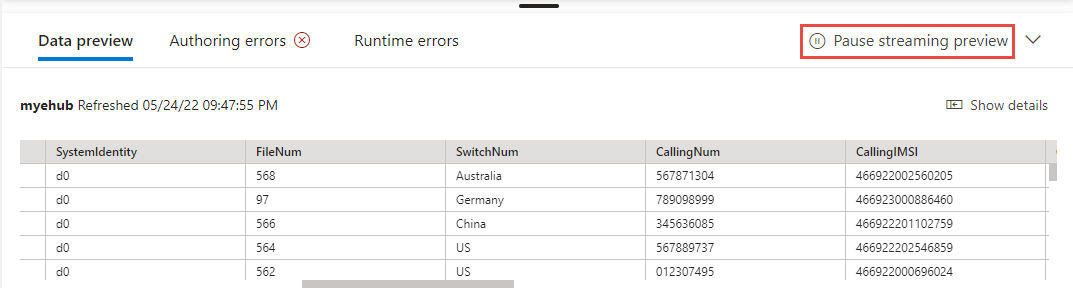

Om anslutningen har upprättats och du har dataströmmar som flödar in till Event Hubs-instansen ser du omedelbart två saker:

- Fält som finns i indata. Du kan välja Lägg till fält eller välja symbolen med tre punkter bredvid varje fält för att ta bort, byta namn på eller ändra dess typ.

- Ett liveexempel på inkommande data i tabellen Dataförhandsgranskning under diagramvyn. Den uppdateras automatiskt med jämna mellanrum. Du kan välja Pausa förhandsversionen av direktuppspelning för att se en statisk vy över exempelindata.

- Fält som finns i indata. Du kan välja Lägg till fält eller välja symbolen med tre punkter bredvid varje fält för att ta bort, byta namn på eller ändra dess typ.

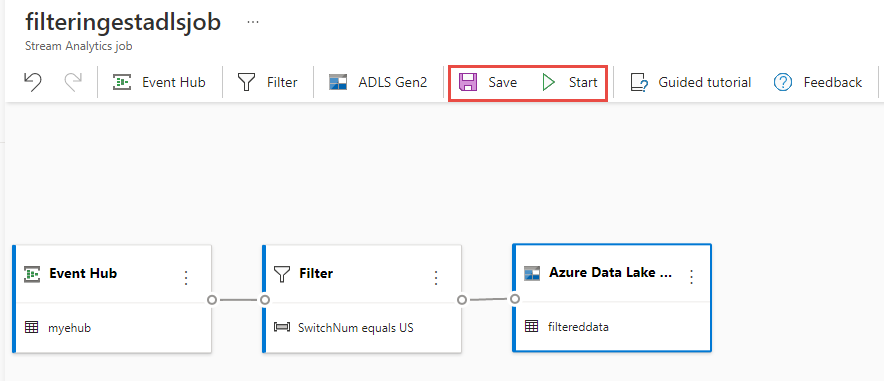

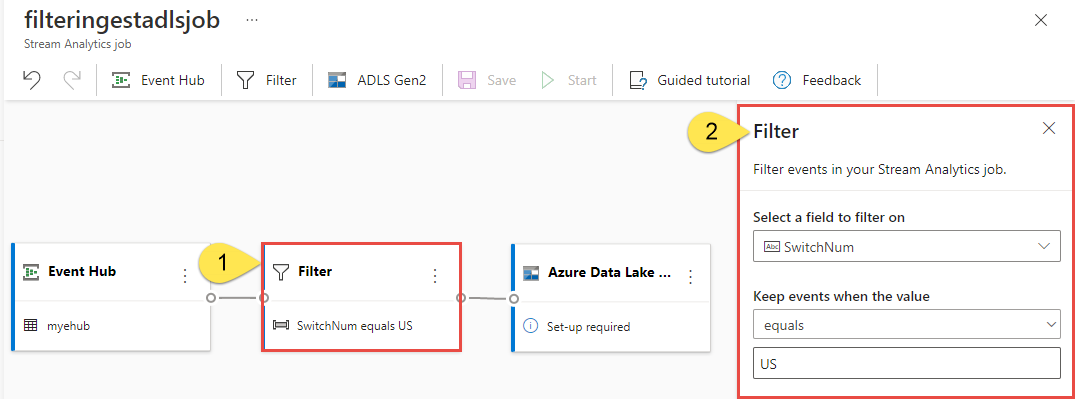

Välj panelen Filter . I området Filter väljer du ett fält för att filtrera inkommande data med ett villkor.

Välj panelen Azure Data Lake Storage Gen2. Välj Azure Data Lake Gen2-kontot för att skicka filtrerade data:

- Välj prenumeration, lagringskontonamn och container i den nedrullningsbara menyn.

- När prenumerationen har valts ska autentiseringsmetoden och lagringskontonyckeln fyllas i automatiskt. Välj Anslut.

Mer information om fälten och om du vill se exempel på sökvägsmönster finns i Blob Storage- och Azure Data Lake Gen2-utdata från Azure Stream Analytics.

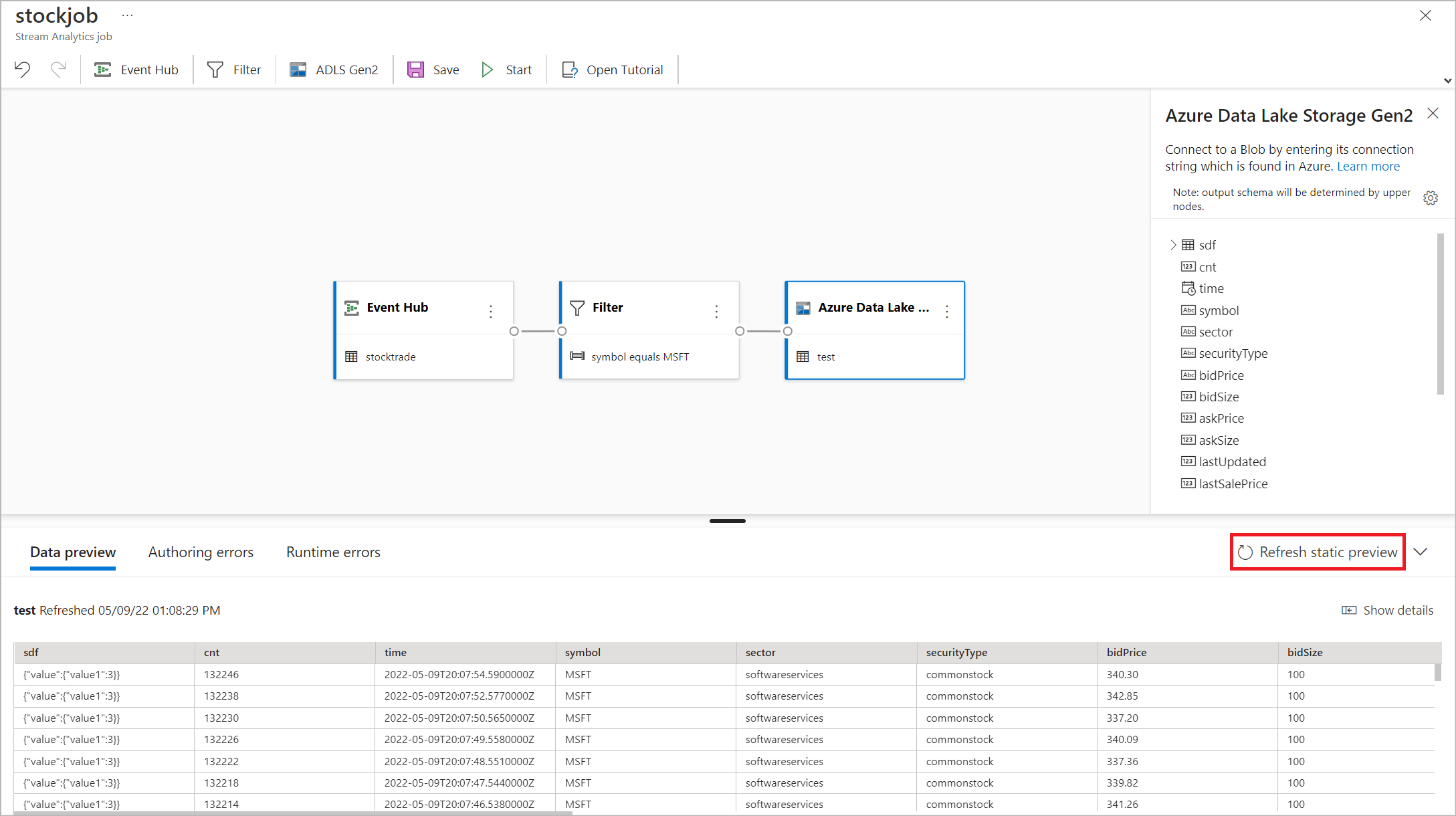

Du kan också välja Hämta statisk förhandsversion/Uppdatera statisk förhandsversion för att se den dataförhandsgranskning som ska matas in från Azure Data Lake Storage Gen2.

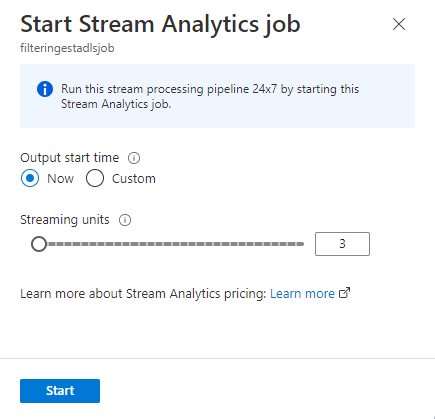

Om du vill starta jobbet anger du antalet strömningsenheter (SUs) som jobbet körs med. SUs representerar mängden beräkning och minne som allokerats till jobbet. Vi rekommenderar att du börjar med tre och sedan justerar efter behov.

När du har valt Start börjar jobbet köras inom två minuter och måtten öppnas i flikavsnittet nedan.

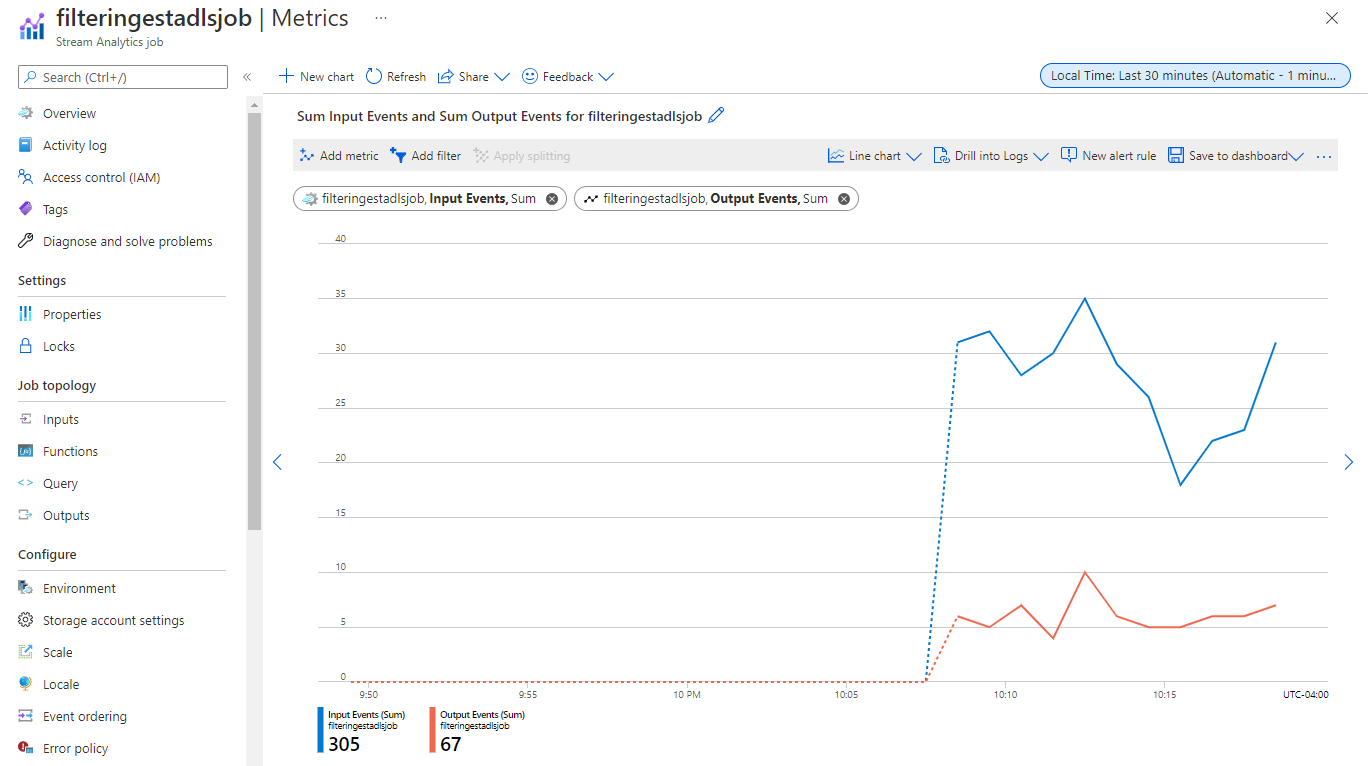

Du kan se jobbet under avsnittet Processdata på fliken Stream Analytics-jobb . Välj Uppdatera tills du ser jobbstatusen som Körs. Välj Öppna mått för att övervaka det eller stoppa och starta om det efter behov.

Här är ett exempel på sidan Mått :

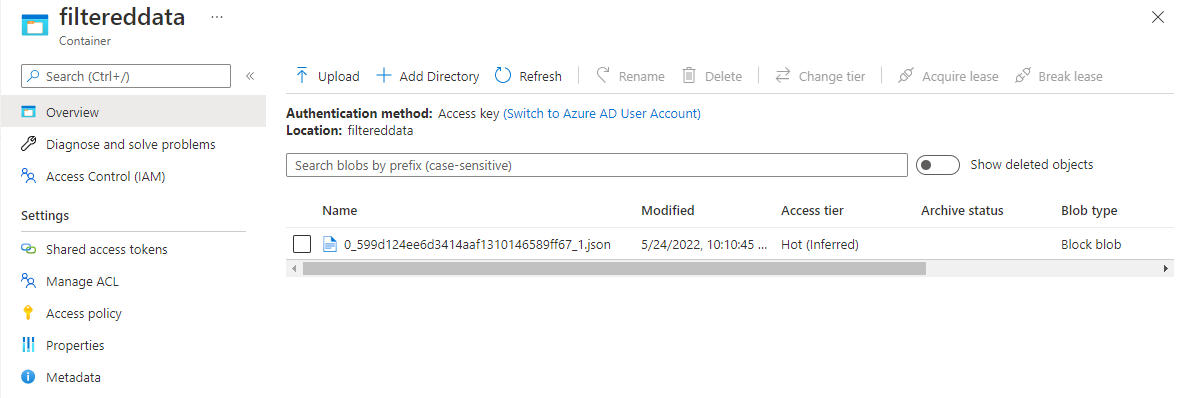

Verifiera data i Data Lake Storage

Du bör se filer som skapats i den container som du har angett.

Ladda ned och öppna filen för att bekräfta att du bara ser filtrerade data. I följande exempel visas data med SwitchNum inställt på USA.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Överväganden vid användning av geo-replikeringsfunktionen i Event Hubs

Azure Event Hubs lanserade nyligen geo-replikeringsfunktionen i offentlig förhandsversion. Den här funktionen skiljer sig från geo-haveriberedskapsfunktionen i Azure Event Hubs.

När redundanstypen är Tvingad och replikeringskonsekvensen är asynkron garanterar Stream Analytics-jobbet inte exakt en gång utdata till en Azure Event Hubs-utdata.

Azure Stream Analytics, som producent med en händelsehubb som utdata, kan observera vattenstämpelfördröjning på jobbet under redundansväxlingen och under begränsningen av Event Hubs om replikeringsfördröjningen mellan primär och sekundär når den maximala konfigurerade fördröjningen.

Azure Stream Analytics, som konsument med Event Hubs som indata, kan observera vattenstämpelfördröjning på jobbet under redundansväxlingen och kan hoppa över data eller hitta duplicerade data när redundansväxlingen är klar.

På grund av dessa varningar rekommenderar vi att du startar om Stream Analytics-jobbet med lämplig starttid direkt efter att Event Hubs-redundansväxlingen har slutförts. Eftersom Geo-replikeringsfunktionen i Event Hubs är en offentlig förhandsversion rekommenderar vi inte heller att du använder det här mönstret för stream analytics-produktionsjobb just nu. Det aktuella Stream Analytics-beteendet förbättras innan funktionen Event Hubs Geo-replikering är allmänt tillgänglig och kan användas i Stream Analytics-produktionsjobb.

Nästa steg

Läs mer om Azure Stream Analytics och hur du övervakar det jobb du har skapat.