Träna med MLflow Projects i Azure Machine Learning (förhandsversion)

I den här artikeln får du lära dig hur du skickar träningsjobb med MLflow Projects som använder Azure Machine Learning-arbetsytor för spårning. Du kan skicka jobb och bara spåra dem med Azure Machine Learning eller migrera dina körningar till molnet för att köras helt på Azure Machine Learning Compute.

Varning

Stöd för MLproject filer (MLflow Projects) i Azure Machine Learning dras tillbaka helt i september 2026. MLflow stöds fortfarande fullt ut och är fortfarande det rekommenderade sättet att spåra maskininlärningsarbetsbelastningar i Azure Machine Learning.

När du fortsätter att använda MLflow rekommenderar vi att du övergår från MLproject filer till Azure Machine Learning-jobb med antingen Azure CLI eller Azure Machine Learning SDK för Python (v2). Mer information om Azure Machine Learning-jobb finns i Spåra ML-experiment och modeller med MLflow.

Med MLflow-projekt kan du organisera och beskriva koden så att andra dataforskare (eller automatiserade verktyg) kan köra den. Med MLflow Projects med Azure Machine Learning kan du spåra och hantera dina träningskörningar på din arbetsyta.

Viktigt!

Den här funktionen är för närvarande i allmänt tillgänglig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade.

Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Läs mer om MLflow- och Azure Machine Learning-integreringen.

Förutsättningar

Installera MLflow SDK-paketet

mlflowoch Azure Machine Learning-plugin-programmetazureml-mlflowför MLflow på följande sätt:pip install mlflow azureml-mlflowDricks

Du kan använda

mlflow-skinnypaketet, som är ett enkelt MLflow-paket utan SQL-lagring, server, användargränssnitt eller datavetenskapsberoenden. Det här paketet rekommenderas för användare som främst behöver MLflow-spårnings- och loggningsfunktionerna utan att importera hela sviten med funktioner, inklusive distributioner.Skapa en Azure Machine Learning-arbetsyta. Information om hur du skapar en arbetsyta finns i Skapa resurser som du behöver för att komma igång. Granska de åtkomstbehörigheter du behöver för att utföra dina MLflow-åtgärder på din arbetsyta.

Om du vill utföra fjärrspårning eller spåra experiment som körs utanför Azure Machine Learning konfigurerar du MLflow så att det pekar på spårnings-URI:n för din Azure Machine Learning-arbetsyta. Mer information om hur du ansluter MLflow till din arbetsyta finns i Konfigurera MLflow för Azure Machine Learning.

Om du använder Azure Machine Learning som serverdel för MLflow-projekt krävs paketet

azureml-core:pip install azureml-core

Anslut till din arbetsyta

Om du arbetar utanför Azure Machine Learning måste du konfigurera MLflow så att det pekar på din Azure Machine Learning-arbetsytas spårnings-URI. Du hittar anvisningarna i Konfigurera MLflow för Azure Machine Learning.

Spåra MLflow-projekt i Azure Machine Learning-arbetsytor

Det här exemplet visar hur du skickar MLflow-projekt och spårar dem i Azure Machine Learning.

azureml-mlflowLägg till paketet som ett pip-beroende till din miljökonfigurationsfil för att spåra mått och nyckelartefakter på din arbetsyta.conda.yaml

name: mlflow-example channels: - defaults dependencies: - numpy>=1.14.3 - pandas>=1.0.0 - scikit-learn - pip: - mlflow - azureml-mlflowSkicka den lokala körningen och se till att du anger parametern

backend = "azureml", som lägger till stöd för automatisk spårning, modellens insamling, loggfiler, ögonblicksbilder och utskrivna fel på arbetsytan. I det här exemplet antar vi att MLflow-projektet som du försöker köra finns i samma mapp som du för närvarande är,uri=".".mlflow run . --experiment-name --backend azureml --env-manager=local -P alpha=0.3Visa dina körningar och mått i Azure Machine Learning-studio.

Träna MLflow-projekt i Azure Machine Learning-jobb

Det här exemplet visar hur du skickar MLflow-projekt som ett jobb som körs på Azure Machine Learning-beräkning.

Skapa serverdelskonfigurationsobjektet, i det här fallet anger

COMPUTEvi . Den här parametern refererar till namnet på det fjärrberäkningskluster som du vill använda för att köra projektet. OmCOMPUTEfinns skickas projektet automatiskt som ett Azure Machine Learning-jobb till den angivna beräkningen.backend_config.json

{ "COMPUTE": "cpu-cluster" }azureml-mlflowLägg till paketet som ett pip-beroende till din miljökonfigurationsfil för att spåra mått och nyckelartefakter på din arbetsyta.conda.yaml

name: mlflow-example channels: - defaults dependencies: - numpy>=1.14.3 - pandas>=1.0.0 - scikit-learn - pip: - mlflow - azureml-mlflowSkicka den lokala körningen och se till att du anger parametern

backend = "azureml", som lägger till stöd för automatisk spårning, modellens insamling, loggfiler, ögonblicksbilder och utskrivna fel på arbetsytan. I det här exemplet antar vi att MLflow-projektet som du försöker köra finns i samma mapp som du för närvarande är,uri=".".mlflow run . --backend azureml --backend-config backend_config.json -P alpha=0.3Kommentar

Eftersom Azure Machine Learning-jobb alltid körs i kontexten för miljöer ignoreras parametern

env_manager.Visa dina körningar och mått i Azure Machine Learning-studio.

Rensa resurser

Om du inte planerar att använda de loggade måtten och artefakterna på din arbetsyta är möjligheten att ta bort dem individuellt för närvarande inte tillgänglig. Ta i stället bort resursgruppen som innehåller lagringskontot och arbetsytan, så att du inte debiteras några avgifter:

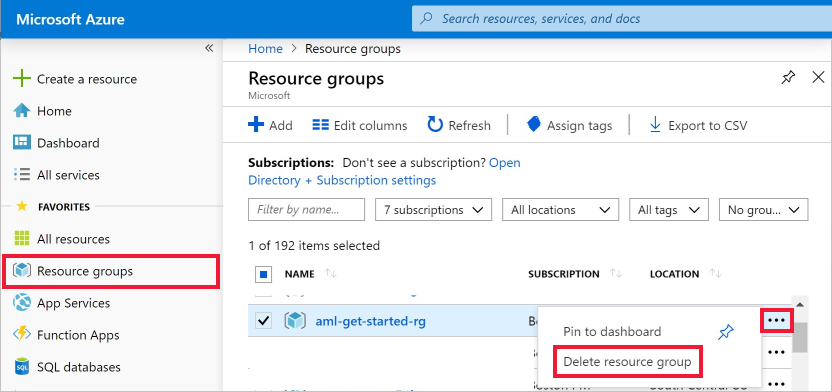

I Azure-portalen väljer du Resursgrupper längst till vänster.

Välj den resursgrupp i listan som du har skapat.

Välj Ta bort resursgrupp.

Ange resursgruppsnamnet. Välj sedan ta bort.

Exempelnotebook-filer

MLflow med Azure Machine Learning-notebook-filer visar och utökar begrepp som presenteras i den här artikeln.

Kommentar

En community-driven lagringsplats med exempel med mlflow finns på https://github.com/Azure/azureml-examples.