Parallellisera justering av hyperparametrar med Hyperopt

Kommentar

Versionen med öppen källkod av Hyperopt underhålls inte längre.

Hyperopt tas bort i nästa större DBR ML-version. Azure Databricks rekommenderar att du använder antingen Optuna- för ennodsoptimering eller RayTune för en liknande upplevelse som de inaktuella hyperopt-distribuerade hyperparameterjusteringsfunktionerna. Läs mer om hur du använder RayTune i Azure Databricks.

Den här notebook-filen visar hur du använder Hyperopt för att parallellisera justeringsberäkningar för hyperparametrar. Den använder SparkTrials klassen för att automatiskt distribuera beräkningar mellan klusterarbetarna. Det illustrerar också automatiserad MLflow-spårning av Hyperopt-körningar så att du kan spara resultatet till senare.

Parallellisera justering av hyperparametrar med automatisk MLflow-spårningsanteckningsbok

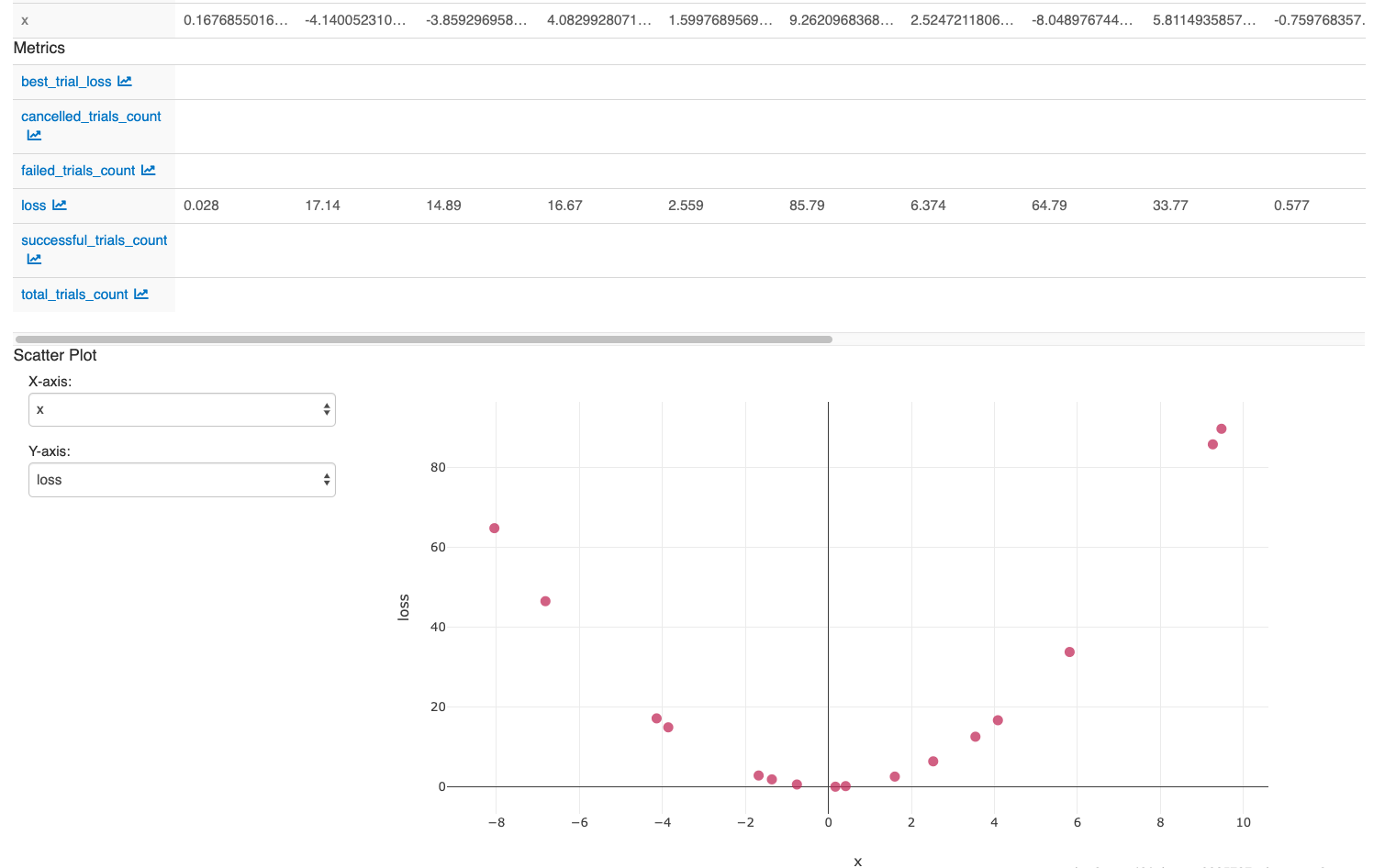

När du har utför åtgärderna i den sista cellen i notebook-filen ska ditt MLflow-användargränssnitt visa: