Användningsfallsdefinition

För att stödja det här arbetsexemplet används det fiktiva företaget "Contoso" med en Azure Data Platform baserat på Microsofts referensarkitekturer.

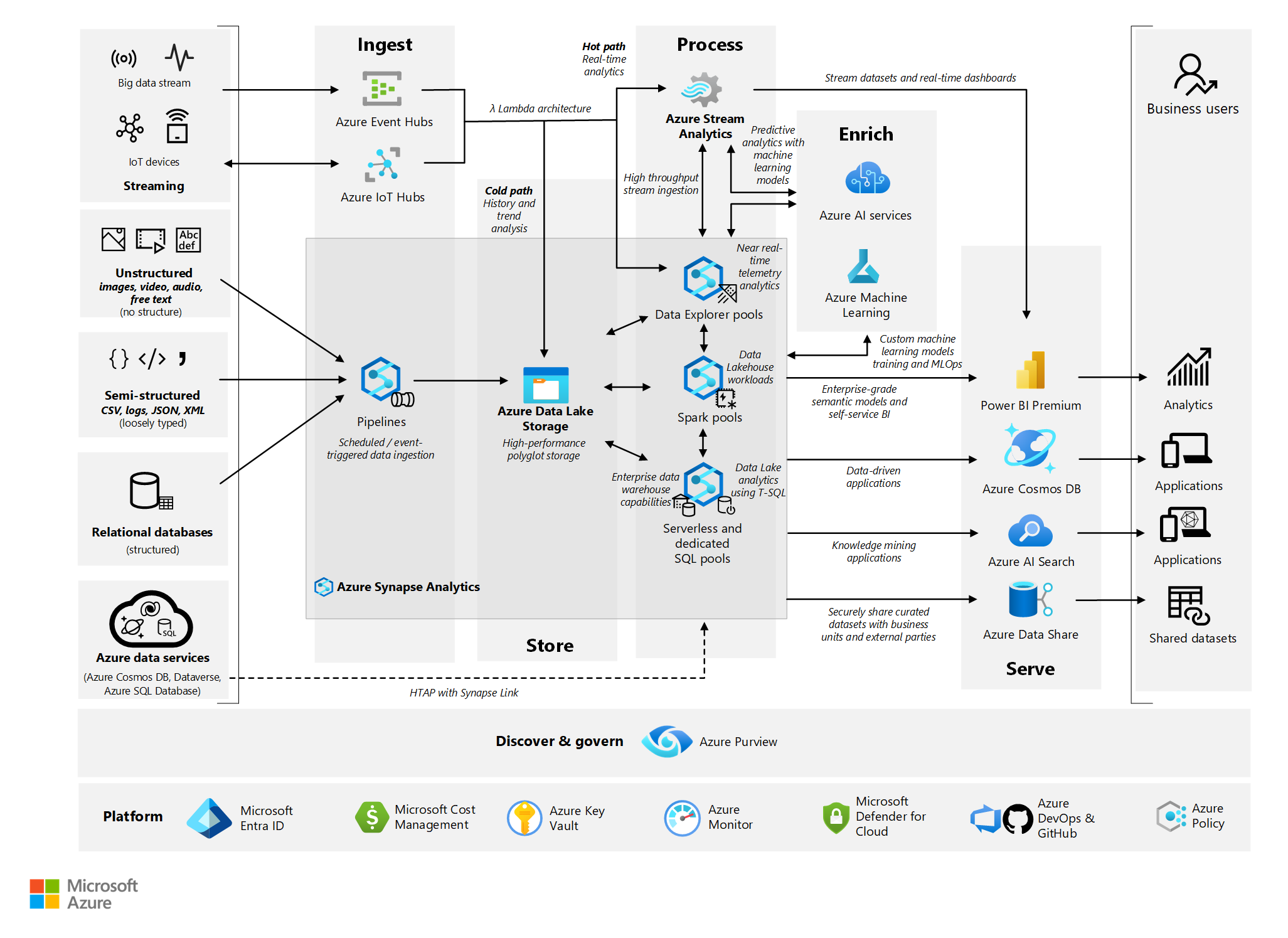

Datatjänst – komponentvy

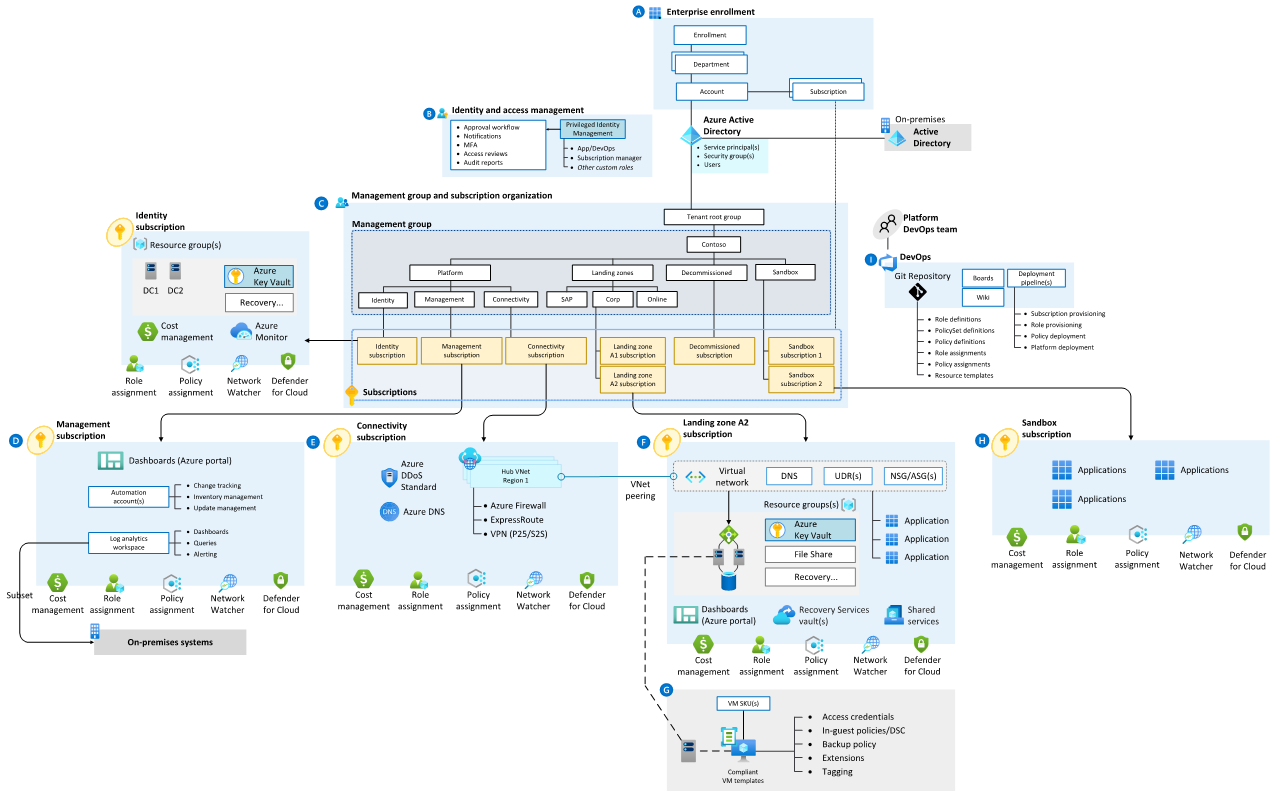

Contoso har implementerat följande grundläggande Azure-arkitektur, som är en delmängd av designen Enterprise Landing Zone .

Siffrorna i följande beskrivningar motsvarar föregående diagram ovan.

Contosos Azure Foundations – arbetsflöde

- Företagsregistrering – Contosos främsta överordnad företagsregistrering i Azure som återspeglar dess kommersiella avtal med Microsoft, organisationens kontostruktur och tillgängliga Azure-prenumerationer. Det ger faktureringsgrunden för prenumerationer och hur den digitala egendomen administreras.

- Identitets- och åtkomsthantering – De komponenter som krävs för att tillhandahålla identitets-, autentiserings-, resursåtkomst- och auktoriseringstjänster i Contosos Azure-egendom.

- Hanteringsgrupp och prenumerationsorganisation – En skalbar grupphierarki som är anpassad efter dataplattformens kärnfunktioner, vilket möjliggör driftsättning i stor skala med hjälp av centralt hanterad säkerhet och styrning där arbetsbelastningar har tydlig separation. Hanteringsgrupper tillhandahåller ett styrningsomfång över prenumerationer.

- Hanteringsprenumeration – en dedikerad prenumeration för de olika hanteringsnivåfunktioner som krävs för att stödja dataplattformen.

- Anslutningsprenumeration – en dedikerad prenumeration för dataplattformens anslutningsfunktioner så att den kan identifiera namngivna tjänster, fastställa säker routning och kommunikation mellan och mellan interna och externa tjänster.

- Prenumeration på landningszon – en-till-många-prenumerationer för azure-inbyggda onlineprogram, interna och externa arbetsbelastningar och resurser

- DevOps-plattformen – DevOps-plattformen som stöder hela Azure-egendomen. Den här plattformen innehåller lagringsplatsen för kodbasen för källkodskontroll och CI/CD-pipelines som möjliggör automatiserade distributioner av infrastruktur som kod (IaC).

Kommentar

Många kunder behåller fortfarande ett stort IaaS-fotavtryck (infrastruktur som en tjänst). För att tillhandahålla återställningsfunktioner i IaaS är den nyckelkomponent som ska läggas till Azure Site Recovery. Site Recovery samordnar och automatiserar replikeringen av virtuella Azure-datorer mellan regioner, lokala virtuella datorer och fysiska servrar till Azure och lokala datorer till ett sekundärt datacenter.

I den här grundläggande strukturen har Contoso implementerat följande element för att stödja företagets business intelligence-behov, anpassade till vägledningen i Analytics från slutpunkt till slutpunkt med Azure Synapse.

Contosos dataplattform – arbetsflöde

Arbetsflödet läss från vänster till höger efter dataflödet:

- Datakällor – Källor eller typer av data som dataplattformen kan använda från.

- Inmatning – Plattformens förmåga att mata in data från olika källor med varierande struktur och hastighet. Den här designen återspeglar en Lambda-arkitektur.

- Store – Möjligheten att på ett säkert sätt lagra data i stor skala som har matats in på plattformen.

- Process – Plattformens förmåga att bearbeta data, vilket gör den "lämplig för ändamålet" för nedströmsprocesser som rensning, standardisering och modellering. Förbearbetningen av data säkerställer vanligtvis att de är i en "position och ett villkor, redo för användning".

- Enrich – Möjligheten att förbättra data som bearbetas på plattformen via statistik, maskininlärning eller andra modelleringstekniker eller fördefinierade Azure AI-tjänster.

- Serve – Plattformens förmåga att forma och presentera data för nedströmsförbrukning.

- Datakonsumenter – Enskilda användare, program eller nedströmsprocesser som använder data från plattformarnas olika tjänstpekpunkter.

- Upptäck och styr – Plattformens funktioner för att styra de data som den innehåller och se till att de är indexerade, identifierbara/sökbara, väl beskrivna, med fullständig härkomst och är transparenta för slutanvändarna och användningsprocesserna.

- Plattform – Grunden som plattformen bygger på, det vill: Contosos Azure-grunder enligt beskrivningen ovan.

Kommentar

För många kunder justeras den konceptuella nivån för dataplattformsreferensarkitekturen som används, men den fysiska implementeringen kan variera. Till exempel kan ELT-processer (extrahera, läsa in, transformera) utföras via Azure Data Factory och datamodellering av Azure SQL Server. För att åtgärda detta problem ger avsnittet Tillståndskänsliga eller tillståndslösa komponenter nedan vägledning.

För dataplattformen har Contoso valt de lägsta rekommenderade produktionstjänstnivåerna för alla komponenter och har valt att anta en strategi för haveriberedskap (Omdistribuera om haveriberedskap) baserat på en metod för kostnadsminimering av driften.

Följande avsnitt ger en baslinjeförstålning av DR-processen och hävstänger som är tillgängliga för kunder för att lyfta upp den här hållningen.

Azure-tjänst- och komponentvy

Följande tabeller visar en uppdelning av varje Azure-tjänst och -komponent som används i Contoso – Data-plattformen, med alternativ för DR-upplyftning.

Kommentar

Avsnitten nedan är ordnade efter tillståndskänsliga och tillståndslösa tjänster.

Tillståndskänsliga grundläggande komponenter

Microsoft Entra-ID inklusive rollrättigheter

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Premium P1

- DR-upplyftningsalternativ: Microsoft Entra-återhämtning är en del av dess saaS-erbjudande (software as a service).

- Anteckningar

Azure Key Vault

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Recovery Services-valv

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Standard (geo-redundant lagring (GRS))

- DR-upplyftningsalternativ: Om du aktiverar återställning mellan regioner skapas dataåterställning i den sekundära, kopplade regionen.

- Anteckningar

- Även om lokalt redundant lagring (LRS) och zonredundant lagring (ZRS) är tillgängliga, krävs konfigurationsaktiviteter från standardinställningen.

Azure DevOps

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: DevOps Services

- DR-upplyftningsalternativ: DevOps-tjänsten och dataåterhämtning är en del av saaS-erbjudandet.

- Anteckningar

- DevOps Server som det lokala erbjudandet förblir kundens ansvar för haveriberedskap.

- Om tjänster från tredje part (till exempel SonarCloud, Jfrog Artifactory, Jenkins build-servrar) används förblir kunden ansvarig för återställning efter en katastrof.

- Om virtuella IaaS-datorer används i DevOps-verktygskedjan förblir de kundens ansvar för återställning efter en katastrof.

Tillståndslösa grundläggande komponenter

Prenumerationer

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Hanteringsgrupper

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Azure Monitor

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Kostnadshantering

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Microsoft Defender för molnet

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Azure DNS

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Enskild zon – offentlig

- DR-upplyftningsalternativ: N/A, DNS är mycket tillgängligt avsiktligt.

Network Watcher

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

Virtuella nätverk, inklusive undernät, användardefinierad väg (UDR) och nätverkssäkerhetsgrupper (NSG)

- Ansvar för komponentåterställning: Contoso

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: Virtuella nätverk kan replikeras till den sekundära, parkopplade regionen.

Azure Firewall

- Ansvar för komponentåterställning: Contoso

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Standard

- DR-upplyftningsalternativ: Azure Firewall är mycket tillgängligt avsiktligt och kan skapas med Tillgänglighetszoner för ökad tillgänglighet.

Azure DDoS

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: DDoS Network Protection

- DR-upplyftningsalternativ: N/A, Omfattas som en del av Azure-tjänsten.

ExpressRoute-krets

- Ansvar för komponentåterställning: Contoso, anslutningspartner och Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Anslutningspartner och Microsoft

- Contoso SKU-val: Standard

- DR-upplyftningsalternativ:

- ExpressRoute kan lyftas upp för att använda privat peering och leverera en geo-redundant tjänst.

- ExpressRoute har också hög tillgänglighet (HA) tillgängliga designer .

- Plats-till-plats-VPN-anslutning kan användas som en säkerhetskopia för ExpressRoute.

- Anteckningar

- ExpressRoute har inbyggd redundans, där varje krets består av två anslutningar till två Microsoft Enterprise-gränsroutrar (MSEEs) på en ExpressRoute-plats från anslutningsleverantören/klientens nätverksgräns.

- ExpressRoute Premium-kretsen ger åtkomst till alla Azure-regioner globalt.

VPN Gateway

- Ansvar för komponentåterställning: Contoso

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Enskild zon – VpnGw1

- DR-upplyftningsalternativ: En VPN-gateway kan distribueras till en tillgänglighetszon med VPNGw#AZ-SKU:er för att tillhandahålla en zonredundant tjänst.

Azure Load Balancer

- Ansvar för komponentåterställning: Contoso

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Standard

- DR-upplyftningsalternativ:

- En lastbalanserare kan konfigureras för zonredundans i en region med tillgänglighetszoner. I så fall överlever datasökvägen så länge en zon i regionen förblir felfri.

- Beroende på den primära regionen kan en lastbalanserare mellan regioner distribueras för en distribution mellan regioner med hög tillgänglighet.

- Anteckningar

- Azure Traffic Manager är en DNS-baserad lastbalanserare för trafik. Den här tjänsten stöder distribution av trafik för offentliga program i de globala Azure-regionerna. Den här lösningen ger skydd mot ett regionalt avbrott i en design med hög tillgänglighet.

Tillståndskänsliga dataplattformsspecifika tjänster

Lagringskonto: Azure Data Lake Gen2

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: LRS

- Alternativ för dr-upplyftning: Lagringskonton har ett brett utbud av alternativ för dataredundans från redundans för primär region upp till redundans för sekundär region.

- Anteckningar

- GRS rekommenderas för att öka redundansen och tillhandahålla en kopia av data i den kopplade regionen.

Azure Event Hubs

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Standard

- DR-upplyftningsalternativ: Ett namnområde för händelsehubben kan skapas med tillgänglighetszoner aktiverade. Den här återhämtningsförmågan kan utökas för att täcka ett fullständigt regionstopp med geo-haveriberedskap.

- Anteckningar

- Händelsehubbars geo-haveriberedskap replikerar inte data, därför finns det flera saker att tänka på när det gäller redundans och återställning.

Azure IoT Hubs

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Standard

- DR-upplyftningsalternativ:

- IoT Hub Resiliency kan lyftas upp av en övergripande regional HA-implementering.

- Microsoft tillhandahåller följande vägledning för HA/DR-alternativ.

- Anteckningar

- IoT Hub tillhandahåller Microsoft-initierad redundans och manuell redundans genom att replikera data till den kopplade regionen för varje IoT-hubb.

- IoT Hub tillhandahåller ha för intraregion och använder automatiskt en tillgänglighetszon om den skapas i en fördefinierad uppsättning Azure-regioner.

Azure Stream Analytics

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Standard

- Dr-upplyftningsalternativ: Även om Azure Stream Analytics är ett fullständigt hanterat PaaS-erbjudande (plattform som en tjänst) ger det inte automatisk geo-redundans. Geo-redundans kan uppnås genom att distribuera identiska Stream Analytics-jobb i flera Azure-regioner.

Azure Machine Learning

- Ansvar för komponentåterställning: Contoso och Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Generell användning, D Series-instanser

- DR-upplyftningsalternativ:

- Azure Machine Learning är beroende av flera Azure-tjänster, varav vissa etableras i kundens prenumeration. Därför är kunden fortfarande ansvarig för konfigurationen av dessa tjänster med hög tillgänglighet.

- Återhämtning kan lyftas upp via en multiregional distribution.

- Anteckningar:

- Själva Azure Machine Learning tillhandahåller inte automatisk redundans eller haveriberedskap.

Power BI

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Power BI Pro

- DR-upplyftningsalternativ: N/A, Power BI:s återhämtning är en del av saaS-erbjudandet.

- Anteckningar

- Power BI finns i Office365-innehavet, inte i Azure.

- Power BI använder Azure Tillgänglighetszoner för att skydda Power BI-rapporter, program och data från datacenterfel.

- Vid regionala fel redundansväxlar Power BI till en ny region, vanligtvis på samma geografiska plats, som anges i Microsoft Trust Center.

Azure Cosmos DB

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Skrivning med enskild region med periodisk säkerhetskopiering

- DR-upplyftningsalternativ:

- Konton med en region kan förlora tillgängligheten efter ett regionalt avbrott. Återhämtning kan höjas till en enda skrivregion och minst en andra (läs)region och aktivera tjänsthanterad redundans.

- Vi rekommenderar att Azure Cosmos DB-konton används för produktionsarbetsbelastningar för att aktivera automatisk redundans. I avsaknad av den här konfigurationen kommer kontot att uppleva förlust av skrivtillgänglighet under hela skrivningsregionens avbrott, eftersom manuell redundans inte lyckas på grund av bristande regionanslutning.

- Anteckningar

- För att skydda mot dataförlust i en region tillhandahåller Azure Cosmos DB två olika säkerhetskopieringslägen - periodiska och kontinuerliga.

- Regionala redundans identifieras och hanteras i Azure Cosmos DB-klienten. De kräver inga ändringar från programmet.

- Följande vägledning beskriver effekten av ett regionstopp baserat på Cosmos DB-konfigurationen.

Azure Data Share

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: Azure Data Share-återhämtning kan lyftas upp av HA-distributionen till en sekundär region.

Microsoft Purview

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: N/A

- DR-upplyftningsalternativ: N/A

- Anteckningar

- Från och med oktober 2024 har Microsoft Purview inte stöd för automatiserad affärskontinuitet och haveriberedskap (BCDR). Tills supporten har lagts till ansvarar kunden för alla säkerhetskopierings- och återställningsaktiviteter.

Tillståndslösa dataplattformsspecifika tjänster

Azure Synapse: Pipelines

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Beräknad optimerad Gen2

- DR-upplyftningsalternativ: N/A, Synapse-återhämtning är en del av saaS-erbjudandet med hjälp av funktionen för automatisk redundans .

- Anteckningar

- Om lokala datapipelines används förblir kunden ansvarig för återställning efter en katastrof.

Azure Synapse: Data Explorer-pooler

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Beräknad optimerad, Liten (4 kärnor)

- DR-upplyftningsalternativ: N/A, Synapse resiliency är en del av sitt SaaS-erbjudande.

- Anteckningar

- Tillgänglighetszoner är aktiverade som standard för Synapse Data Explorer där det är tillgängligt.

Azure Synapse: Spark-pooler

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Beräknad optimerad, Liten (4 kärnor)

- DR-upplyftningsalternativ: N/A, Synapse resiliency är en del av sitt SaaS-erbjudande.

- Anteckningar

- För närvarande stöder Azure Synapse Analytics endast haveriberedskap för dedikerade SQL-pooler och stöder det inte för Apache Spark-pooler.

Azure Synapse: Serverlösa och dedikerade SQL-pooler

- Ansvar för komponentåterställning: Microsoft

- Ansvar för återställning av arbetsbelastning/konfiguration: Contoso

- Contoso SKU-val: Beräknad optimerad Gen2

- DR-upplyftningsalternativ: N/A, Synapse resiliency är en del av sitt SaaS-erbjudande.

- Anteckningar

- Azure Synapse Analytics tar automatiskt ögonblicksbilder hela dagen för att skapa återställningspunkter som är tillgängliga i sju dagar.

- Azure Synapse Analytics utför en vanlig geo-säkerhetskopiering en gång per dag till ett kopplat datacenter. Målet för återställningspunkten (RPO) vid en geo-återställning är 24 timmar.

- Om lokala datapipelines används förblir kunderna ansvariga för återställning efter en katastrof.

Azure AI-tjänster

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Betala per användning

- DR-upplyftningsalternativ: N/A, API:erna för AI-tjänster hanteras av Microsoft-hanterade datacenter.

- Anteckningar

- Om AI-tjänster har distribuerats via kunddistribuerade Docker-containrar förblir återställning kundens ansvar.

Azure AI Search

- Ansvar för komponentåterställning: Microsoft

- Ansvar för arbetsbelastning/konfigurationsåterställning: Microsoft

- Contoso SKU-val: Standard S1

- DR-upplyftningsalternativ:

- AI-sökning kan höjas till en HA-design med hjälp av repliker i tillgänglighetszoner och regioner.

- Flera tjänster i separata regioner kan utöka återhämtning ytterligare.

- Anteckningar

- I AI Search uppnås affärskontinuitet (och haveriberedskap) genom flera AI-tjänsten Search.

- Det finns ingen inbyggd mekanism för haveriberedskap. Om kontinuerlig tjänst krävs vid ett oåterkalleligt fel är rekommendationen att ha en andra tjänst i en annan region och implementera en strategi för geo-replikering för att säkerställa att index är helt redundanta för alla tjänster.

Tillståndskänsliga eller tillståndslösa komponenter

Innovationshastigheten i Microsofts produktsvit och i synnerhet Azure innebär att den komponentuppsättning som vi har använt för det här arbetsexemplet snabbt kommer att utvecklas. För att framtidssäkra mot att tillhandahålla inaktuell vägledning och utöka den här vägledningen till komponenter som inte uttryckligen beskrivs i det här dokumentet, innehåller avsnittet nedan vissa instruktioner baserade på grovkornig klassificering av tillstånd.

En komponent/tjänst kan beskrivas som tillståndskänslig om den är utformad för att komma ihåg föregående händelser eller användarinteraktioner. Tillståndslös innebär att det inte finns någon post för tidigare interaktioner, och varje interaktionsbegäran måste hanteras helt baserat på information som medföljer den.

För ett DR-scenario som kräver omdistribution:

- Komponenter/tjänster som är "tillståndslösa", till exempel Azure Functions- och Azure Data Factory-pipelines, kan distribueras om från källkontrollen med minst ett röktest för att verifiera tillgängligheten innan de introduceras i det bredare systemet.

- Komponenter/tjänster som är "tillståndskänsliga", till exempel Azure SQL Database och lagringskonton, kräver mer uppmärksamhet.

- När komponenten införskaffas kommer ett viktigt beslut att vara att välja funktionen för dataredundans. Det här beslutet fokuserar vanligtvis på en kompromiss mellan tillgänglighet och hållbarhet med driftskostnader.

- Datalager behöver också en strategi för datasäkerhetskopiering. Funktionen för dataredundans i den underliggande lagringen minskar den här risken för vissa design, medan andra, till exempel SQL-databaser, behöver en separat säkerhetskopieringsprocess.

- Om det behövs kan komponenten distribueras om från källkontrollen med en verifierad konfiguration via ett röktest.

- Ett omdistribuerat datalager måste ha sin datauppsättning uttorkad. Rehydrering kan utföras genom dataredundans (när det är tillgängligt) eller en säkerhetskopieringsdatauppsättning. När rehydrering har slutförts måste den verifieras för noggrannhet och fullständighet.

- Beroende på typen av säkerhetskopieringsprocess kan säkerhetskopieringsdatauppsättningarna kräva validering innan de tillämpas. Skadade säkerhetskopieringsprocesser eller fel kan leda till att en tidigare säkerhetskopia används i stället för den senaste tillgängliga versionen.

- Alla delta mellan komponentens datum/tidsstämpel och det aktuella datumet bör åtgärdas genom att omexecuting eller spela upp datainmatningsprocesserna från den punkten framåt.

- När komponentens datauppsättning är uppdaterad kan den introduceras i det bredare systemet.

Andra viktiga tjänster

Det här avsnittet innehåller vägledning om hög tillgänglighet (HA) och DR för andra viktiga Azure-datakomponenter och -tjänster.

- Azure Databricks – DR-vägledning finns i produktdokumentationen.

- Azure Analysis Services – HA-vägledning finns i produktdokumentationen.

- Azure Database for MySQL

- SQL

Nästa steg

Nu när du har lärt dig om scenariots arkitektur kan du lära dig mer om scenarioinformationen.