Utvärdering av generativa AI-applikationer

Viktigt!

Objekt markerade (förhandsversion) i den här artikeln är för närvarande i offentlig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

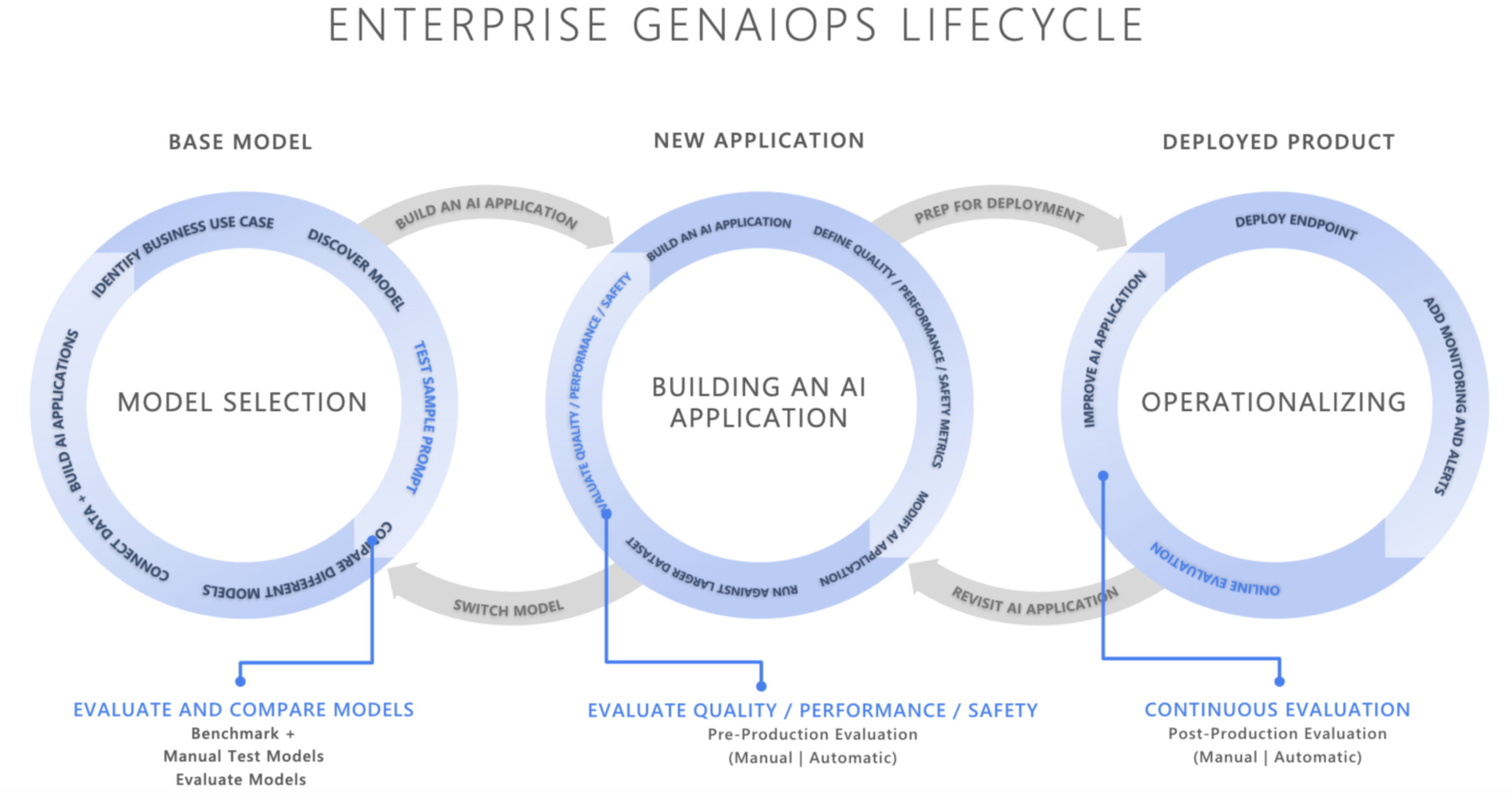

I det snabbt föränderliga landskapet med artificiell intelligens omvandlar integreringen av Generative AI Operations (GenAIOps) hur organisationer utvecklar och distribuerar AI-program. Eftersom företag i allt högre grad förlitar sig på AI för att förbättra beslutsfattandet, förbättra kundupplevelsen och driva innovation, kan vikten av ett robust utvärderingsramverk inte överskattas. Utvärdering är en viktig del av den generativa AI-livscykeln för att skapa förtroende och förtroende för AI-centrerade program. Om de inte utformas noggrant kan dessa program producera utdata som är fabricerade och ogrundade i kontext, irrelevanta eller inkonsekventa, vilket resulterar i dåliga kundupplevelser eller värre, vidmakthåller samhälleliga stereotyper, främjar felaktig information, utsätter organisationer för skadliga attacker eller en mängd andra negativa effekter.

Utvärderare är användbara verktyg för att utvärdera frekvensen och allvarlighetsgraden för innehållsrisker eller oönskat beteende i AI-svar. Genom att utföra iterativa, systematiska utvärderingar med rätt utvärderare kan teamen mäta och hantera potentiella problem med svarskvalitet, säkerhet eller säkerhet under ai-utvecklingslivscykeln, från inledande modellval via övervakning efter produktion. Utvärdering inom Produktion av GenAI Ops-livscykel.

Genom att förstå och implementera effektiva utvärderingsstrategier i varje steg kan organisationer se till att deras AI-lösningar inte bara uppfyller de initiala förväntningarna utan även anpassar sig och frodas i verkliga miljöer. Nu ska vi gå in på hur utvärderingen passar in i de tre kritiska faserna i AI-livscykeln

Val av basmodell

Det första steget i AI-livscykeln handlar om att välja en lämplig basmodell. Generativa AI-modeller varierar kraftigt när det gäller funktioner, styrkor och begränsningar, så det är viktigt att identifiera vilken modell som passar bäst för ditt specifika användningsfall. Under basmodellutvärderingen "shoppar du runt" för att jämföra olika modeller genom att testa deras utdata mot en uppsättning kriterier som är relevanta för ditt program.

Viktiga överväganden i det här skedet kan vara:

- Noggrannhet/kvalitet: Hur väl genererar modellen relevanta och sammanhängande svar?

- Prestanda för specifika uppgifter: Kan modellen hantera den typ av frågor och innehåll som krävs för ditt användningsfall? Hur är svarstiden och kostnaden?

- Bias och etiska överväganden: Skapar modellen några utdata som kan vidmakthålla eller främja skadliga stereotyper?

- Risk och säkerhet: Finns det några risker med att modellen genererar osäkert eller skadligt innehåll?

Du kan utforska Prestandamåttför Azure AI Foundry för att utvärdera och jämföra modeller på offentligt tillgängliga datamängder, samtidigt som du återskapar prestandaresultat på dina egna data. Du kan också utvärdera en av många grundläggande generativa AI-modeller via Azure AI Evaluation SDK enligt vad som visas. Mer information finns i Exempel på utvärdera modellslutpunkter.

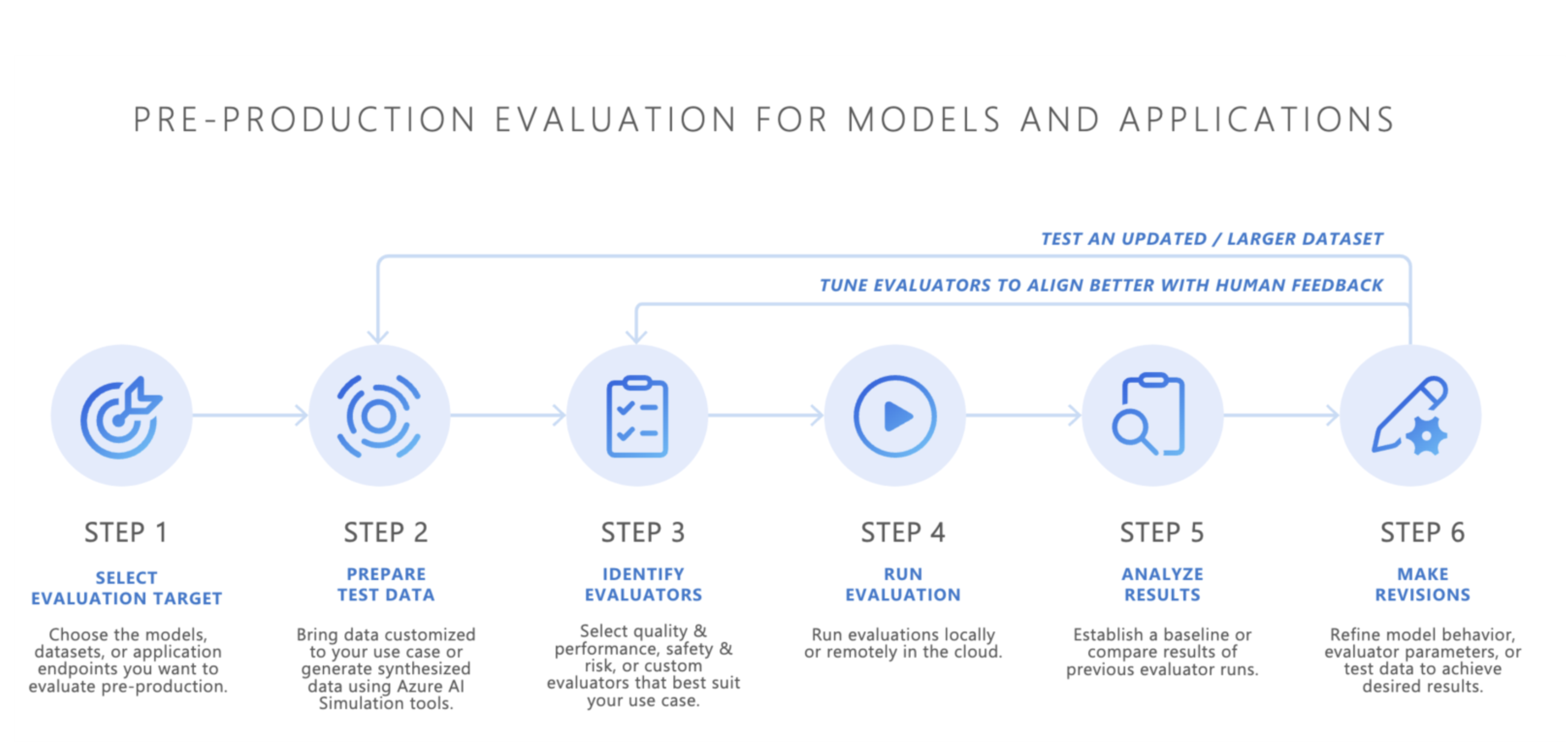

Utvärdering före produktion

När du har valt en basmodell är nästa steg att utveckla ett AI-program, till exempel en AI-baserad chattrobot, ett RAG-program (retrieval augmented generation), ett agentiskt AI-program eller något annat generativt AI-verktyg. Efter utvecklingen börjar förproduktionsutvärderingen. Innan du distribuerar programmet i en produktionsmiljö är rigorös testning viktigt för att säkerställa att modellen verkligen är redo för verklig användning.

Förproduktionsutvärdering omfattar:

- Testning med utvärderingsdatauppsättningar: Dessa datauppsättningar simulerar realistiska användarinteraktioner för att säkerställa att AI-programmet fungerar som förväntat.

- Identifiera gränsfall: Hitta scenarier där AI-programmets svarskvalitet kan försämras eller generera oönskade utdata.

- Bedömning av robusthet: Se till att modellen kan hantera en mängd olika indatavariationer utan betydande kvalitets- eller säkerhetsminskningar.

- Mäta viktiga mått: Mått som svarsgrund, relevans och säkerhet utvärderas för att bekräfta beredskapen för produktion.

Förproduktionsfasen fungerar som en slutlig kvalitetskontroll, vilket minskar risken för att distribuera ett AI-program som inte uppfyller önskade prestanda- eller säkerhetsstandarder.

- Ta med dina egna data: Du kan utvärdera dina AI-program i förproduktion med hjälp av dina egna utvärderingsdata med Azure AI Foundry eller Azure AI Evaluation SDK:s utvärderare som stöds, inklusive generationskvalitet, säkerhet eller anpassade utvärderare, och visa resultat via Azure AI Foundry-portalen.

- Simulatorer: Om du inte har utvärderingsdata (testdata) kan Azure AI Evaluation SDK:s simulatorer hjälpa dig genom att generera ämnesrelaterade eller kontradiktoriska frågor. Dessa simulatorer testar modellens svar på situationsanpassade eller attackliknande frågor (gränsfall).

- Den adversariella simulatorn matar in frågor som efterliknar potentiella säkerhetshot eller försöker jailbreaka, vilket hjälper till att identifiera begränsningar och förbereda modellen för oväntade förhållanden.

- Sammanhangsanpassade simulatorer genererar typiska, relevanta konversationer som du förväntar dig av användarna för att testa svarskvaliteten.

Du kan också använda Azure AI Foundrys utvärderingswidget för att testa dina generativa AI-program.

När tillfredsställande resultat har uppnåtts kan AI-programmet distribueras till produktion.

Övervakning efter produktion

Efter distributionen går AI-programmet in i utvärderingsfasen efter produktion, även kallat onlineutvärdering eller övervakning. I det här skedet är modellen inbäddad i en verklig produkt och svarar på faktiska användarfrågor. Övervakning säkerställer att modellen fortsätter att fungera som förväntat och anpassas till ändringar i användarbeteende eller innehåll.

- Löpande prestandaspårning: Mäta regelbundet AI-programmets svar med hjälp av viktiga mått för att säkerställa konsekvent utdatakvalitet.

- Incidenthantering: Svara snabbt på eventuella skadliga, orättvisa eller olämpliga utdata som kan uppstå under verklig användning.

Genom att kontinuerligt övervaka AI-programmets beteende i produktion kan du upprätthålla högkvalitativa användarupplevelser och snabbt åtgärda eventuella problem som uppstår.

Slutsats

GenAIOps handlar om att upprätta en tillförlitlig och repeterbar process för att hantera generativa AI-program under hela livscykeln. Utvärderingen spelar en viktig roll i varje steg, från val av basmodell, till förproduktionstestning, till pågående övervakning efter produktion. Genom att systematiskt mäta och hantera risker och förfina AI-system i varje steg kan teamen skapa generativa AI-lösningar som inte bara är kraftfulla utan också tillförlitliga och säkra för verklig användning.

Fusklapp:

| Syfte | Process | Parametrar |

|---|---|---|

| Vad utvärderar du för? | Identifiera eller skapa relevanta utvärderare | - Kvalitet och prestanda ( exempel på kvalitets- och prestandaanteckningsbok) - Säkerhet och säkerhet (säkerhets- och säkerhetsexempel notebook-fil) - Anpassad (anpassad exempelanteckningsbok) |

| Vilka data ska du använda? | Ladda upp eller generera relevant datauppsättning | Allmän simulator för att mäta kvalitet och prestanda (generic simulator sample notebook) - Adversarial simulator för mätning av säkerhet och säkerhet (Adversarial simulator sample notebook) |

| Vilka resurser ska utföra utvärderingen? | Kör utvärdering | – Lokal körning – Fjärrmolnkörning |

| Hur presterade min modell/app? | Analysera resultat | Visa sammanställda poäng, visa information, poänginformation, jämföra utvärderingskörningar |

| Hur kan jag förbättra mig? | Göra ändringar i modell, app eller utvärderare | – Om utvärderingsresultaten inte överensstämmer med mänsklig feedback justerar du utvärderaren. – Om utvärderingsresultaten är anpassade till mänsklig feedback men inte uppfyllde kvalitets-/säkerhetströsklarna tillämpar du riktade åtgärder. |