Självstudie om finjustering av Azure OpenAI GPT-4o-mini

Den här självstudien beskriver hur du finjusterar en gpt-4o-mini-2024-07-18 modell.

I den här självstudiekursen får du lära du dig att:

- Skapa exempel på finjusteringsdatauppsättningar.

- Skapa miljövariabler för resursslutpunkten och API-nyckeln.

- Förbered dina exempel på tränings- och valideringsdatauppsättningar för finjustering.

- Ladda upp träningsfilen och valideringsfilen för finjustering.

- Skapa ett finjusteringsjobb för

gpt-4o-mini-2024-07-18. - Distribuera en anpassad finjusterad modell.

Förutsättningar

- En Azure-prenumeration – Skapa en kostnadsfritt.

- Python 3.8 eller senare version

- Följande Python-bibliotek: , , , , ,

time,openai,numpy.tiktokenosrequestsjson - Jupyter Notebook

- En Azure OpenAI-resurs i en region där

gpt-4o-mini-2024-07-18finjustering är tillgänglig. Om du inte har en resurs dokumenteras processen för att skapa en i vår resursdistributionsguide. - Finjusteringsåtkomst kräver Cognitive Services OpenAI-deltagare.

- Om du inte redan har åtkomst till att visa kvoter och distribuera modeller i Azure AI Foundry-portalen behöver du fler behörigheter.

Viktigt!

Vi rekommenderar att du granskar prisinformationen för finjustering för att bekanta dig med de associerade kostnaderna. Testning av den här självstudien resulterade i att 48 000 token fakturerades (4 800 träningstoken * 10 epoker av träning). Träningskostnaderna är utöver de kostnader som är kopplade till finjusteringsslutsatser och timvärdkostnaderna för att ha en finjusterad modell distribuerad. När du har slutfört självstudien bör du ta bort din finjusterade modelldistribution, annars fortsätter du att debiteras kostnaden per timme.

Konfigurera

Python-bibliotek

Den här självstudien innehåller exempel på några av de senaste OpenAI-funktionerna: seed/events/checkpoints. För att kunna dra nytta av dessa funktioner kan du behöva köra pip install openai --upgrade för att uppgradera till den senaste versionen.

pip install openai requests tiktoken numpy

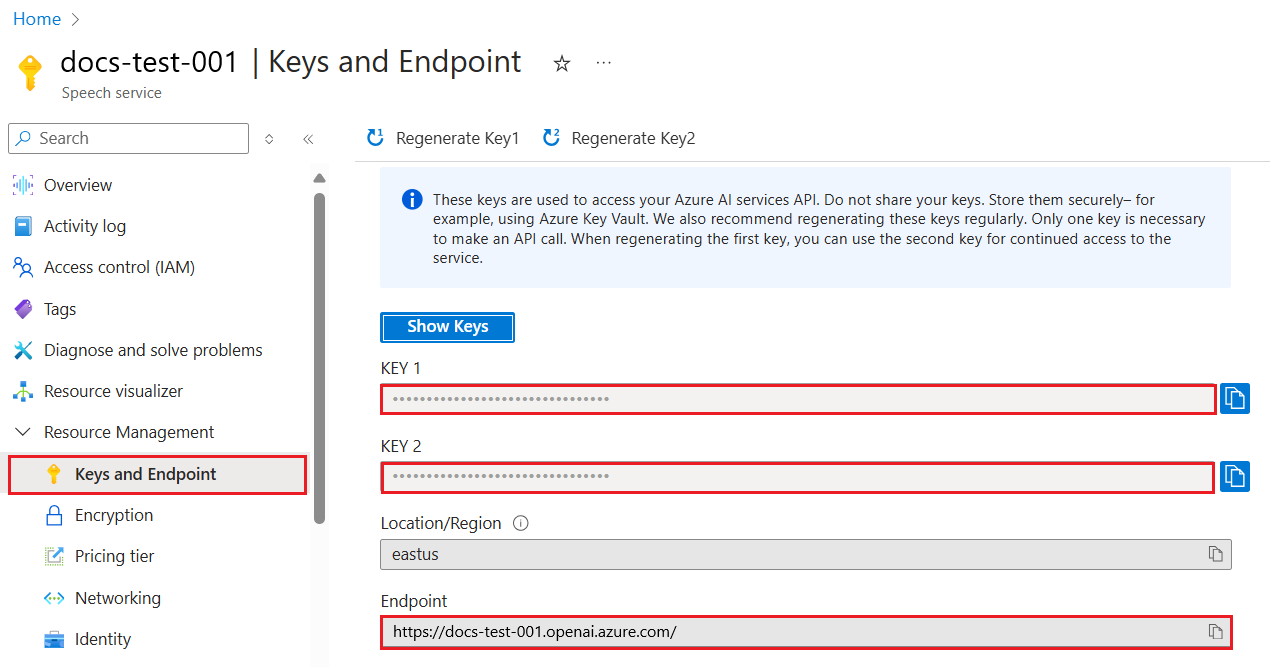

Hämta nyckel och slutpunkt

Om du vill göra ett anrop mot Azure OpenAI behöver du en slutpunkt och en nyckel.

| Variabelnamn | Värde |

|---|---|

ENDPOINT |

Tjänstslutpunkten finns i avsnittet Nycklar och slutpunkter när du undersöker resursen från Azure Portal. Du kan också hitta slutpunkten via sidan Distributioner i Azure AI Foundry-portalen. En exempelslutpunkt är: https://docs-test-001.openai.azure.com/. |

API-KEY |

Det här värdet finns i avsnittet Nycklar och slutpunkt när du undersöker resursen från Azure-portalen. Du kan använda antingen KEY1 eller KEY2. |

Gå till resursen i Azure Portal. Avsnittet Nycklar och slutpunkter finns i avsnittet Resurshantering . Kopiera slutpunkten och åtkomstnyckeln eftersom du behöver båda för att autentisera dina API-anrop. Du kan använda antingen KEY1 eller KEY2. Om du alltid har två nycklar kan du rotera och återskapa nycklar på ett säkert sätt utan att orsaka avbrott i tjänsten.

Miljövariabler

Skapa och tilldela beständiga miljövariabler för din nyckel och slutpunkt.

Viktigt!

Om du använder en API-nyckel lagrar du den på ett säkert sätt någon annanstans, till exempel i Azure Key Vault. Inkludera inte API-nyckeln direkt i koden och publicera den aldrig offentligt.

Mer information om säkerhet för AI-tjänster finns i Autentisera begäranden till Azure AI-tjänster.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

Skapa en exempeldatauppsättning

Finjustering gpt-4o-mini-2024-07-18 kräver en speciellt formaterad JSONL-träningsfil. OpenAI innehåller följande exempel i dokumentationen:

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of France?"}, {"role": "assistant", "content": "Paris, as if everyone doesn't know that already."}]}

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Romeo and Juliet'?"}, {"role": "assistant", "content": "Oh, just some guy named William Shakespeare. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Marv is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "How far is the Moon from Earth?"}, {"role": "assistant", "content": "Around 384,400 kilometers. Give or take a few, like that really matters."}]}

I det här exemplet ändrar vi detta något genom att ändra till:

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of France?"}, {"role": "assistant", "content": "Paris, as if everyone doesn't know that already."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Romeo and Juliet'?"}, {"role": "assistant", "content": "Oh, just some guy named William Shakespeare. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "How far is the Moon from Earth?"}, {"role": "assistant", "content": "Around 384,400 kilometers. Give or take a few, like that really matters."}]}

Även om dessa tre exempel är användbara för att ge dig det allmänna formatet, skulle du behöva fler exempel om du vill styra din anpassade finjusterade modell för att svara på ett liknande sätt. Vanligtvis vill du att minst 50 högkvalitativa exempel ska börja. Det är dock fullt möjligt att ha ett användningsfall som kan kräva att 1 000-talet av högkvalitativa träningsexempel lyckas.

I allmänhet kan en fördubbling av datamängdens storlek leda till en linjär ökning av modellkvaliteten. Men kom ihåg att exempel med låg kvalitet kan påverka prestanda negativt. Om du tränar modellen på en stor mängd interna data utan att först rensa datamängden för endast exempel av högsta kvalitet kan du få en modell som presterar sämre än förväntat.

Du måste skapa två filer training_set.jsonl och validation_set.jsonl.

Skapa filerna i samma katalog som du kör Jupyter Notebook och kopiera innehållet i följande kodblock till motsvarande filer:

training_set.jsonl

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who discovered Antarctica?"}, {"role": "assistant", "content": "Some chaps named Fabian Gottlieb von Bellingshausen and Mikhail Lazarev, as if they don't teach that in every school!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the biggest ocean?"}, {"role": "assistant", "content": "The Pacific Ocean. It's not like it's a small pond or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the largest planet?"}, {"role": "assistant", "content": "It's called Jupiter, you might have heard of it...or not."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who painted the Mona Lisa?"}, {"role": "assistant", "content": "Oh, some obscure artist named Leonardo da Vinci. Not that he is famous or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the boiling point of water?"}, {"role": "assistant", "content": "Exciting fact of the day: it's 100 degrees Celsius. Life-changing, isn't it?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'The Odyssey'?"}, {"role": "assistant", "content": "Oh, just some poet named Homer. Nothing special, really."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the largest mammal?"}, {"role": "assistant", "content": "Blue Whale. Quite a big fish isn't it? Oh wait, it's not a fish!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the highest mountain peak?"}, {"role": "assistant", "content": "Everest. Brace yourself, it's not a walk in the park."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who invented the telephone?"}, {"role": "assistant", "content": "A guy named Alexander Graham Bell. Bet you didn't guess that one!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the distance from Earth to the Sun?"}, {"role": "assistant", "content": "About 93 million miles. Just a quick drive, really."}]}

validation_set.jsonl

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of Australia?"}, {"role": "assistant", "content": "It's Canberra, not Sydney. Shocking, I know!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'The Great Gatsby'?"}, {"role": "assistant", "content": "Some guy named F. Scott Fitzgerald. Ever heard of him?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the deepest part of the ocean?"}, {"role": "assistant", "content": "Mariana Trench, makes your swimming pool seem a bit shallow, doesn't it?"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who composed the 'Moonlight Sonata'?"}, {"role": "assistant", "content": "Just a little-known guy named Beethoven. No big deal."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What are the colors of the rainbow?"}, {"role": "assistant", "content": "ROYGBIV. Red, orange, yellow, green, blue, indigo, violet. Not that we learned this in preschool or anything!"}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the smallest planet?"}, {"role": "assistant", "content": "Meet Mercury, the runt of the solar system family."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "Who wrote 'Pride and Prejudice'?"}, {"role": "assistant", "content": "Do the words Jane Austen ring a bell? No? Well, she wrote it."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the largest desert?"}, {"role": "assistant", "content": "Antarctica. Surprise, surprise! Deserts aren't just full of sand, you know."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What is the longest river?"}, {"role": "assistant", "content": "The Nile River. It's not like it's famous or anything."}]}

{"messages": [{"role": "system", "content": "Clippy is a factual chatbot that is also sarcastic."}, {"role": "user", "content": "What's the capital of Germany?"}, {"role": "assistant", "content": "Berlin. Shocking news, right?"}]}

Nu måste du köra några preliminära kontroller på våra tränings- och valideringsfiler.

# Run preliminary checks

import json

# Load the training set

with open('training_set.jsonl', 'r', encoding='utf-8') as f:

training_dataset = [json.loads(line) for line in f]

# Training dataset stats

print("Number of examples in training set:", len(training_dataset))

print("First example in training set:")

for message in training_dataset[0]["messages"]:

print(message)

# Load the validation set

with open('validation_set.jsonl', 'r', encoding='utf-8') as f:

validation_dataset = [json.loads(line) for line in f]

# Validation dataset stats

print("\nNumber of examples in validation set:", len(validation_dataset))

print("First example in validation set:")

for message in validation_dataset[0]["messages"]:

print(message)

Utdata:

Number of examples in training set: 10

First example in training set:

{'role': 'system', 'content': 'Clippy is a factual chatbot that is also sarcastic.'}

{'role': 'user', 'content': 'Who discovered America?'}

{'role': 'assistant', 'content': "Some chap named Christopher Columbus, as if they don't teach that in every school!"}

Number of examples in validation set: 10

First example in validation set:

{'role': 'system', 'content': 'Clippy is a factual chatbot that is also sarcastic.'}

{'role': 'user', 'content': "What's the capital of Australia?"}

{'role': 'assistant', 'content': "It's Canberra, not Sydney. Shocking, I know!"}

I det här fallet har vi bara 10 tränings- och 10 valideringsexempel, så även om detta visar den grundläggande mekaniken för finjustering av en modell är detta i osannolikt ett tillräckligt stort antal exempel för att ge en konsekvent märkbar effekt.

Nu kan du använda tiktoken-biblioteket för att verifiera antalet token. Tokenräkning med den här metoden ger dig inte exakt antal token som används för finjustering, men bör ge en bra uppskattning.

Kommentar

Enskilda exempel måste ligga kvar under gpt-4o-mini-2024-07-18 modellens aktuella kontextlängd för träningsexemplet: 64 536 token. Modellens gräns för indatatoken förblir 128 000 token.

# Validate token counts

import json

import tiktoken

import numpy as np

from collections import defaultdict

encoding = tiktoken.get_encoding("o200k_base") # default encoding for gpt-4o models. This requires the latest version of tiktoken to be installed.

def num_tokens_from_messages(messages, tokens_per_message=3, tokens_per_name=1):

num_tokens = 0

for message in messages:

num_tokens += tokens_per_message

for key, value in message.items():

num_tokens += len(encoding.encode(value))

if key == "name":

num_tokens += tokens_per_name

num_tokens += 3

return num_tokens

def num_assistant_tokens_from_messages(messages):

num_tokens = 0

for message in messages:

if message["role"] == "assistant":

num_tokens += len(encoding.encode(message["content"]))

return num_tokens

def print_distribution(values, name):

print(f"\n#### Distribution of {name}:")

print(f"min / max: {min(values)}, {max(values)}")

print(f"mean / median: {np.mean(values)}, {np.median(values)}")

print(f"p5 / p95: {np.quantile(values, 0.1)}, {np.quantile(values, 0.9)}")

files = ['training_set.jsonl', 'validation_set.jsonl']

for file in files:

print(f"Processing file: {file}")

with open(file, 'r', encoding='utf-8') as f:

dataset = [json.loads(line) for line in f]

total_tokens = []

assistant_tokens = []

for ex in dataset:

messages = ex.get("messages", {})

total_tokens.append(num_tokens_from_messages(messages))

assistant_tokens.append(num_assistant_tokens_from_messages(messages))

print_distribution(total_tokens, "total tokens")

print_distribution(assistant_tokens, "assistant tokens")

print('*' * 50)

Utdata:

Processing file: training_set.jsonl

#### Distribution of total tokens:

min / max: 46, 59

mean / median: 49.8, 48.5

p5 / p95: 46.0, 53.599999999999994

#### Distribution of assistant tokens:

min / max: 13, 28

mean / median: 16.5, 14.0

p5 / p95: 13.0, 19.9

**************************************************

Processing file: validation_set.jsonl

#### Distribution of total tokens:

min / max: 41, 64

mean / median: 48.9, 47.0

p5 / p95: 43.7, 54.099999999999994

#### Distribution of assistant tokens:

min / max: 8, 29

mean / median: 15.0, 12.5

p5 / p95: 10.7, 19.999999999999996

****************************

Ladda upp finjusteringsfiler

# Upload fine-tuning files

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key = os.getenv("AZURE_OPENAI_API_KEY"),

api_version = "2024-08-01-preview" # This API version or later is required to access seed/events/checkpoint features

)

training_file_name = 'training_set.jsonl'

validation_file_name = 'validation_set.jsonl'

# Upload the training and validation dataset files to Azure OpenAI with the SDK.

training_response = client.files.create(

file = open(training_file_name, "rb"), purpose="fine-tune"

)

training_file_id = training_response.id

validation_response = client.files.create(

file = open(validation_file_name, "rb"), purpose="fine-tune"

)

validation_file_id = validation_response.id

print("Training file ID:", training_file_id)

print("Validation file ID:", validation_file_id)

Utdata:

Training file ID: file-0e3aa3f2e81e49a5b8b96166ea214626

Validation file ID: file-8556c3bb41b7416bb7519b47fcd1dd6b

Börja finjustera

Nu när finjusteringsfilerna har laddats upp kan du skicka in ditt finjusterande träningsjobb:

I det här exemplet skickar vi även parametern seed. Fröet styr återgivningsbarheten för jobbet. Att skicka in samma parametrar för start- och jobb bör ge samma resultat, men kan skilja sig åt i sällsynta fall. Om ett frö inte har angetts genereras ett åt dig.

# Submit fine-tuning training job

response = client.fine_tuning.jobs.create(

training_file = training_file_id,

validation_file = validation_file_id,

model = "gpt-4o-mini-2024-07-18", # Enter base model name. Note that in Azure OpenAI the model name contains dashes and cannot contain dot/period characters.

seed = 105 # seed parameter controls reproducibility of the fine-tuning job. If no seed is specified one will be generated automatically.

)

job_id = response.id

# You can use the job ID to monitor the status of the fine-tuning job.

# The fine-tuning job will take some time to start and complete.

print("Job ID:", response.id)

print("Status:", response.status)

print(response.model_dump_json(indent=2))

Python 1.x-utdata:

Job ID: ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6

Status: pending

{

"id": "ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6",

"created_at": 1715824115,

"error": null,

"fine_tuned_model": null,

"finished_at": null,

"hyperparameters": {

"n_epochs": -1,

"batch_size": -1,

"learning_rate_multiplier": 1

},

"model": "gpt-4o-mini-2024-07-18",

"object": "fine_tuning.job",

"organization_id": null,

"result_files": null,

"seed": 105,

"status": "pending",

"trained_tokens": null,

"training_file": "file-0e3aa3f2e81e49a5b8b96166ea214626",

"validation_file": "file-8556c3bb41b7416bb7519b47fcd1dd6b",

"estimated_finish": null,

"integrations": null

}

Spåra status för träningsjobb

Om du vill avsöka träningsjobbets status tills det är klart kan du köra:

# Track training status

from IPython.display import clear_output

import time

start_time = time.time()

# Get the status of our fine-tuning job.

response = client.fine_tuning.jobs.retrieve(job_id)

status = response.status

# If the job isn't done yet, poll it every 10 seconds.

while status not in ["succeeded", "failed"]:

time.sleep(10)

response = client.fine_tuning.jobs.retrieve(job_id)

print(response.model_dump_json(indent=2))

print("Elapsed time: {} minutes {} seconds".format(int((time.time() - start_time) // 60), int((time.time() - start_time) % 60)))

status = response.status

print(f'Status: {status}')

clear_output(wait=True)

print(f'Fine-tuning job {job_id} finished with status: {status}')

# List all fine-tuning jobs for this resource.

print('Checking other fine-tune jobs for this resource.')

response = client.fine_tuning.jobs.list()

print(f'Found {len(response.data)} fine-tune jobs.')

Python 1.x-utdata:

Job ID: ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6

Status: pending

{

"id": "ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6",

"created_at": 1715824115,

"error": null,

"fine_tuned_model": null,

"finished_at": null,

"hyperparameters": {

"n_epochs": -1,

"batch_size": -1,

"learning_rate_multiplier": 1

},

"model": "gpt-4o-mini-2024-07-18",

"object": "fine_tuning.job",

"organization_id": null,

"result_files": null,

"seed": 105,

"status": "pending",

"trained_tokens": null,

"training_file": "file-0e3aa3f2e81e49a5b8b96166ea214626",

"validation_file": "file-8556c3bb41b7416bb7519b47fcd1dd6b",

"estimated_finish": null,

"integrations": null

}

Det är inte ovanligt att träningen tar mer än en timme att slutföra. När träningen är klar ändras utdatameddelandet till ungefär så här:

Fine-tuning job ftjob-900fcfc7ea1d4360a9f0cb1697b4eaa6 finished with status: succeeded

Checking other fine-tune jobs for this resource.

Found 4 fine-tune jobs.

Visa en lista över finjusterande händelser

API-version: 2024-08-01-preview eller senare krävs för det här kommandot.

Även om det inte är nödvändigt att slutföra finjusteringen kan det vara bra att undersöka de enskilda finjusteringshändelser som genererades under träningen. De fullständiga träningsresultaten kan också undersökas när träningen har slutförts i träningsresultatfilen.

response = client.fine_tuning.jobs.list_events(fine_tuning_job_id=job_id, limit=10)

print(response.model_dump_json(indent=2))

Python 1.x-utdata:

{

"data": [

{

"id": "ftevent-179d02d6178f4a0486516ff8cbcdbfb6",

"created_at": 1715826339,

"level": "info",

"message": "Training hours billed: 0.500",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-467bc5e766224e97b5561055dc4c39c0",

"created_at": 1715826339,

"level": "info",

"message": "Completed results file: file-175c81c590074388bdb49e8e0d91bac3",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-a30c44da4c304180b327c3be3a7a7e51",

"created_at": 1715826337,

"level": "info",

"message": "Postprocessing started.",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-ea10a008f1a045e9914de98b6b47514b",

"created_at": 1715826303,

"level": "info",

"message": "Job succeeded.",

"object": "fine_tuning.job.event",

"type": "message"

},

{

"id": "ftevent-008dc754dc9e61b008dc754dc9e61b00",

"created_at": 1715825614,

"level": "info",

"message": "Step 100: training loss=0.001647822093218565",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 100,

"train_loss": 0.001647822093218565,

"train_mean_token_accuracy": 1,

"valid_loss": 1.5170825719833374,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.7539110545870624,

"full_valid_mean_token_accuracy": 0.7215189873417721

}

},

{

"id": "ftevent-008dc754dc3f03a008dc754dc3f03a00",

"created_at": 1715825604,

"level": "info",

"message": "Step 90: training loss=0.00971441250294447",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 90,

"train_loss": 0.00971441250294447,

"train_mean_token_accuracy": 1,

"valid_loss": 1.3702410459518433,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.7371194453179082,

"full_valid_mean_token_accuracy": 0.7278481012658228

}

},

{

"id": "ftevent-008dc754dbdfa59008dc754dbdfa5900",

"created_at": 1715825594,

"level": "info",

"message": "Step 80: training loss=0.0032251903321594",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 80,

"train_loss": 0.0032251903321594,

"train_mean_token_accuracy": 1,

"valid_loss": 1.4242165088653564,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.6554046099698996,

"full_valid_mean_token_accuracy": 0.7278481012658228

}

},

{

"id": "ftevent-008dc754db80478008dc754db8047800",

"created_at": 1715825584,

"level": "info",

"message": "Step 70: training loss=0.07380199432373047",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 70,

"train_loss": 0.07380199432373047,

"train_mean_token_accuracy": 1,

"valid_loss": 1.2011798620224,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.508960385865803,

"full_valid_mean_token_accuracy": 0.740506329113924

}

},

{

"id": "ftevent-008dc754db20e97008dc754db20e9700",

"created_at": 1715825574,

"level": "info",

"message": "Step 60: training loss=0.245253324508667",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 60,

"train_loss": 0.245253324508667,

"train_mean_token_accuracy": 0.875,

"valid_loss": 1.0585949420928955,

"valid_mean_token_accuracy": 0.75,

"full_valid_loss": 1.3787144045286541,

"full_valid_mean_token_accuracy": 0.7341772151898734

}

},

{

"id": "ftevent-008dc754dac18b6008dc754dac18b600",

"created_at": 1715825564,

"level": "info",

"message": "Step 50: training loss=0.1696014404296875",

"object": "fine_tuning.job.event",

"type": "metrics",

"data": {

"step": 50,

"train_loss": 0.1696014404296875,

"train_mean_token_accuracy": 0.8999999761581421,

"valid_loss": 0.8862184286117554,

"valid_mean_token_accuracy": 0.8125,

"full_valid_loss": 1.2814022257358213,

"full_valid_mean_token_accuracy": 0.7151898734177216

}

}

],

"has_more": true,

"object": "list"

}

Lista kontrollpunkter

API-version: 2024-08-01-preview eller senare krävs för det här kommandot.

När varje träningsepooch har slutförts genereras en kontrollpunkt. En kontrollpunkt är en fullt fungerande version av en modell som både kan distribueras och användas som målmodell för efterföljande finjusteringsjobb. Kontrollpunkter kan vara användbara eftersom de kan ge en ögonblicksbild av din modell innan överanpassningen har inträffat. När ett finjusteringsjobb har slutförts har du de tre senaste versionerna av modellen som är tillgängliga att distribuera. Den sista epoken representeras av din finjusterade modell, de föregående två epokerna är tillgängliga som kontrollpunkter.

response = client.fine_tuning.jobs.checkpoints.list(job_id)

print(response.model_dump_json(indent=2))

Python 1.x-utdata:

{

"data": [

{

"id": "ftchkpt-148ab69f0a404cf9ab55a73d51b152de",

"created_at": 1715743077,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.8258173013035255,

"full_valid_mean_token_accuracy": 0.7151898734177216,

"step": 100.0,

"train_loss": 0.004080486483871937,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.5915886163711548,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 100

},

{

"id": "ftchkpt-e559c011ecc04fc68eaa339d8227d02d",

"created_at": 1715743013,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678:ckpt-step-90",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.7958603267428241,

"full_valid_mean_token_accuracy": 0.7215189873417721,

"step": 90.0,

"train_loss": 0.0011079151881858706,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.6084896326065063,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 90

},

{

"id": "ftchkpt-8ae8beef3dcd4dfbbe9212e79bb53265",

"created_at": 1715742984,

"fine_tuned_model_checkpoint": "gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678:ckpt-step-80",

"fine_tuning_job_id": "ftjob-372c72db22c34e6f9ccb62c26ee0fbd9",

"metrics": {

"full_valid_loss": 1.6909511662736725,

"full_valid_mean_token_accuracy": 0.7088607594936709,

"step": 80.0,

"train_loss": 0.000667572021484375,

"train_mean_token_accuracy": 1.0,

"valid_loss": 1.4677599668502808,

"valid_mean_token_accuracy": 0.75

},

"object": "fine_tuning.job.checkpoint",

"step_number": 80

}

],

"has_more": false,

"object": "list"

}

Resultat av den slutliga träningskörningen

Kör följande för att få de slutliga resultaten:

# Retrieve fine_tuned_model name

response = client.fine_tuning.jobs.retrieve(job_id)

print(response.model_dump_json(indent=2))

fine_tuned_model = response.fine_tuned_model

Distribuera finjusterad modell

Till skillnad från de tidigare Python SDK-kommandona i den här självstudien måste modelldistributionen göras med hjälp av REST-API:et, vilket kräver separat auktorisering, en annan API-sökväg och en annan API-version.

Du kan också distribuera din finjusterade modell med någon av de andra vanliga distributionsmetoderna som Azure AI Foundry-portalen eller Azure CLI.

| variabel | Definition |

|---|---|

| token | Det finns flera sätt att generera en auktoriseringstoken. Den enklaste metoden för inledande testning är att starta Cloud Shell från Azure Portal. Kör sedan az account get-access-token. Du kan använda den här token som din tillfälliga auktoriseringstoken för API-testning. Vi rekommenderar att du lagrar detta i en ny miljövariabel |

| prenumeration | Prenumerations-ID för den associerade Azure OpenAI-resursen |

| resource_group | Resursgruppens namn för din Azure OpenAI-resurs |

| resource_name | Azure OpenAI-resursnamnet |

| model_deployment_name | Det anpassade namnet på din nya finjusterade modelldistribution. Det här är namnet som refereras till i koden när du gör samtal om chattens slutförande. |

| fine_tuned_model | Hämta det här värdet från ditt finjusterande jobbresultat i föregående steg. Det ser ut som gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678. Du måste lägga till det värdet i deploy_data json. |

Viktigt!

När du har distribuerat en anpassad modell tas distributionen bort om distributionen förblir inaktiv i mer än femton (15) dagar. Distributionen av en anpassad modell är inaktiv om modellen distribuerades för mer än femton (15) dagar sedan och inga slutföranden eller samtal om chattavslut gjordes till den under en kontinuerlig 15-dagarsperiod.

Borttagningen av en inaktiv distribution tar inte bort eller påverkar inte den underliggande anpassade modellen, och den anpassade modellen kan distribueras om när som helst. Enligt beskrivningen i prissättningen för Azure OpenAI Service medför varje anpassad (finjusterad) modell som distribueras en timbaserad värdkostnad oavsett om slutföranden eller chattavslut görs till modellen. Mer information om hur du planerar och hanterar kostnader med Azure OpenAI finns i vägledningen i Planera för att hantera kostnader för Azure OpenAI Service.

# Deploy fine-tuned model

import json

import requests

token = os.getenv("TEMP_AUTH_TOKEN")

subscription = "<YOUR_SUBSCRIPTION_ID>"

resource_group = "<YOUR_RESOURCE_GROUP_NAME>"

resource_name = "<YOUR_AZURE_OPENAI_RESOURCE_NAME>"

model_deployment_name = "gpt-4o-mini-2024-07-18-ft" # Custom deployment name you chose for your fine-tuning model

deploy_params = {'api-version': "2023-05-01"}

deploy_headers = {'Authorization': 'Bearer {}'.format(token), 'Content-Type': 'application/json'}

deploy_data = {

"sku": {"name": "standard", "capacity": 1},

"properties": {

"model": {

"format": "OpenAI",

"name": "<YOUR_FINE_TUNED_MODEL>", #retrieve this value from the previous call, it will look like gpt-4o-mini-2024-07-18.ft-0e208cf33a6a466994aff31a08aba678

"version": "1"

}

}

}

deploy_data = json.dumps(deploy_data)

request_url = f'https://management.azure.com/subscriptions/{subscription}/resourceGroups/{resource_group}/providers/Microsoft.CognitiveServices/accounts/{resource_name}/deployments/{model_deployment_name}'

print('Creating a new deployment...')

r = requests.put(request_url, params=deploy_params, headers=deploy_headers, data=deploy_data)

print(r)

print(r.reason)

print(r.json())

Du kan kontrollera distributionsförloppet i Azure AI Foundry-portalen.

Det är inte ovanligt att den här processen tar lite tid att slutföra när du hanterar distribution av finjusterade modeller.

Använda en distribuerad anpassad modell

När din finjusterade modell har distribuerats kan du använda den som vilken annan distribuerad modell som helst i chattlekplatsen för Azure AI Foundry-portalen eller via API:et för chattens slutförande. Du kan till exempel skicka ett samtal för att slutföra chatten till din distribuerade modell, som du ser i följande Python-exempel. Du kan fortsätta att använda samma parametrar med din anpassade modell, till exempel temperatur och max_tokens, som du kan med andra distribuerade modeller.

# Use the deployed customized model

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key = os.getenv("AZURE_OPENAI_API_KEY"),

api_version = "2024-06-01"

)

response = client.chat.completions.create(

model = "gpt-4o-mini-2024-07-18-ft", # model = "Custom deployment name you chose for your fine-tuning model"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},

{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},

{"role": "user", "content": "Do other Azure AI services support this too?"}

]

)

print(response.choices[0].message.content)

Ta bort distribution

Till skillnad från andra typer av Azure OpenAI-modeller har finjusterade/anpassade modeller en timvärdkostnad som är associerad med dem när de har distribuerats. Vi rekommenderar starkt att du tar bort modelldistributionen när du är klar med den här självstudien och har testat några samtal om att slutföra chatten mot din finjusterade modell.

Om du tar bort distributionen påverkas inte själva modellen, så du kan distribuera om den finjusterade modellen som du har tränat för den här självstudien när som helst.

Du kan ta bort distributionen i Azure AI Foundry-portalen via REST API, Azure CLI eller andra distributionsmetoder som stöds.

Felsökning

Hur gör jag för att aktivera finjustering? Skapa en anpassad modell är nedtonad.

För att få åtkomst till finjusteringen behöver du Tilldelat Cognitive Services OpenAI-deltagare. Även personer med behörigheter som tjänstadministratör på hög nivå skulle behöva det här kontot uttryckligen inställt för att få åtkomst till finjustering. Mer information finns i vägledningen för rollbaserad åtkomstkontroll.

Nästa steg

- Läs mer om finjustering i Azure OpenAI

- Läs mer om de underliggande modeller som driver Azure OpenAI.