Modeller som stöds av Azure AI Agent Service

Agenter drivs av en mängd olika modeller med olika funktioner och prispunkter. Modelltillgängligheten varierar beroende på region och moln. Vissa verktyg och funktioner kräver de senaste modellerna. Följande modeller är tillgängliga i tillgängliga SDK:er. Följande tabell är för betala per användning. Information om PTU-tillgänglighet (Provisioned Throughput Unit) finns i etablerat dataflöde i Azure OpenAI-dokumentationen. Du kan använda globala standardmodeller om de stöds i de regioner som anges här.

Azure OpenAI-modeller

Azure AI Agent Service stöder samma modeller som API:et för chattavslut i Azure OpenAI i följande regioner.

| Region | gpt-4o, 2024-05-13 | gpt-4o, 2024-08-06 | gpt-4o-mini, 2024-07-18 | gpt-4, 0613 | gpt-4, 1106-Preview | gpt-4, 0125-Preview | gpt-4, turbo-2024-04-09 | gpt-4-32k, 0613 | gpt-35-turbo, 0613 | gpt-35-turbo, 1106 | gpt-35-turbo, 0125 | gpt-35-turbo-16k, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| australiaeast | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ | ✅ |

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| eastus2 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| Japan, östra | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| norwayeast | - | - | - | - | ✅ | - | - | - | - | - | - | - |

| swedencentral | ✅ | ✅ | ✅ | ✅ | ✅ | - | ✅ | ✅ | ✅ | ✅ | - | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

| westus3 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | - | ✅ | - |

Fler modeller

Azure AI Agent Service stöder även följande modeller från Azure AI Foundry-modellkatalogen.

- Llama 3.1-70B-instruct

- Mistral-large-2407

- Cohere-kommando R+

Om du vill använda dessa modeller kan du använda Azure AI Foundry-portalen för att göra en distribution och sedan referera till den i din agent.

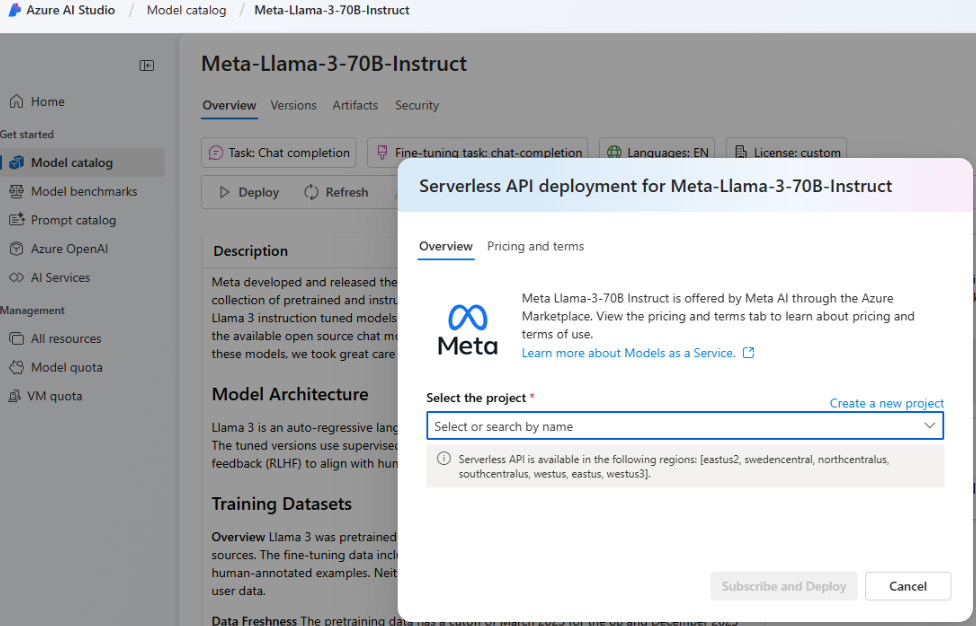

Gå till Azure AI Foundry-portalen och välj Modellkatalog i den vänstra navigeringsmenyn och rulla ned till Meta-Llama-3-70B-Instruct. Du kan också hitta och använda någon av de modeller som angavs tidigare.

Välj distribuera.

På skärmen Distributionsalternativ som visas väljer du Serverlöst API med Azure AI Content Safety.

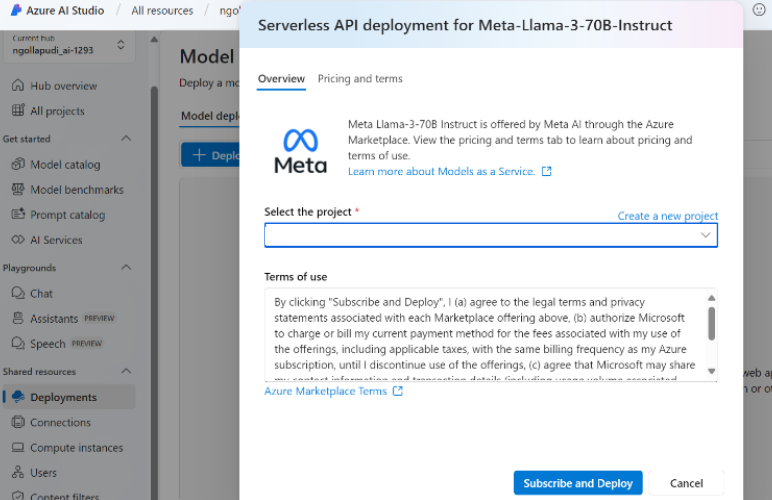

Välj projektet och välj sedan Prenumerera och distribuera.

Lägg till den serverlösa anslutningen till din hubb/ditt projekt. Det distributionsnamn du väljer är det som du refererar till i koden.

När du anropar API:et för att skapa agenten anger du parametern

modelstill ditt distributionsnamn. Till exempel: