Prestandamått för Azure NetApp Files-datalager för Azure VMware Solution

I den här artikeln beskrivs prestandamått som Azure NetApp Files-datalager levererar för virtuella datorer på Azure VMware Solution (AVS).

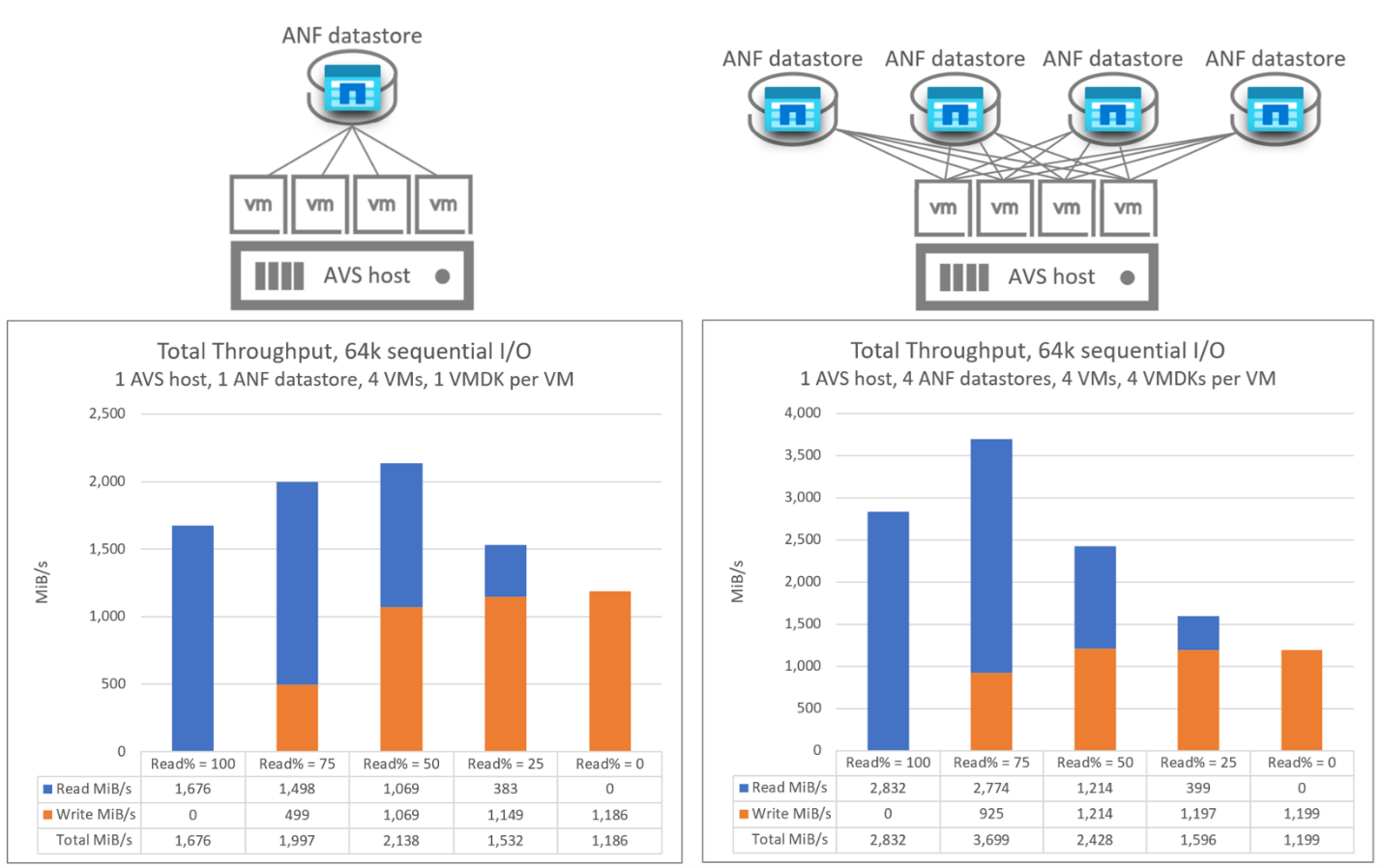

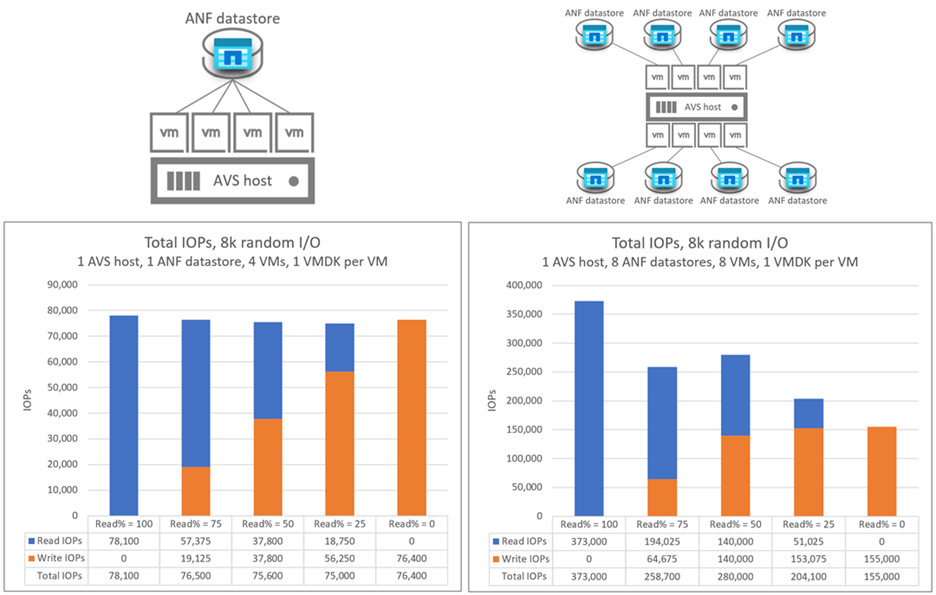

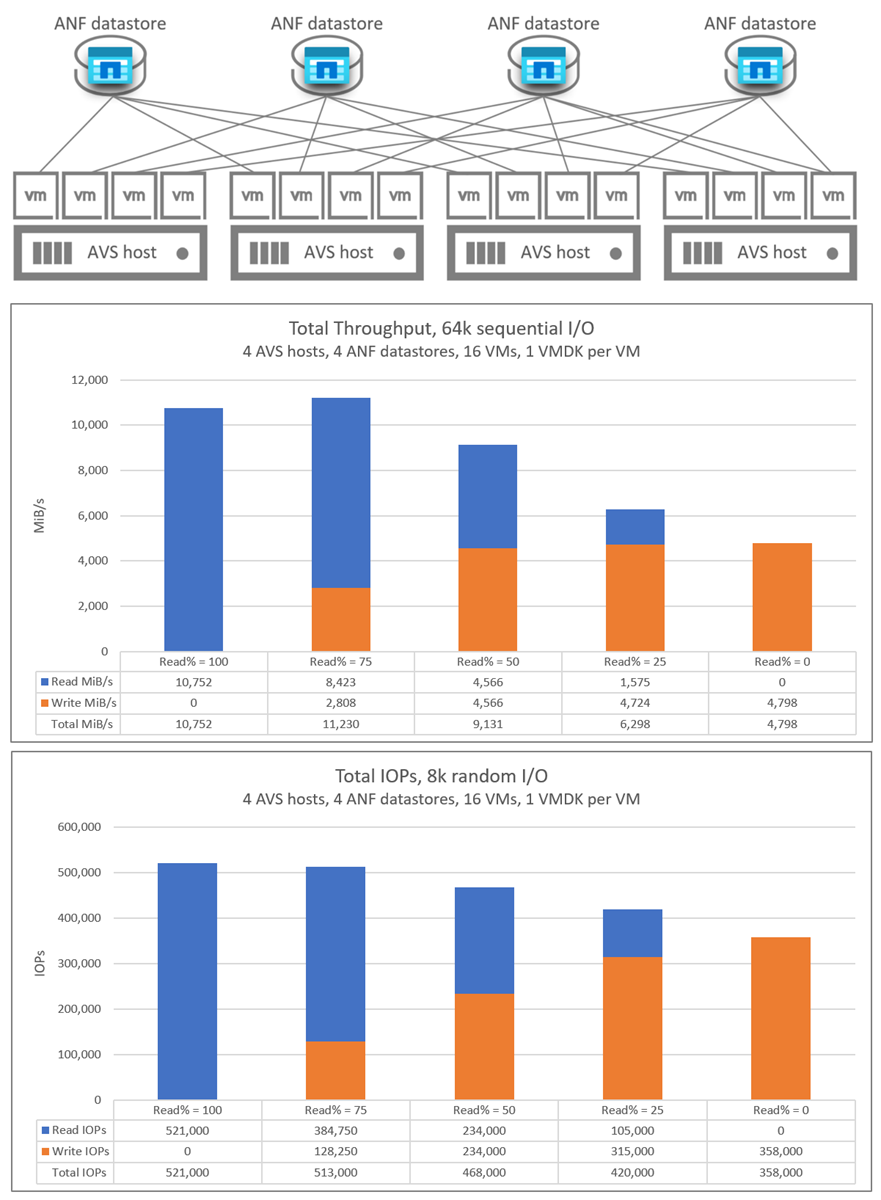

De testade scenarierna är följande:

- En-till-flera virtuella datorer som körs på en enda AVS-värd och ett enda Azure NetApp Files-datalager

- En-till-flera Azure NetApp Files-datalager med en enda AVS-värd

- Skala ut Azure NetApp Files-datalager med flera AVS-värdar

Följande read:write I/O-förhållanden testades för varje scenario: 100:0, 75:25, 50:50, 25:75, 0:100

Prestandamått som beskrivs i den här artikeln utfördes med tillräckligt volymgenomflöde för att förhindra att mjuka gränser påverkar prestanda. Prestandamått kan uppnås med Azure NetApp Files Premium- och Ultra-tjänstnivåer och i vissa fall med standardtjänstnivå. Mer information om volymdataflöde finns i Prestandaöverväganden för Azure NetApp Files.

Läs azure NetApp Files-dataarkivet för Azure VMware Solution TCO Estimator för att förstå storleksfördelarna och de associerade kostnadsfördelarna med Azure NetApp Files-datalager.

Svarstid

Trafikfördröjningen från AVS till Azure NetApp Files-datalager varierar från undermillisekunder (för miljöer med minimal belastning) upp till 2–3 millisekunder (för miljöer med medelhög till hög belastning). Svarstiden är potentiellt högre för miljöer som försöker push-överföra över dataflödesgränserna för olika komponenter. Svarstid och dataflöde kan variera beroende på faktorer som I/O-storlek, läs-/skrivförhållanden, konkurrerande nätverkstrafik med mera.

Prestandaskalning

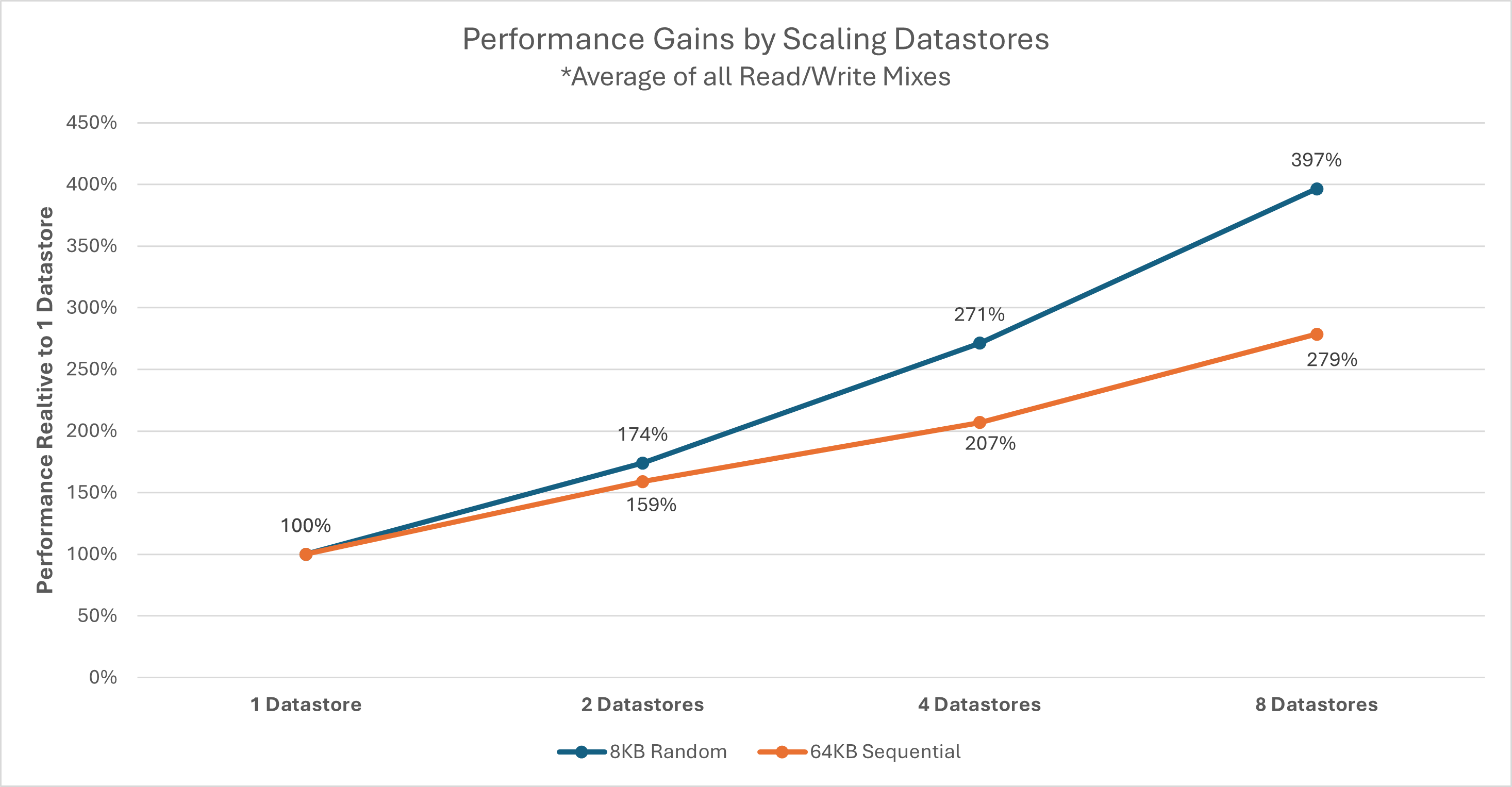

Varje AVS-värd ansluter till varje Azure NetApp Files-datalager med ett fast antal nätverksflöden som kan begränsa en enskild VM-disk (VMDK) eller AVS-värdens dataflöde till varje datalager. Flera datalager kan krävas beroende på en viss uppsättning arbetsbelastningar och deras prestandakrav. Övergripande lagringsprestanda för varje AVS-värd kan ökas genom att arbetsbelastningar sprids över flera datalager. Du kan också öka prestandan genom att sprida arbetsbelastningen till varje datalager mellan AVS-värdar. Följande diagram visar den relativa prestandaskalningen för ytterligare datalager.

Kommentar

Dataflödestaket för externa datalager kan begränsas av andra faktorer som nätverksbandbredd, SKU-gränser eller servicenivåtak för Azure NetApp Files-volymer.

Dataflödet för varje enskild värd kan påverkas av den valda AVS-SKU:n. AV64 SKU har nätverkskort med 100 Gigabit Ethernet (GbE). De andra SKU:erna har 25 GbE nätverkskort. Enskilda nätverksflöden (till exempel NFS-monteringar) kan begränsas av nätverkskorten på 25 GbE.

MILJÖinformation för AV64

Resultatet i den här artikeln uppnåddes med hjälp av följande miljökonfiguration:

- Värdstorlek för Azure VMware Solution: AV64 som kör VMware ESXi version 7u3

- Privat molnanslutning i Azure VMware Solution: UltraPerformance-gateway med FastPath

- Virtuella gästdatorer: Rocky Linux 9, 16 vCPU, 64 GB minne

- Arbetsbelastningsgenerator:

fio3.35

Kommentar

AV64-testerna fokuserar bara på utvärderingen av en enda ESXi-värd. Utskalning av antalet ESXi-värdar beskrivs i avsnittet AV36.

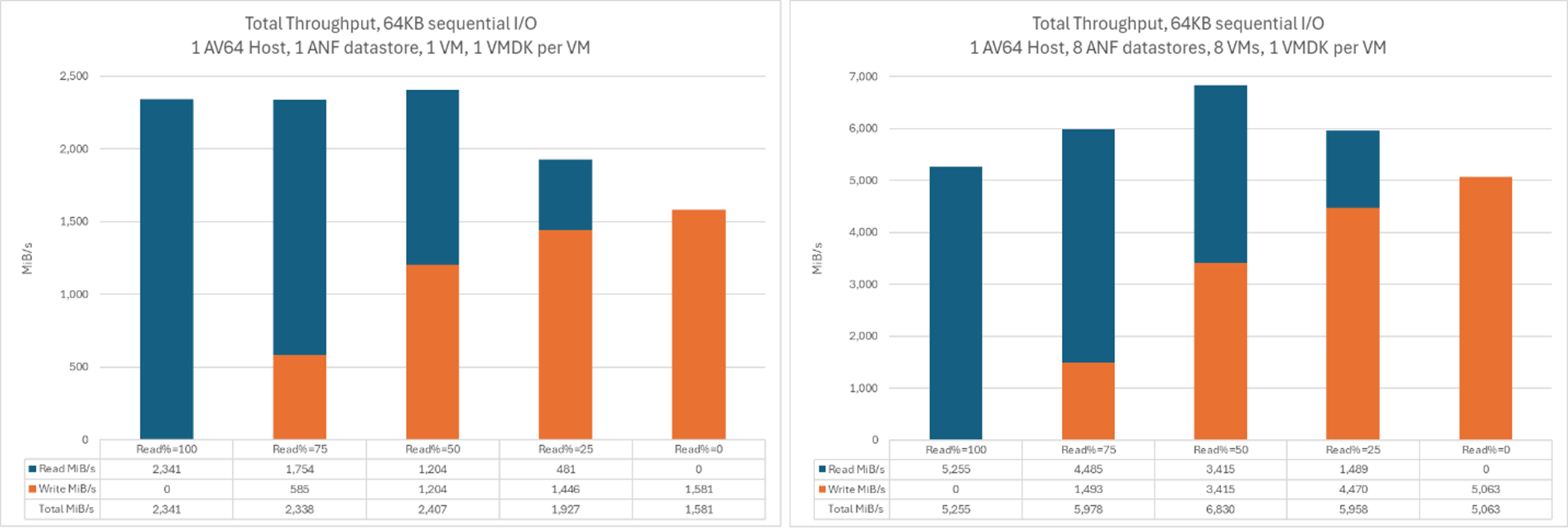

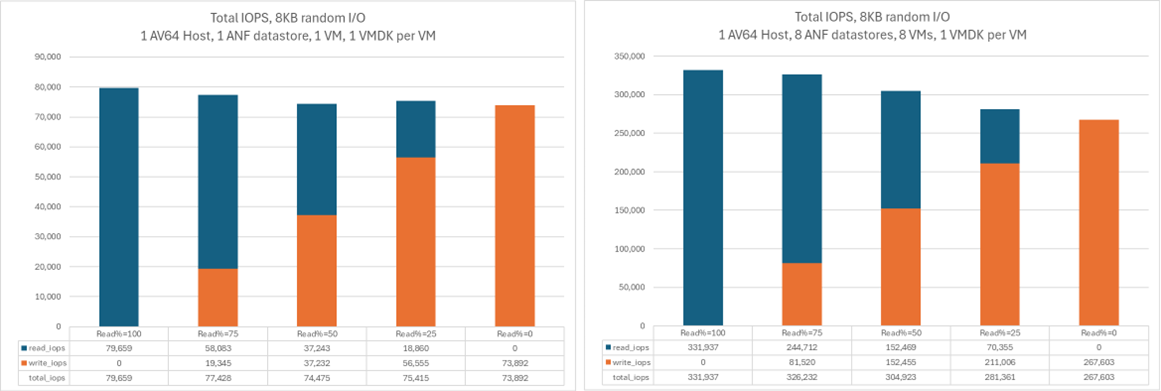

En-till-flera Azure NetApp Files-datalager med en enda AV64-värd

I följande diagram jämförs dataflödet för en enskild virtuell dator på ett enda Azure NetApp Files-datalager med det aggregerade dataflödet för åtta virtuella datorer, var och en på sina egna Azure NetApp Files-datalager. Liknande dataflöde kan uppnås av ett mindre antal virtuella datorer med ytterligare VMDK:er spridda över samma antal datalager.

I det här diagrammet jämförs dataflödet:

I det här diagrammet jämförs I/OPS:

Miljöinformation för AV36

Dessa tester utfördes med en miljökonfiguration med hjälp av:

- Värdstorlek för Azure VMware Solution: AV36 som kör VMware ESXi version 7u3

- Privat molnanslutning i Azure VMware Solution: UltraPerformance-gateway med FastPath

- Virtuella gästdatorer: Ubuntu 21.04, 16 vCPU, 64 GB minne

- Arbetsbelastningsgenerator:

fio

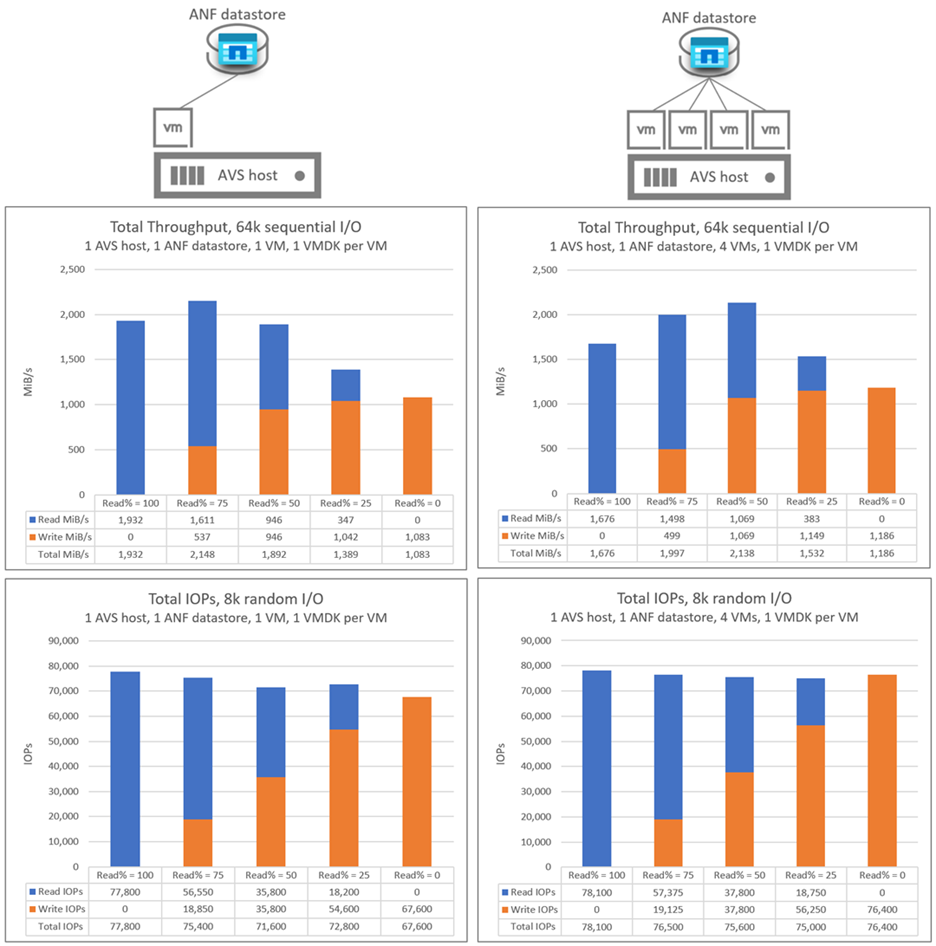

En-till-flera virtuella datorer som körs på en enda AV36-värd och ett enda Azure NetApp Files-datalager

I ett enda AVS-värdscenario sker I/O för datalager-I/O för AVS till Azure NetApp Files via ett enda nätverksflöde. De här graferna jämför dataflödet och I/OP:erna för en enskild virtuell dator med det aggregerade dataflödet och I/OPS för fyra virtuella datorer. I efterföljande scenarier ökar antalet nätverksflöden när fler värdar och datalager läggs till.

En-till-flera Azure NetApp Files-datalager med en enda AV36-värd

I följande diagram jämförs dataflödet för en enskild virtuell dator på ett enda Azure NetApp Files-datalager med det aggregerade dataflödet för fyra Azure NetApp Files-datalager. I båda scenarierna har varje virtuell dator en VMDK på varje Azure NetApp Files-datalager.

I följande diagram jämförs I/OPS för en enskild virtuell dator på ett enda Azure NetApp Files-datalager med den aggregerade I/OPS för åtta Azure NetApp Files-datalager. I båda scenarierna har varje virtuell dator en VMDK på varje Azure NetApp Files-datalager.

Skala ut Azure NetApp Files-datalager med flera AV36-värdar

Följande diagram visar det aggregerade dataflödet och I/OPS för 16 virtuella datorer som distribueras över fyra AVS-värdar. Det finns fyra virtuella datorer per AVS-värd, var och en i ett annat Azure NetApp Files-datalager. Nästan identiska resultat uppnåddes med en enda virtuell dator på varje värd med fyra VMDK:er per virtuell dator och var och en av dessa VMDK:er i ett separat datalager.