Использование Spark в Azure Synapse Analytics

В Spark можно запускать самые разные приложения, в том числе код в скриптах Python или Scala, код Java, скомпилированный в виде архива Java (JAR), и т. д. Spark обычно используется в двух типах рабочих нагрузок.

- Задания пакетной или потоковой обработки для приема, очистки и преобразования данных — часто выполняются как часть автоматизированного конвейера.

- Интерактивные сеансы аналитики для изучения, анализа и визуализации данных.

Выполнение кода Spark в записных книжках

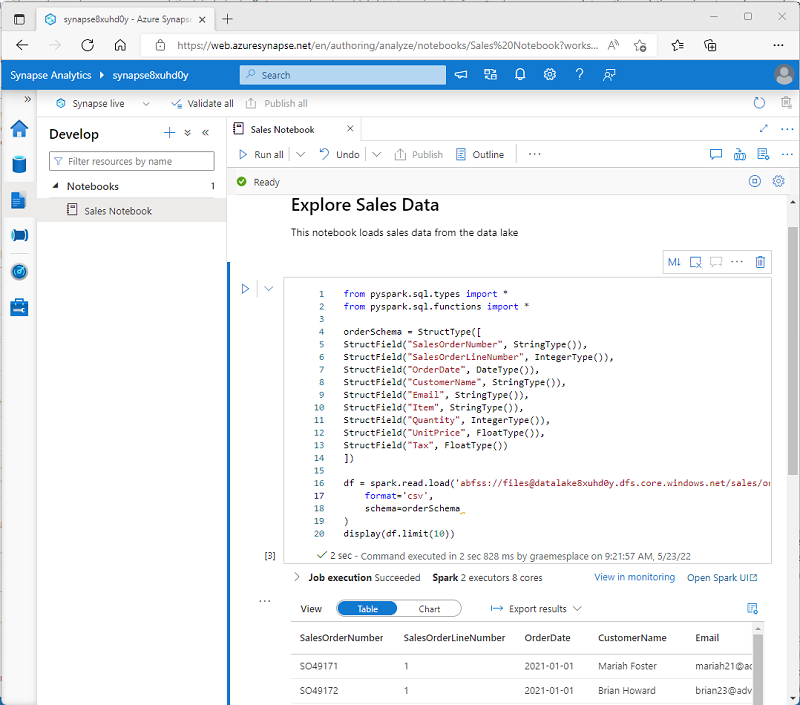

Azure Synapse Studio включает интегрированный интерфейс записной книжки для работы со Spark. Записные книжки предоставляют интуитивно понятный способ объединения кода с заметками Markdown, который часто используют специалисты по обработке и анализу данных. Внешний вид интегрированной записной книжки в Azure Synapse Studio аналогичен внешнему виду записных книжек Jupyter — популярной платформы записных книжек с открытым кодом.

Примечание.

Обычно записные книжки используются в интерактивном режиме, однако их можно включать в автоматизированные конвейеры и выполнять как автоматические скрипты.

Записные книжки состоят из одной или нескольких ячеек, каждая из которых содержит код или заметку Markdown. Ячейки кода в записных книжках имеют некоторые функции для повышения производительности, в том числе:

- выделение синтаксиса и поддержка ошибок;

- автоматическое выполнение кода;

- интерактивные визуализации данных;

- возможность экспорта результатов.

Совет

Дополнительные сведения о работе с записными книжками в Azure Synapse Analytics см. в статье Создание, разработка и обслуживание записных книжек Synapse в Azure Synapse Analytics в документации по Azure Synapse Analytics.

Доступ к данным из пула Synapse Spark

Spark можно использовать в Azure Synapse Analytics для работы с данными из различных источников, в том числе:

- озера данных на базе основной учетной записи хранения для рабочей области Azure Synapse Analytics;

- озера данных на базе хранилища, определенного как связанная служба в рабочей области;

- выделенного или бессерверного пула SQL в рабочей области;

- базы данных Azure SQL или SQL Server (с помощью соединителя Spark для SQL Server);

- аналитической базы данных Azure Cosmos DB, определенной как связанная служба и настроенной с помощью Azure Synapse Link для Cosmos DB;

- базы данных Kusto Azure Data Explorer, определенной как связанная служба в рабочей области;

- внешнего хранилища метаданных Hive, определенного как связанная служба в рабочей области.

Одним из наиболее распространенных вариантов использования Spark является работа с данными в озере данных, где можно читать и записывать файлы в различных распространенных форматах, включая текстовый файл с разделителями, Parquet, Avro и т. д.