Руководство. Потоковая передача и использование событий в аналитику в режиме реального времени с помощью конечной точки Apache Kafka в потоке событий

В этом руководстве вы узнаете, как использовать конечную точку Apache Kafka, предоставляемую пользовательским источником конечных точек в расширенных возможностях потоков событий Microsoft Fabric для потоков потоков событий Microsoft Fabric для потоков событий в аналитику в режиме реального времени. (Пользовательская конечная точка называется пользовательским приложением в стандартных возможностях потоков событий Fabric.) Вы также узнаете, как использовать эти события потоковой передачи с помощью конечной точки Apache Kafka из назначения пользовательской конечной точки потока событий.

Изучив это руководство, вы:

- Создайте поток событий.

- Получите конечную точку Kafka из пользовательского источника конечной точки.

- Отправка событий с помощью приложения Kafka.

- Получите конечную точку Kafka из назначения пользовательской конечной точки.

- Использование событий с помощью приложения Kafka.

Необходимые компоненты

- Получите доступ к рабочей области с разрешениями участника или выше, где находится ваш поток событий.

- Получите компьютер Windows и установите следующие компоненты:

- Комплект разработчика Java (JDK 1.7+)

- Двоичный архив Maven (скачивание и установка)

- Git

Создание потока событий в Microsoft Fabric

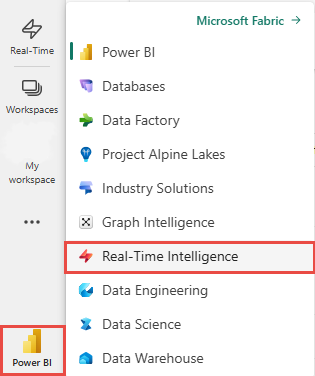

Измените интерфейс Fabric на аналитику в режиме реального времени.

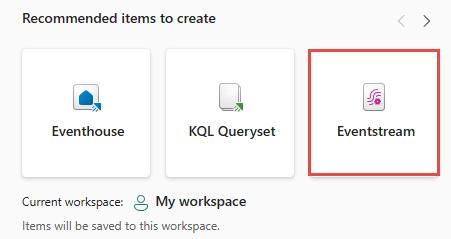

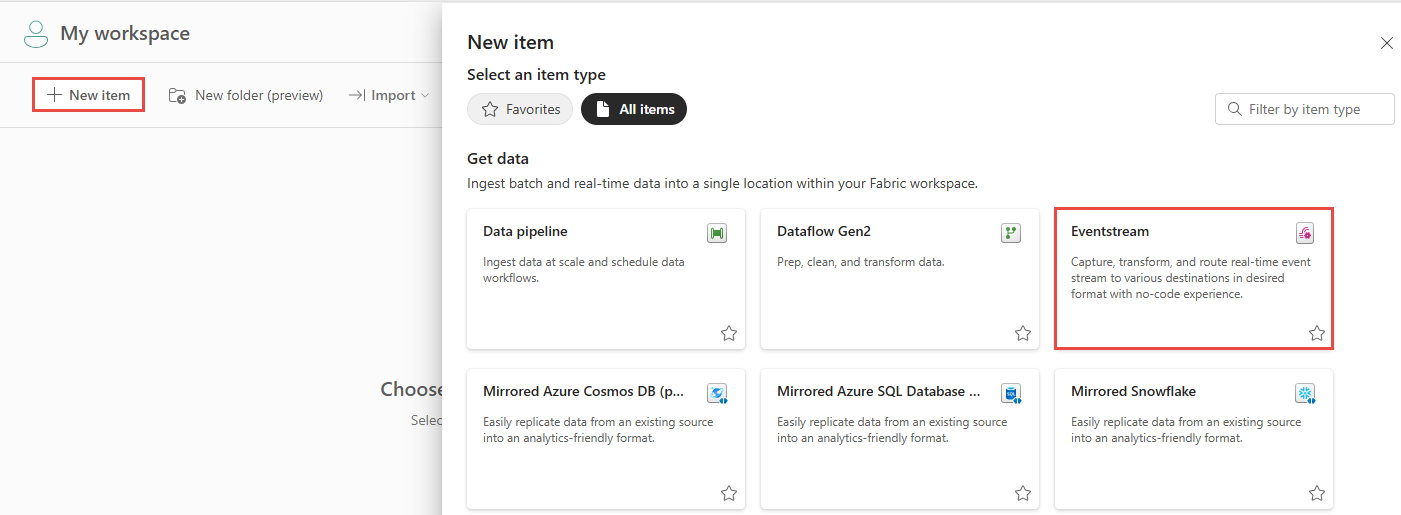

Выполните одно из следующих действий, чтобы начать создание потока событий:

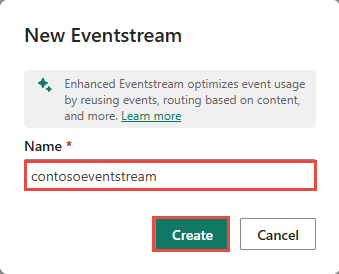

Введите имя нового потока событий и нажмите кнопку "Создать".

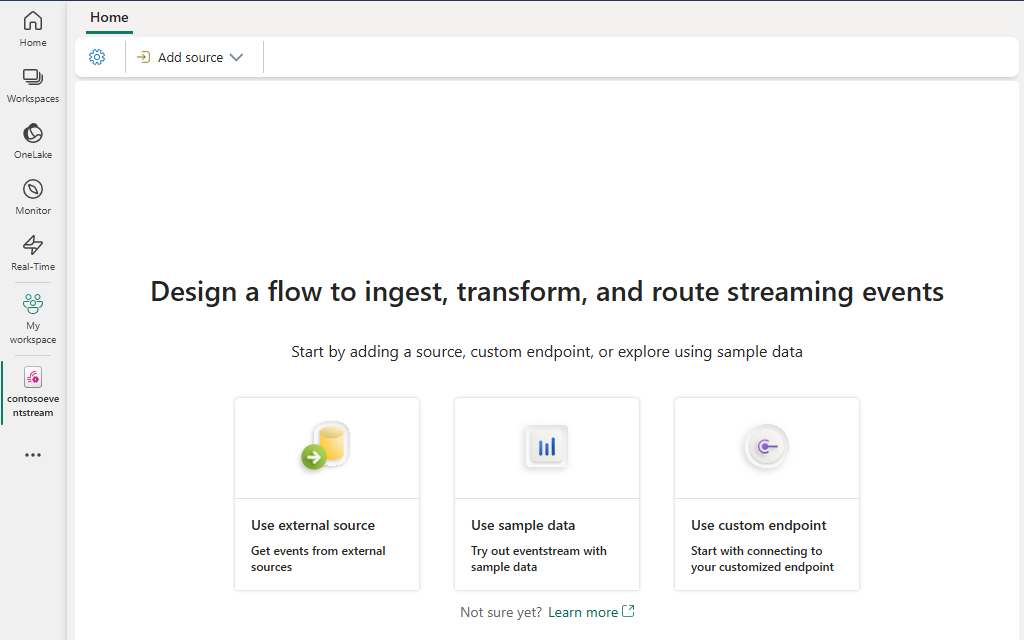

Создание нового потока событий в рабочей области может занять несколько секунд. После создания потока событий вы будете перенаправлены в главный редактор, где можно начать с добавления источников в поток событий.

Получение конечной точки Kafka из добавленного пользовательского источника конечной точки

Чтобы получить конечную точку раздела Kafka, добавьте в поток событий пользовательский источник конечной точки. Затем конечная точка подключения Kafka доступна и предоставляется в пользовательском источнике конечной точки.

Чтобы добавить в поток событий пользовательский источник конечной точки, выполните приведенные ниже действия.

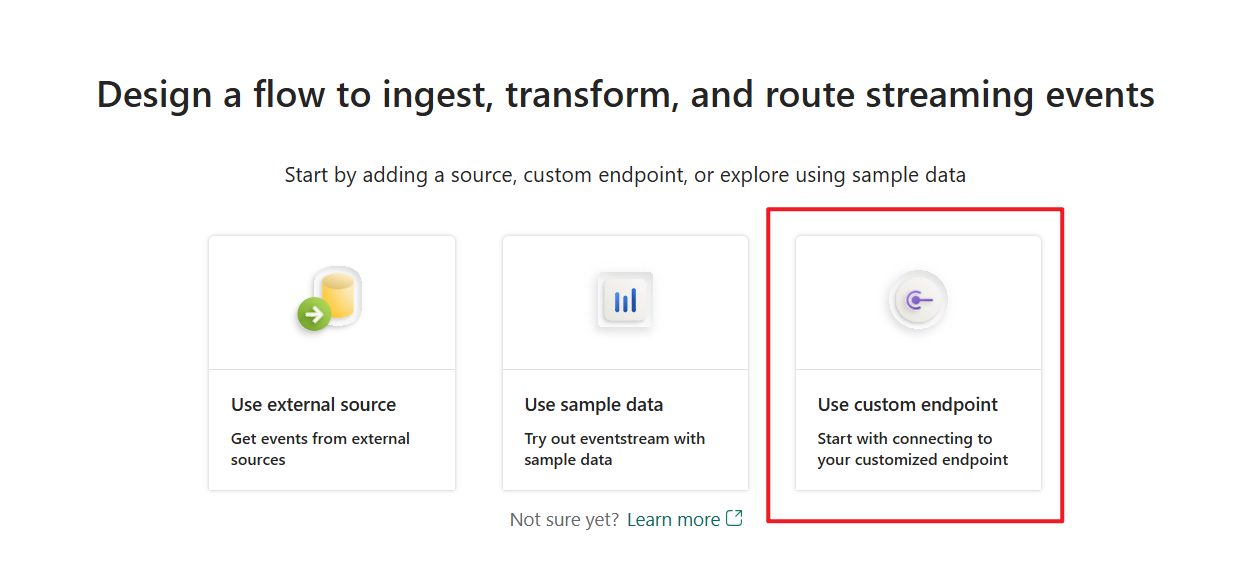

На домашней странице потока событий выберите "Использовать пользовательскую конечную точку ", если это пустой поток событий.

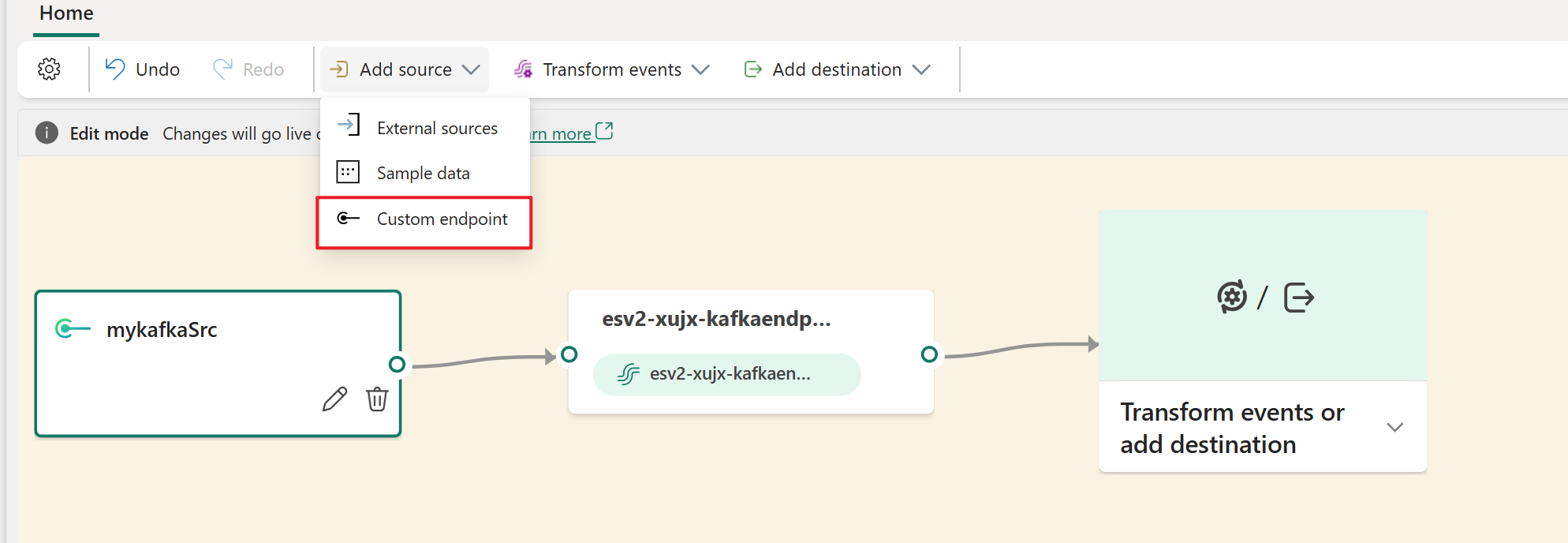

Или на ленте выберите "Добавить исходную>пользовательскую конечную точку".

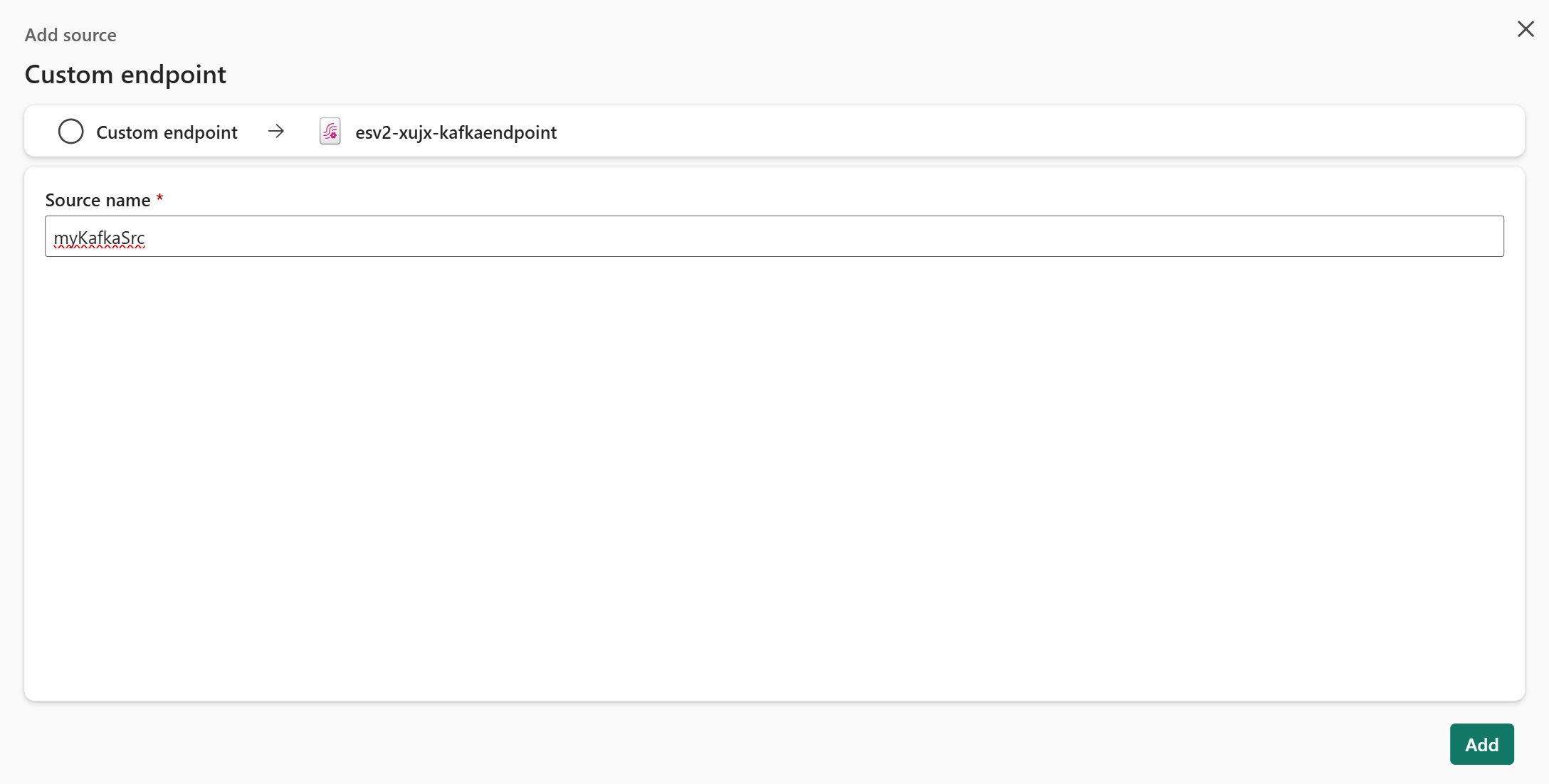

Введите значение имени источника для настраиваемой конечной точки и нажмите кнопку "Добавить".

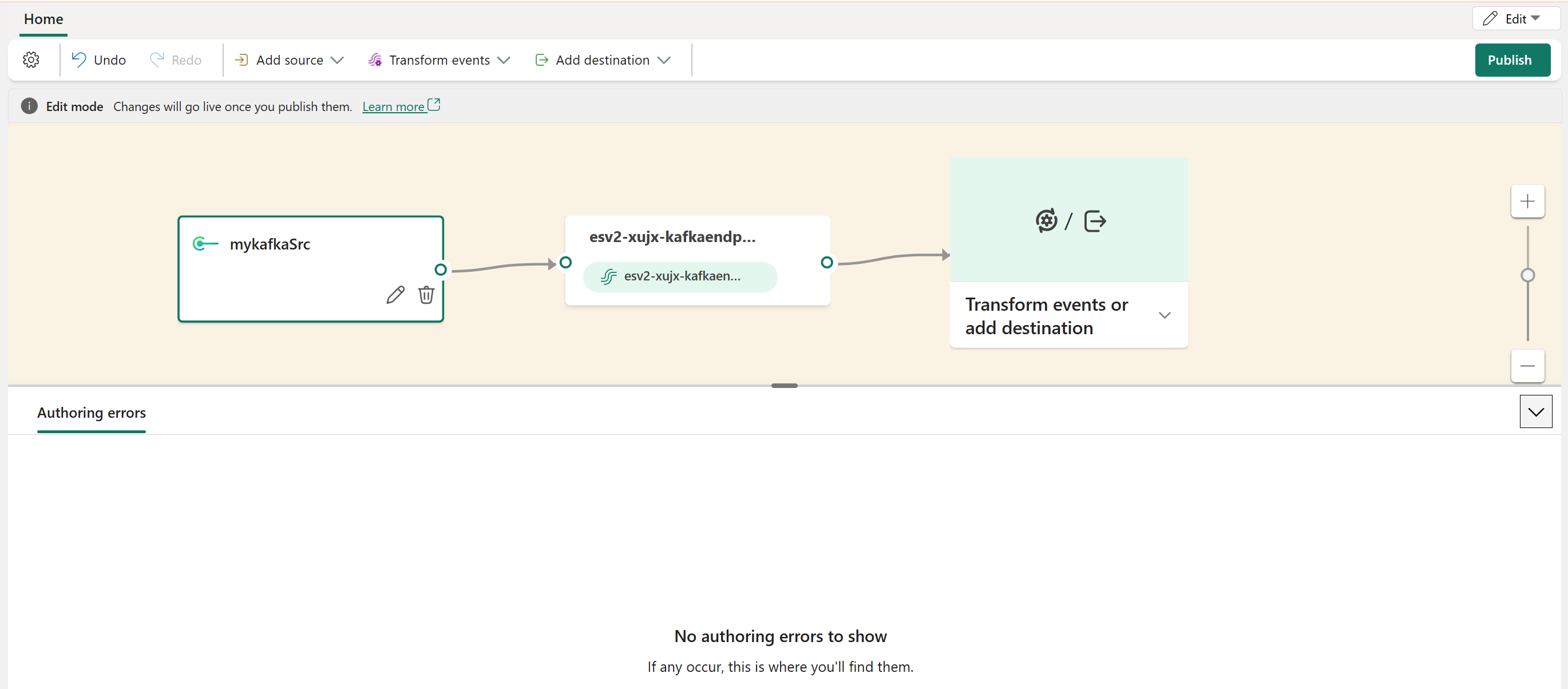

Убедитесь, что на холсте потока событий в режиме редактирования отображается пользовательский источник конечной точки, а затем нажмите кнопку "Опубликовать".

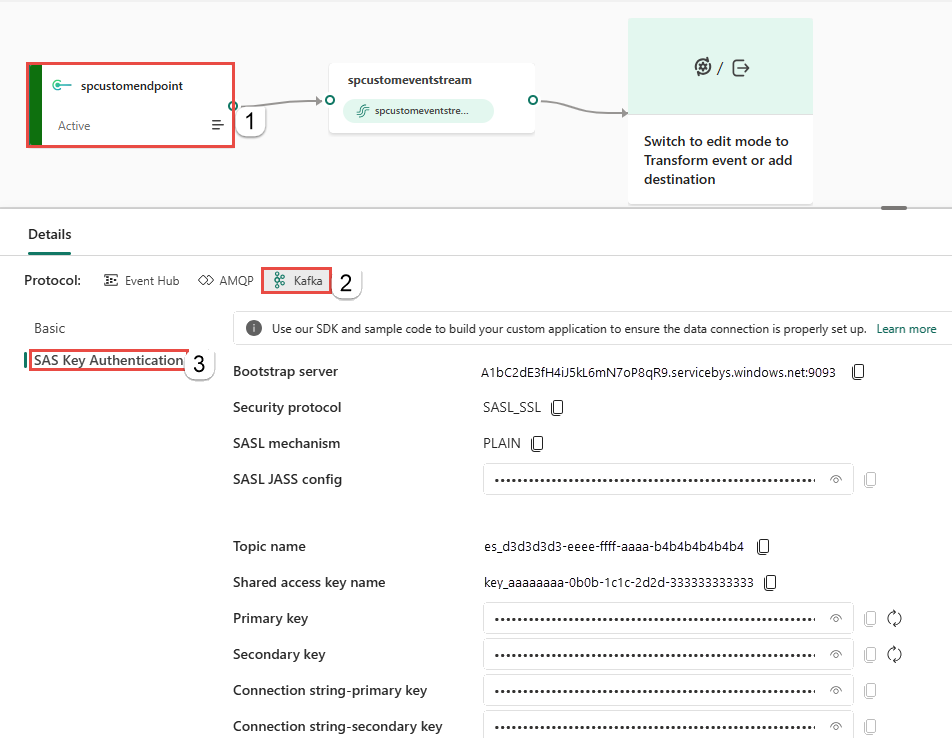

После успешной публикации потока событий можно получить сведения, включая сведения о конечной точке Kafka. Выберите плитку источника пользовательской конечной точки на холсте. Затем в нижней области узла источника пользовательской конечной точки выберите вкладку Kafka .

На странице проверки подлинности ключа SAS вы можете получить следующие важные сведения о конечной точке Kafka:

bootstrap.servers={YOUR.BOOTSTRAP.SERVER}security.protocol=SASL_SSLsasl.mechanism=PLAINsasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="$ConnectionString" password="{YOUR.CONNECTION.STRING}";

{YOUR.BOOTSTRAP.SERVER}— значение сервера Bootstrap на странице проверки подлинности ключей SAS.{YOUR.CONNECTION.STRING}может быть значением строки подключения— первичным ключом или значением ключа -connection-secondary. Выберите один из них.Дополнительные сведения о проверке подлинности ключа SAS и примерах кодов см. в разделе "Сведения о конечной точке Kafka".

Отправка событий с помощью приложения Kafka

Используя важные сведения Kafka, полученные на предыдущем шаге, можно заменить конфигурации подключений в существующем приложении Kafka. Затем вы можете отправить события в поток событий.

Ниже приведено одно приложение на основе пакета SDK Центры событий Azure, написанного на Java, следуя протоколу Kafka. Чтобы использовать это приложение для потоковой передачи событий в поток событий, выполните следующие действия, чтобы заменить сведения о конечной точке Kafka и выполнить его правильно:

Клонируйте репозиторий Центров событий Azure для Kafka.

Перейдите в azure-event-hubs-for-kafka/quickstart/java/producer.

Обновите сведения о конфигурации производителя в src/main/resources/producer.config следующим образом:

bootstrap.servers={YOUR.BOOTSTRAP.SERVER}security.protocol=SASL_SSLsasl.mechanism=PLAINsasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="$ConnectionString" password="{YOUR.CONNECTION.STRING}";

Замените

{YOUR.BOOTSTRAP.SERVER}значением сервера Bootstrap. Замените{YOUR.CONNECTION.STRING}значением строки подключения-первичного ключа или значением ключа connection-secondary. Выберите один из них.Обновите имя раздела с новым именем раздела следующим

src/main/java/TestProducer.javaобразом:private final static String TOPIC = "{YOUR.TOPIC.NAME}";Значение можно найти

{YOUR.TOPIC.NAME}на странице проверки подлинности ключа SAS на вкладке Kafka.Запустите код производителя и потоковую передачу событий в поток событий:

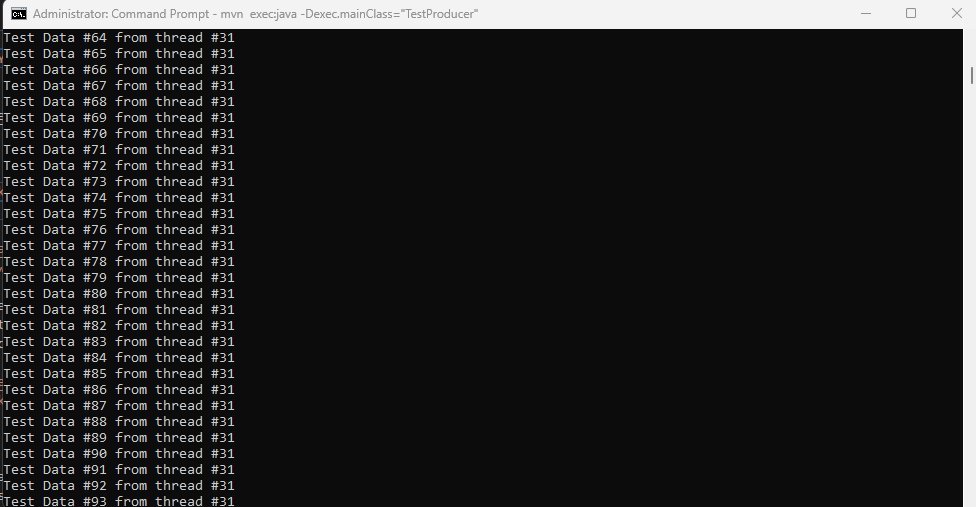

mvn clean packagemvn exec:java -Dexec.mainClass="TestProducer"

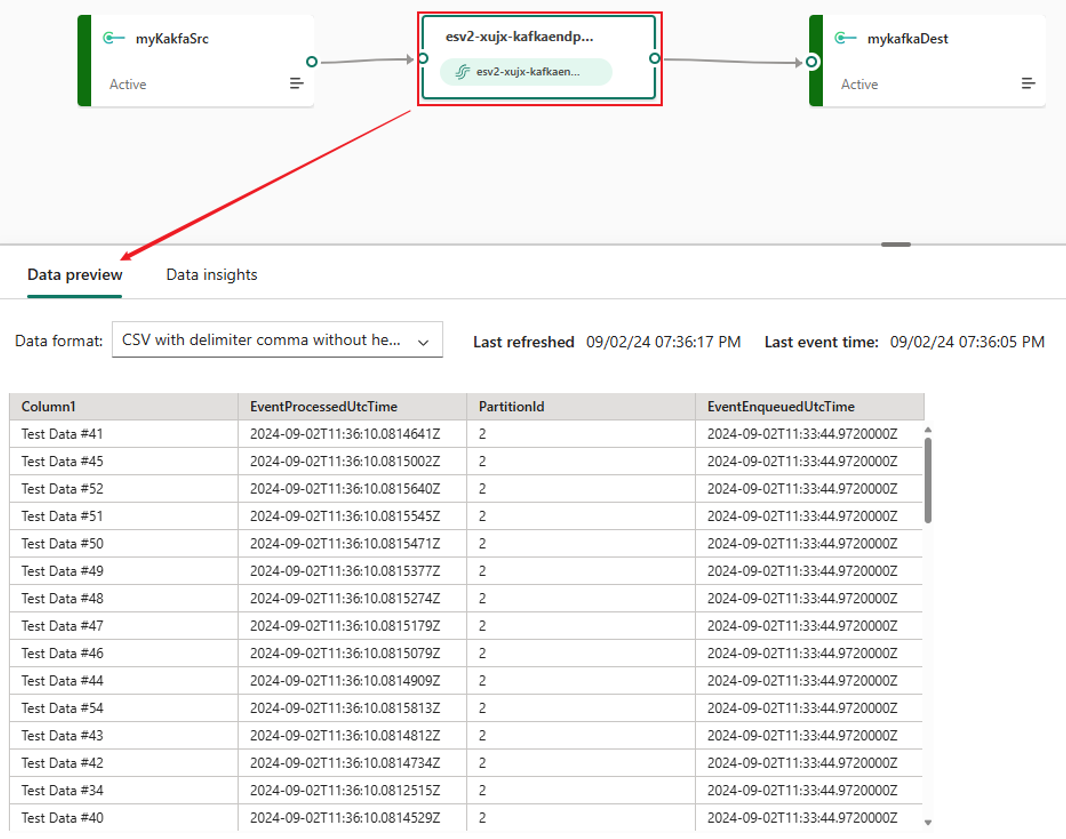

Предварительный просмотр данных, отправленных с помощью этого приложения Kafka. Выберите узел eventstream, который является средним узлом, в котором отображается имя потока событий.

Выберите csv-файл формата данных с запятой разделителя без заголовка. Этот выбор соответствует формату, в котором приложение передает данные события.

Получение конечной точки Kafka из добавленного назначения пользовательской конечной точки

Можно добавить настраиваемое назначение конечной точки, чтобы получить сведения о конечной точке подключения Kafka для использования событий из потока событий. После добавления назначения вы можете получить сведения из области сведений о назначении в режиме реального времени.

На странице "Базовый" можно получить значение группы потребителей. Это значение необходимо, чтобы позже настроить приложение потребителя Kafka.

На странице проверки подлинности ключа SAS вы можете получить важные сведения о конечной точке Kafka:

bootstrap.servers={YOUR.BOOTSTRAP.SERVER}security.protocol=SASL_SSLsasl.mechanism=PLAINsasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="$ConnectionString" password="{YOUR.CONNECTION.STRING}";

{YOUR.BOOTSTRAP.SERVER}— значение сервера Bootstrap. {YOUR.CONNECTION.STRING}может быть значением строки подключения— первичным ключом или значением ключа -connection-secondary. Выберите один из них.

Использование событий с помощью приложения Kafka

Теперь вы можете использовать другое приложение в Центры событий Azure репозитория Kafka для использования событий из потока событий. Чтобы использовать это приложение для использования событий из потока событий, выполните следующие действия, чтобы заменить сведения о конечной точке Kafka и запустить его соответствующим образом:

Клонируйте репозиторий Центров событий Azure для Kafka.

Перейдите к azure-event-hubs-for-kafka/quickstart/java/consumer.

Обновите сведения о конфигурации для потребителя в src/main/resources/consumer.config следующим образом:

bootstrap.servers={YOUR.BOOTSTRAP.SERVER}group.id={YOUR.EVENTHUBS.CONSUMER.GROUP}security.protocol=SASL_SSLsasl.mechanism=PLAINsasl.jaas.config=org.apache.kafka.common.security.plain.PlainLoginModule required username="$ConnectionString"password="{YOUR.CONNECTION.STRING}";

Замените

{YOUR.BOOTSTRAP.SERVER}значением сервера Bootstrap. Значение можно получить{YOUR.EVENTHUBS.CONSUMER.GROUP}на странице "Базовый" на панели сведений для назначения пользовательской конечной точки. Замените{YOUR.CONNECTION.STRING}значением строки подключения-первичного ключа или значением ключа connection-secondary. Выберите один из них.Обновите имя раздела с новым именем раздела на странице проверки подлинности ключей SAS в src/main/java/TestConsumer.java следующим образом:

private final static String TOPIC = "{YOUR.TOPIC.NAME}";Значение можно найти

{YOUR.TOPIC.NAME}на странице проверки подлинности ключа SAS на вкладке Kafka.Запустите код потребителя и потоковую передачу событий в поток событий:

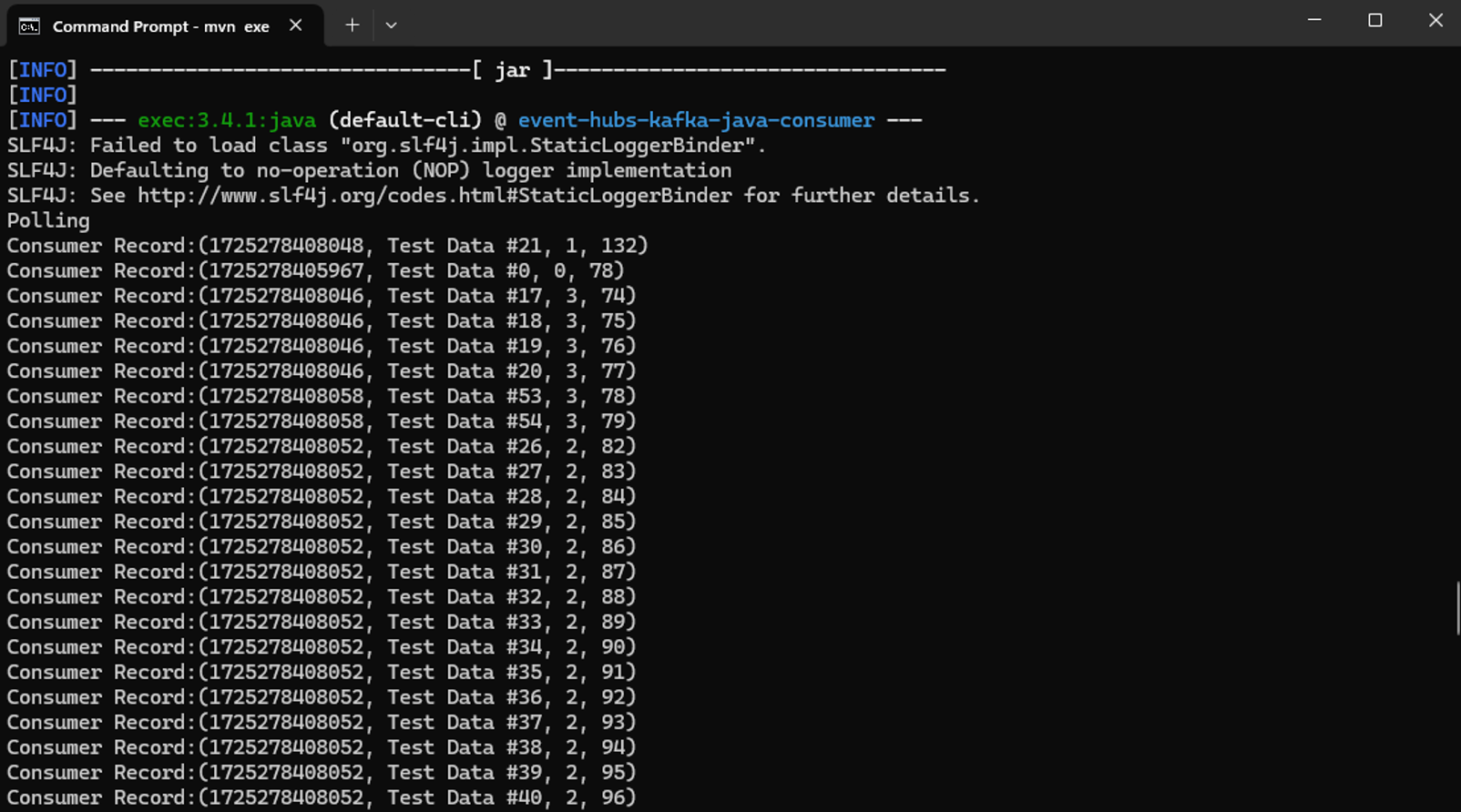

mvn clean packagemvn exec:java -Dexec.mainClass="TestConsumer"

Если в потоке событий есть входящие события (например, предыдущее приложение производителя по-прежнему запущено), убедитесь, что потребитель получает события из раздела событий.

По умолчанию потребители Kafka считывают с конца потока, а не в начале. Потребитель Kafka не считывает никаких событий, которые помещаются в очередь перед началом запуска потребителя. Если вы запускаете своего потребителя, но он не получает никаких событий, попробуйте запустить продюсер снова, пока ваш потребитель опрос.

Заключение

Поздравляем. Вы узнали, как использовать конечную точку Kafka, предоставленную из потока событий, для потоковой передачи и использования событий в потоке событий. Если у вас уже есть приложение, которое отправляет или используется из раздела Kafka, вы можете использовать то же приложение для отправки или использования событий в потоке событий без каких-либо изменений кода. Просто измените сведения о конфигурации подключения.