Отчеты о выставлении счетов и использовании для Apache Spark в Microsoft Fabric

Область применения:✅ Инжиниринг данных и Обработка и анализ данных в Microsoft Fabric

В этой статье объясняется использование вычислительных ресурсов и отчеты для ApacheSpark, которые могут использовать рабочие нагрузки Fabric Инжиниринг данных и науки в Microsoft Fabric. Использование вычислений включает операции lakehouse, такие как предварительная версия таблицы, загрузка в разностную, записная книжка выполняется из интерфейса, запланированных запусков, запусков с помощью шагов записной книжки в конвейерах и выполнения определений заданий Apache Spark.

Как и другие возможности в Microsoft Fabric, Инжиниринг данных также использует емкость, связанную с рабочей областью для выполнения этих заданий, и общие расходы на емкость отображаются в портал Azure в подписке Microsoft Cost Management. Дополнительные сведения о выставлении счетов в Fabric см. в статье "Общие сведения о счете Azure" в емкости Fabric.

Емкость Fabric

Пользователь может приобрести емкость Fabric из Azure, указав подписку Azure. Размер емкости определяет объем доступной вычислительной мощности. Для Apache Spark для Fabric каждый приобретенный накопительный пакет обновления преобразуется в 2 виртуальных ядра Apache Spark. Например, если вы приобрели емкость Fabric F128, это преобразуется в 256 SparkVCores. Емкость Fabric используется для всех рабочих областей, добавленных в нее, и в которой общий объем вычислительных ресурсов Apache Spark позволяет совместно использовать все задания, отправленные из всех рабочих областей, связанных с емкостью. Сведения о различных номерах SKU, выделении ядер и регулировании в Spark см. в статье об ограничениях параллелизма и очередях в Apache Spark для Microsoft Fabric.

Конфигурация вычислений Spark и приобретенная емкость

Вычисление Apache Spark для Fabric предлагает два варианта, когда речь идет о конфигурации вычислений.

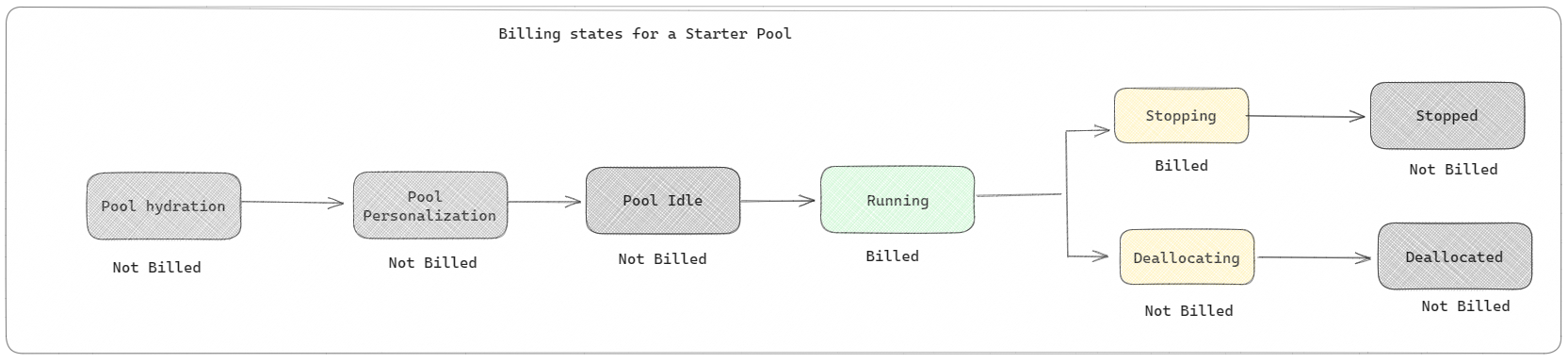

Начальные пулы: эти пулы по умолчанию являются быстрым и простым способом использования Spark на платформе Microsoft Fabric в течение нескольких секунд. Сеансы Spark можно использовать сразу, а не ожидать, пока Spark настроит узлы для вас, что поможет вам быстрее использовать данные и получить аналитические сведения. Когда речь идет о выставлении счетов и потреблении емкости, плата взимается при запуске выполнения задачи записной книжки или определения задания Spark или операции Lakehouse. Плата за время простоя кластеров в пуле не взимается.

Например, если вы отправляете задание записной книжки в начальный пул, плата взимается только за период времени, когда сеанс записной книжки активен. Оплачиваемое время не включает время простоя или время, затраченное на персонализацию сеанса с помощью контекста Spark. Дополнительные сведения о настройке начальных пулов на основе SKU приобретенной емкости Fabric см. в разделе "Настройка начальных пулов на основе емкости Fabric"

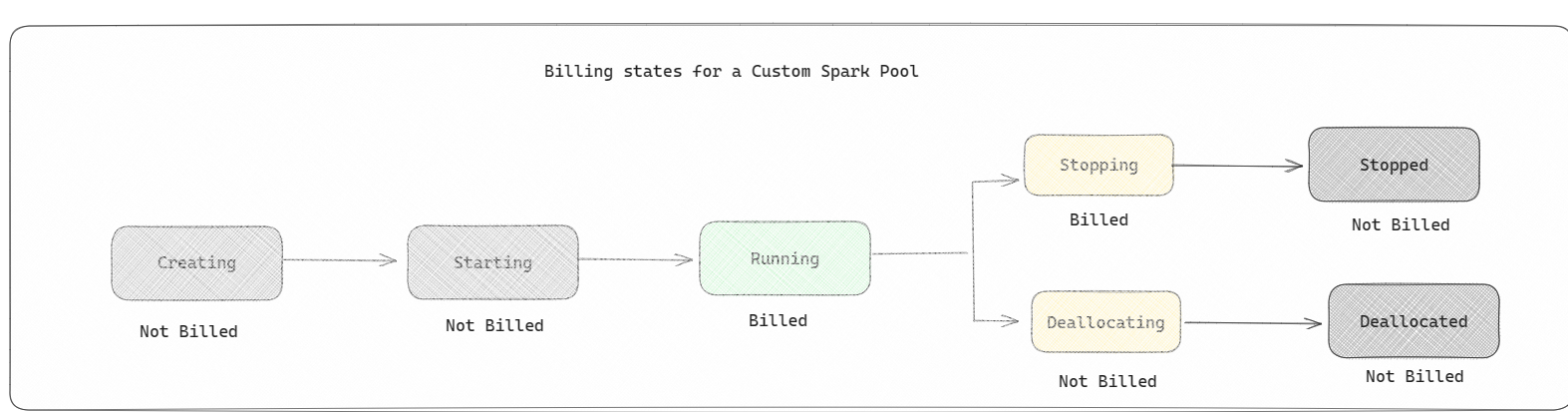

Пулы Spark. Это настраиваемые пулы, где можно настроить размер ресурсов, необходимых для задач анализа данных. Вы можете указать имя пула Spark и выбрать, сколько и сколько узлов (компьютеры, которые выполняют эту работу). Вы также можете указать Spark, как настроить количество узлов в зависимости от того, сколько работ у вас есть. Создание пула Spark бесплатно; вы платите только при выполнении задания Spark в пуле, а затем Spark настраивает узлы для вас.

- Размер и количество узлов, которые можно использовать в пользовательском пуле Spark, зависит от емкости Microsoft Fabric. Эти виртуальные ядра Spark можно использовать для создания узлов разных размеров для пользовательского пула Spark, если общее количество виртуальных ядер Spark не превышает 128.

- Счета за пулы Spark, такие как начальные пулы; Вы не платите за созданные настраиваемые пулы Spark, если у вас нет активного сеанса Spark, созданного для выполнения определения задания Spark или записной книжки. Плата взимается только за время выполнения задания. Плата за этапы, такие как создание кластера и размещение сделки после завершения задания, не взимается.

Например, если вы отправляете задание записной книжки в пользовательский пул Spark, плата взимается только за период времени, когда сеанс активен. Выставление счетов за сеанс записной книжки останавливается после остановки или истечения срока действия сеанса Spark. Плата за получение экземпляров кластера из облака или времени, затраченное на инициализацию контекста Spark, не взимается. Дополнительные сведения о настройке пулов Spark на основе приобретенного номера SKU емкости Fabric см. в разделе "Настройка пулов на основе емкости Fabric"

Примечание.

Период истечения срока действия сеанса по умолчанию для создаваемых пулов и пулов Spark составляет 20 минут. Если вы не используете пул Spark в течение 2 минут после истечения срока действия сеанса, пул Spark будет освобожден. Чтобы остановить сеанс и выставление счетов после завершения выполнения записной книжки до истечения срока действия сеанса, можно щелкнуть кнопку остановки сеанса из меню "Главная" записных книжек или перейти на страницу центра мониторинга и остановить сеанс там.

Отчеты об использовании вычислений Spark

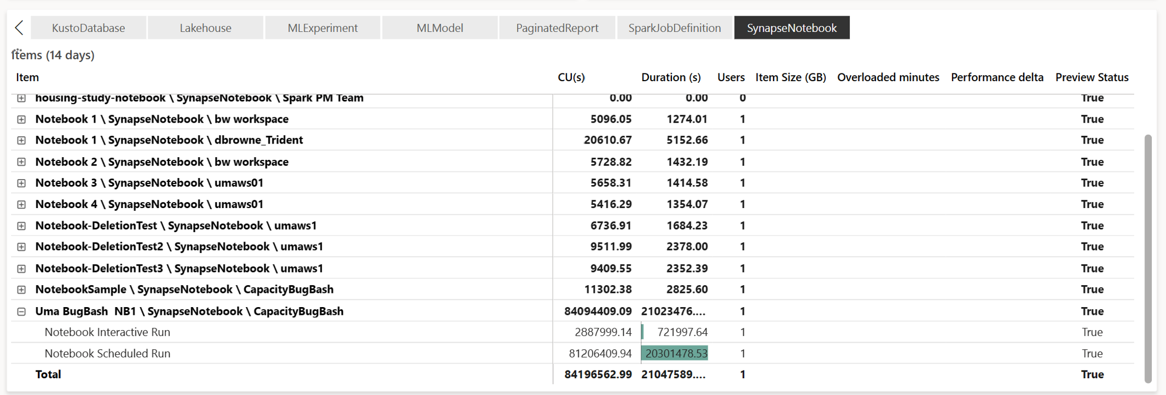

Приложение "Метрики емкости Microsoft Fabric" обеспечивает видимость использования емкости для всех рабочих нагрузок Fabric в одном месте. Он используется администраторами емкости для мониторинга производительности рабочих нагрузок и их использования по сравнению с приобретенной емкостью.

После установки приложения выберите тип "Записная книжка", "Lakehouse", "Определение задания Spark" в раскрывающемся списке "Выбор элемента". Диаграмма диаграммы с многометричной лентой теперь можно настроить на нужный интервал времени, чтобы понять использование всех выбранных элементов.

Все связанные операции Spark классифицируются как фоновые операции. Потребление емкости из Spark отображается в записной книжке, определении задания Spark или lakehouse и агрегируется по имени и элементу операции. Например, если вы запускаете задание записной книжки, вы можете увидеть выполнение записной книжки, блоки CUS, используемые записной книжкой (всего виртуальных ядер Spark/2 как 1 CU дает 2 виртуальных ядер Spark), длительность задания, принятого в отчете.

Дополнительные сведения об использовании емкости Spark см. в статье "Мониторинг потребления емкости Apache Spark"

Дополнительные сведения об использовании емкости Spark см. в статье "Мониторинг потребления емкости Apache Spark"

Пример выставления счетов

Рассмотрим следующий сценарий:

Существует емкость C1, в которой размещена рабочая область Fabric W1, и эта рабочая область содержит Lakehouse LH1 и Записную книжку NB1.

- Любая операция Spark, выполняемая записной книжкой (NB1) или lakehouse(LH1), сообщается в отношении емкости C1.

Расширение этого примера к сценарию, в котором есть другая емкость C2, в которой размещена рабочая область Fabric W2 и позволяет сказать, что эта рабочая область содержит определение задания Spark (SJD1) и Lakehouse (LH2).

- Если определение задания Spark (SDJ2) из рабочей области (W2) считывает данные из Lakehouse (LH1), использование сообщается в отношении емкости C2, связанной с рабочей областью (W2), в которой размещен элемент.

- Если записная книжка (NB1) выполняет операцию чтения из Lakehouse(LH2), потребление емкости сообщается в отношении емкости C1, которая использует рабочую область W1, на которой размещен элемент записной книжки.