Ответственный ИИ в рабочих нагрузках Azure

Цель ответственного ИИ в проектировании рабочей нагрузки заключается в том, чтобы обеспечить использование алгоритмов ИИ справедливой, прозрачнойи инклюзивной. Принципы безопасности Microsoft Azure Well-Architected Framework взаимосвязаны и сосредоточены на конфиденциальности и целостности. Меры безопасности должны применяться для поддержания конфиденциальности пользователей, защиты данных и обеспечения целостности структуры. Дизайн не должен быть неправильно использован для непреднамеренных целей.

В рабочих нагрузках искусственного интеллекта модели часто используют непрозрачную логику для принятия решений. Пользователи должны доверять функциональным возможностям системы и чувствовать себя уверенными в том, что модели отвечают этим решениям. Неприемлемое поведение, например манипуляция, токсикация содержимого, нарушение IP-адресов и сложенные ответы, должны быть запрещены.

Рассмотрим вариант использования, в котором компания медиа-развлечений хочет предоставить рекомендации с помощью моделей ИИ. Если компания не реализует ответственные протоколы ИИ и надлежащие протоколы безопасности, плохой субъект может взять под контроль модели. Модель может рекомендовать содержимое, которое причиняет вред. Для организации это поведение может привести к повреждению бренда, небезопасным средам и юридическим проблемам. Таким образом, поддержание надлежащей бдительности в течение жизненного цикла системы является важным и неизменяемым.

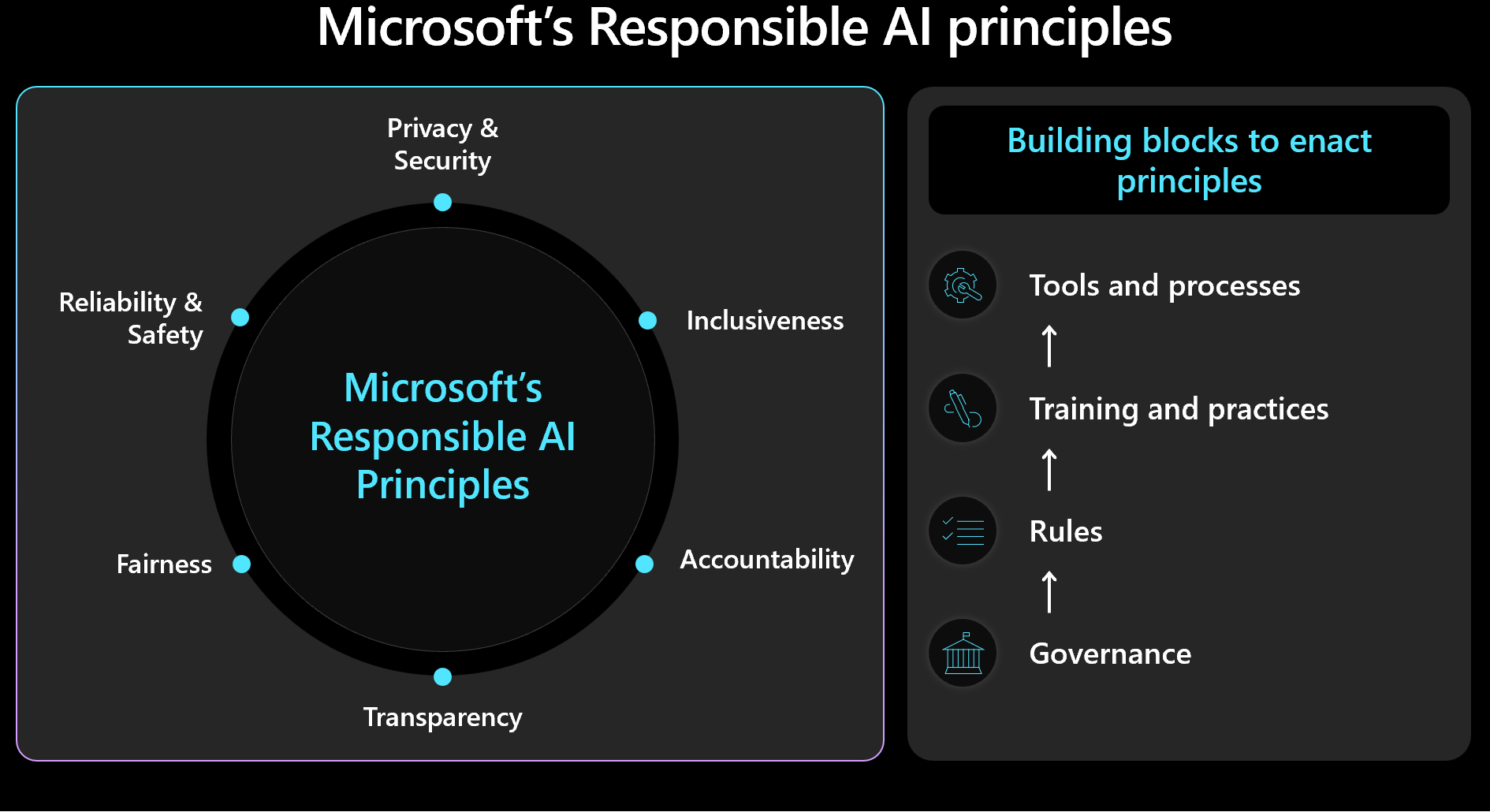

При принятии решений по проектированию следует учитывать приоритеты управления безопасностью и рабочей нагрузкой и учитывать результаты человеческой нагрузки. Ознакомьтесь с фреймворком Майкрософт для ответственного ИИ и убедитесь, что вы измеряете и реализуете принципы фреймворка в своей разработке. На следующем рисунке показаны основные понятия платформы.

Внимание

Точность прогнозов и метрик ответственного ИИ обычно связаны друг с другом. Повышая точность модели, вы можете повысить её справедливость и соответствие реальности. Ответственный ИИ часто соответствует точности, но точность сама по себе не включает все соображения безопасности. Важно проверить эти принципы ответственно.

В этой статье приводятся рекомендации по ответственному принятию решений, проверке входных данных пользователей и обеспечению безопасного взаимодействия с пользователем. Он также предоставляет рекомендации по обеспечению безопасности данных для защиты данных пользователей.

Рекомендации

В следующей таблице приведены рекомендации в этой статье.

| Рекомендация | Description |

|---|---|

| Разработка политик, которые применяют моральные практики на каждом этапе жизненного цикла. | Включите элементы контрольного списка, которые явно определяют требования к безопасности и адаптированы к контексту рабочей нагрузки. Примеры включают прозрачность пользовательских данных, конфигурацию согласия и процедуры для обработки права на забытие (RTBF). ▪ Разработайте ваши политики ответственного ИИ ▪ Обеспечить управление политиками для ответственного ИИ |

| Защитить данные пользователей с целью максимальной конфиденциальности. | Соберите только необходимые сведения и с соответствующим согласием пользователя. Применение технических элементов управления для защиты профилей пользователей, их данных и доступа к этим данным. ▪ обрабатывать данные пользователей соответствующим образом ▪ Проверка входящих и исходящих данных |

| держите решения искусственного интеллекта ясными и понятными. | Четко объясните, как работают алгоритмы рекомендаций. Предоставьте пользователям аналитические сведения об использовании данных и принятии алгоритмических решений, чтобы помочь им понять и доверять процессу. ▪ Безопасное взаимодействие с пользователем |

Разработка политик ответственного искусственного интеллекта

Задокументируйте подход к ответственному использованию ИИ. Четко сформулируйте политики, применяемые на каждом этапе жизненного цикла, чтобы команда, ответственная за рабочие нагрузки, понимала свои обязанности. Стандарты Майкрософт для ответственного ИИ предоставляют рекомендации, но необходимо определить, что эти рекомендации означают специально для вашего контекста.

Например, политики должны включать контрольный список элементов для механизмов, поддерживающих прозрачность пользовательских данных и конфигурацию согласия. В идеале эти механизмы должны позволить пользователям отказаться от включения данных. Конвейеры данных, анализ, обучение модели и другие этапы должны уважать этот выбор. Еще одним примером являются процедуры обработки RTBF. Обратитесь к отделу этики вашей организации и юридической группе, чтобы принять обоснованные решения.

Создайте прозрачные политики для использования данных и принятия алгоритмических решений, чтобы помочь пользователям понять и доверять процессу. Задокументируйте эти решения, чтобы сохранить четкую историю потенциальных будущих судебных процессов.

Реализация ответственного искусственного интеллекта включает три ключевые роли: исследовательскую группу, группу политики и инженерную команду. Совместная работа между этими командами должна быть введена в эксплуатацию. Если у вашей организации есть существующая команда, используйте их работу. В противном случае создайте эти методики самостоятельно.

Каждая команда должна иметь свои обязанности. Например:

Исследовательская группа проводит обнаружение рисков путем консультаций по организационным рекомендациям, отраслевым стандартам, законам, нормативным требованиям и известной тактике красной команды.

Команда разработчиков политик разрабатывает политики, относящиеся к рабочей нагрузке. Они включают в себя руководящие принципы родительской организации и нормативных актов правительства.

инженерная команда внедряет политики в свои процессы и результаты. Команда проверяет и проводит тестирование на соответствие.

Каждая команда формализирует свои рекомендации, но команда рабочей нагрузки должна отвечать за свои собственные документированные методики. Команда должна четко документировать любые дополнительные шаги или преднамеренные отклонения, чтобы убедиться, что не существует неоднозначности о том, что разрешено. Команда также должна быть прозрачной в отношении любых потенциальных недостатков или непредвиденных результатов в решении.

Обеспечение соблюдения политик ответственного искусственного интеллекта

Разработайте рабочую нагрузку, чтобы обеспечить соответствие организационным и нормативным требованиям. Например, если прозрачность является требованием организации, определите, как она применяется к рабочей нагрузке. Определите области в проектировании, жизненном цикле, коде или других компонентах, в которых необходимо внедрить функции прозрачности для удовлетворения этого стандарта.

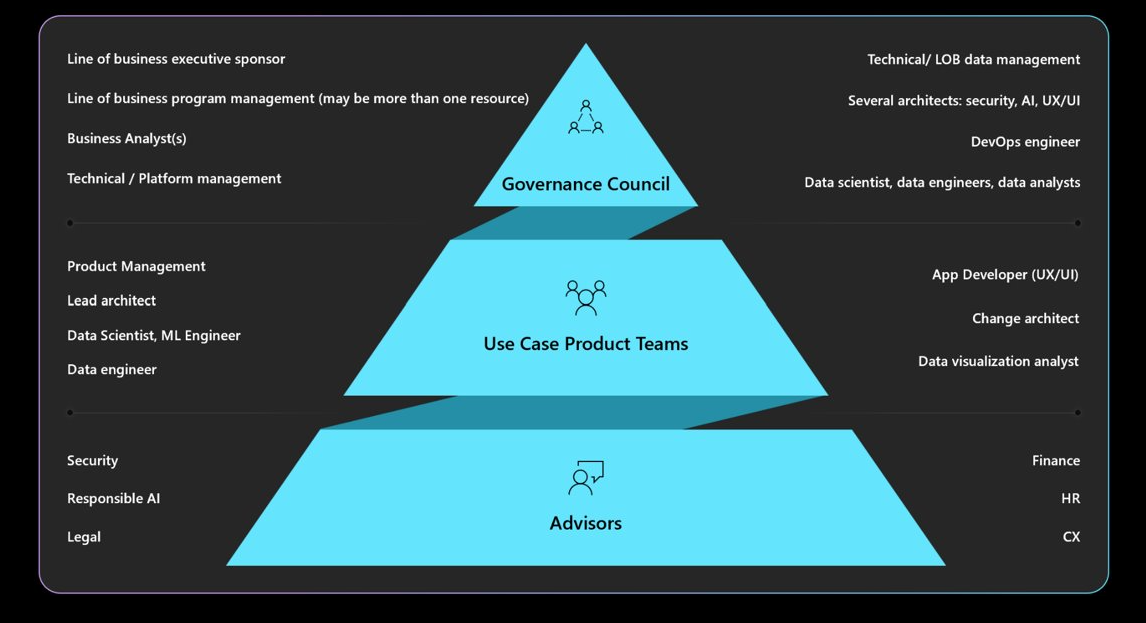

Ознакомьтесь с необходимыми требованиями к управлению, подотчетности, советам по обзору и мандатам отчетности. Убедитесь, что ваш совет по управлению утверждает и заверяет проекты рабочих нагрузок, чтобы избежать их переработки и уменьшить риски, касающиеся безопасности или конфиденциальности. Возможно, потребуется пройти несколько уровней утверждения. На следующей схеме описана типичная структура управления в организации.

Дополнительные сведения о политиках организации и утверждающих см. в статье Определение ответственной стратегии ИИ.

Безопасное взаимодействие с пользователем

Взаимодействие с пользователями должно основываться на отраслевых рекомендациях. Используйте библиотеку конструктора microsoft Human-AI интерфейсов, которая включает принципы и предоставляет рекомендации по реализации. Он также содержит примеры из продуктов Майкрософт и других отраслевых источников.

На протяжении всего жизненного цикла взаимодействия с пользователем существуют обязанности, связанные с управлением рабочей нагрузкой. Они начинают с намерения пользователя использовать систему, и они продолжаются на протяжении сеанса и во время каких-либо нарушений, вызванных системными ошибками. Рассмотрим следующие методики.

Создайте прозрачность. Узнайте, как система создает ответы на запрос.

Включите ссылки на источники данных, к которым модель обращается для прогнозирования. Эта практика повышает доверие пользователей, показывая им источники информации. Проектирование данных должно включать эти источники в метаданные. Например, когда оркестратор в приложении с дополнением для извлечения информации выполняет поиск, он извлекает 20 блоков документов и отправляет первые 10 блоков в модель в качестве контекста. Первые 10 блоков принадлежат трем разным документам. Затем пользовательский интерфейс может ссылаться на эти три исходных документа при отображении ответа модели. Эта прозрачность повышает доверие пользователей.

Прозрачность становится более важной при использовании агентов, которые служат посредниками между интерфейсными интерфейсами и внутренними системами. Например, в системе оформления заявок код оркестрации интерпретирует намерение пользователя и вызывает интерфейсы программирования приложений (API) агентов для получения необходимых сведений. Предоставление этих взаимодействий помогает пользователю знать о действиях системы.

Для автоматизированных рабочих процессов, включающих несколько агентов, создайте файлы журналов, которые записывают каждый шаг. Файлы журналов помогают выявлять и исправлять ошибки. Они также предоставляют пользователям объяснение решений, что способствует прозрачности.

Внимание

При реализации рекомендаций по прозрачности избегайте перегруженности пользователя информацией. Берите постепенный подход с помощью минимально разрушительных методов пользовательского интерфейса.

Например, отображайте всплывающую подсказку, которая показывает оценку уверенности модели. Вы можете включить ссылки, такие как ссылки на исходные документы, которые пользователи могут выбрать для получения дополнительных сведений. Этот метод, инициированный пользователем, сохраняет неразверчивый пользовательский интерфейс и позволяет пользователям искать дополнительные сведения только в том случае, если они решили.

Сбор отзывов. Реализуйте механизмы обратной связи.

Избегайте подавляющего большинства пользователей с обширными анкетами после каждого ответа. Вместо этого используйте быстрые и простые механизмы обратной связи, такие как пальцы вверх или пальцы вниз, или система оценки для конкретных аспектов ответа в масштабе от 1 до 5. Эти методы помогают улучшать систему с течением времени и позволяют обеспечить детализированную обратную связь без навязчивого вмешательства. Помните о возможных вопросах справедливости в обратной связи, поскольку за ответами пользователей могут стоять вторичные мотивы.

Реализация механизма обратной связи влияет на архитектуру из-за необходимости хранения данных. При необходимости обработайте отзывы, такие как данные пользователей и применяйте уровни контроля конфиденциальности.

Помимо обратной связи, соберите отзывы об эффективности взаимодействия с пользователем. Сбор метрик взаимодействия с помощью стека мониторинга системы.

Операционные меры безопасности содержимого

Интеграция безопасности содержимого в каждый этап жизненного цикла ИИ с помощью пользовательского кода решения, соответствующих инструментов и эффективных методик безопасности. Рассмотрим следующие стратегии.

Анонимизировать данные. При переходе данных от приема к обучению или оценке реализуйте проверки таким образом, чтобы свести к минимуму риск утечки персональных данных и избежать воздействия необработанных пользовательских данных.

Умеренное содержимое. Используйте API безопасности содержимого, который оценивает запросы и ответы в режиме реального времени. Убедитесь, что эти API доступны.

Выявление и устранение угроз. Применяйте известные методики безопасности к сценариям искусственного интеллекта. Например, выполните моделирование угроз, а затем задокументируйте угрозы и способы их устранения. Типичные методики безопасности, такие как упражнения красной команды, применяются к рабочим нагрузкам ИИ. Красные команды могут проверить, могут ли модели управляться для создания вредного содержимого. Эти действия должны быть интегрированы в операции искусственного интеллекта.

Дополнительные сведения см. в разделе Планирование красной команды для больших языковых моделей и приложений.

Используйте правильные метрики. Используйте метрики, которые эффективно измеряют поведение модели. Метрики зависят от типа модели ИИ. В некоторых случаях измерение генерируемых моделей может не применяться к моделям регрессии. Например, модель прогнозирует продолжительность жизни, а результаты влияют на страховые ставки. Проблемы справедливости в этой модели могут привести к вреду, связанному с справедливостью. Эта проблема возникает из-за отклонений в проверке основных метрик, так как метрики справедливости и точности обычно связаны друг с другом. Повышение точности для снижения вреда, связанного с справедливостью.

Добавьте соответствующую инструментовку. Результаты модели ИИ должны быть объяснимыми. Необходимо обосновывать и отслеживать, как делаются выводы, включая обучающие данные, вычисляемые признаки и опорные данные. В дискриминируемом ИИ вы можете выполнить пошаговые решения. Однако для генеривных моделей объяснение результатов может быть сложным. Задокументируйте процесс принятия решений для решения потенциальных юридических последствий и обеспечения прозрачности.

Этот аспект объясняемости следует реализовать на протяжении всего жизненного цикла ИИ. Очистка данных, происхождение, критерии выбора и обработка являются критическими этапами, в которых следует отслеживать решения.

Инструменты

Интеграция средств для обеспечения безопасности содержимого и отслеживания данных, таких как Microsoft Purview. API безопасности содержимого Azure можно вызывать из тестирования, чтобы упростить тестирование безопасности содержимого.

Azure AI Foundry предоставляет метрики, которые оценивают поведение модели. Дополнительные сведения см. в разделе "Метрики оценки и мониторинга" для создания искусственного интеллекта.

См. метрики , которые предоставляет платформа машинного обучения Azureдля обучения моделей.

Проверка входящих и исходящих данных

Атаки на внедрение запросов, такие как нарушение тюрьмы, являются распространенной проблемой для рабочих нагрузок ИИ. В этом случае некоторые пользователи могут попытаться использовать модель в непреднамеренных целях. Чтобы обеспечить безопасность, проверять данные, чтобы предотвратить атаки и отфильтровывать неуместное содержимое. Примените этот анализ как к входным данным пользователя, так и к ответам системы, чтобы обеспечить тщательную модерацию содержимого в входящих потоках и исходящих потоках.

В некоторых случаях необходимо выполнить несколько вызовов модели, например с помощью Службы Azure OpenAI, для обслуживания одного клиентского запроса. В этих сценариях применение проверок безопасности содержимого к каждому вызову может быть дорогостоящим и ненужным. Рассмотрите возможность централизованной работы в архитектуре при сохранении безопасности на стороне сервера. Предположим, что архитектура имеет шлюз перед конечной точкой вывода модели, чтобы выгрузить определенные внутренние возможности. Этот шлюз можно разработать для обработки проверок безопасности содержимого для запросов и ответов, которые серверная часть может не поддерживать нативно. Хотя шлюз является обычным решением, уровень оркестрации может эффективно обрабатывать эти задачи в простых архитектурах. В обоих случаях можно выборочно применять эти проверки при необходимости, что оптимизирует производительность и затраты.

проверки должны быть многомодальными и охватывать различные форматы. При использовании многомодальных входных данных, таких как изображения, важно проанализировать их для скрытых сообщений, которые могут быть вредными или насильственными. Эти сообщения могут быть не сразу видимыми, поэтому им требуется тщательная проверка. Используйте такие средства, как API безопасности содержимого для этой цели.

Чтобы обеспечить соблюдение политик конфиденциальности и безопасности данных, проверьте данные пользователей и данные о соответствии нормативным требованиям о конфиденциальности. Убедитесь, что данные санируются или фильтруются по мере его прохождения через систему. Например, данные из предыдущих бесед в службе поддержки клиентов могут служить основными данными. Перед повторной использованием эти данные следует дезинфисировать.

Обработка пользовательских данных соответствующим образом

Ответственные практики включают в себя тщательную обработку управления данными пользователей. Это управление включает в себя знание того, когда следует использовать данные и когда избежать использования пользовательских данных.

Практика рассуждений без обмена данными пользователя. Для безопасного совместного использования данных пользователей с другими организациями для получения аналитических сведений используйте модель очистки. В этом сценарии организации предоставляют данные доверенному партнеру, который обучает модель с помощью агрегированных данных. Затем все учреждения могут использовать эту модель и предоставлять аналитические сведения без предоставления отдельных наборов данных. Цель состоит в том, чтобы использовать возможности вывода модели без предоставления общего доступа к подробным данным обучения.

Повышение разнообразия и инклюзивности. Если необходимо использовать данные пользователей, используйте разнообразие данных, включая жанры и создателей, которые недопредставлены, с целью снижения несправедливости. Реализуйте функции, которые поощряют пользователей изучать новое и разнообразное содержимое. Отслеживайте использование на постоянной основе и корректируйте рекомендации, чтобы избежать чрезмерного использования любого одного типа контента.

Уважайте RTBF. Избегайте использования пользовательских данных, когда это возможно. Помогите обеспечить соответствие RTBF, выполнив необходимые меры, чтобы убедиться, что пользовательские данные удаляются старательно.

Чтобы обеспечить соответствие требованиям, могут возникнуть запросы на удаление пользовательских данных из системы. Для небольших моделей можно удалить пользовательские данные, повторно обучив модель с помощью данных, которые исключают личную информацию. Для более крупных моделей, которые могут состоять из нескольких небольших, независимо обученных моделей, процесс более сложный, а затраты и усилия являются значительными. Ищите юридические и этические рекомендации по обработке этих ситуаций и убедитесь, что они включены в ваши политики ответственного искусственного интеллекта.

Сохраняйте данные ответственно. Если удаление данных невозможно, получите явное согласие пользователя для сбора данных и предоставьте четкие политики конфиденциальности. Сбор и хранение данных только при абсолютной необходимости. Выполняйте операции для агрессивного удаления данных, когда они больше не нужны. Например, очистите журнал чата сразу после практического использования и анонимизируйте конфиденциальные данные перед хранением. Используйте расширенные методы шифрования для неактивных данных.

Поддержка объяснимости. Решения трассировки в системе для поддержки требований к объяснимости. Разработка четких объяснений того, как работают алгоритмы рекомендаций. Предоставьте пользователям аналитические сведения о том, почему для них рекомендуется определенное содержимое. Цель заключается в том, чтобы рабочие нагрузки ИИ и их результаты были прозрачными и оправданными, детализовав, как они принимаются решения, какие данные они используют, и как были обучены модели.

Шифрование данных пользователя. Входные данные должны быть зашифрованы на каждом этапе конвейера обработки данных с момента ввода пользователем данных. Эти этапы включают данные, которые перемещаются с одной точки на другую, данные, которые хранятся, и данные, которые обрабатываются при необходимости. Балансируйте безопасность и функциональные возможности и стремитесь обеспечивать конфиденциальность данных на протяжении всего жизненного цикла.

Предоставление надежных элементов управления доступом. Несколько типов удостоверений могут потенциально получить доступ к данным пользователя. Реализуйте управление доступом на основе ролей для плоскости управления и плоскости данных, чтобы он охватывал взаимодействие между пользователями и системой.

Обеспечение надлежащей сегментации пользователей для защиты конфиденциальности. Например, Microsoft 365 Copilot может выполнять поиск и предоставлять ответы на основе определенных документов и сообщений электронной почты пользователя, обеспечивая доступ только к содержимому, соответствующему этому пользователю.

Уменьшите область поверхности. Основная стратегия столпа безопасности фреймворка Well-Architected — уменьшить поверхность атаки и укрепить ресурсы. Эту стратегию следует применять к стандартным методам безопасности конечных точек, жестко контролируя конечные точки API, предоставляя только важные данные и избегая дополнительных сведений в ответах. Сбалансируйте выбор дизайна между гибкостью и контролем.

Убедитесь, что нет анонимных конечных точек. Как правило, не предоставляйте пользователям больше контроля, чем необходимо. В большинстве случаев пользователям не нужно настраивать гиперпараметры, за исключением экспериментальных сред. В типичных случаях использования, таких как взаимодействие с виртуальным агентом, пользователи должны контролировать только важные аспекты, чтобы обеспечить безопасность путем ограничения ненужных элементов управления.

Дополнительные сведения см. в статье Проектирование приложений для рабочих нагрузок ИИ в Azure.