Обзор виртуальных машин серии HBv3

Применимо к: ✔️ Виртуальные машины Linux ✔️ Виртуальные машины Windows ✔️ Универсальные масштабируемые наборы

Характеристики сервера серии HBv3: 2 * 64-ядерных процессора EPYC 7V73X, всего 128 физических ядер "Zen3" с помощью технологии AMD 3D V-Cache. Одновременная многопоточность (SMT) отключена для серии HBv3. Эти 128 ядер разделены на 16 разделов (8 на сокет), каждый раздел содержит 8 ядер процессора с равномерным доступом к кэшу третьего уровня 96 МБ. На серверах Azure HBv3 также используются следующие параметры для BIOS компании AMD:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

В результате сервер загружается с 4 домена NUMA (2 на сокет). Каждый домен имеет размер 32 ядер. Каждый NUMA имеет прямой доступ к 4 каналам физической DRAM, работающей в 3200 MT/s.

Чтобы работа гипервизора Azure не мешала работе виртуальной машины, мы резервируем 8 физических ядер для каждого сервера.

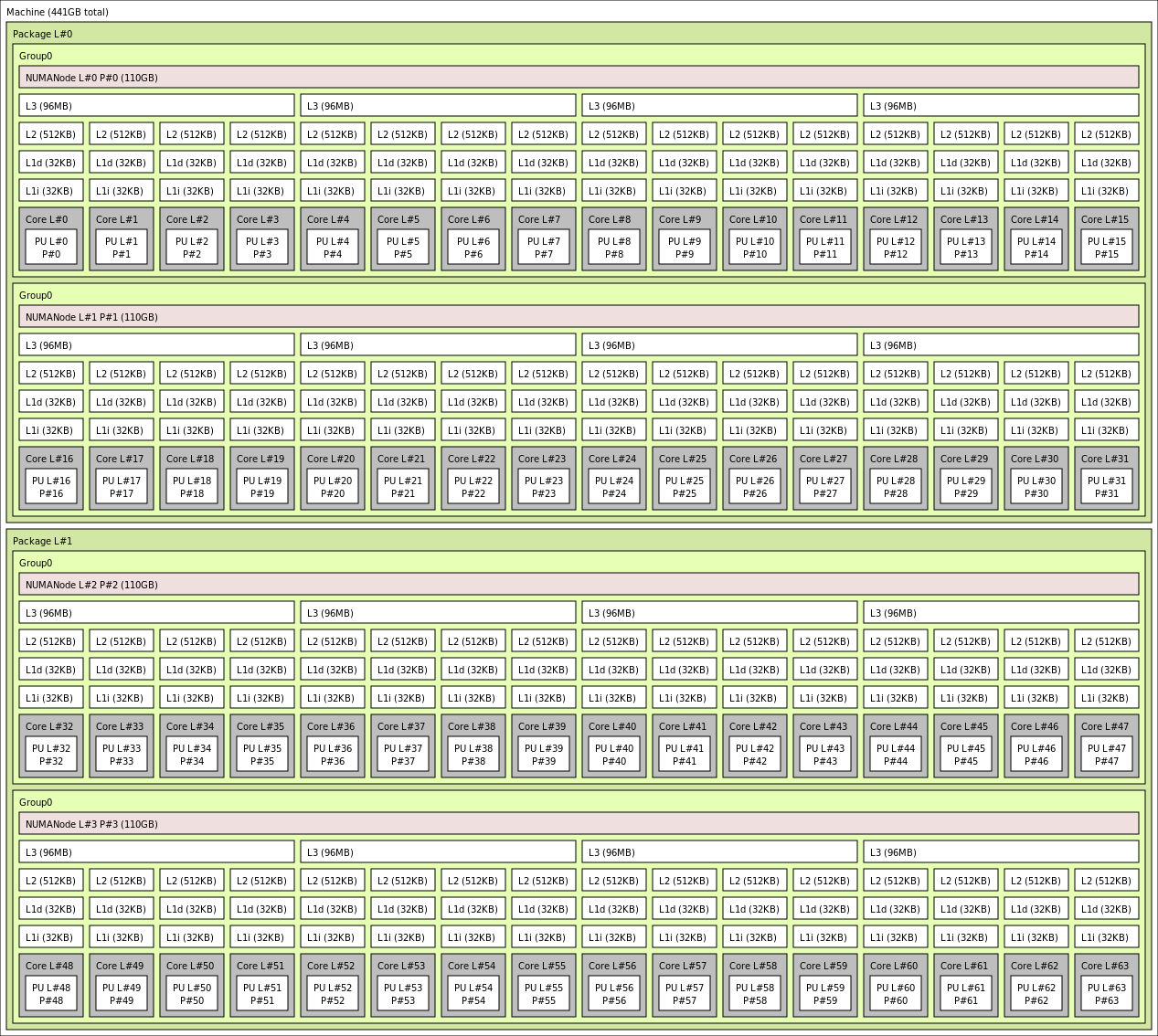

Топология виртуальной машины

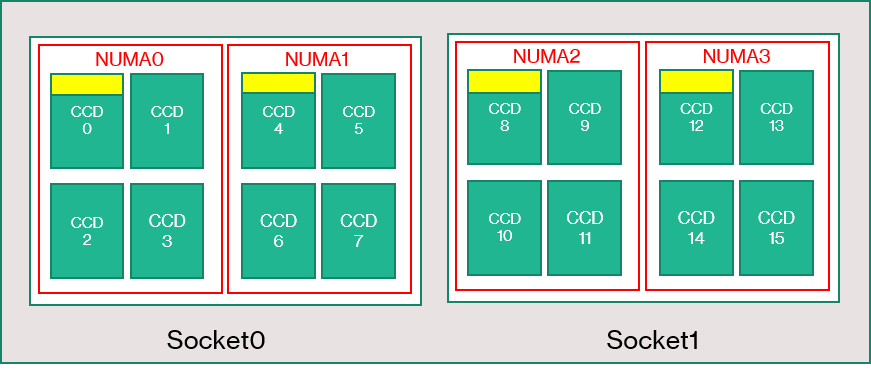

На следующей схеме показана топология сервера. Мы зарезервировали 8 ядер узла гипервизора (желтый) симметрично в обоих сокетах ЦП, первые 2 ядра из которых взяты с конкретных устройств Core Complex Dies (ПЗС) в каждом домене NUMA, а оставшиеся ядра предназначены для виртуальной машины серии HBv3 (зеленый).

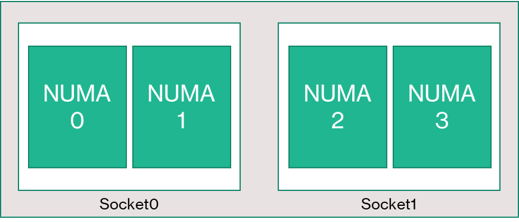

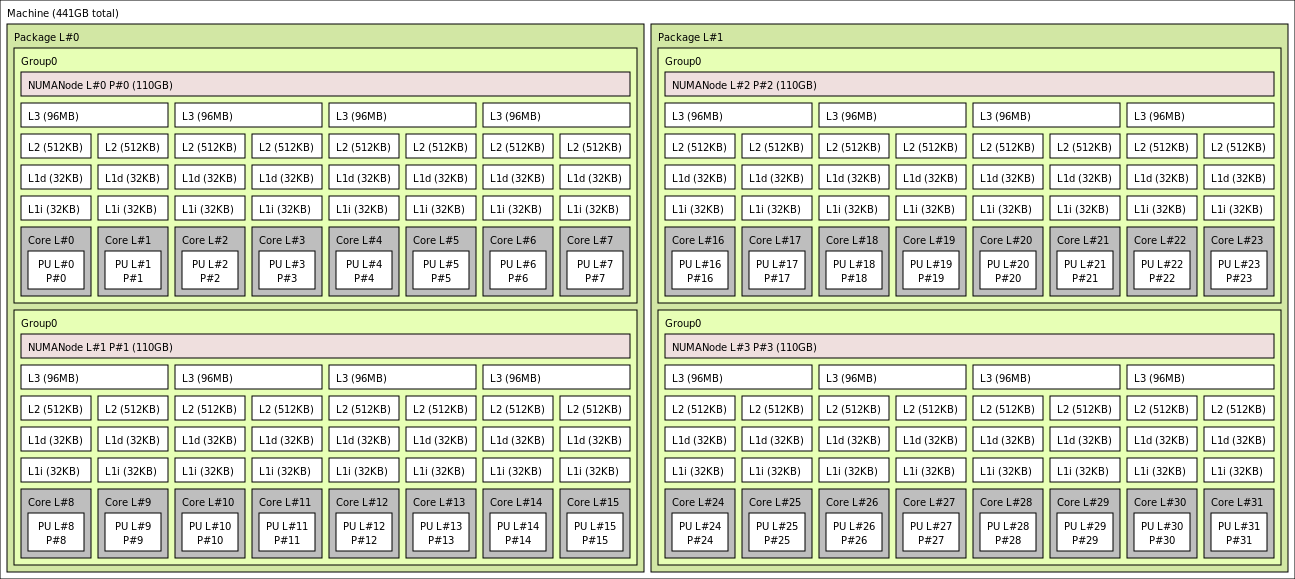

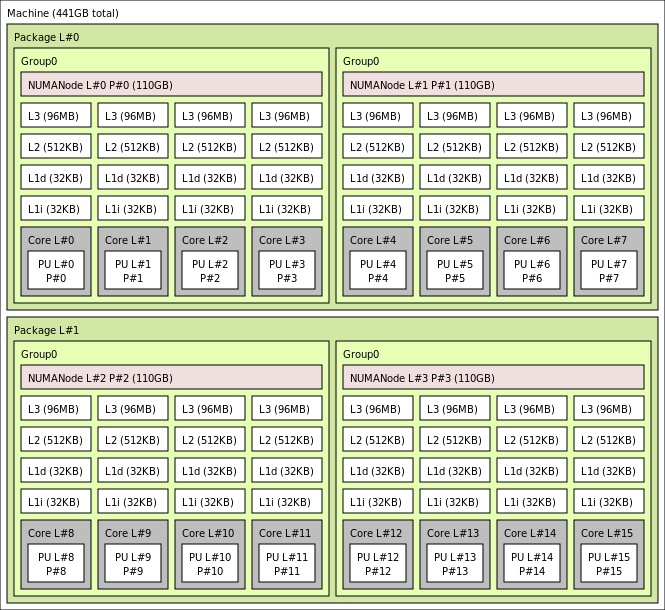

Граница CCD не эквивалентна границе NUMA. В HBv3 группа из четырех последовательных (4) CCD настраивается как домен NUMA, как на уровне узла, так и на гостевой виртуальной машине. Таким образом, все размеры виртуальных машин HBv3 предоставляют 4 домена NUMA, которые отображаются в ОС и приложении, как показано ниже. 4 универсальных доменов NUMA, каждый из которых отличается от количества ядер в зависимости от конкретного размера виртуальной машины HBv3.

Каждый размер виртуальной машины HBv3 аналогичен физическому макету, возможностям и производительности другого ЦП из серии AMD EPYC 7003, как показано ниже:

| Размер виртуальной машины серии HBv3 | Домены NUMA | Количество ядер на домен NUMA | Сходство с AMD EPYC |

|---|---|---|---|

| Standard_HB120rs_v3 | 4 | 30 | Два разъема EPYC 7773X |

| Standard_HB120-96rs_v3 | 4 | 24 | Два разъема EPYC 7643 |

| Standard_HB120-64rs_v3 | 4 | 16 | Два разъема EPYC 7573X |

| Standard_HB120-32rs_v3 | 4 | 8 | Два разъема EPYC 7373X |

| Standard_HB120-16rs_v3 | 4 | 4 | Два разъема EPYC 72F3 |

Примечание.

Размеры виртуальных машин с ограниченным количеством ядер уменьшают только количество физических ядер, предоставленных виртуальной машине. Все глобальные общие ресурсы (ОЗУ, пропускная способность памяти, кэш третьего уровня, подключение GMI и xGMI, InfiniBand, сеть Ethernet Azure, локальный SSD) остаются постоянными. Это позволяет клиенту выбрать размер виртуальной машины, наиболее подходящий для определенного набора рабочих нагрузок или лицензирования программного обеспечения.

Виртуальное сопоставление NUMA для каждого размера виртуальной машины HBv3 сопоставляется с базовой физической топологией NUMA. Не существует потенциально неверной абстракции топологии оборудования.

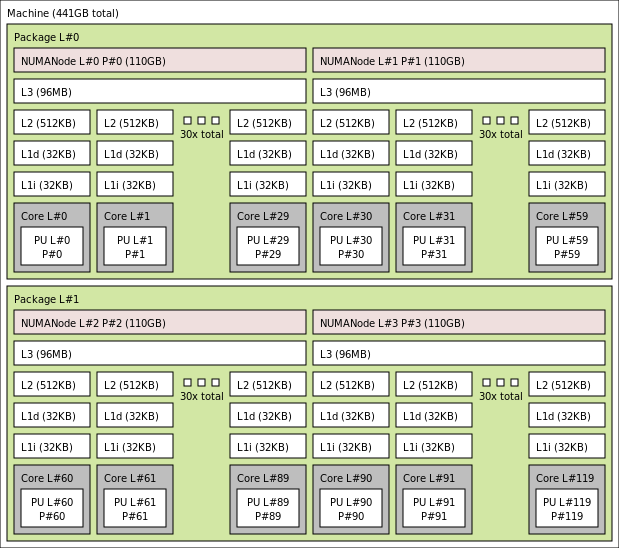

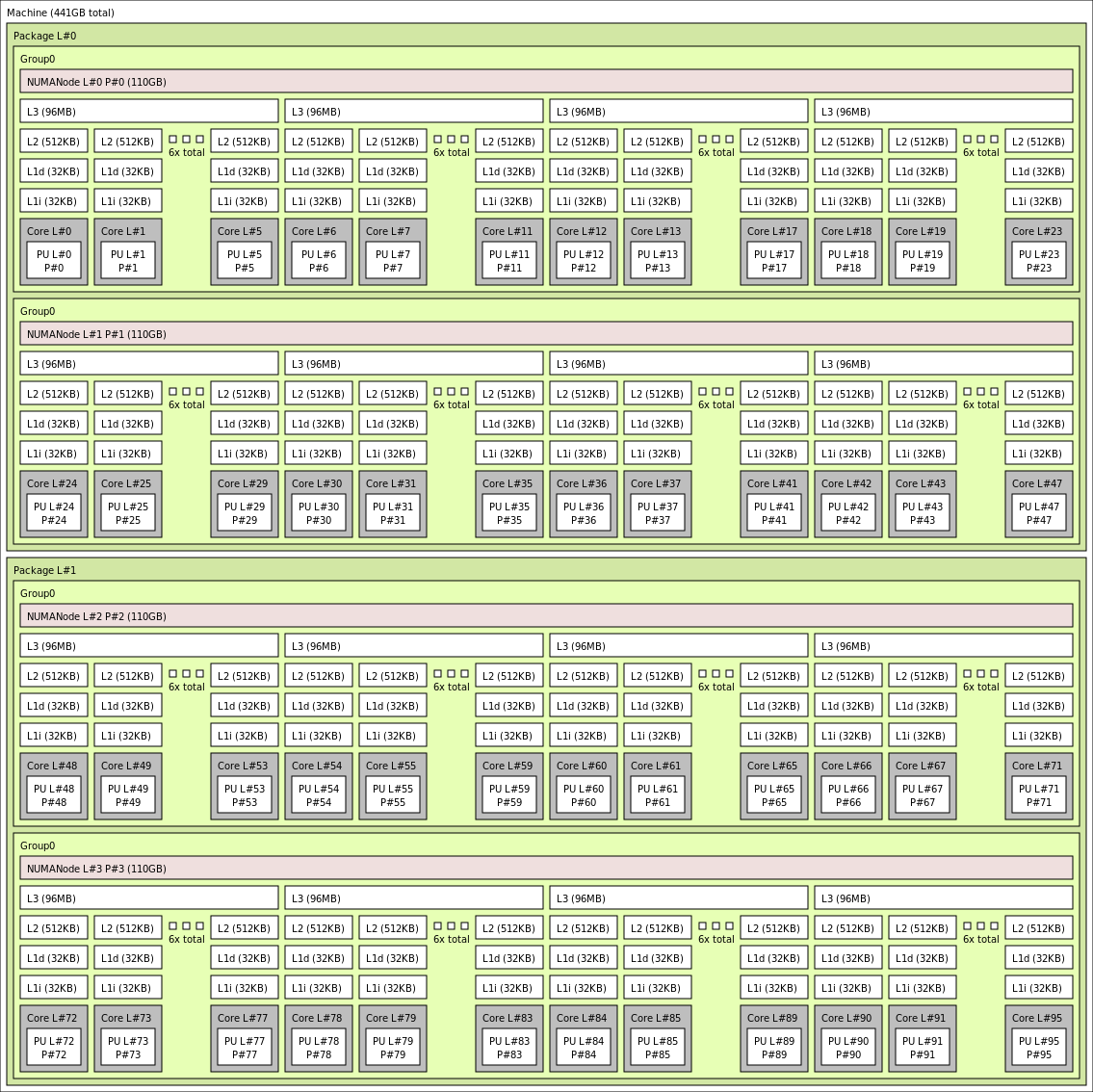

Точная топология для различных размеров виртуальной машины HBv3 выглядит следующим образом, если использовать выходные данные lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Щелкните, чтобы посмотреть выходные данные lstopo для Standard_HB120rs_v3

Щелкните, чтобы посмотреть выходные данные lstopo для Standard_HB120rs-96_v3

Щелкните, чтобы посмотреть выходные данные lstopo для Standard_HB120rs-64_v3

Щелкните, чтобы посмотреть выходные данные lstopo для Standard_HB120rs-32_v3

Щелкните, чтобы посмотреть выходные данные lstopo для Standard_HB120rs-16_v3

Сеть InfiniBand

Виртуальные машины HBv3 также могут иметь сетевые адаптеры NVIDIA Mellanox HDR InfiniBand (ConnectX-6) со скоростью до 200 Гбит/с. Сетевой адаптер передается на виртуальную машину через SRIOV, что позволяет использовать сетевой трафик для обхода гипервизора. Это приводит к тому, что клиенты загружают стандартные драйверы Mellanox OFED на виртуальные машины HBv3, как на компьютер без операционной системы.

Виртуальные машины HBv3 поддерживают адаптивную маршрутизацию, динамический подключенный транспорт (DCT, а также стандартные транспорты RC и UD), а также аппаратные разгрузки коллективов MPI на процессор подключения адаптера ConnectX-6. Эти функции повышают производительность приложений, масштабируемость и согласованность и рекомендуется использовать их.

Временное хранилище

Виртуальные машины HBv3 оснащены 3 физическими локальными устройствами SSD. Одно устройство предварительно отформатировано, чтобы служить файлом страницы, и он появился в виртуальной машине в качестве универсального устройства SSD.

Два других более крупных устройства SSD предоставляются в виде неформатированных блочных устройств NVMe через NVMeDirect. По мере того как устройство NVMe блока проходит гипервизор, он имеет более высокую пропускную способность, более высокую скорость ввода-вывода в секунду и более низкую задержку на IOP.

При связывании в чередующемся массиве NVMe SSD обеспечивает скорость до 7 ГБ/с для операций чтения и 3 ГБ/с для операций записи, а также до 186 000 операций ввода-вывода для операций чтения и 201 000 операций ввода-вывода для операций записи для очередей большой длины.

Характеристики оборудования

| Характеристики оборудования | Виртуальные машины серии HBv3 |

|---|---|

| Ядра | 120, 96, 64, 32 или 16 (SMT отключено) |

| ЦП | AMD EPYC 7V73X |

| Частота ЦП (без AVX) | 3,0 ГГц (все ядра), 3,5 ГГц (до 10 ядер) |

| Память | 448 ГБ (ОЗУ на ядро зависит от размера виртуальной машины) |

| Локальный диск | Два NVMe емкостью 960 ГБ (блок), SSD емкостью 480 ГБ (файл подкачки) |

| Infiniband | 200 Гбит/с Mellanox ConnectX-6 HDR InfiniBand |

| Network | Ethernet 50 Гбит/с (доступно 40 Гбит/с) Azure SmartNIC второго поколения |

Характеристики программного обеспечения

| Характеристики программного обеспечения | Виртуальные машины серии HBv3 |

|---|---|

| Максимальный размер задания MPI | 36 000 ядер (300 виртуальных машин в одном масштабируемом наборе виртуальных машин с singlePlacementGroup=true) |

| Поддержка MPI | HPC-X, Intel MPI, OpenMPI, MVAPICH2, MPICH |

| Дополнительные платформы | UCX, libfabric, PGAS |

| Поддержка службы хранилища Microsoft Azure | Диски уровня "Стандартный" и "Премиум" (максимум 32 диска) |

| Поддержка ОС для SRIOV RDMA | RHEL 7.9+, Ubuntu 18.04+, SLES 15.4, WinServer 2016+ |

| Рекомендуемая операционная система для повышения производительности | Windows Server 2019+ |

| Поддержка Orchestrator | Azure CycleCloud, пакетная служба Azure, AKS; параметры конфигурации кластера |

Примечание.

Windows Server 2012 R2 не поддерживается на HBv3 и других виртуальных машинах с более чем 64 ядрами (виртуальными или физическими). Дополнительные сведения см. в статье "Поддерживаемые гостевые операционные системы Windows" для Hyper-V на Windows Server.

Внимание

Этот документ ссылается на версию выпуска Linux, которая приближается или находится в конце жизни(EOL). Пожалуйста, рассмотрите возможность обновления до более текущей версии.

Следующие шаги

- Ознакомьтесь с последними объявлениями, примерами рабочей нагрузки HPC, а также результатами оценки производительности в блогах технического сообщества Вычислений Azure.

- Сведения о более высоком уровне архитектурного представления выполнения рабочих нагрузок HPC см. в статье Высокопроизводительные вычисления (HPC) в Azure.