Получение дополненного поколения с помощью потока запроса Машинное обучение Azure (предварительная версия)

Внимание

Эта функция сейчас доступна в виде общедоступной предварительной версии. Эта предварительная версия предоставляется без соглашения об уровне обслуживания. Ее не следует использовать для производственных рабочих нагрузок. Некоторые функции могут не поддерживаться или их возможности могут быть ограничены.

Дополнительные сведения см. в статье Дополнительные условия использования Предварительных версий Microsoft Azure.

Извлечение дополненного поколения (RAG) — это шаблон, который работает с предварительно обученными крупными языковыми моделями (LLM) и собственными данными для создания ответов. Теперь RAG можно внедрять в поток запросов машинного обучения Azure. Сейчас поддержка RAG находится в общедоступной предварительной версии.

В этой статье перечислены некоторые преимущества RAG, техническая информация и описание поддержки RAG в Машинное обучение Azure.

Примечание.

Новые понятия LLM и RAG? Этот видеоролик из презентации Майкрософт предлагает простое объяснение.

Зачем использовать RAG?

Традиционно базовая модель обучена данными на определенный момент времени, чтобы обеспечить эффективность выполнения конкретных задач и адаптации к нужному домену. Однако иногда необходимо работать с более новыми или более текущими данными. Два подхода могут дополнить базовую модель: тонкой настройкой или дальнейшим обучением базовой модели с новыми данными или RAG, которая использует инженерию запросов для дополнения или руководства моделью в режиме реального времени.

Точное изменение подходит для непрерывной адаптации домена, что позволяет значительно улучшить качество модели, но часто влечет за собой более высокие затраты. И наоборот, RAG предлагает альтернативный подход, позволяя использовать ту же модель, что и подсистема рассудок по новым данным, предоставленным в запросе. Этот метод позволяет обучению в контексте без необходимости дорогостоящих тонкой настройки, что позволяет предприятиям эффективнее использовать LLM.

RAG позволяет предприятиям достичь настраиваемых решений при сохранении релевантности данных и оптимизации затрат. При внедрении RAG компании могут использовать возможности по поводу LLM, используя существующие модели для обработки и создания ответов на основе новых данных. RAG упрощает периодические обновления данных без необходимости точной настройки, упрощая интеграцию LLM с предприятиями.

- Предоставление дополнительных данных в виде директивы или запроса на LLM

- Добавляет компонент проверки фактов для существующих моделей

- Обучение модели на актуальных данных без дополнительных затрат на время и затраты, связанные с тонкой настройкой

- Обучение бизнес-данных

Технический обзор использования RAG в крупных языковых моделях (LLM)

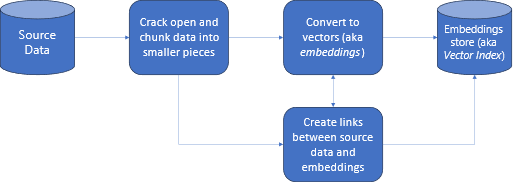

В получении информации RAG — это подход, позволяющий использовать возможности LLM с собственными данными. Включение LLM для доступа к пользовательским данным включает следующие действия. Во-первых, большие данные должны быть разделены на управляемые части. Во-вторых, блоки должны быть преобразованы в формат, доступный для поиска. В-третьих, преобразованные данные должны храниться в расположении, позволяющем эффективному доступу. Кроме того, важно хранить соответствующие метаданные для ссылок или ссылок, когда LLM предоставляет ответы.

Рассмотрим схему более подробно.

Исходные данные: это место, где существуют данные. Это может быть файл или папка на компьютере, файл в облачном хранилище, Машинное обучение Azure ресурс данных, репозиторий Git или база данных SQL.

Блокирование данных: данные в источнике необходимо преобразовать в обычный текст. Например, документы word или PDF-файлы должны быть открыты и преобразованы в текст. Затем текст фрагментируется на меньшие части.

Преобразование текста в векторы: называется внедрением. Векторы — это числовые представления концепций, преобразованные в числовые последовательности. Такое преобразование упрощает понимание компьютером связей между понятиями.

Связи между исходными данными и внедрением: эти сведения хранятся в виде метаданных на созданных блоках, которые затем используются для создания ссылок при создании ответов.

RAG с Машинное обучение Azure (предварительная версия)

RAG в Машинное обучение Azure включена интеграция с Azure OpenAI Service для больших языковых моделей и векторизации, с поддержкой Faiss и поиска ИИ Azure (ранее — когнитивный поиск) в качестве векторных хранилищ и поддержки открытый код предложений инструментов и платформ, таких как LangChain для фрагментирования данных.

Для реализации RAG необходимо выполнить несколько ключевых требований. Во-первых, данные должны быть отформатированы таким образом, чтобы обеспечить эффективную возможность поиска перед отправкой в LLM, что в конечном итоге снижает потребление маркеров. Чтобы обеспечить эффективность RAG, также важно регулярно обновлять данные на периодической основе. Кроме того, возможность оценить выходные данные из LLM с помощью ваших данных позволяет измерять эффективность ваших методов. Машинное обучение Azure не только позволяет легко приступить к работе с этими аспектами, но и позволяет улучшить и создать RAG. предложения Машинное обучение Azure:

- Примеры запуска сценариев Q&A на основе RAG.

- Интерфейс пользовательского интерфейса на основе мастера для создания данных и управления ими и их включения в потоки запросов.

- Возможность измерять и улучшать рабочие процессы RAG, включая создание тестовых данных, автоматическое создание запроса и визуализированные метрики оценки запросов.

- Расширенные сценарии с дополнительным контролем с помощью новых встроенных компонентов RAG для создания пользовательских конвейеров в записных книжках.

- Интерфейс кода, который позволяет использовать данные, созданные с помощью открытый код предложений, таких как LangChain.

- Простая интеграция рабочих процессов RAG в рабочие процессы MLOps с помощью конвейеров и заданий.

Заключение

Машинное обучение Azure позволяет включить RAG в ИИ с помощью Студия машинного обучения Azure или использования кода с конвейерами Машинное обучение Azure. Он предлагает несколько добавлений значений, таких как возможность измерения и улучшения рабочих процессов RAG, создания тестовых данных, автоматического создания запросов и визуализации метрик оценки запросов. Он позволяет интегрировать рабочие процессы RAG в рабочие процессы MLOps с помощью конвейеров. Вы также можете использовать данные с открытый код предложениями, такими как LangChain.

Следующие шаги

Использование векторных хранилищ с Машинное обучение Azure (предварительная версия)

Создание векторного индекса в потоке запросов Машинное обучение Azure (предварительная версия)