Параллелизация настройки гиперпараметров Hyperopt

Примечание.

Версия Hyperopt с открытым исходным кодом больше не поддерживается.

Hyperopt будет удален в следующей основной версии DBR ML. Azure Databricks рекомендует использовать Optuna для оптимизации на одном узле или RayTune для аналогичного опыта, который предоставляла устаревшая функция распределенной настройки гиперпараметров Hyperopt. Дополнительные сведения об использовании RayTune в Azure Databricks.

В этой записной книжке показано, как использовать Hyperopt для параллелизации вычислений для настройки гиперпараметров. Здесь используется класс SparkTrials для автоматического распределения вычислений между рабочими ролями кластера. Также демонстрируется автоматическое отслеживание запусков Hyperopt с помощью MLflow, так что вы можете сохранить результаты для последующего использования.

Параллельная настройка гиперпараметров с помощью автоматизированной записной книжки для отслеживания MLflow

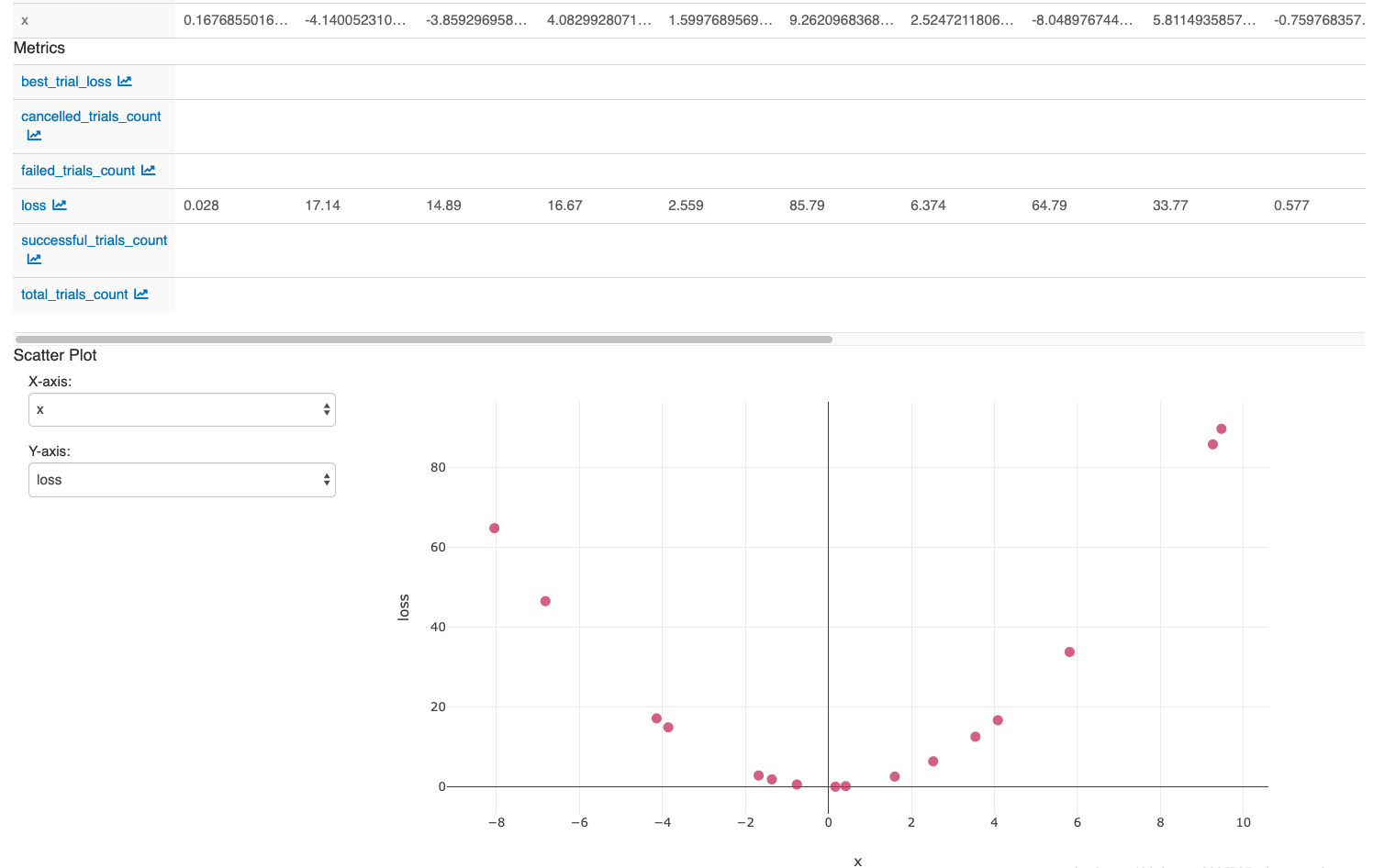

После выполнения действий в последней ячейке записной книжки в пользовательском интерфейсе MLflow должно отобразиться: