Эталонные архитектуры для Lakehouse (для скачивания)

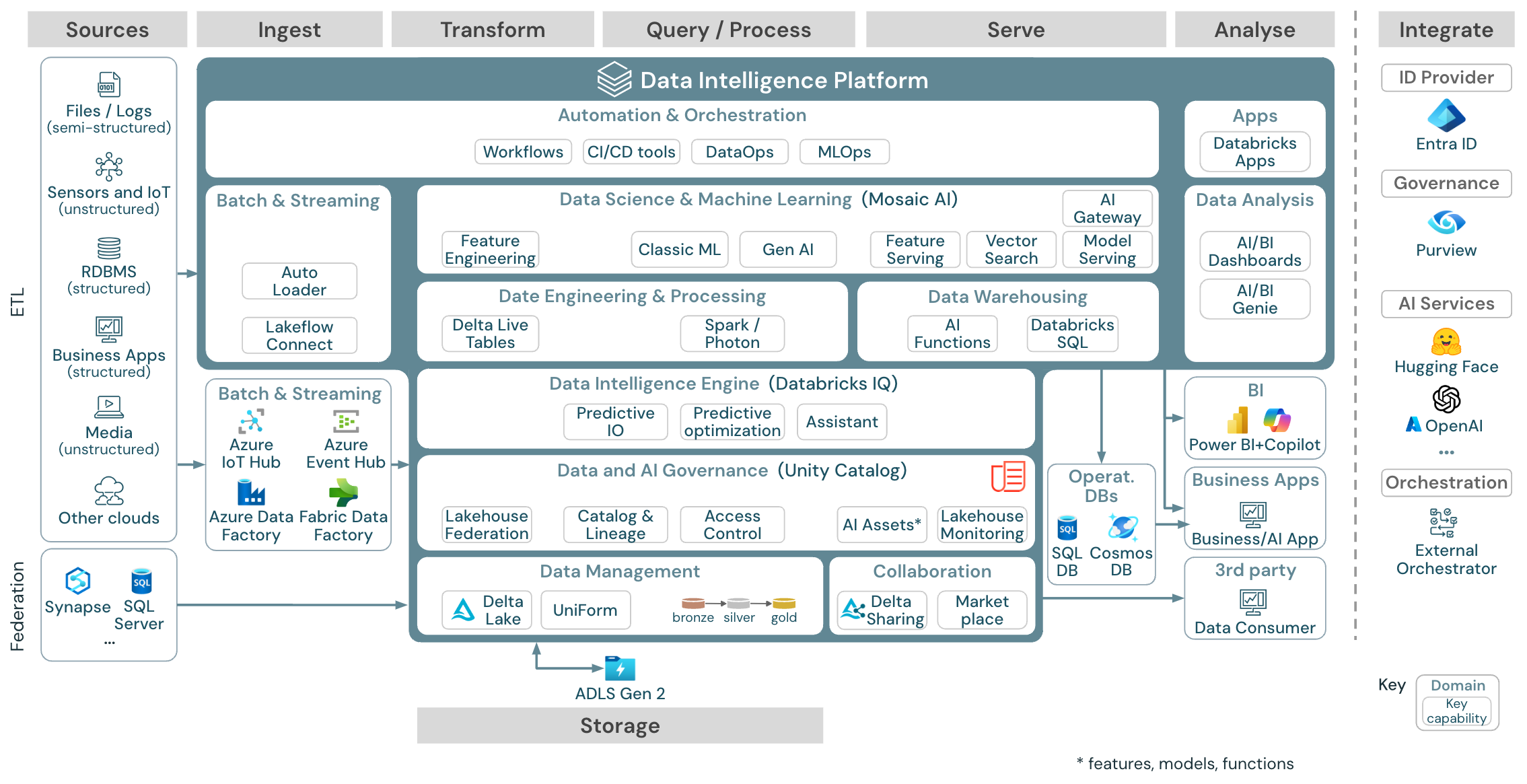

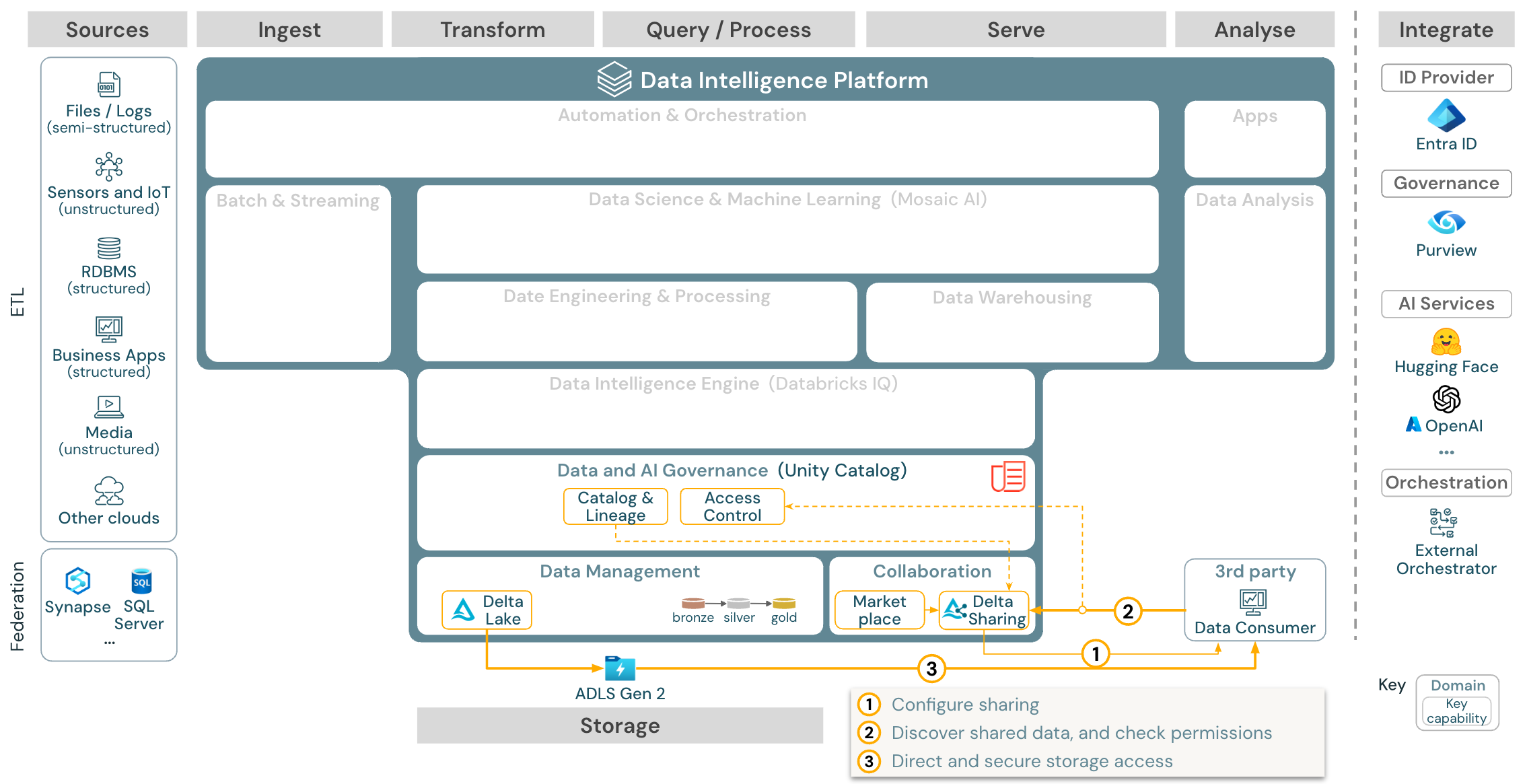

В этой статье описывается руководство по архитектуре lakehouse с точки зрения источника данных, приема данных, преобразования, запроса и обработки, обслуживания, анализа и хранения.

Каждая эталонная архитектура имеет скачиваемый PDF-файл в формате 11 x 17 (A3).

Хотя Lakehouse на Databricks является открытой платформой, которая интегрируется с большой экосистемой партнерских инструментов, эталонные архитектуры ориентированы исключительно на службы Azure и Lakehouse Databricks. Показаны службы поставщиков облачных служб, чтобы проиллюстрировать основные понятия и не являются исчерпывающими.

скачать: эталонная архитектура для Azure Databricks Lakehouse

Эталонная архитектура Azure показывает следующие службы Azure для приема, хранения, обслуживания и анализа:

- Azure Synapse и SQL Server в качестве исходных систем для Федерации Lakehouse

- Центр Интернета вещей Azure и Центры событий Azure для приема потоковой передачи

- Фабрика данных Azure для приема пакетной обработки

- Azure Data Lake Storage 2-го поколения (ADLS) в качестве хранилища объектов

- База данных SQL Azure и Azure Cosmos DB в качестве операционных баз данных

- Azure Purview в качестве корпоративного каталога, куда UC экспортирует информацию о схеме данных и её происхождении.

- Power BI в качестве средства бизнес-аналитики

Организация эталонных архитектур

Эталонная архитектура структурирована вдоль полос источник, прием, преобразование, запрос/процесс, обслуживание, анализ, и хранилище:

Источник

Архитектура отличается от полуструктурированных и неструктурированных данных (датчиков и Интернета вещей, мультимедиа, файлов и журналов) и структурированных данных (RDBMS, бизнес-приложений). Источники SQL (RDBMS) также можно интегрировать в lakehouse и каталог Unity без использования ETL через федерации lakehouse. Кроме того, данные могут загружаться из других поставщиков облачных служб.

Глотать

Данные можно получать в lakehouse с помощью пакетной или потоковой передачи:

- Databricks LakeFlow Connect предлагает встроенные коннекторы для интеграции с корпоративными приложениями и базами данных. Результирующий конвейер приема управляется каталогом Unity и работает на бессерверных вычислениях и Delta Live Tables.

- Файлы, доставленные в облачное хранилище, можно загружать непосредственно с помощью автозагрузчика Databricks.

- Для пакетного приема данных из корпоративных приложений в Delta Lake databricks lakehouseиспользует средства приема партнеров с определенными адаптерами для этих систем записей.

- События потоковой передачи можно получать непосредственно из систем потоковой передачи событий, таких как Kafka с помощью Структурированной потоковой передачи Databricks. Источники потоковой передачи могут быть датчиками, IoT или процессами отслеживания измененных данных.

Память

Данные обычно хранятся в облачной системе хранения, где конвейеры ETL используют архитектуру медальона для хранения данных в виде разностных файлов и таблиц.

преобразовать и выполнить запрос / обработку

Databricks lakehouse использует свои механизмы Apache Spark и Photon для всех преобразований и запросов.

DLT (Разностные динамические таблицы) — это декларативная платформа для упрощения и оптимизации надежных, обслуживаемых и тестируемых конвейеров обработки данных.

На базе Apache Spark и Photon платформа аналитики данных Databricks поддерживает оба типа рабочих нагрузок: SQL-запросы через хранилища SQL, а также рабочие нагрузки Python и Scala через кластеры рабочих областей.

Для обработки и анализа данных (моделирование машинного обучения и ИИ поколения) платформа Databricks AI и Машинное обучение предоставляет специализированные среды выполнения машинного обучения для AutoML и для написания заданий машинного обучения. Все рабочие процессы обработки и анализа данных и MLOps лучше всего поддерживаются MLflow.

обслуживание

Для вариантов использования DWH и BI lakehouse Databricks предоставляет Databricks SQL, хранилище данных на базе хранилищ SQL и бессерверные хранилища SQL.

Для машинного обучения обслуживание модели — это масштабируемая модель в режиме реального времени, предназначенная для обслуживания корпоративного уровня, размещенная в плоскости управления Databricks. шлюза ИИ Мозаики — это решение Databricks для управления и мониторинга доступа к поддерживаемым моделям создания ИИ и связанным с ними конечным точкам обслуживания моделей.

Операционные базы данных: внешние системы, такие как операционные базы данных, можно использовать для хранения и доставки конечных продуктов данных в пользовательские приложения.

Совместная работа: бизнес-партнеры получают безопасный доступ к данным, которые они нуждаются, с помощью Delta Sharing. На основе разностного общего доступа Databricks Marketplace является открытым форумом для обмена продуктами данных.

Анализ

Последние бизнес-приложения находятся в этой плаваловой полосе. Примеры включают в себя пользовательские клиенты, такие как приложения ИИ, подключенные к модели ИИ Мозаики для вывода в режиме реального времени или приложений, которые обращаются к данным, отправленным из lakehouse в операционную базу данных.

Для вариантов использования бизнес-аналитики обычно используют средства бизнес-аналитики для доступа к хранилищу данных. Разработчики SQL также могут использовать редактор SQL Databricks (не показан на схеме) для запросов и панелей мониторинга.

Платформа аналитики данных также предлагает панели мониторинга для создания визуализаций данных и обмена аналитическими сведениями.

Интегрируйте

Платформа Databricks интегрируется со стандартными поставщиками удостоверений для управления пользователями и единого входа (SSO).

Внешние службы ИИ, такие как OpenAI, LangChain или HuggingFace можно использовать непосредственно из платформы Аналитики Databricks.

Внешние оркестраторы могут использовать комплексный REST API или специализированные коннекторы для таких внешних средств оркестрации, как Apache Airflow.

Каталог Unity используется для всех данных, & управления ИИ в платформе Аналитики Databricks и может интегрировать другие базы данных в управление с помощью Федерации Lakehouse.

Кроме того, каталог Unity можно интегрировать в другие корпоративные каталоги, например Purview. Для получения сведений обратитесь к поставщику корпоративного каталога.

Общие возможности для всех рабочих нагрузок

Кроме того, Databricks lakehouse поставляется с возможностями управления, поддерживающими все рабочие нагрузки:

Управление данными и ИИ

Центральная система управления данными и ИИ в платформе аналитики данных Databricks — это Unity Catalog. Каталог Unity предоставляет одно место для управления политиками доступа к данным, которые применяются во всех рабочих областях и поддерживают все ресурсы, созданные или используемые в lakehouse, такие как таблицы, тома, компоненты (хранилище компонентов) и модели (реестр моделей). Каталог Unity также можно использовать для отслеживания происхождения данных среды выполнения в запросах, выполняемых в Databricks.

Databricks мониторинг lakehouse позволяет отслеживать качество данных во всех таблицах в вашей учетной записи. Он также может отслеживать производительность моделей машинного обучения и конечных точек, обслуживающих модели.

Для обеспечения наблюдаемости системная таблица — это аналитическое хранилище операционных данных вашей учетной записи, размещенное в Databricks. Системные таблицы можно использовать для исторической наблюдаемости в вашей учетной записи.

Подсистема аналитики данных

Платформа аналитики данных Databricks позволяет всей организации использовать данные и ИИ. Он работает с DatabricksIQ и объединяет генерированный ИИ с преимуществами объединения lakehouse, чтобы понять уникальную семантику ваших данных.

Помощник по Databricks доступен в записных книжках Databricks, редакторе SQL и редакторе файлов в качестве помощника по ИИ с учетом контекста для разработчиков.

автоматизация & оркестрация

Databricks Jobs управляет обработкой данных, машинным обучением и конвейерами аналитики на платформе Databricks Data Intelligence. Разностные динамические таблицы позволяют создавать надежные и обслуживаемые конвейеры ETL с декларативным синтаксисом. Платформа также поддерживает CI/CD и MLOps

Высокоуровневые варианты использования платформы аналитики данных в Azure

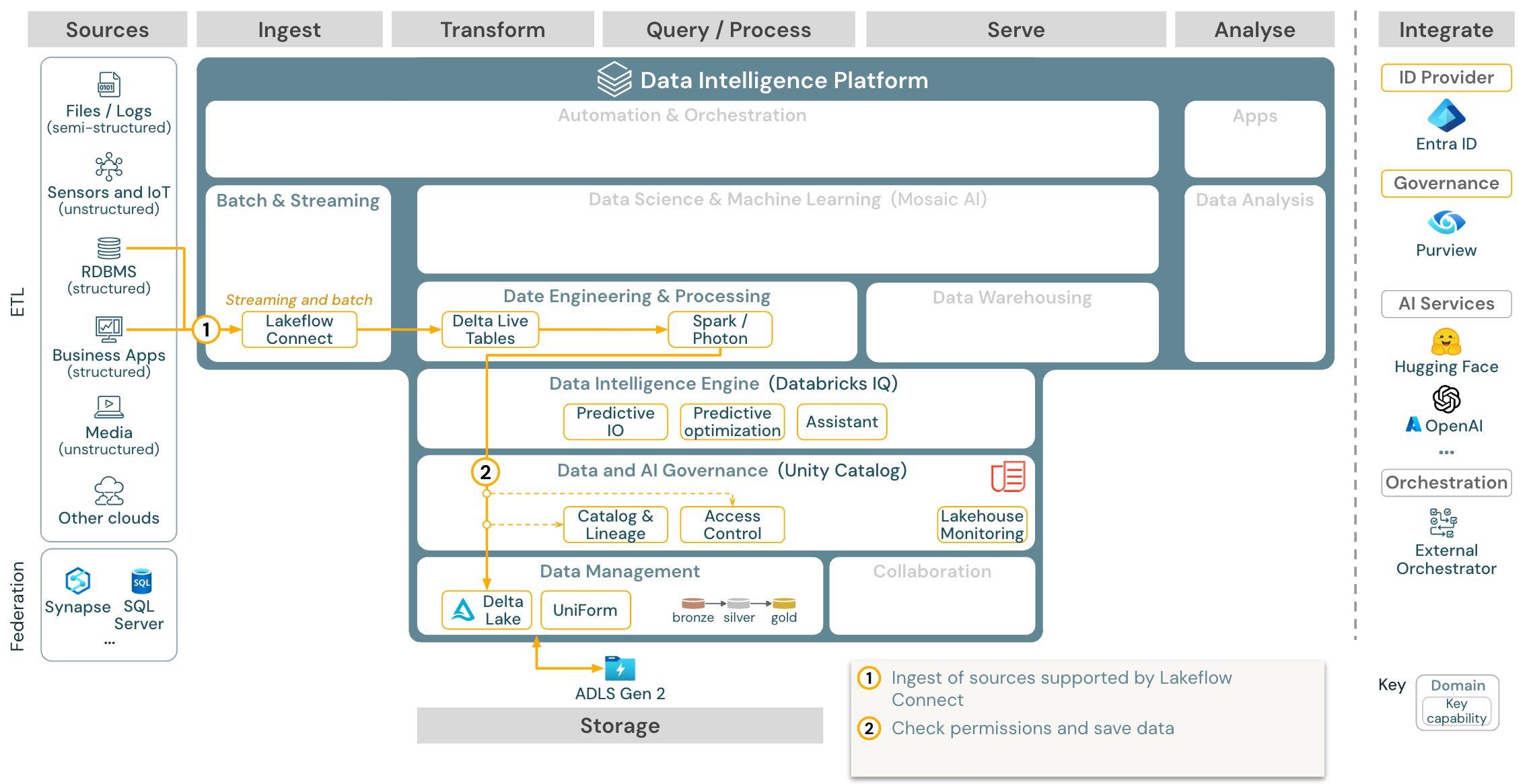

Databricks LakeFlow Connect предлагает встроенные коннекторы для интеграции данных из корпоративных приложений и баз данных. Результирующий конвейер приема управляется каталогом Unity и работает на бессерверных вычислениях и Delta Live Tables. LakeFlow Connect использует эффективные инкрементальные чтения и записи, чтобы сделать прием данных более быстрым, масштабируемым и экономичным, при этом ваша информация остается актуальной для дальнейшего использования.

Вариант использования: прием с помощью Lakeflow Connect:

Скачать: эталонная архитектура пакетной обработки ETL для Azure Databricks.

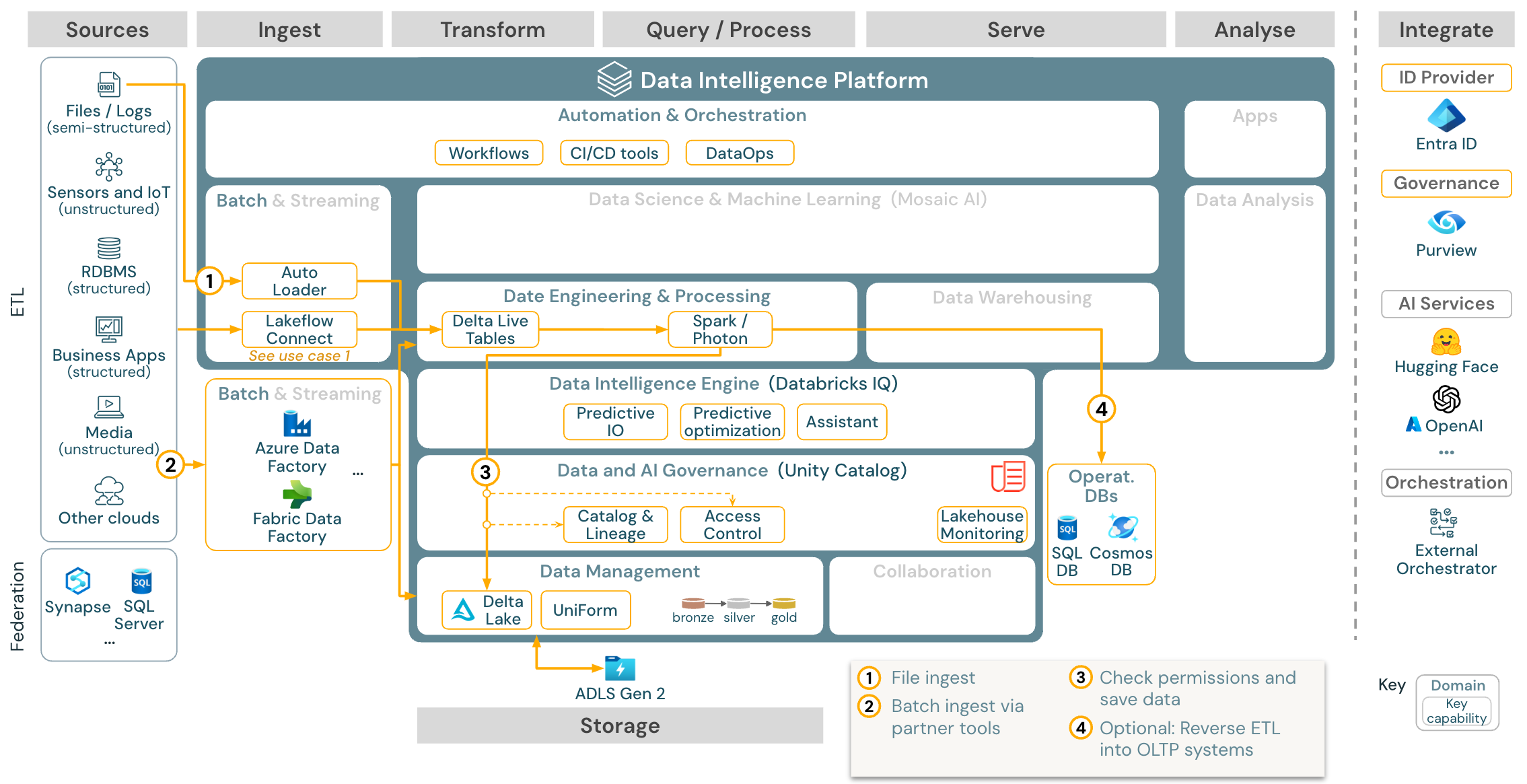

Вариант использования: пакетный ETL

Скачивание: эталонная архитектура пакетного ETL для Azure Databricks

Средства приема используют адаптеры, относящиеся к источнику, чтобы считывать данные из источника, а затем хранить их в облачном хранилище, откуда автозагрузчик может читать его, или вызывать Databricks напрямую (например, с инструментами приема партнеров, интегрированными в Databricks lakehouse). Чтобы загрузить данные, модуль ETL Databricks и обработчик обработки (через DLT) выполняет запросы. Одно- или многозадачные рабочие процессы могут координироваться заданиями в Databricks и регулироваться каталогом Unity (управление доступом, аудит, происхождение, и т. д.). Если операционные системы с низкой задержкой требуют доступа к определенным золотым таблицам, их можно экспортировать в операционную базу данных, например хранилище RDBMS или хранилище значений ключей в конце конвейера ETL.

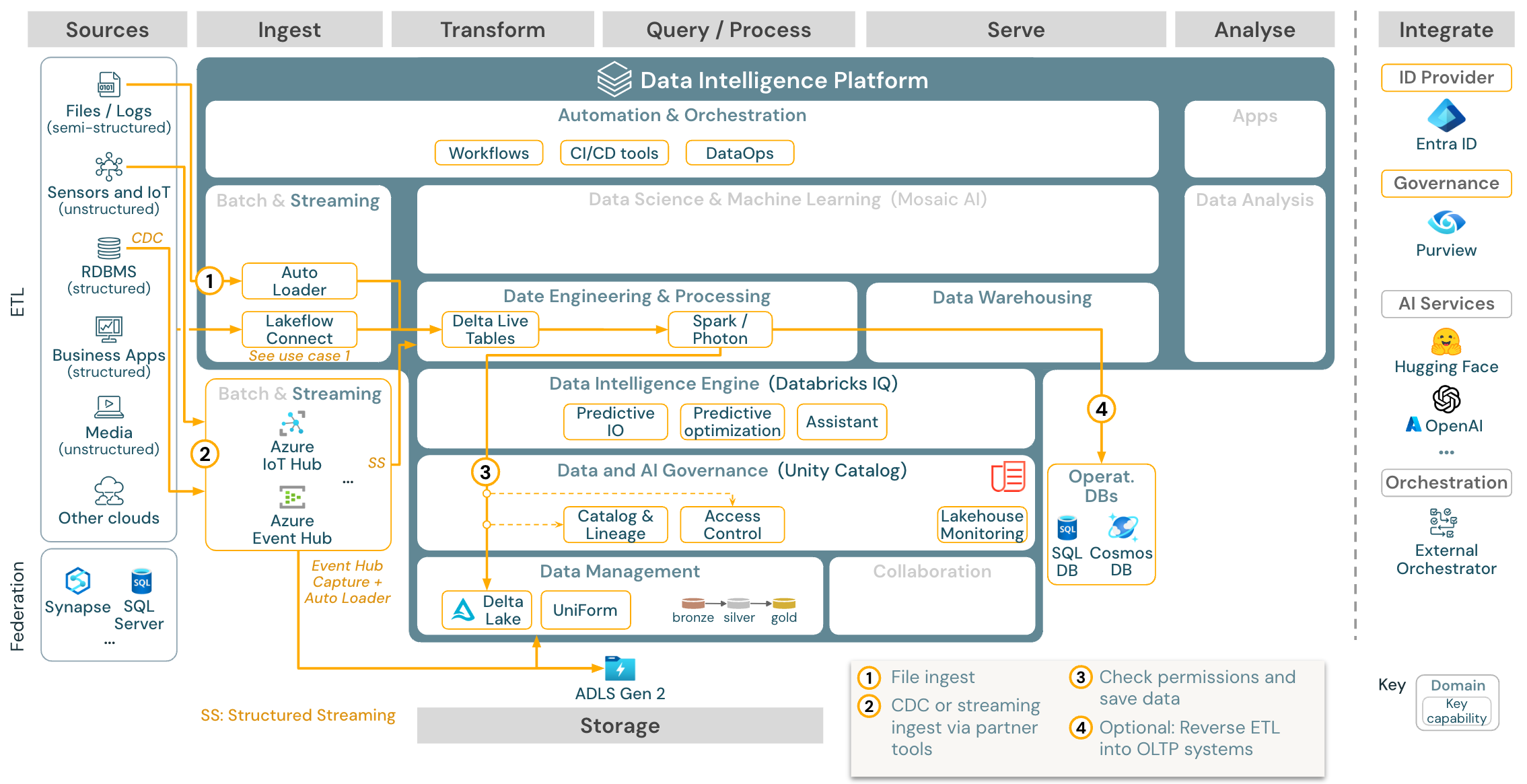

Вариант использования: потоковая передача и запись измененных данных (CDC)

Скачивание: структурированная архитектура потоковой передачи Spark для Azure Databricks

Подсистема ETL Databricks использует структурированную потоковую передачу Spark для чтения из очередей событий, таких как Apache Kafka или Концентратор событий Azure. Ниже приведены шаги ниже, описанные выше в случае использования пакетной службы.

Запись измененных данных в режиме реального времени (CDC) обычно использует очередь событий для хранения извлеченных событий. Оттуда вариант использования следует варианту использования потоковой передачи.

Если CDC выполняется в пакетном режиме, где сначала извлеченные записи хранятся в облачном хранилище, автозагрузчик Databricks может считывать их, и вариант использования соответствует пакетному подходу ETL.

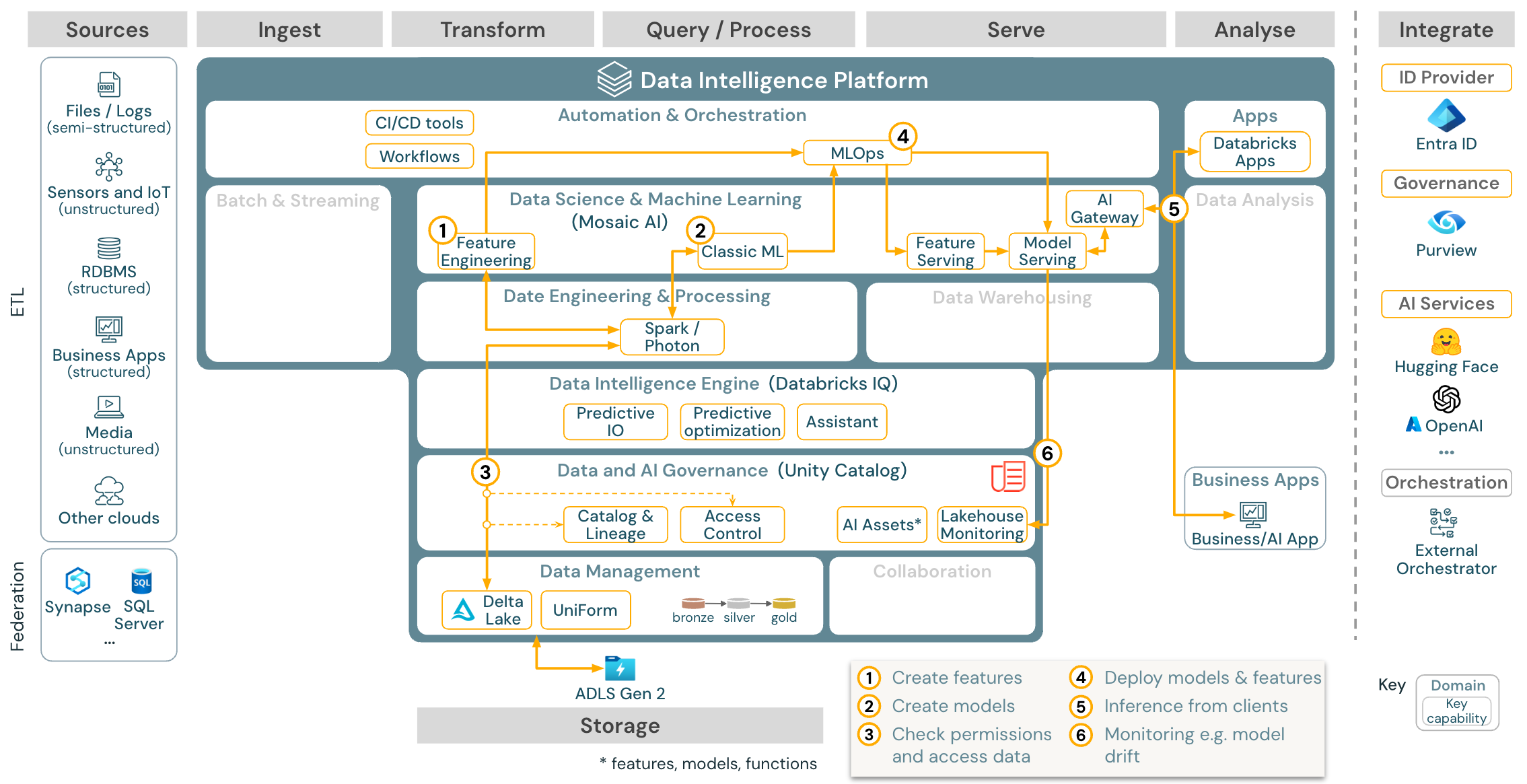

Вариант использования: машинное обучение и ИИ

Скачать: эталонная архитектура машинного обучения и искусственного интеллекта для Azure Databricks

Для машинного обучения платформа Databricks Data Intelligence предоставляет ИИ Мозаики, который поставляется с библиотеками машинного и глубокого обучения. Он предоставляет такие возможности, как Хранилище компонентов и реестр моделей (оба интегрированы в Unity Catalog), функции low-code с AutoML, а также интеграцию MLflow в жизненный цикл обработки данных.

Все ресурсы, связанные с обработкой и анализом данных (таблицы, функции и модели), управляются каталогом Unity, а специалисты по обработке и анализу данных могут использовать задания Databricks для оркестрации своих заданий.

Для развертывания моделей в масштабируемом и корпоративном классе используйте возможности MLOps для публикации моделей в службе моделей.

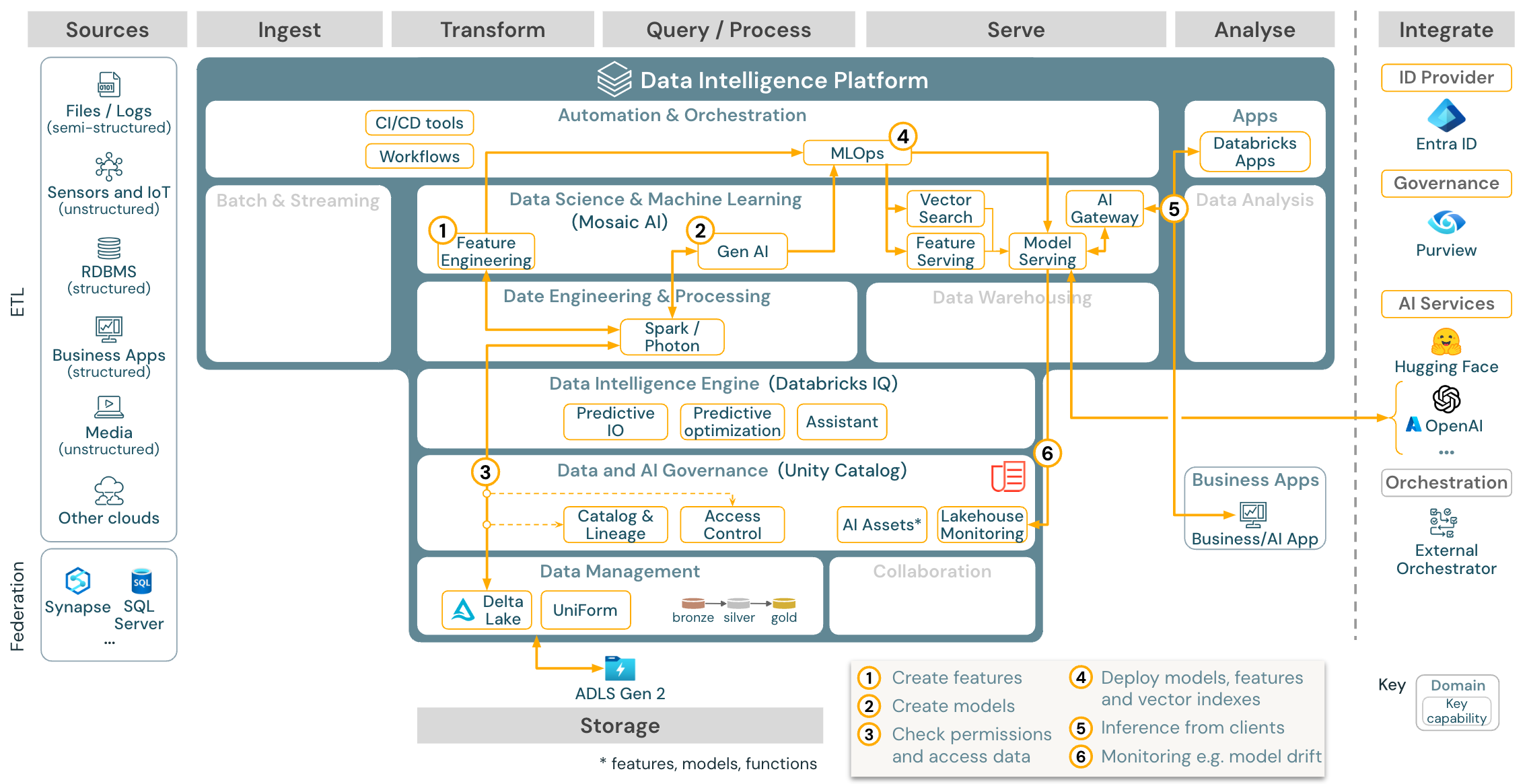

Вариант использования: приложения агента Generative AI (Gen AI)

Скачать: эталонная архитектура приложений Gen AI для Azure Databricks

Для случаев использования генеративного ИИ Mosaic AI предлагает передовые библиотеки и конкретные возможности генеративного ИИ от инжиниринга запросов до тонкой настройки существующих моделей и предобучения с нуля. В приведенной выше архитектуре показан пример того, как векторный поиск может быть интегрирован для создания приложения генеративного ИИ с помощью RAG (генерация, дополненная поиском).

Для развертывания моделей в масштабируемом и корпоративном классе используйте возможности MLOps для публикации моделей в службе моделей.

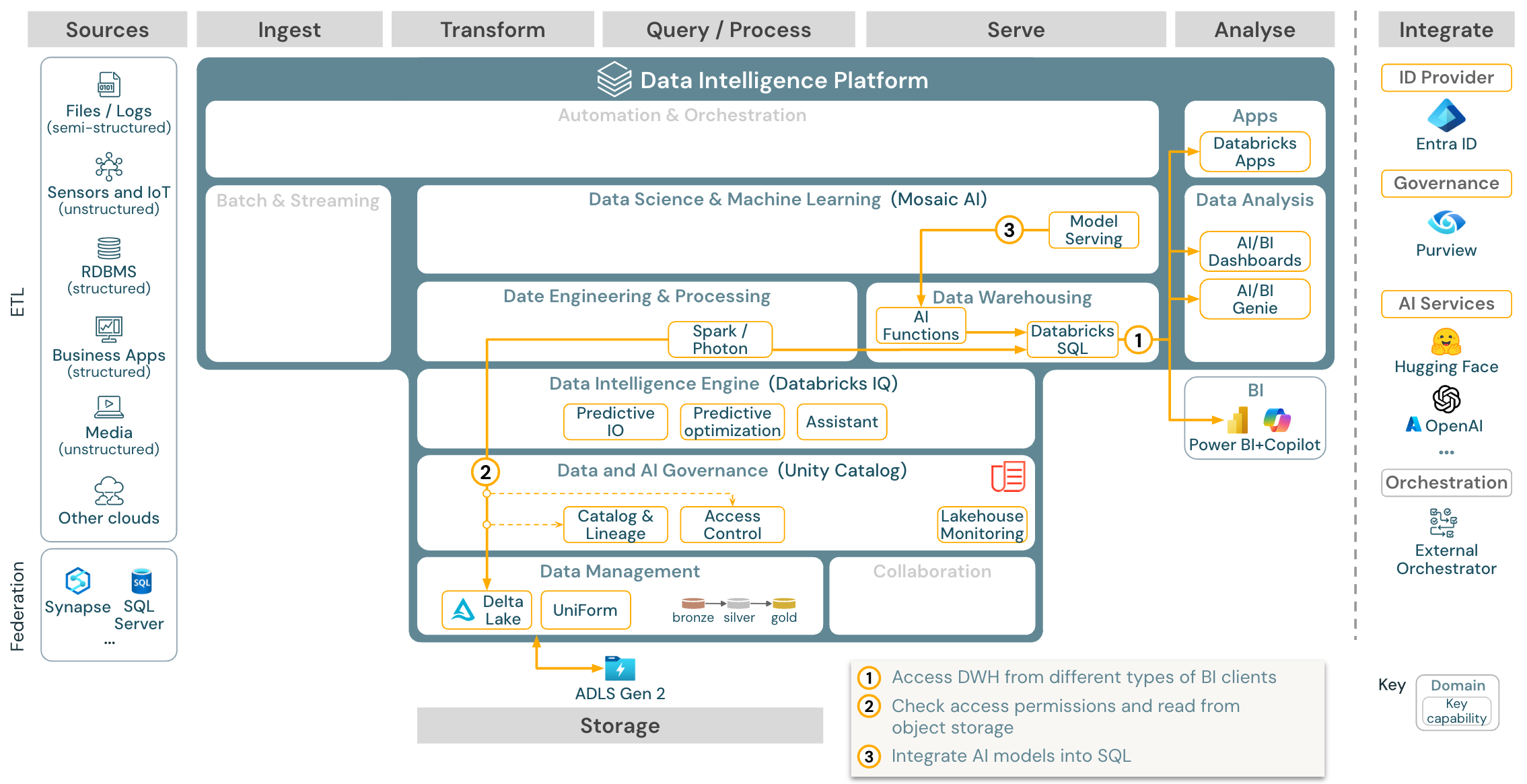

Вариант использования: аналитика бизнес-аналитики и SQL

Скачивание: эталонная архитектура бизнес-аналитики и аналитики SQL для Azure Databricks

Для вариантов использования бизнес-аналитики могут использовать панели мониторинга, редактор SQL Databricks или определенные средства бизнес-аналитики, такие как Tableau или Power BI. Во всех случаях движок — это Databricks SQL (бессерверный или несерверный), а обнаружение данных, их исследование и контроль доступа обеспечиваются Unity Catalog.

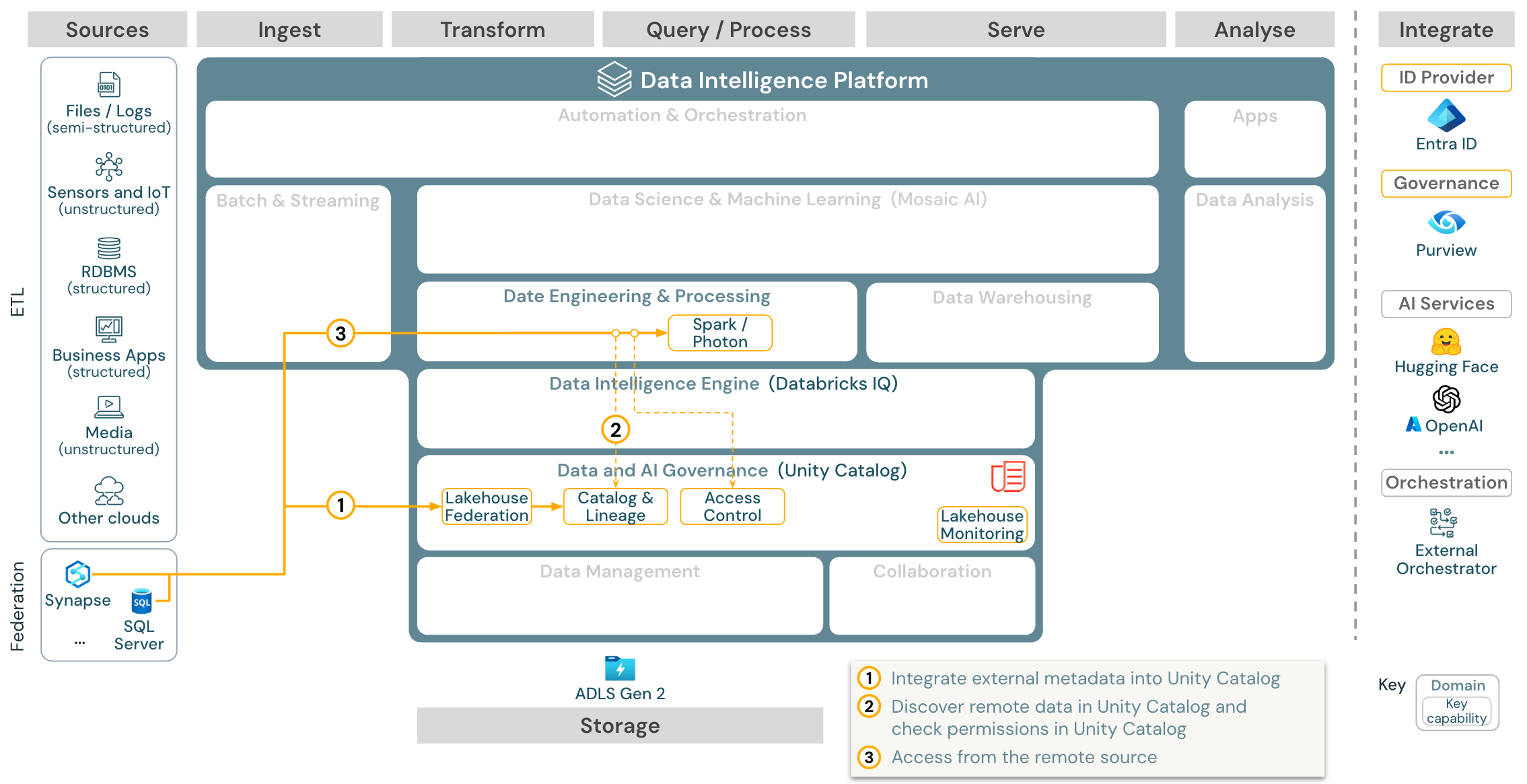

Вариант использования: федерация Lakehouse

Скачать: эталонная архитектура федерации Lakehouse для Azure Databricks

Федерация Lakehouse позволяет интегрировать внешние базы данных SQL данных (например, MySQL, Postgres, SQL Server или Azure Synapse) с Databricks.

Все рабочие нагрузки (ИИ, DWH и BI) могут воспользоваться преимуществами этого без необходимости ETL данных в хранилище объектов. Внешний исходный каталог сопоставляется с каталогом Unity и точное управление доступом можно применять для доступа через платформу Databricks.

Вариант использования: общий доступ к корпоративным данным

Общий доступ к данным корпоративного уровня предоставляется разностным общим доступом. Он предоставляет прямой доступ к данным в хранилище объектов, защищенном каталогом Unity, и Databricks Marketplace является открытым форумом для обмена продуктами данных.