Ознакомьтесь с эталонным образцом сети для развертывания двухузловой системы без использования коммутатора или с использованием одного коммутатора в локальной среде Azure.

Область применения: Azure Local 2311.2 и более поздних версий

В этой статье описывается бессерверный коммутатор хранилища двух узлов с одним шаблоном ссылки на сеть toR, который можно использовать для развертывания локального решения Azure. Сведения в этой статье также помогают определить, подходит ли эта конфигурация для планирования развертывания. В этой статье рассматриваются ИТ-администраторы, которые развертывают и управляют Azure Local в своих центрах обработки данных.

Для получения информации о других шаблонах сети см. Шаблоны развертывания локальных сетей Azure.

Сценарии

Сценарии этого сетевого шаблона включают лаборатории, фабрики, розничные магазины и государственные учреждения.

Рассмотрим этот шаблон для экономичного решения, которое включает отказоустойчивость на уровне системы, но может допускать прерывания подключения на северных каналах, если единственный физический коммутатор выходит из строя или нуждается в обслуживании.

Этот шаблон можно масштабировать, но требуется время простоя рабочей нагрузки для перенастройки физического подключения к хранилищу и перенастройки сети хранилища. Хотя службы SDN L3 полностью поддерживаются для этого шаблона, службы маршрутизации, такие как BGP, должны быть настроены на устройстве брандмауэра на вершине коммутатора TOR, если он не поддерживает службы L3. Функции безопасности сети, такие как микросегментация и QoS, не требуют дополнительной настройки на устройстве брандмауэра, так как они реализованы на виртуальном коммутаторе.

Компоненты физического подключения

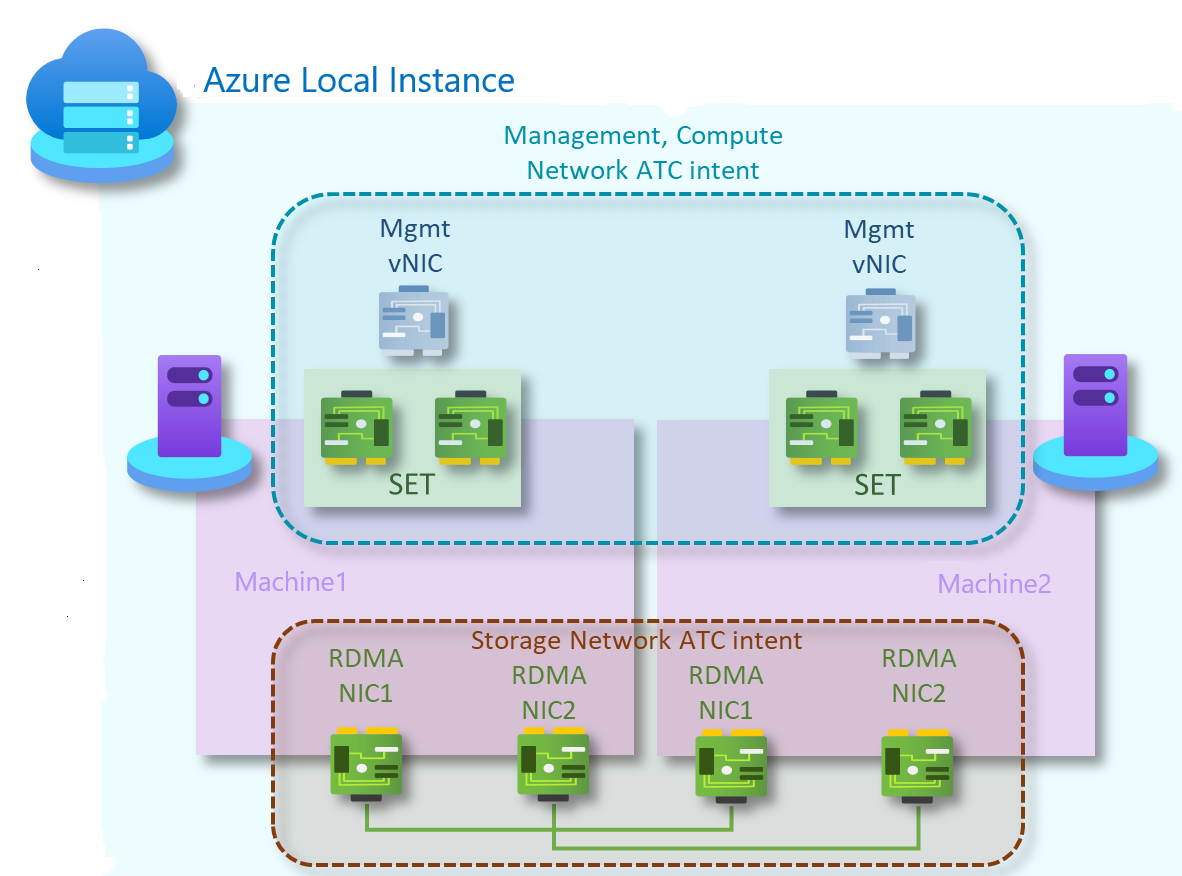

Как показано на следующей схеме, этот шаблон содержит следующие компоненты физической сети:

Один переключатель TOR для связи между севером и югом.

Два объединенных сетевых порта для обработки управления и вычислительного трафика, подключенного к коммутатору L2 на каждом узле

Два RDMA-сетевых адаптера в полносетной конфигурации для восточно-западного трафика для работы с хранилищем. Каждый узел в системе имеет избыточное подключение к другому узлу в системе.

В качестве варианта некоторые решения могут использовать бессерверную конфигурацию без карточки BMC в целях безопасности.

| Сети | Управление и вычисление | Хранилище | BMC |

|---|---|---|---|

| Скорость связи | По крайней мере 1 Гбит/с. Рекомендуется 10 Гбит/с | По крайней мере 10 Гбит/с | Обратитесь к производителю оборудования |

| Тип интерфейса | RJ45, SFP+ или SFP28 | SFP+ или SFP28 | RJ45 |

| Порты и агрегация | Два объединённых порта | Два автономных порта | Один порт |

Намерения ATC сети

Для двухузловых шаблонов хранения без использования коммутаторов создаются два намерения Network ATC. Первый для управления и вычислительного сетевого трафика, а второй — для трафика хранилища.

Управление и намерение вычислений

- Тип намерения: управление и вычисление

- Режим намерения: режим кластера

- Работа в команде: Да. pNIC01 и pNIC02 объединены в команду

- Виртуальная локальная сеть управления по умолчанию: настроенная виртуальная локальная сеть для адаптеров управления не изменяется

- PA и вычислительные виртуальные локальные сети и виртуальные сетевые адаптеры: сетевая atC является прозрачной для виртуальных сетей PA и VLAN или виртуальных сетей виртуальных машин вычислений и виртуальных ЛС

Намерение хранилища

- Тип намерения: хранилище

- Требуемый режим: режим кластера

- Объединение: pNIC03 и pNIC04 используют SMB Multichannel для обеспечения отказоустойчивости и агрегирования пропускной способности.

- Виртуальные локальные сети по умолчанию:

- 711 для сети хранения 1

- 712 для сети хранения 2

- Подсети по умолчанию:

- 10.71.1.0/24 для сети хранения 1

- 10.71.2.0/24 для сети хранения 2

Для получения дополнительной информации см. Развертывание сетевой инфраструктуры узлов.

Выполните следующие действия, чтобы создать намерения сети для этого эталонного шаблона:

Запустите PowerShell с правами администратора.

Выполните следующую команду:

Add-NetIntent -Name <Management_Compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02> Add-NetIntent -Name <Storage> -Storage -ClusterName <HCI01> -AdapterName <pNIC03, pNIC04>

Компоненты логического подключения

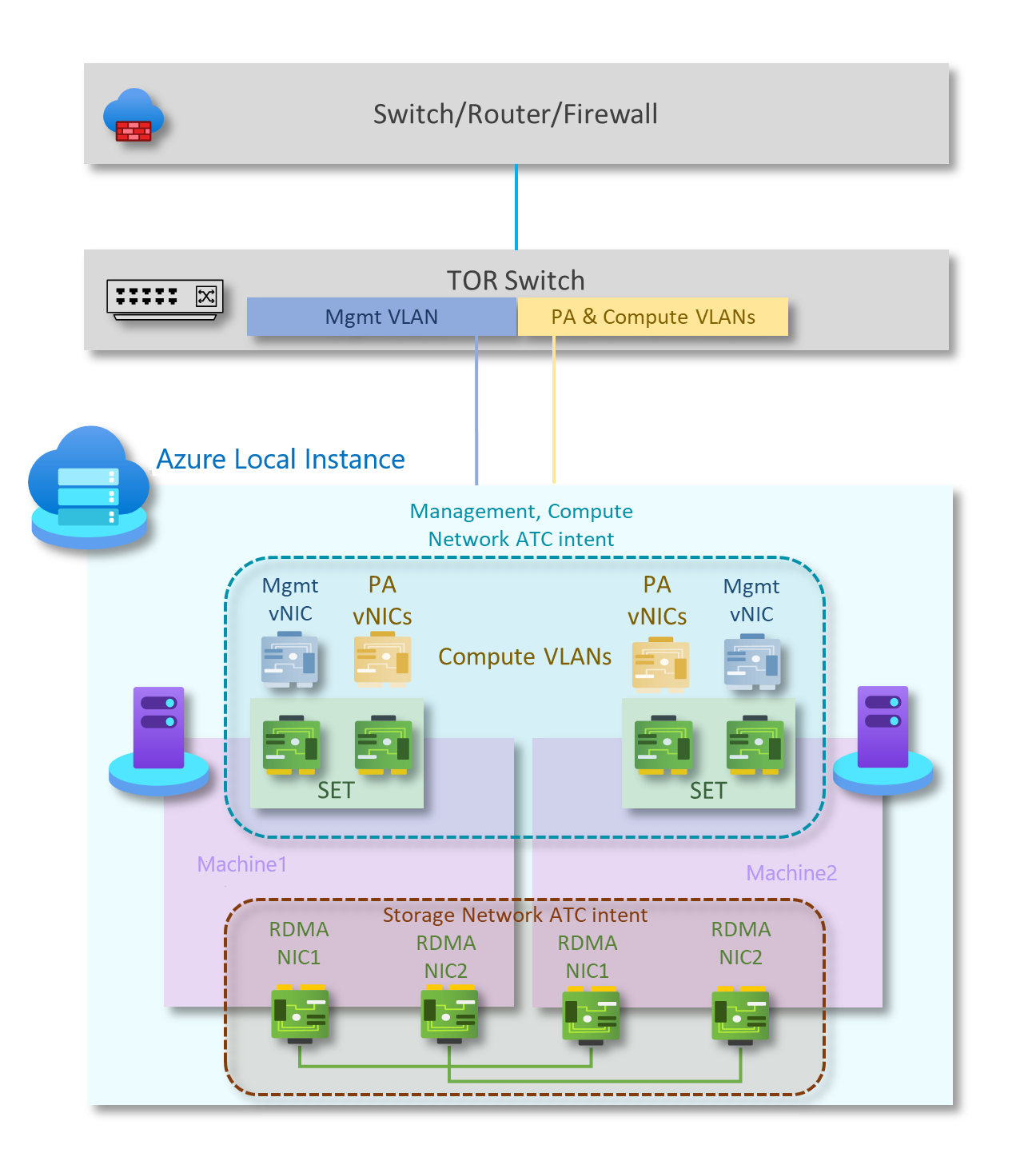

Как показано на схеме ниже, этот шаблон содержит следующие компоненты логической сети:

Виртуальные локальные сети в сети хранения данных

Трафик, основанный на намерениях хранилища, состоит из двух отдельных сетей, поддерживающих трафик RDMA. Каждый интерфейс будет выделен отдельной сети хранения, и оба могут использовать один и тот же тег виртуальной локальной сети. Этот трафик предназначен только для перемещения между двумя узлами. Трафик хранилища — это частная сеть без подключения к другим ресурсам.

Адаптеры хранилища работают с различными IP-подсетями. Чтобы включить конфигурацию без переключения, каждый подключенный узел поддерживает соответствующую подсеть своего соседа. Каждая сеть хранения использует предопределенные виртуальные локальные сети Network ATC по умолчанию (711 и 712). Однако при необходимости эти виртуальные локальные сети можно настроить. Кроме того, если подсети по умолчанию, определенные Сетевым ATC (10.71.1.0/24 и 10.71.2.0/24), не могут быть использованы, вы несете ответственность за назначение всех IP-адресов хранилища в системе.

Для получения дополнительной информации см. обзор Network ATC.

Сеть OOB

Сеть внеполосная (OOB) предназначена для поддержки интерфейса управления серверами в отсутствие персонала, также известного как контроллер управления базовой платой (BMC). Каждый интерфейс BMC подключается к предоставленному клиентом коммутатору. BMC используется для автоматизации сценариев загрузки PXE.

Для сети управления требуется доступ к интерфейсу BMC с использованием Intelligent Platform Management Interface (IPMI) и порта 623 протокола пользовательской датаграммы (UDP).

Сеть OOB изолирована от вычислительных нагрузок и является необязательной для развертываний, не основанных на конкретных решениях.

VLAN управления

Для всех физических вычислительных узлов требуется доступ к логической сети управления. Для планирования IP-адресов каждый физический вычислительный узел должен иметь по крайней мере один IP-адрес, назначенный из логической сети управления.

DHCP-сервер может автоматически назначать IP-адреса для сети управления или вручную назначать статические IP-адреса. Если DHCP является предпочтительным методом назначения IP-адресов, рекомендуется использовать резервирования DHCP без истечения срока действия.

Сеть управления поддерживает следующие конфигурации виртуальной локальной сети:

Собственная виртуальная локальная локальная сеть — вам не требуется предоставлять идентификаторы виртуальной ЛС . Это необходимо для инсталляций на базе решений.

Помеченная виртуальная локальная сеть — вы предоставляете идентификаторы виртуальной ЛС во время развертывания.

Сеть управления поддерживает весь трафик, используемый для управления кластером, включая удаленный рабочий стол, Центр администрирования Windows и Active Directory.

Дополнительные сведения см. в разделе "Планирование инфраструктуры SDN: Управление и провайдер HNV".

Вычислительные VLANы

В некоторых сценариях не требуется использовать виртуальные сети SDN с инкапсуляцией виртуальной расширяемой локальной сети (VXLAN). Вместо этого можно использовать традиционные виртуальные локальные сети для изоляции рабочих нагрузок клиента. Эти виртуальные локальные сети настраиваются на порту коммутатора TOR в режиме магистрали. При подключении новых виртуальных машин к этим виртуальным сетям соответствующий тег виртуальной локальной сети определяется на виртуальном сетевом адаптере.

Сеть поставщика HNV (PA)

Сеть виртуализации сети Hyper-V (HNV) Address (PA) служит базовой физической сетью для трафика клиента East/West (internal-internal), трафика клиента North/South (external-internal) и обмена данными пиринга BGP с физической сетью. Эта сеть требуется только в том случае, если требуется развернуть виртуальные сети с помощью инкапсуляции VXLAN для другого уровня изоляции и многотенантности сети.

Дополнительные сведения см. в разделе "Планирование инфраструктуры SDN: управление и поставщик HNV".

Варианты сетевой изоляции

Поддерживаются следующие параметры сетевой изоляции:

Виртуальные локальные сети (IEEE 802.1Q)

Виртуальные локальные сети позволяют устройствам, которые должны быть изолированы, совместно использовать кабели физической сети, но при этом не дают им возможности напрямую взаимодействовать друг с другом. Этот управляемый общий доступ обеспечивает простоту, безопасность, управление трафиком и экономику. Например, виртуальная локальная сеть может использоваться для разделения трафика в бизнесе на основе отдельных пользователей или групп пользователей или их ролей или на основе характеристик трафика. Многие службы размещения интернета используют виртуальные сети для разделения частных зон друг от друга, что позволяет каждому клиенту группировать серверы в одном сегменте сети независимо от того, где находятся отдельные серверы в центре обработки данных. Некоторые меры предосторожности необходимы, чтобы предотвратить "побег" трафика из данной VLAN, эксплойт, известный как VLAN-хоппинг.

Дополнительные сведения см. в статье об использовании виртуальных сетей и виртуальных ЛС.

Политики доступа к сети по умолчанию и микросегментация по умолчанию

Политики доступа к сети по умолчанию гарантируют, что все виртуальные машины в кластере Azure Stack HCI защищены по умолчанию от внешних угроз. С помощью этих политик мы блокируем входящий доступ к виртуальной машине по умолчанию, предоставляя возможность включить выборочные входящий порт и таким образом защитить виртуальные машины от внешних атак. Эта реализация доступна с помощью таких средств управления, как Windows Admin Center.

Микросегментация включает создание детализированных политик сети между приложениями и службами. Это существенно сокращает периметр безопасности до ограждения вокруг каждого приложения или виртуальной машины. Это ограждение разрешает только необходимую связь между уровнями приложений или другими логическими границами, что делает чрезвычайно сложным для киберугроз распространяться по горизонтали от одной системы к другой. Микросегментация безопасно изолирует сети друг от друга и уменьшает общую поверхность атаки инцидента безопасности сети.

Политики доступа к сети по умолчанию и микросегментация реализованы в виде пятиэлементных правил брандмауэра (префикс исходного адреса, исходный порт, префикс адреса назначения, порт назначения и протокол) в кластерах Azure Stack HCI. Правила брандмауэра также называются группами безопасности сети (NSG). Эти политики применяются на порту vSwitch каждой виртуальной машины. Политики управления передаются через управленческий уровень, а сетевой контроллер SDN распределяет их на все применимые узлы. Эти политики безопасности доступны для виртуальных машин в традиционных сетях VLAN и на наложенных сетях SDN.

Дополнительные сведения см. в разделе "Что такое брандмауэр центра обработки данных?".

QoS для сетевых адаптеров виртуальных машин

Вы можете настроить качество обслуживания (QoS) для сетевого адаптера виртуальной машины, чтобы ограничить пропускную способность виртуального интерфейса, чтобы предотвратить подключение виртуальной машины с высоким трафиком к другому сетевому трафику виртуальной машины. Вы также можете настроить QoS, чтобы зарезервировать определенный объем пропускной способности виртуальной машины, чтобы убедиться, что виртуальная машина может отправлять трафик независимо от другого трафика в сети. Это можно применить к виртуальным машинам, подключенным к традиционным сетям виртуальной локальной сети, а также к виртуальным машинам, подключенным к сетям наложения SDN.

Дополнительные сведения см. в разделе "Настройка качества обслуживания" для сетевого адаптера виртуальной машины.

Виртуальные сети

Виртуализация сети предоставляет виртуальные сети виртуальным машинам, аналогичным тому, как виртуализация сервера (гипервизор) предоставляет виртуальные машины операционной системе. Виртуализация сети отделяет виртуальные сети от инфраструктуры физической сети и удаляет ограничения VLAN и иерархического назначения IP-адресов из подготовки виртуальной машины. Такая гибкость позволяет легко перейти в облака IaaS (инфраструктура как услуга) и эффективно для хостеров и администраторов центров обработки данных управлять своей инфраструктурой, поддерживая необходимую многопользовательскую изоляцию, соответствие требованиям безопасности и управляющих перекрывающимися IP-адресами виртуальных машин.

Дополнительные сведения см. в статье "Виртуализация сети Hyper-V".

Параметры сетевых служб L3

Доступны следующие параметры сетевой службы L3:

Пиринг между виртуальными сетями

Пиринг между виртуальными сетями позволяет легко подключать две виртуальные сети. После однорангового подключения виртуальные сети отображаются в качестве одного. Преимущества пиринговой связи между виртуальными сетями:

- Трафик между виртуальными машинами в одноранговых виртуальных сетях направляется через магистральную инфраструктуру только через частные IP-адреса. Для обмена данными между виртуальными сетями не требуется общедоступный Интернет или шлюзы.

- подключение между ресурсами в разных виртуальных сетях, характеризующееся низкой задержкой и высокой пропускной способностью;

- Возможность взаимодействия ресурсов в одной виртуальной сети с ресурсами в другой виртуальной сети.

- Время простоя ресурсов в любой виртуальной сети при создании пиринга не выполняется.

Дополнительные сведения см. в статье Пиринг между виртуальными сетями.

Подсистема балансировки нагрузки программного обеспечения SDN

Поставщики облачных служб (ПОСТАВЩИКИ облачных служб) и предприятия, которые развертывают программное обеспечение определяемой сетью (SDN), могут использовать Software Load Balancer (SLB) для равномерного распределения сетевого трафика клиентов между ресурсами виртуальной сети. SLB позволяет размещать одну и ту же рабочую нагрузку на нескольких серверах, что обеспечивает высокий уровень доступности и масштабирования. Он также используется для предоставления служб преобразования входящих сетевых адресов (NAT) для входящего доступа к виртуальным машинам и исходящих служб NAT для исходящего подключения.

С помощью SLB можно масштабировать возможности балансировки нагрузки с помощью виртуальных машин SLB на одних вычислительных серверах Hyper-V, используемых для других рабочих нагрузок виртуальных машин. SLB поддерживает быстрое создание и удаление конечных точек балансировки нагрузки, необходимых для операций CSP. Кроме того, SLB поддерживает десятки гигабайт на каждый кластер, предоставляет простую модель развёртывания и легко масштабируется как в увеличении, так и в уменьшении. SLB использует протокол пограничного шлюза для объявления виртуальных IP-адресов в физической сети.

Дополнительные сведения см. в статье О том, что такое SLB для SDN?

VPN-шлюзы SDN

Шлюз SDN — это программный маршрутизатор пограничного шлюза (BGP), предназначенный для поставщиков услуг безопасности и предприятий, на которых размещаются мультитенантные виртуальные сети с помощью виртуализации сети Hyper-V (HNV). Шлюз RAS можно использовать для маршрутизации сетевого трафика между виртуальной сетью и другой сетью либо локальной, либо удаленной.

Шлюз SDN можно использовать для:

Создайте безопасные подключения IPsec типа "сеть — сеть" между виртуальными сетями SDN и внешними клиентскими сетями через Интернет.

Создать подключения инкапсуляции генерической маршрутизации (GRE) между виртуальными сетями SDN и внешними сетями. Разница между подключениями типа "сеть — сеть" и подключениями GRE заключается в том, что последний не является зашифрованным подключением.

Дополнительные сведения о сценариях подключения GRE см. в разделе "Туннелирование GRE" в Windows Server.

Создание подключений уровня 3 (L3) между виртуальными сетями SDN и внешними сетями. В этом случае шлюз SDN просто выступает в качестве маршрутизатора между виртуальной сетью и внешней сетью.

Шлюз SDN требует сетевого контроллера SDN. Сетевой контроллер выполняет развертывание пулов шлюзов, настраивает подключения клиентов на каждом шлюзе и переключает потоки сетевого трафика в резервный шлюз, если шлюз завершается сбоем.

Шлюзы используют протокол пограничного шлюза для объявления конечных точек GRE и установления подключений типа "точка — точка". Развертывание SDN создает пул шлюзов по умолчанию, поддерживающий все типы подключений. В этом пуле можно указать, сколько шлюзов зарезервировано в режиме ожидания в случае сбоя активного шлюза.

Дополнительные сведения см. в статье о том, что такое шлюз RAS для SDN?

Следующие шаги

Узнайте о шаблоне сети без переключателей для хранилища с двумя узлами и двумя коммутаторами