Каталог моделей и коллекции на портале Azure AI Foundry

Внимание

Элементы, обозначенные в этой статье как (предварительная версия), сейчас предлагаются в общедоступной предварительной версии. Эта предварительная версия предоставляется без соглашения об уровне обслуживания, и мы не рекомендуем ее для рабочих нагрузок. Некоторые функции могут не поддерживаться или их возможности могут быть ограничены. Дополнительные сведения см. в статье Дополнительные условия использования Предварительных версий Microsoft Azure.

Каталог моделей на портале Azure AI Foundry — это центр для обнаружения и использования широкого спектра моделей для создания создаваемых приложений ИИ. Каталог моделей включает сотни моделей в таких поставщиках моделей, как Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA и Hugging Face, включая модели, обученные Корпорацией Майкрософт. Модели от поставщиков, отличных от корпорации Майкрософт, являются продуктами, не являющихся корпорацией Майкрософт, как определено в условиях продуктов Майкрософт, и применяются к условиям, предоставленным моделями.

Коллекции моделей

Каталог моделей упорядочивает модели в разные коллекции:

Курируется ИИ Azure: самые популярные модели, отличные от Корпорации Майкрософт с открытым весом и закрытыми моделями, упакованными и оптимизированными для эффективной работы на платформе ИИ Azure. Использование этих моделей распространяется на условия лицензионного соглашения поставщиков моделей. При развертывании этих моделей на портале Azure AI Foundry их доступность распространяется на применимое соглашение об уровне обслуживания Azure (SLA), а корпорация Майкрософт предоставляет поддержку проблем с развертыванием.

Модели от партнеров, таких как Meta, NVIDIA и Mistral AI, являются примерами моделей, доступных в этой коллекции в каталоге. Эти модели можно определить, найдите зеленый флажок на плитках модели в каталоге. Вы также можете отфильтровать данные по коллекции ИИ Azure.

Модели Azure OpenAI доступны исключительно в Azure: флагманские модели Azure OpenAI, доступные через интеграцию со службой Azure OpenAI. Корпорация Майкрософт поддерживает эти модели и их использование в соответствии с условиями продукта и соглашением об уровне обслуживания для Azure OpenAI Service.

Откройте модели из концентратора распознавания лиц Hugging: сотни моделей из концентратора распознавания лиц для вывода в режиме реального времени с управляемыми вычислениями. Hugging Face создает и поддерживает модели, перечисленные в этой коллекции. Чтобы помочь, воспользуйтесь форумом hugging Face или Hugging Face support. Дополнительные сведения см. в разделе "Развертывание открытых моделей с помощью Azure AI Foundry".

Вы можете отправить запрос на добавление модели в каталог моделей с помощью этой формы.

Общие сведения о возможностях каталога моделей

Вы можете искать и обнаруживать модели, соответствующие вашим требованиям keyword search , и filters. Каталог моделей также предлагает метрики показателей производительности модели для выбора моделей. Вы можете получить доступ к эталону, щелкнув Compare Models или на вкладке "Тест тестирования модели".

На карточке модели вы найдете:

- Краткие факты: вы увидите ключевые сведения о модели на быстром взгляде.

- Сведения: эта страница содержит подробные сведения о модели, включая описание, сведения о версии, поддерживаемый тип данных и т. д.

- Тесты: вы найдете метрики теста производительности для выбора моделей.

- Существующие развертывания: если вы уже развернули модель, ее можно найти на вкладке "Существующие развертывания".

- Примеры кода: вы найдете основные примеры кода для начала разработки приложений ИИ.

- Лицензия: вы найдете юридическую информацию, связанную с лицензированием модели.

- Артефакты: эта вкладка будет отображаться только для открытых моделей. Вы можете просмотреть ресурсы модели и скачать их с помощью пользовательского интерфейса.

Развертывание модели: Azure OpenAI

Дополнительные сведения о моделях Azure OpenAI см. в статье "Что такое Служба Azure OpenAI?".

Развертывание модели: управляемые вычислительные и бессерверные API

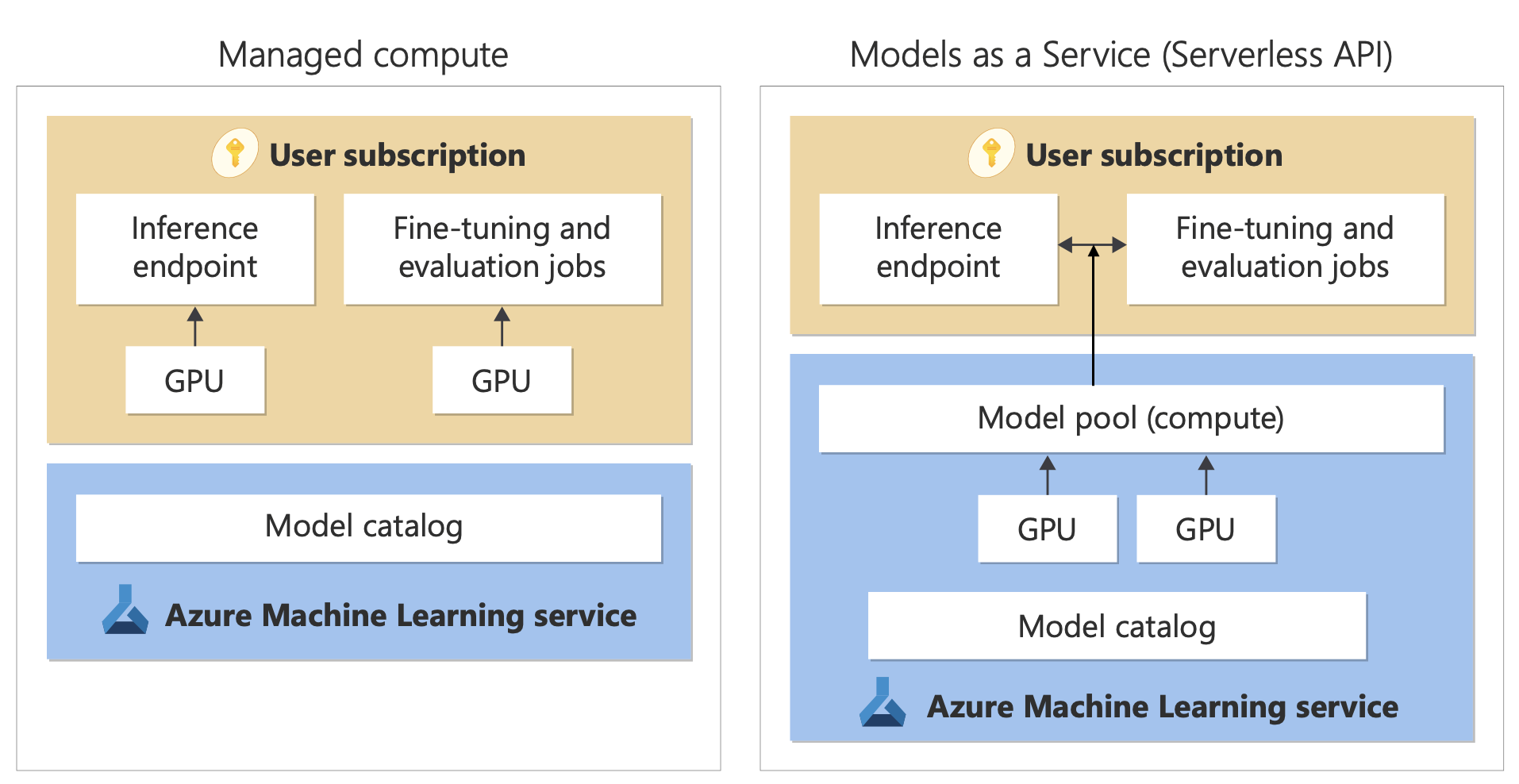

Помимо моделей службы Azure OpenAI, каталог моделей предлагает два различных способа развертывания моделей для использования: управляемые вычислительные и бессерверные API.

Варианты развертывания и функции, доступные для каждой модели, зависят, как описано в следующих таблицах. Дополнительные сведения об обработке данных с параметрами развертывания.

Возможности параметров развертывания модели

| Компоненты | Управляемые вычисления | Бессерверный API (оплата за токен) |

|---|---|---|

| Интерфейс развертывания и выставление счетов | Весы модели развертываются на выделенных виртуальных машинах с управляемыми вычислительными ресурсами. Управляемые вычислительные ресурсы, которые могут иметь одно или несколько развертываний, предоставляет REST API для вывода. Плата взимается за основные часы виртуальных машин, которые используются развертываниями. | Доступ к моделям осуществляется через развертывание, которое подготавливает API для доступа к модели. API предоставляет доступ к модели, в которую майкрософт размещается и управляет ими, для вывода. Плата за входные и выходные данные в API обычно взимается в токенах. Сведения о ценах предоставляются перед развертыванием. |

| Проверка подлинности API | Ключи и проверка подлинности Microsoft Entra. | Только ключи. |

| Безопасность содержимого | Используйте API службы безопасности содержимого Azure. | Фильтры безопасности содержимого ИИ Azure доступны как интегрированные с API вывода. Фильтры безопасности содержимого Azure оплачиваются отдельно. |

| Сетевая изоляция | Настройте управляемые сети для центров Azure AI Foundry. | Управляемые вычисления следуют параметру флага доступа к общедоступной сети (PNA) концентратора. Дополнительные сведения см. в разделе " Сетевая изоляция для моделей, развернутых с помощью бессерверных API" далее в этой статье. |

Доступные модели для поддерживаемых вариантов развертывания

В следующем списке содержатся модели бессерверных API. Модели Azure OpenAI см. в разделе "Модели службы Azure OpenAI".

| Модель | Управляемые вычисления | Бессерверный API (оплата за токен) |

|---|---|---|

| Модели семейства AI21 | Недоступно | Джамба-1.5-Мини Джамба-1.5-большой |

| Модели семейства Cohere | Недоступно | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-многоязычный Cohere-rerank-v3-english Cohere-rerank-v3-многоязычный |

| Модели DeepSeek от Майкрософт | Недоступно | DeepSeek-R1 |

| Гретель | Недоступно | Gretel-Navigator |

| Модели семейства ИИ для здравоохранения | MedImageParse MedImageInsight CxrReportGen Virchow Virchow2 Prism; BiomedCLIP-PubMedBERT microsoft-llava-med-v1.5 m42-health-llama3-med4 biomistral-biomistral-7b Microsoft-biogpt-large-pub microsoft-biomednlp-pub стэнфорд-crfm-biom-biomedlm medicalai-clinicalbert Microsoft-biogpt Microsoft-biogpt-large microsoft-biomednlp-pub |

Недоступно |

| JAIS | Недоступно | jais-30b-chat |

| Мета-Лама семейных моделей | Лама-3.3-70B-Instruct Лама-3.2-3B-Instruct Лама-3.2-1B-Instruct Лама-3.2-1B Лама-3.2-90B-Vision-Instruct Лама-3.2-11B-Vision-Instruct Лама-3.1-8B-Instruct Лама-3.1-8B Лама-3.1-70B-Instruct Лама-3.1-70B Llama-3-8B-Instruct Llama-3-70B Llama-3-8B Лама-Гвардия-3-1B Лама-Guard-3-8B Llama-Guard-3-11B-Vision Llama-2-7b Llama-2-70b Llama-2-7b-chat Llama-2-13b-chat CodeLlama-7b-hf CodeLlama-7b-Instruct-hf CodeLlama-34b-hf CodeLlama-34b-Python-hf CodeLlama-34b-Instruct-hf CodeLlama-13b-Instruct-hf CodeLlama-13b-Python-hf Prompt-Guard-86M CodeLlama-70b-hf |

Лама-3.3-70B-Instruct Лама-3.2-90B-Vision-Instruct Лама-3.2-11B-Vision-Instruct Лама-3.1-8B-Instruct Лама-3.1-70B-Instruct Лама-3.1-405B-Instruct Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-70b Llama-2-70b-chat Llama-2-13b Llama-2-13b-chat |

| Модели семейства Microsoft Phi | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-instruct Phi-3.5-MoE-Instruct Phi-4 |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-instruct Phi-3.5-MoE-Instruct Phi-4 |

| Модели семейства Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Мистраль-большой (2402) Мистраль-большой (2407) Мистраль-маленький Министерство-3B Мистраль-NeMo |

| Nixtla | Недоступно | TimeGEN-1 |

Жизненный цикл модели: отмена и выход на пенсию

Модели ИИ развиваются быстро, и когда новая версия или новая модель с обновленными возможностями в том же семействе моделей становятся доступными, старые модели могут быть сняты в каталоге моделей AI Foundry. Чтобы обеспечить плавное переход на более новую версию модели, некоторые модели предоставляют пользователям возможность включить автоматическое обновление. Дополнительные сведения о жизненном цикле модели различных моделей, предстоящих датах выхода на пенсию модели и предлагаемых моделях и версиях см. в следующих примерах:

- Нерекомендуемая модель Azure OpenAI Service и выход на пенсию

- Нерекомендуемая модель API без использования и выхода на пенсию

Управляемые вычисления

Возможность развертывания моделей в качестве управляемых вычислительных ресурсов основана на возможностях платформы Машинное обучение Azure для обеспечения простой интеграции широкой коллекции моделей в каталоге моделей во всем жизненном цикле операций с крупной языковой моделью (LLM).

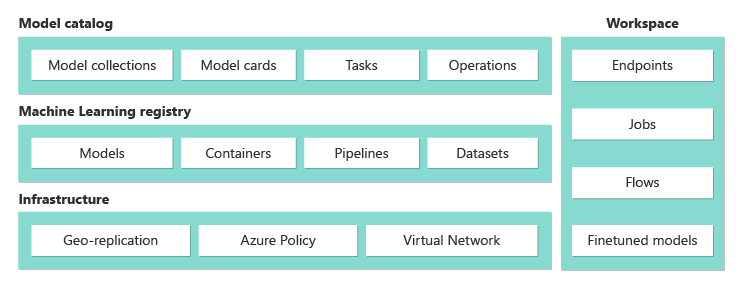

Доступность моделей для развертывания как управляемых вычислений

Модели становятся доступными с помощью Машинное обучение Azure реестров. Эти реестры позволяют использовать подход машинного обучения к размещению и распределению Машинное обучение Azure ресурсов. К этим ресурсам относятся весы моделей, среды выполнения контейнеров для выполнения моделей, конвейеры для оценки и точной настройки моделей, а также наборы данных для тестов и примеров.

Реестры создаются на основе высокомасштабируемой и корпоративной инфраструктуры, которая:

Предоставляет артефакты модели доступа с низкой задержкой во всех регионах Azure с встроенной георепликацией.

Поддерживает требования корпоративной безопасности, такие как ограничение доступа к моделям с помощью Политика Azure и безопасного развертывания с помощью управляемых виртуальных сетей.

Развертывание моделей для вывода с помощью управляемых вычислений

Модели, доступные для развертывания для управляемых вычислений, можно развернуть для Машинное обучение Azure управляемых вычислений для вывода в режиме реального времени. При развертывании на управляемых вычислительных ресурсах требуется квота виртуальной машины в подписке Azure для определенных продуктов, которые необходимо оптимально запустить модель. Некоторые модели позволяют развертывать временно общую квоту для тестирования моделей.

Дополнительные сведения о развертывании моделей:

Создание созданных приложений ИИ с помощью управляемых вычислений

Функция потока запросов в Машинное обучение Azure предлагает отличный интерфейс для создания прототипов. Модели, развернутые с управляемыми вычислительными ресурсами в потоке запросов, можно использовать с помощью средства Open Model LLM. Вы также можете использовать REST API, предоставляемый управляемыми вычислениями, в популярных инструментах LLM, таких как LangChain с расширением Машинное обучение Azure.

Безопасность содержимого для моделей, развернутых как управляемые вычислительные ресурсы

Служба безопасности содержимого ИИ Azure доступна для использования с управляемыми вычислительными ресурсами на экране для различных категорий вредного содержимого, таких как сексуальное содержимое, насилие, ненависть и самоповредение. Вы также можете использовать службу для просмотра дополнительных угроз, таких как обнаружение рисков в тюрьме и обнаружение защищенного текста материала.

Эту записную книжку можно использовать для справки по интеграции с безопасностью содержимого ИИ Azure для Llama 2. Кроме того, вы можете использовать средство "Безопасность содержимого ( текст) в потоке запроса для передачи ответов от модели в Службу безопасности содержимого ИИ Azure для проверки. Плата взимается отдельно за использование, как описано в ценах на безопасность содержимого ИИ Azure.

Выставление счетов за бессерверный API (оплата за токен)

Некоторые модели можно развернуть в каталоге моделей с выставлением счетов за токен. Этот метод развертывания, также называемый БЕССерверным API, предоставляет способ использования моделей в качестве API без размещения их в подписке. Модели размещаются в управляемой корпорацией Майкрософт инфраструктуре, которая обеспечивает доступ на основе API к модели поставщика моделей. Доступ на основе API может значительно сократить затраты на доступ к модели и упростить процесс подготовки.

Модели, доступные для развертывания в качестве бессерверных API с выставлением счетов по мере использования, предлагаются поставщиком моделей, но они размещаются в инфраструктуре, управляемой Корпорацией Майкрософт, и доступ к ним осуществляется через API. Поставщики моделей определяют условия лицензии и устанавливают цену на использование своих моделей. Служба Машинное обучение Azure:

- Управляет инфраструктурой размещения.

- Делает интерфейсы API вывода доступными.

- Выступает в качестве обработчика данных для запросов, отправленных и выходных данных содержимого моделями, развернутыми с помощью MaaS.

Дополнительные сведения об обработке данных для MaaS см. в статье о конфиденциальности данных.

Примечание.

подписки поставщик облачных решений (CSP) не имеют возможности приобрести бессерверные модели развертываний API (MaaS).

Выставление счетов

Интерфейс обнаружения, подписки и потребления моделей, развернутых с помощью MaaS, находится на портале Azure AI Foundry и Студия машинного обучения Azure. Пользователи принимают условия лицензии для использования моделей. Сведения о ценах на потребление предоставляются во время развертывания.

Счета за модели от поставщиков, отличных от Майкрософт, выставляются через Azure Marketplace в соответствии с условиями использования Коммерческой платформы Майкрософт.

Счета за модели от Корпорации Майкрософт выставляются через метры Azure в качестве служб потребления первой стороны. Как описано в условиях продукта, вы приобретаете службы потребления первой стороны с помощью счетчиков Azure, но они не применяются к условиям службы Azure. Использование этих моделей распространяется на указанные условия лицензионного соглашения.

Модели точной настройки

Некоторые модели также поддерживают точную настройку. Для этих моделей можно воспользоваться преимуществами управляемых вычислений (предварительная версия) или бессерверной настройки API для настройки моделей с помощью предоставленных данных. Дополнительные сведения см. в обзоре тонкой настройки.

RAG с моделями, развернутыми как бессерверные API

На портале Azure AI Foundry можно использовать векторные индексы и расширенное поколение (RAG). Вы можете использовать модели, которые можно развернуть с помощью бессерверных API для создания внедрения и вывода на основе пользовательских данных. Эти внедрения и вывод могут затем создавать ответы, относящиеся к вашему варианту использования. Дополнительные сведения см. в статье "Создание и использование векторных индексов" на портале Azure AI Foundry.

Региональная доступность предложений и моделей

Выставление счетов за токен доступно только пользователям, подписка Azure которой принадлежит учетной записи выставления счетов в стране или регионе, где поставщик модели сделал предложение доступным. Если предложение доступно в соответствующем регионе, пользователь должен иметь ресурс проекта в регионе Azure, где модель доступна для развертывания или тонкой настройки, как применимо. Доступность регионов для моделей в конечных точках API без сервера | Azure AI Foundry для получения подробных сведений.

Безопасность содержимого для моделей, развернутых с помощью бессерверных API

Для языковых моделей, развернутых с помощью бессерверных API, Azure AI реализует конфигурацию по умолчанию фильтров модерации текста безопасности содержимого ИИ Azure, которые обнаруживают вредное содержимое, например ненависть, самоповредение, сексуальное и насильственное содержимое. Дополнительные сведения о фильтрации содержимого (предварительная версия) см. в статьях "Безопасность содержимого ИИ Azure".

Совет

Фильтрация содержимого (предварительная версия) недоступна для определенных типов моделей, развернутых через бессерверные API. Эти типы моделей включают внедрение моделей и моделей временных рядов.

Фильтрация содержимого (предварительная версия) выполняется синхронно, так как процессы службы запрашивают создание содержимого. Вы можете выставлять счета отдельно в соответствии с ценами на безопасность содержимого искусственного интеллекта Azure для такого использования. Вы можете отключить фильтрацию содержимого (предварительная версия) для отдельных бессерверных конечных точек:

- Во время первого развертывания языковой модели

- Позже, выбрав переключатель фильтрации содержимого на странице сведений о развертывании

Предположим, вы решите использовать API, отличный от API вывода модели ИИ Azure, для работы с моделью, развернутой через бессерверный API. В такой ситуации фильтрация содержимого (предварительная версия) не включена, если только вы не реализуете его отдельно с помощью безопасности содержимого ИИ Azure.

Сведения о начале работы с безопасностью содержимого ИИ Azure см . в кратком руководстве по анализу текстового содержимого. Если при работе с моделями, развернутыми через бессерверные API, не используется фильтрация содержимого (предварительная версия), то при работе с моделями, развернутыми через бессерверные API, возникает более высокий риск предоставления пользователям вредного содержимого.

Сетевая изоляция для моделей, развернутых с помощью бессерверных API

Конечные точки для моделей, развернутых как бессерверные API, следуют параметру флага доступа к общедоступной сети концентратора Azure AI Foundry с проектом, в котором существует развертывание. Чтобы защитить конечную точку API без сервера, отключите флаг доступа к общедоступной сети в центре Azure AI Foundry. Вы можете защитить входящий трафик от клиента к конечной точке с помощью частной конечной точки для концентратора.

Чтобы задать флаг доступа к общедоступной сети для центра Azure AI Foundry, выполните следующие действия.

- Переход на портал Azure.

- Найдите группу ресурсов, к которой принадлежит концентратор, и выберите центр Azure AI Foundry из ресурсов, перечисленных для этой группы ресурсов.

- На странице обзора концентратора на левой панели перейдите в раздел "Параметры>сети".

- На вкладке "Общедоступный доступ" можно настроить параметры для флага доступа к общедоступной сети.

- Сохранение изменений. Для распространения изменений может потребоваться до пяти минут.

Ограничения

Если у вас есть центр Azure AI Foundry с частной конечной точкой, созданной до 11 июля 2024 г., конечные точки API без сервера, добавленные в проекты в этом концентраторе, не будут следовать конфигурации сети концентратора. Вместо этого необходимо создать частную конечную точку для концентратора и создать новые бессерверные развертывания API в проекте, чтобы новые развертывания могли следовать конфигурации сети концентратора.

Если у вас есть центр Azure AI Foundry с развертываниями MaaS, созданными до 11 июля 2024 года, и вы включите частную конечную точку в этом концентраторе, существующие бессерверные развертывания API не будут следовать конфигурации сети концентратора. Для развертываний бессерверных API в концентраторе, чтобы следовать конфигурации сети центра, необходимо снова создать развертывания.

В настоящее время поддержка Azure OpenAI On Your Data недоступна для развертываний бессерверных API в частных центрах, так как частные центры имеют флаг доступа к общедоступной сети отключен.

Любое изменение конфигурации сети (например, включение или отключение флага доступа к общедоступной сети) может занять до пяти минут.