Usar o Spark em blocos de anotações

Você pode executar muitos tipos diferentes de aplicativos no Spark, incluindo código em scripts Python ou Scala, código Java compilado como um Java Archive (JAR) e outros. O Spark é comumente usado em dois tipos de cargas de trabalho:

- Tarefas de processamento em lote ou fluxo para ingerir, limpar e transformar dados - geralmente em execução como parte de um pipeline automatizado.

- Sessões de análise interativas para explorar, analisar e visualizar dados.

Executando o código Spark em blocos de anotações

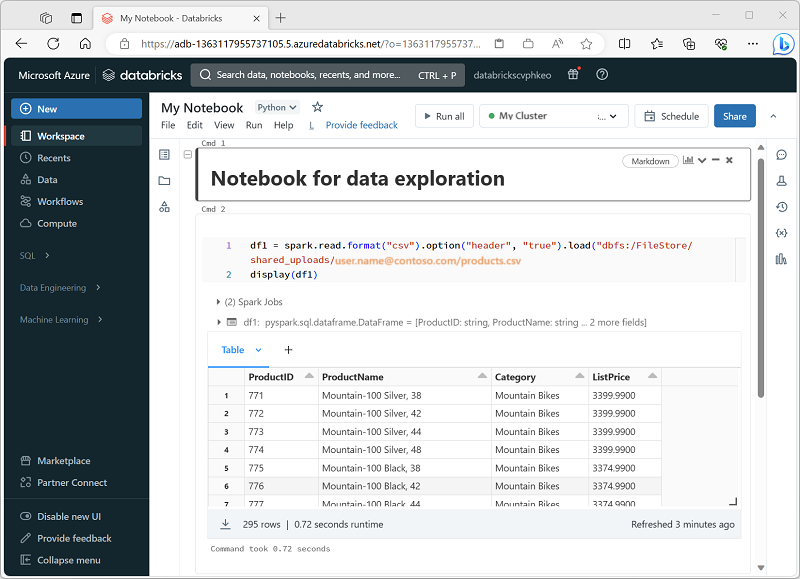

O Azure Databricks inclui uma interface de bloco de notas integrada para trabalhar com o Spark. Os notebooks fornecem uma maneira intuitiva de combinar código com notas Markdown, comumente usadas por cientistas de dados e analistas de dados. A aparência da experiência de notebook integrada no Azure Databricks é semelhante à dos notebooks Jupyter - uma plataforma de notebook de código aberto popular.

Os blocos de notas consistem em uma ou mais células, cada uma contendo código ou marcação. As células de código nos blocos de notas têm algumas funcionalidades que o podem ajudar a ser mais produtivo, incluindo:

- Realce de sintaxe e suporte a erros.

- Preenchimento automático de código.

- Visualizações de dados interativas.

- A capacidade de exportar resultados.

Gorjeta

Para obter mais informações sobre como trabalhar com blocos de anotações no Azure Databricks, consulte o artigo Blocos de anotações na documentação do Azure Databricks.