Mitigar danos potenciais

Depois de determinar uma linha de base e uma maneira de medir a saída prejudicial gerada por uma solução, você pode tomar medidas para mitigar os danos potenciais e, quando apropriado, testar novamente o sistema modificado e comparar os níveis de dano com a linha de base.

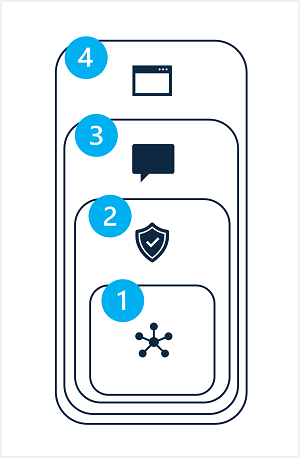

A mitigação de danos potenciais em uma solução de IA generativa envolve uma abordagem em camadas, na qual as técnicas de mitigação podem ser aplicadas em cada uma das quatro camadas, como mostrado aqui:

- Modelo

- Sistema de Segurança

- Metaprompt e aterramento

- Experiência do utilizador

1: A camada do modelo

A camada de modelo consiste em um ou mais modelos de IA generativa no centro da sua solução. Por exemplo, sua solução pode ser construída em torno de um modelo como GPT-4.

As atenuações que você pode aplicar na camada do modelo incluem:

- Selecionar um modelo apropriado para o uso da solução pretendida. Por exemplo, enquanto o GPT-4 pode ser um modelo poderoso e versátil, em uma solução que é necessária apenas para classificar pequenas entradas de texto específicas, um modelo mais simples pode fornecer a funcionalidade necessária com menor risco de geração de conteúdo prejudicial.

- Ajuste fino de um modelo básico com seus próprios dados de treinamento para que as respostas geradas sejam mais relevantes e com escopo para o cenário da solução.

2: A camada do sistema de segurança

A camada do sistema de segurança inclui configurações e recursos no nível da plataforma que ajudam a mitigar danos. Por exemplo, o Azure AI Studio inclui suporte para filtros de conteúdo que aplicam critérios para suprimir prompts e respostas com base na classificação do conteúdo em quatro níveis de gravidade (seguro, baixo, médio e alto) para quatro categorias de dano potencial (ódio, sexual, violência e automutilação).

Outras mitigações da camada do sistema de segurança podem incluir algoritmos de deteção de abuso para determinar se a solução está sendo sistematicamente abusada (por exemplo, por meio de grandes volumes de solicitações automatizadas de um bot) e notificações de alerta que permitem uma resposta rápida a possíveis abusos do sistema ou comportamento prejudicial.

3: O metaprompt e a camada de aterramento

A camada de metaprompt e aterramento se concentra na construção de prompts que são enviados ao modelo. As técnicas de mitigação de danos que você pode aplicar nesta camada incluem:

- Especificação de metaprompts ou entradas do sistema que definem parâmetros comportamentais para o modelo.

- Aplicação de engenharia imediata para adicionar dados de aterramento aos prompts de entrada, maximizando a probabilidade de uma saída relevante e não prejudicial.

- Usando uma abordagem de geração aumentada de recuperação (RAG) para recuperar dados contextuais de fontes de dados confiáveis e incluí-los em prompts.

4: A camada de experiência do usuário

A camada de experiência do usuário inclui o aplicativo de software através do qual os usuários interagem com o modelo de IA generativa e documentação ou outro material de apoio do usuário que descreve o uso da solução para seus usuários e partes interessadas.

Projetar a interface do usuário do aplicativo para restringir as entradas a assuntos ou tipos específicos, ou aplicar a validação de entrada e saída pode reduzir o risco de respostas potencialmente prejudiciais.

A documentação e outras descrições de uma solução de IA generativa devem ser adequadamente transparentes sobre as capacidades e limitações do sistema, os modelos nos quais ele se baseia e quaisquer danos potenciais que nem sempre podem ser abordados pelas medidas de mitigação que você implementou.