Exercício – Moderação de imagem

A Contoso Camping Store oferece aos clientes a capacidade de carregar fotos para complementar suas avaliações de produtos. Os clientes acham esse recurso útil, pois fornece informações sobre como os produtos parecem e funcionam fora das imagens genéricas de marketing. Poderíamos aplicar um modelo de IA para detetar se as imagens postadas por nossos clientes são prejudiciais e, posteriormente, usar os resultados da deteção para implementar as precauções necessárias.

Conteúdos seguros

Vamos primeiro testar uma imagem de um acampamento em família!

Na página Segurança de Conteúdo, selecione Moderar conteúdo de imagem.

Selecione Procurar um ficheiro e carregue-o

family-builds-campfire.JPG.Defina todos os níveis de Limite como Médio.

Selecione Executar teste.

Como esperado, esse conteúdo de imagem é Permitido e o nível de Severidade é Seguro em todas as categorias.

Conteúdo violento

Devemos também antecipar os clientes que podem publicar conteúdo de imagem prejudicial. Para garantir que respondemos por esse cenário, vamos testar a deteção de conteúdo de imagem prejudicial.

Nota

A imagem usada para o teste contém uma deteção gráfica de um ataque de urso. A imagem é desfocada por padrão na visualização da imagem. No entanto, você pode usar a alternância de imagem Desfoque para alterar essa configuração.

- Selecione Procurar um ficheiro e carregue-o

bear-attack-blood.JPG. - Defina todos os níveis de Limite como Médio.

- Selecione Executar teste.

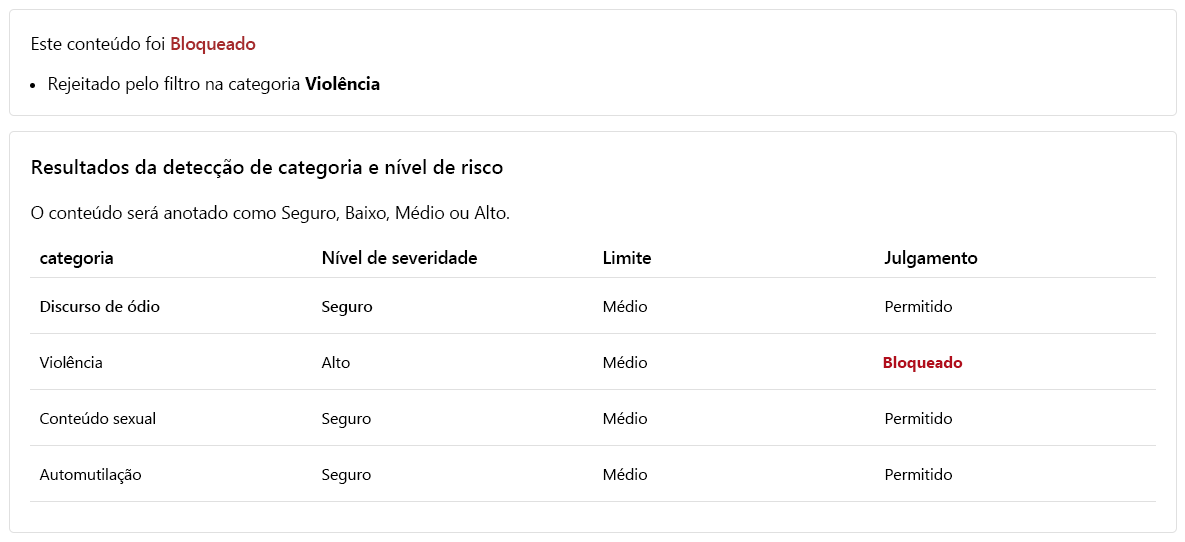

Com razão, o conteúdo é Bloqueado e foi rejeitado pelo filtro Violência que tem um nível de Severidade Alto.

Executar um teste em massa

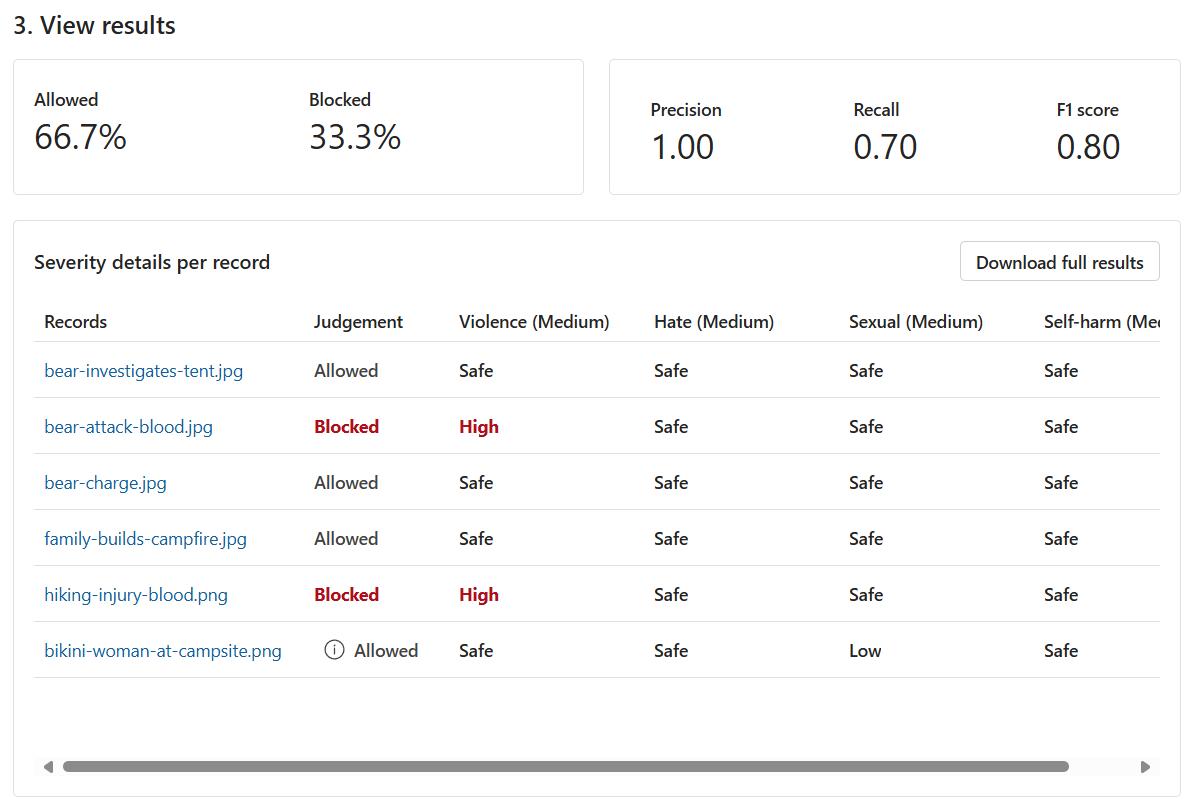

Até agora, testamos o conteúdo da imagem para imagens isoladas singulares. No entanto, se tivermos um conjunto de dados em massa de conteúdo de imagem, poderemos testar o conjunto de dados em massa de uma só vez e receber métricas com base no desempenho do modelo.

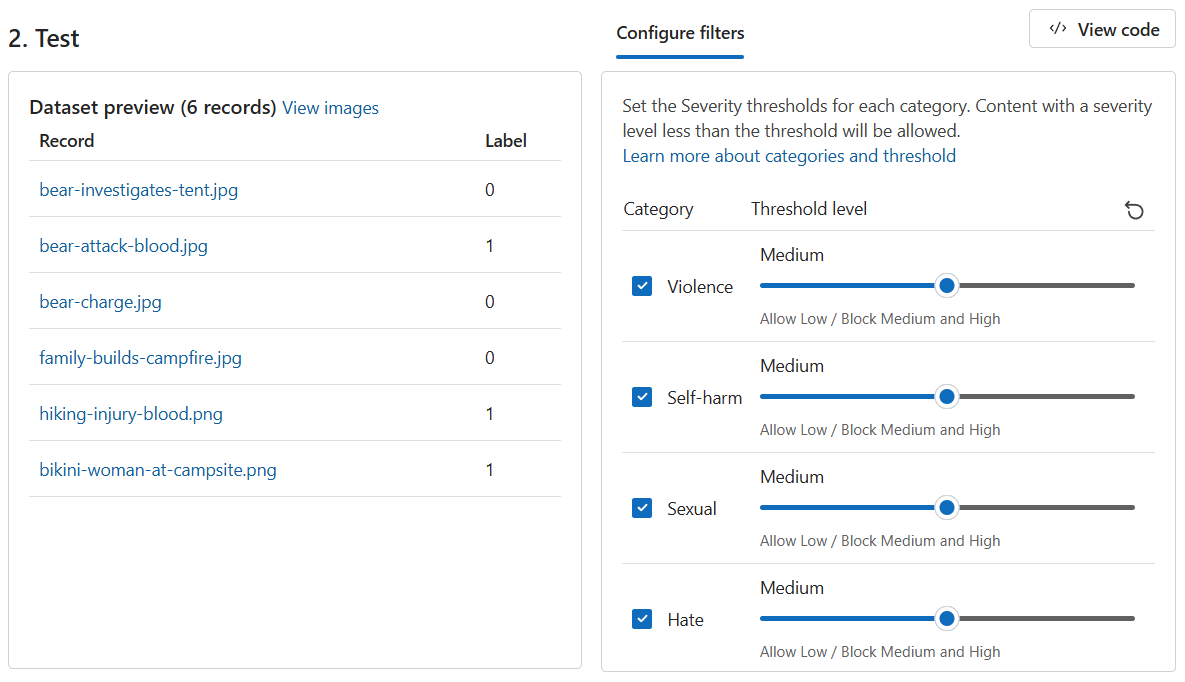

Temos um conjunto de dados em massa de imagens fornecidas pelos clientes. O conjunto de dados também inclui imagens nocivas de amostra para testar a capacidade do modelo de detetar conteúdo nocivo. Cada registro no conjunto de dados inclui um rótulo para indicar se o conteúdo é prejudicial. Vamos fazer outra rodada de testes, mas desta vez com o conjunto de dados!

Alterne para a guia Executar um teste em massa.

Selecione Procurar um ficheiro e carregue-o

bulk-image-moderation-dataset.zip.Na seção de visualização do Conjunto de Dados, navegue pelos Registros e pelo Rótulo correspondente. A 0 indica que o conteúdo é aceitável (não prejudicial). A 1 indica que o conteúdo é inaceitável (conteúdo nocivo).

Defina todos os níveis de Limite como Médio.

Selecione Executar teste.

Com base nos resultados, há margem para melhorias? Em caso afirmativo, ajuste os níveis de Limite até que as métricas de Precisão, Recall e Pontuação F1 estejam mais próximas de 1.