Como funciona o Azure Data Factory

Aqui, você aprenderá sobre os componentes e sistemas interconectados do Azure Data Factory e como eles funcionam. Esse conhecimento deve ajudá-lo a determinar como você pode usar melhor o Azure Data Factory para atender aos requisitos da sua organização.

O Azure Data Factory é uma coleção de sistemas interconectados que se combinam para fornecer uma plataforma de análise de dados de ponta a ponta. Nesta unidade, você aprenderá sobre as seguintes funções do Azure Data Factory:

- Ligar e recolher

- Transformar e enriquecer

- Integração e entrega contínuas (CI/CD) e publicação

- Monitorização

Você também aprende sobre esses componentes principais do Azure Data Factory:

- Pipelines

- Atividades

- Conjuntos de Dados

- Serviços ligados

- Fluxos de dados

- Tempos de execução de integração

Funções do Azure Data Factory

O Azure Data Factory consiste em várias funções que se combinam para fornecer aos seus engenheiros de dados uma plataforma completa de análise de dados.

Ligar e recolher

A primeira parte do processo consiste em recolher os dados necessários a partir das fontes de dados adequadas. Essas fontes podem ser localizadas em diferentes locais, incluindo fontes locais e na nuvem. Os dados podem ser:

- estruturado

- não estruturado

- semiestruturado

Além disso, esses dados díspares podem chegar em velocidades e intervalos diferentes. Com o Azure Data Factory, você pode usar a atividade de cópia para mover dados de várias fontes para um único armazenamento de dados centralizado na nuvem. Depois de copiar os dados, você usa outros sistemas para transformá-los e analisá-los.

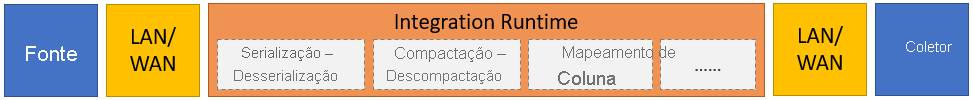

A atividade de cópia executa as seguintes etapas de alto nível:

Leia os dados do armazenamento de dados de origem.

Execute as seguintes tarefas nos dados:

- Serialização/desserialização

- Compressão/descompressão

- Mapeamento de colunas

Nota

Pode haver tarefas adicionais.

Grave dados no armazenamento de dados de destino (conhecido como coletor).

Este processo está resumido no seguinte gráfico:

Transformar e enriquecer

Depois de copiar com êxito os dados para um local central baseado na nuvem, você pode processar e transformar os dados conforme necessário usando os fluxos de dados de mapeamento do Azure Data Factory. Os fluxos de dados permitem criar gráficos de transformação de dados que são executados no Spark. No entanto, você não precisa entender os clusters do Spark ou a programação do Spark.

Gorjeta

Embora não seja necessário, você pode preferir codificar suas transformações manualmente. Nesse caso, o Azure Data Factory dá suporte a atividades externas para executar suas transformações.

CI/CD e publicar

O suporte para CI/CD permite que você desenvolva e entregue seus processos de extração, transformação e carregamento (ETL) incrementalmente antes de publicar. O Azure Data Factory fornece CI/CD de seus pipelines de dados usando:

- Azure DevOps

- GitHub

Nota

Integração contínua significa testar automaticamente cada alteração feita em sua base de código o mais rápido possível. A entrega contínua segue esse teste e envia as alterações para um sistema de preparação ou produção.

Depois que o Azure Data Factory refinar os dados brutos, você poderá carregá-los em qualquer mecanismo de análise que seus usuários corporativos possam acessar a partir de suas ferramentas de business intelligence, incluindo:

- Azure Synapse Analytics

- Base de Dados SQL do Azure

- Azure Cosmos DB

Monitor

Depois de criar e implantar com êxito seu pipeline de integração de dados, é importante que você possa monitorar suas atividades agendadas e pipelines. O monitoramento permite acompanhar as taxas de sucesso e falha. O Azure Data Factory fornece suporte para monitoramento de pipeline usando um dos seguintes métodos:

- Azure Monitor

- API

- PowerShell

- Registos do Azure Monitor

- Painéis de integridade no portal do Azure

Componentes do Azure Data Factory

O Azure Data Factory é composto pelos componentes descritos na tabela a seguir:

| Componente | Description |

|---|---|

| Pipelines | Um agrupamento lógico de atividades que executam uma unidade específica de trabalho. Essas atividades juntas executam uma tarefa. A vantagem de usar um pipeline é que você pode gerenciar mais facilmente as atividades como um conjunto em vez de como itens individuais. |

| Atividades | Uma única etapa de processamento em um pipeline. O Azure Data Factory dá suporte a três tipos de atividade: movimentação de dados, transformação de dados e atividades de controle. |

| Conjuntos de Dados | Represente estruturas de dados em seus armazenamentos de dados. Os conjuntos de dados apontam para (ou fazem referência) aos dados que você deseja usar em suas atividades como entradas ou saídas. |

| Serviços ligados | Defina as informações de conexão necessárias para que o Azure Data Factory se conecte a recursos externos, como uma fonte de dados. O Azure Data Factory usa serviços vinculados para duas finalidades: para representar um armazenamento de dados ou um recurso de computação. |

| Fluxos de dados | Permita que seus engenheiros de dados desenvolvam lógica de transformação de dados sem a necessidade de escrever código. Os fluxos de dados são executados como atividades dentro dos pipelines do Azure Data Factory que usam clusters Apache Spark escalonados. |

| Tempos de execução de integração | O Azure Data Factory usa a infraestrutura de computação para fornecer os seguintes recursos de integração de dados em diferentes ambientes de rede: fluxo de dados, movimentação de dados, despacho de atividades e execução de pacotes do SQL Server Integration Services (SSIS). No Azure Data Factory, um tempo de execução de integração fornece a ponte entre a atividade e os serviços vinculados. |

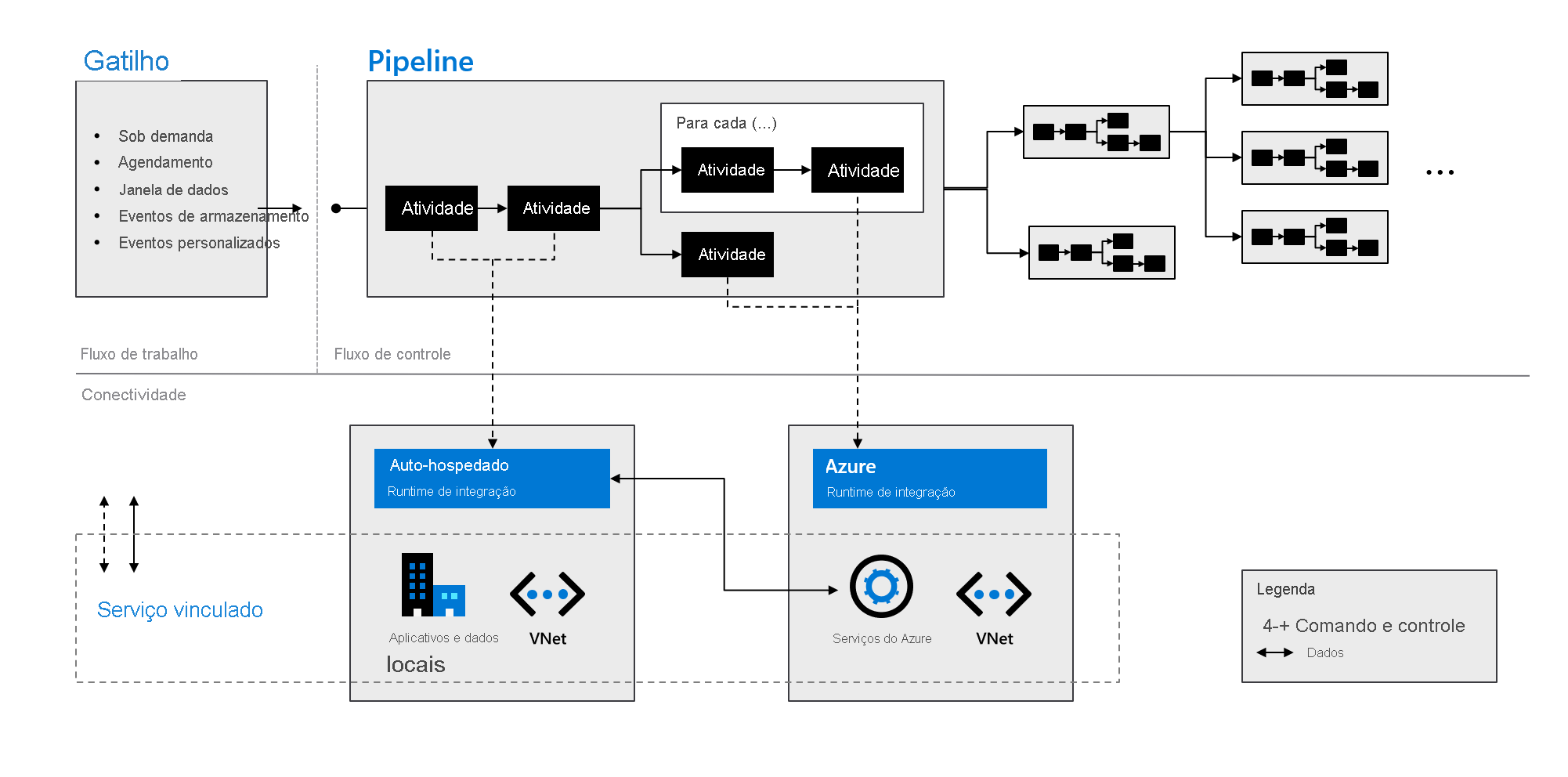

Conforme indicado no gráfico a seguir, esses componentes trabalham juntos para fornecer uma plataforma completa de ponta a ponta para engenheiros de dados. Usando o Data Factory, você pode:

- Defina gatilhos sob demanda e agende o processamento de dados com base em suas necessidades.

- Associe um pipeline a um gatilho ou inicie-o manualmente como e quando necessário.

- Conecte-se a serviços vinculados (como aplicativos e dados locais) ou serviços do Azure por meio de tempos de execução de integração.

- Monitore todo o seu pipeline executado nativamente na experiência do usuário do Azure Data Factory ou usando o Azure Monitor.