Avaliar e comparar modelos

Quando um experimento de aprendizado de máquina automatizado (AutoML) for concluído, você desejará revisar os modelos que foram treinados e decidir qual deles teve o melhor desempenho.

No estúdio do Azure Machine Learning, você pode selecionar um experimento AutoML para explorar seus detalhes.

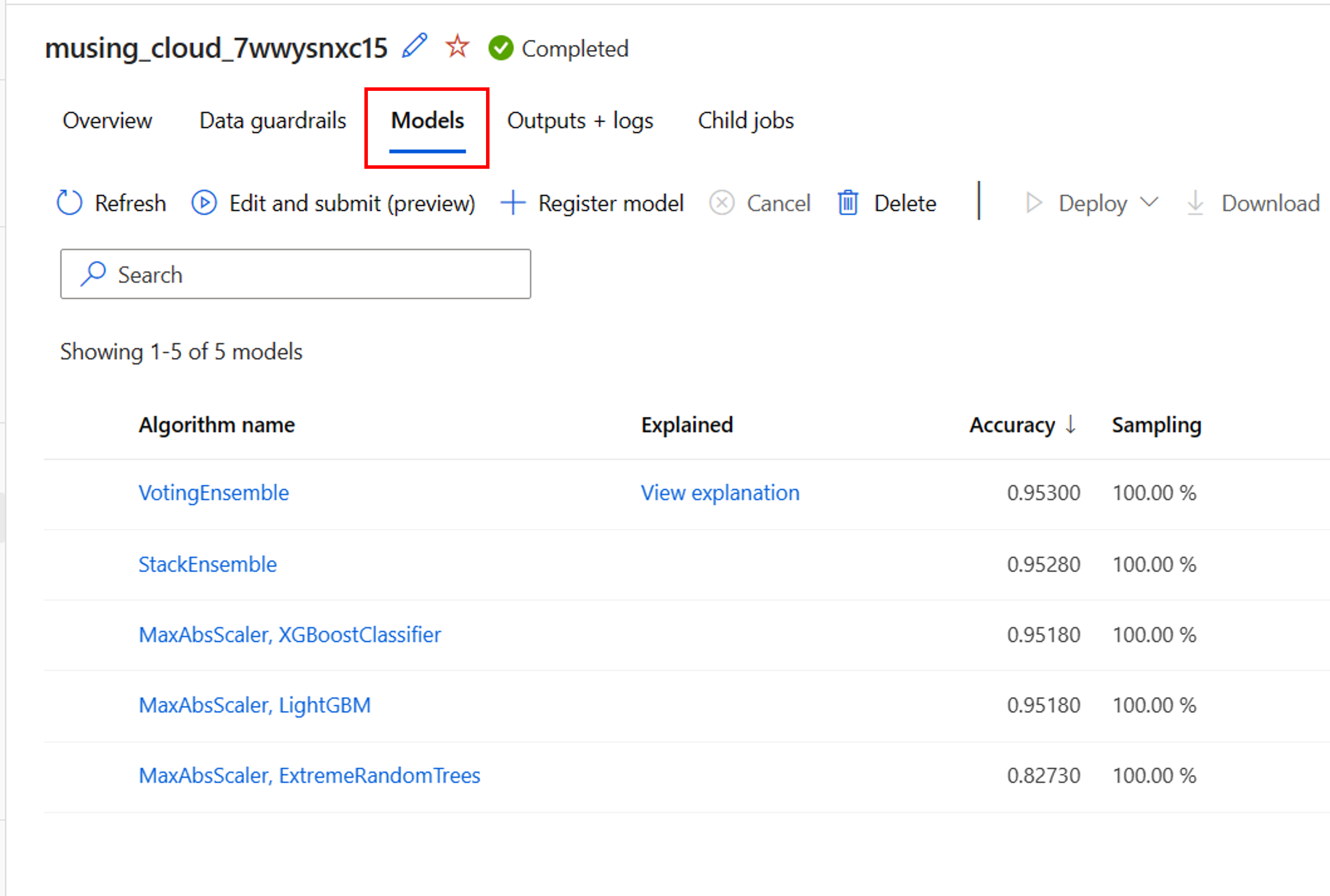

Na página Visão geral da execução do experimento AutoML, você pode revisar o ativo de dados de entrada e o resumo do melhor modelo. Para explorar todos os modelos que foram treinados, você pode selecionar a guia Modelos :

Explore as etapas de pré-processamento

Quando você tiver ativado a featurização para seu experimento AutoML, os guardrails de dados também serão aplicados automaticamente. Os três guardrails de dados suportados para modelos de classificação são:

- Deteção de balanceamento de classe.

- Imputação de valores de recurso ausente.

- Deteção de recursos de alta cardinalidade.

Cada um desses guarda-corpos de dados mostrará um dos três estados possíveis:

- Aprovado: Nenhum problema foi detetado e nenhuma ação é necessária.

- Concluído: as alterações foram aplicadas aos seus dados. Você deve revisar as alterações feitas pelo AutoML em seus dados.

- Alertado: foi detetado um problema, mas não foi possível corrigi-lo. Deve rever os dados para corrigir o problema.

Ao lado dos guardrails de dados, o AutoML pode aplicar técnicas de dimensionamento e normalização a cada modelo treinado. Você pode revisar a técnica aplicada na lista de modelos em Nome do algoritmo.

Por exemplo, o nome do algoritmo de um modelo listado pode ser MaxAbsScaler, LightGBM. MaxAbsScaler refere-se a uma técnica de dimensionamento em que cada recurso é dimensionado pelo seu valor absoluto máximo. LightGBM refere-se ao algoritmo de classificação usado para treinar o modelo.

Recupere a melhor execução e seu modelo

Ao revisar os modelos no AutoML, você pode identificar facilmente a melhor execução com base na métrica principal especificada. No estúdio do Azure Machine Learning, os modelos são classificados automaticamente para mostrar o modelo com melhor desempenho na parte superior.

Na guia Modelos do experimento AutoML, você pode editar as colunas se quiser mostrar outras métricas na mesma visão geral. Ao criar uma visão geral mais abrangente que inclui várias métricas, pode ser mais fácil comparar modelos.

Para explorar ainda mais um modelo, você pode gerar explicações para cada modelo que foi treinado. Ao configurar um experimento AutoML, você pode especificar que explicações devem ser geradas para o modelo de melhor desempenho. No entanto, se estiver interessado na interpretabilidade de outro modelo, pode selecionar o modelo na descrição geral e selecionar Explicar modelo.

Nota

Explicar um modelo é uma aproximação à interpretabilidade do modelo. Especificamente, as explicações estimarão a importância relativa dos recursos no recurso de destino (o que o modelo é treinado para prever). Saiba mais sobre a interpretabilidade do modelo.

Gorjeta

Saiba mais sobre como avaliar execuções de AutoML.