Explore os modelos de linguagem no catálogo de modelos

Selecionar um modelo de linguagem para seu aplicativo de IA generativa é importante, pois afeta o funcionamento do seu aplicativo. Ao desenvolver um aplicativo de IA generativo com o Azure AI Foundry, você cria um aplicativo de chat que pode usar modelos de linguagem para várias finalidades:

- Para entender a pergunta do usuário.

- Procurar contexto relevante.

- Para gerar uma resposta à pergunta do usuário.

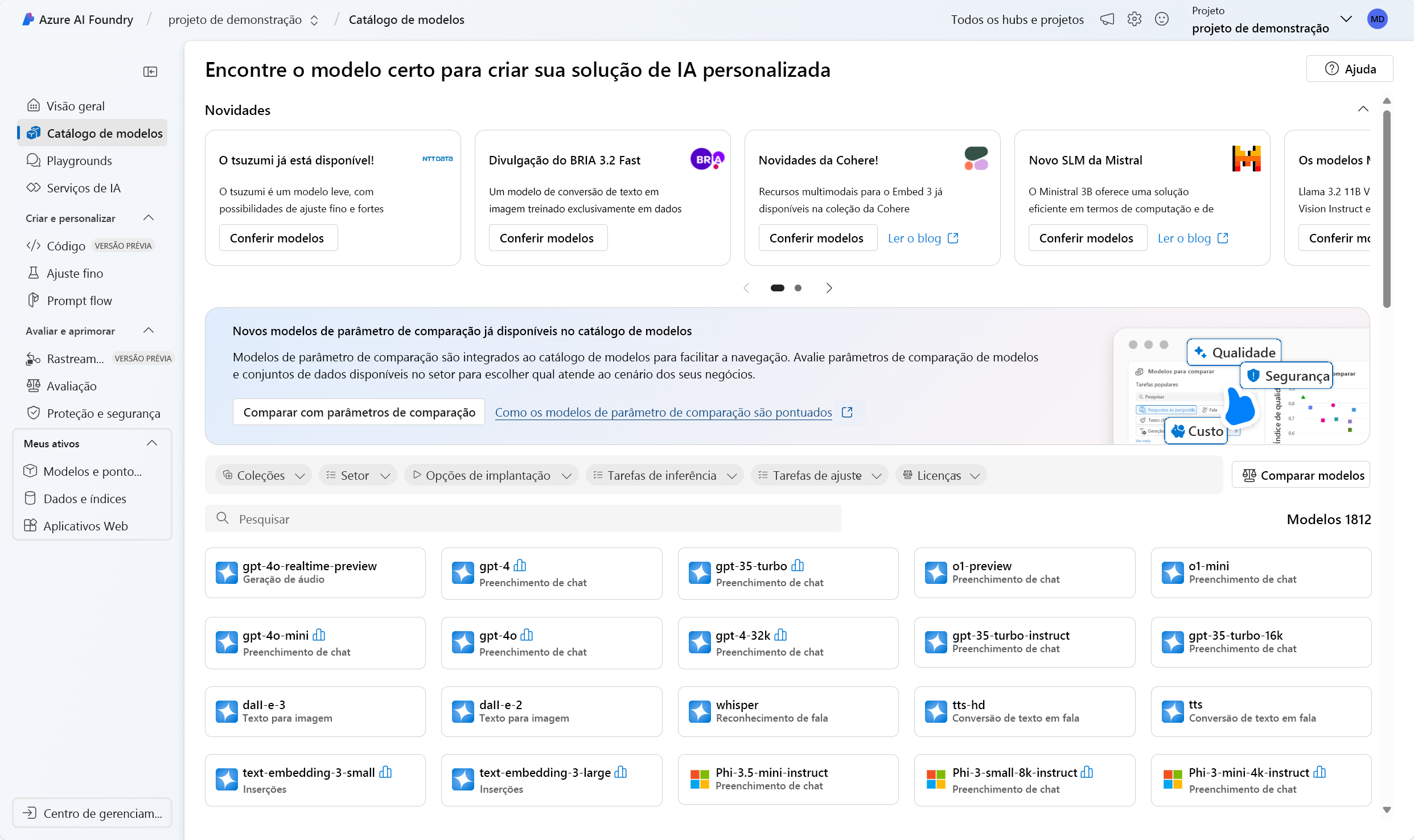

No portal do Azure AI Foundry, você pode procurar modelos de linguagem disponíveis no catálogo de modelos. Vamos explorar o catálogo de modelos e os tipos de modelos de linguagem disponíveis por meio da IA do Azure.

Explore o catálogo de modelos

No portal do Azure AI Foundry, você pode navegar até o catálogo de modelos para explorar todos os modelos de linguagem disponíveis. Além disso, você pode importar qualquer modelo da biblioteca de código aberto Hugging Face para o catálogo de modelos.

Gorjeta

Hugging Face é uma comunidade de código aberto que disponibiliza modelos ao público. Você pode encontrar todos os modelos em seu catálogo. Além disso, você pode explorar a documentação para saber mais sobre como modelos individuais funcionam, como o BERT.

O catálogo de modelos do Azure AI Foundry integra-se com modelos do Hugging Face e de outras fontes. Através do catálogo de modelos, você pode explorar, ajustar e implantar modelos.

Importante

A disponibilidade do modelo varia de acordo com o local, também conhecido como região. Sua localização é especificada no nível do hub de IA. Ao criar um novo Hub de IA, você pode usar o Auxiliar de localização para especificar o modelo que deseja implantar para obter uma lista de locais nos quais você pode implantá-lo. Você também pode explorar a tabela de resumo do modelo e a disponibilidade da região para saber mais.

Explore modelos linguísticos

Os modelos de base ou de linguagem disponíveis no catálogo de modelos já estão pré-treinados. Você pode implantar um modelo de linguagem em um ponto de extremidade ou ajustar um modelo para torná-lo melhor desempenho em uma tarefa especializada ou em conhecimento específico do domínio.

O modelo selecionado depende do seu caso de uso e preferências de implantação. Em primeiro lugar, você precisa pensar sobre a tarefa que deseja que o modelo execute. Por exemplo:

- Classificação de textos

- Classificação de tokens

- Perguntas e respostas

- Resumo

- Tradução

Alguns modelos de linguagem que são comumente usados para várias tarefas são:

| Modelo | Description |

|---|---|

| BERT (Representações de codificadores bidirecionais de transformadores) | Focado na codificação de informações usando contexto de antes e depois de um token (bidirecional). Comumente usado quando você deseja ajustar um modelo para executar uma tarefa específica, como classificação de texto e resposta a perguntas. |

| GPT (Transformador Generativo Pré-treinado) | Treinado para criar texto coerente e contextualmente relevante, e é mais comumente usado para tarefas como geração de texto e conclusão de bate-papo. |

| LLaMA (Modelo de Linguagem Grande Meta AI) | Uma família de modelos criada pela Meta. Ao treinar modelos LLaMA, o foco tem sido fornecer mais dados de treinamento do que aumentar a complexidade dos modelos. Você pode usar modelos LLaMA para geração de texto e conclusão de bate-papo. |

| Phi-3-mini (variação de parâmetros 3.8B de modelos phi) | Um modelo leve e de última geração otimizado para ambientes com recursos restritos e inferência local (como em um telefone), suportando prompts de contexto longo de até 128 K tokens. É desenvolvido com foco na segurança, alinhamento e reforço aprendendo com o feedback humano. |

Depois de selecionar uma tarefa e filtrar os modelos disponíveis que são adequados para o seu objetivo, você pode revisar o resumo do modelo no Azure AI Foundry para levar algumas outras considerações em consideração:

- Recursos do modelo: avalie os recursos do modelo de linguagem e quão bem eles se alinham com sua tarefa. Por exemplo, um modelo como o BERT é melhor na compreensão de textos curtos.

- Dados de pré-treinamento: considere o conjunto de dados usado para pré-treinar o modelo de linguagem. Por exemplo, o GPT-2 é treinado em conteúdo não filtrado da internet que pode resultar em preconceitos.

- Limitações e enviesamentos: Esteja ciente de quaisquer limitações ou enviesamentos que possam estar presentes no modelo de linguagem.

- Suporte a idiomas: explore quais modelos oferecem o suporte a idiomas específicos ou recursos multilíngues de que você precisa para seu caso de uso.

Gorjeta

Embora o Azure AI Foundry forneça descrições para cada modelo de linguagem no catálogo de modelos, você também pode encontrar mais informações sobre cada modelo por meio do respetivo cartão de modelo. Os cartões modelo são referenciados na visão geral de cada modelo e hospedados no site da Hugging Face

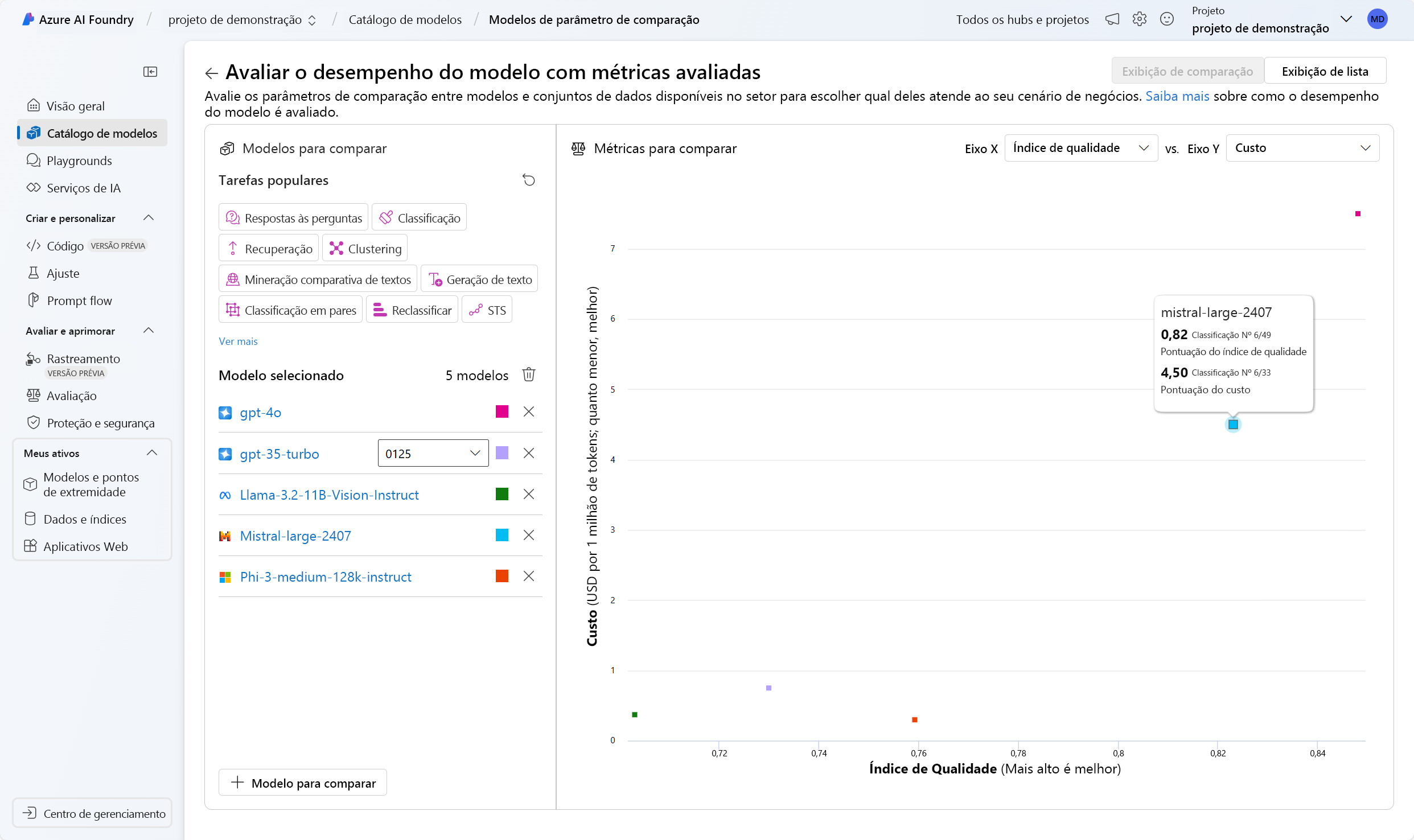

Compare benchmarks entre modelos

Ao explorar modelos de linguagem, você também pode comparar os benchmarks de modelo disponíveis para avaliar a qualidade dos modelos antes de implantar e integrar um modelo. Os parâmetros de referência são como boletins para modelos linguísticos. Os benchmarks ajudam a entender o desempenho de um modelo, comparando-o com outros modelos usando testes ou tarefas específicas. Os benchmarks de modelo no portal do Azure AI Foundry fornecem uma lista selecionada dos modelos com melhor desempenho para uma determinada tarefa, com base em métricas de benchmarking.

Algumas métricas comumente usadas para avaliar o desempenho de modelos de linguagem são:

| Métricas | Descrição |

|---|---|

| Exatidão | As pontuações de precisão estão disponíveis no conjunto de dados e nos níveis do modelo. No nível do conjunto de dados, a pontuação é o valor médio de uma métrica de precisão calculada sobre todos os exemplos no conjunto de dados. A métrica de precisão usada é de correspondência exata em todos os casos, exceto para o conjunto de dados HumanEval que usa uma métrica pass@1. A correspondência exata simplesmente compara o texto gerado pelo modelo com a resposta correta de acordo com o conjunto de dados, relatando um se o texto gerado corresponder exatamente à resposta e zero caso contrário. Pass@1 mede a proporção de soluções de modelo que passam em um conjunto de testes de unidade em uma tarefa de geração de código. No nível do modelo, a pontuação de precisão é a média das precisões no nível do conjunto de dados para cada modelo. |

| Coerência | A coerência avalia o quão bem o modelo de linguagem pode produzir resultados que fluem suavemente, lêem naturalmente e se assemelham à linguagem humana. |

| Fluência | A fluência avalia a proficiência linguística da resposta prevista de uma IA generativa. Ele avalia o quão bem o texto gerado adere às regras gramaticais, estruturas sintáticas e uso apropriado do vocabulário, resultando em respostas linguisticamente corretas e com sonoridade natural. |

| GPTSimilaridade | GPTSimilarity é uma medida que quantifica a semelhança entre uma sentença (ou documento) de verdade fundamental e a sentença de previsão gerada por um modelo de IA. Ele é calculado pela primeira computação de incorporações de nível de sentença usando a API de incorporação para a verdade do terreno e a previsão do modelo. Essas incorporações representam representações vetoriais de alta dimensão das frases, capturando seu significado semântico e contexto. |

| Fundamentação | A fundamentação mede o quão bem as respostas geradas pelo modelo de linguagem se alinham com as informações da fonte de entrada. |

| Pertinência | A relevância mede até que ponto as respostas geradas pelo modelo de linguagem são pertinentes e diretamente relacionadas às perguntas dadas. |

Nota

Ao desenvolver e avaliar aplicativos que usam modelos de linguagem, é importante usar métricas para medir o desempenho do modelo e do aplicativo. As mesmas métricas usadas para benchmarks, que comparam modelos diferentes, também podem ser usadas para avaliar o desempenho de um modelo individual durante o desenvolvimento. Essas métricas ajudam você a entender o desempenho do seu modelo e a identificar áreas para melhoria.

Selecionar o modelo que atende às suas necessidades, pode ser um processo iterativo. Em seguida, você aprenderá como implantar um modelo para testá-lo e experimentar como otimizar o modelo para seu caso de uso.