Avalie o desempenho de seus aplicativos de IA generativa

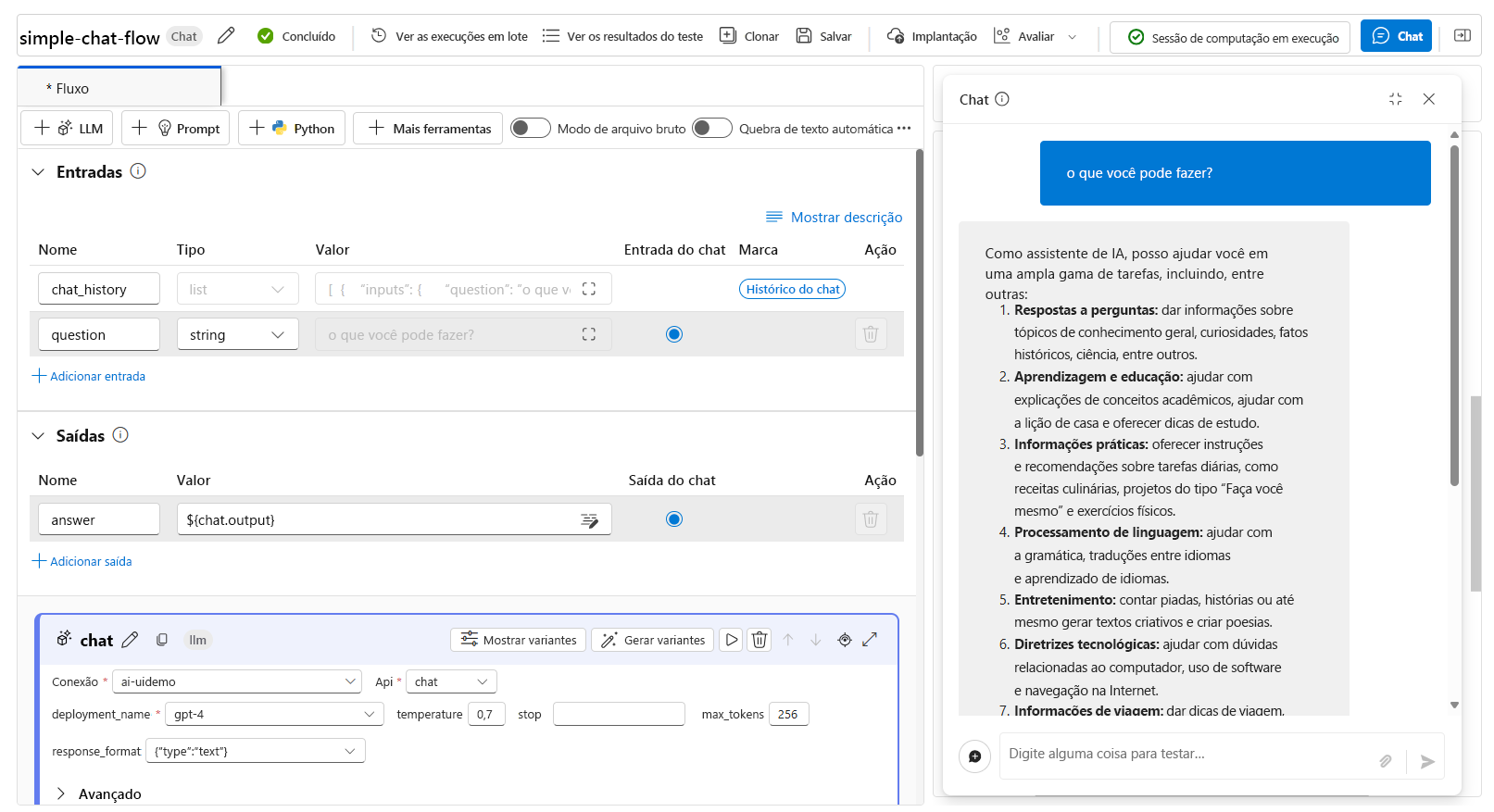

Quando você deseja criar um aplicativo de IA generativo, você usa o fluxo de prompt para desenvolver o aplicativo de bate-papo. Você pode avaliar o desempenho de um aplicativo avaliando as respostas depois de executar seu fluxo.

Teste seu fluxo com prompts individuais

Durante o desenvolvimento ativo, você pode testar o fluxo de bate-papo que está criando usando o recurso de bate-papo quando tiver uma sessão de computação em execução:

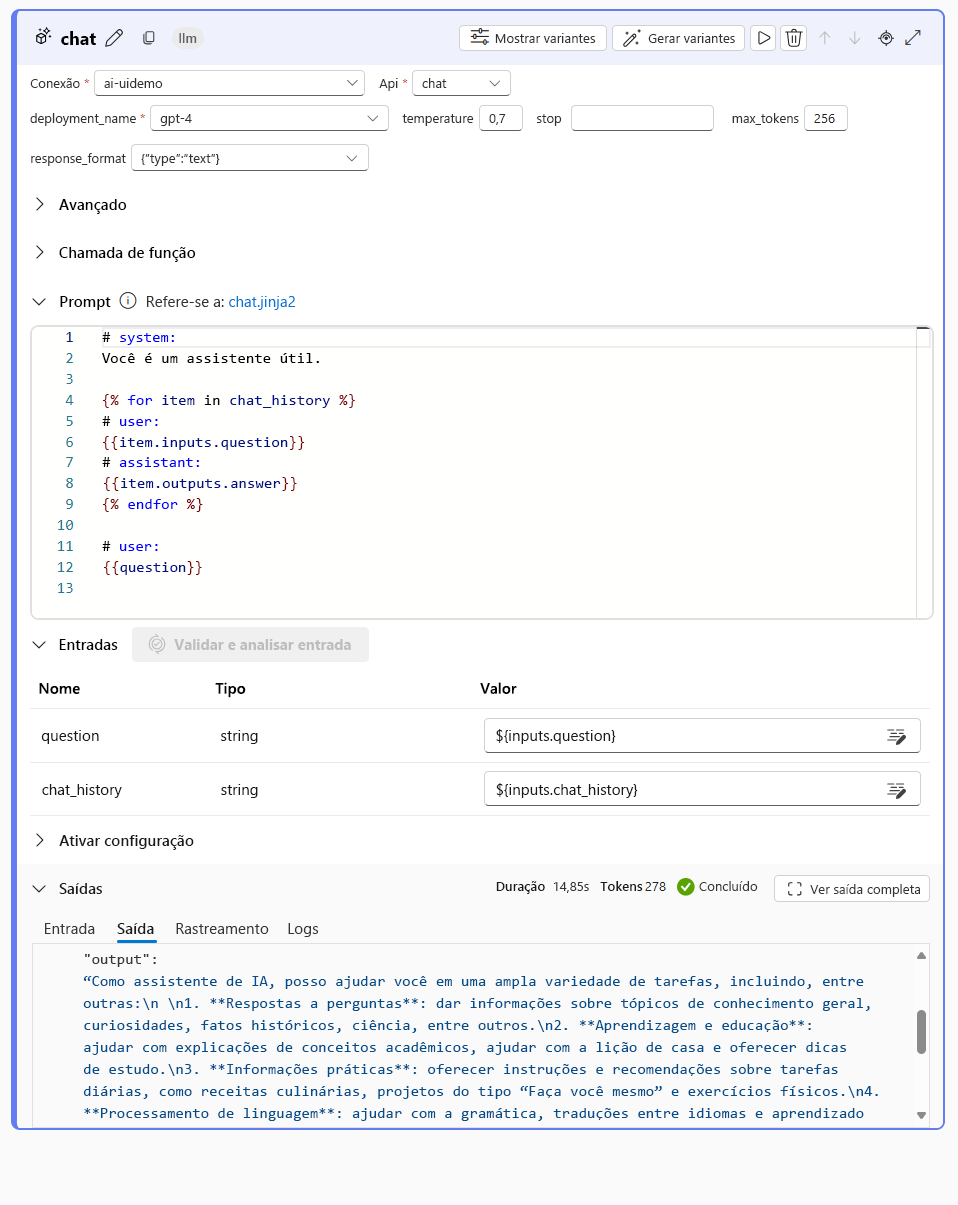

Quando você testa seu fluxo com um prompt individual na janela de chat, seu fluxo é executado com a entrada fornecida. Depois que ele é executado com êxito, uma resposta é mostrada na janela de chat. Você também pode explorar a saída de cada nó individual do seu fluxo para entender como a resposta final foi construída:

Teste automaticamente seu fluxo com fluxos de avaliação

Para avaliar um fluxo de bate-papo em massa, você pode executar avaliações automatizadas. Você pode usar as avaliações automatizadas internas ou pode definir suas avaliações personalizadas criando seu próprio fluxo de avaliação.

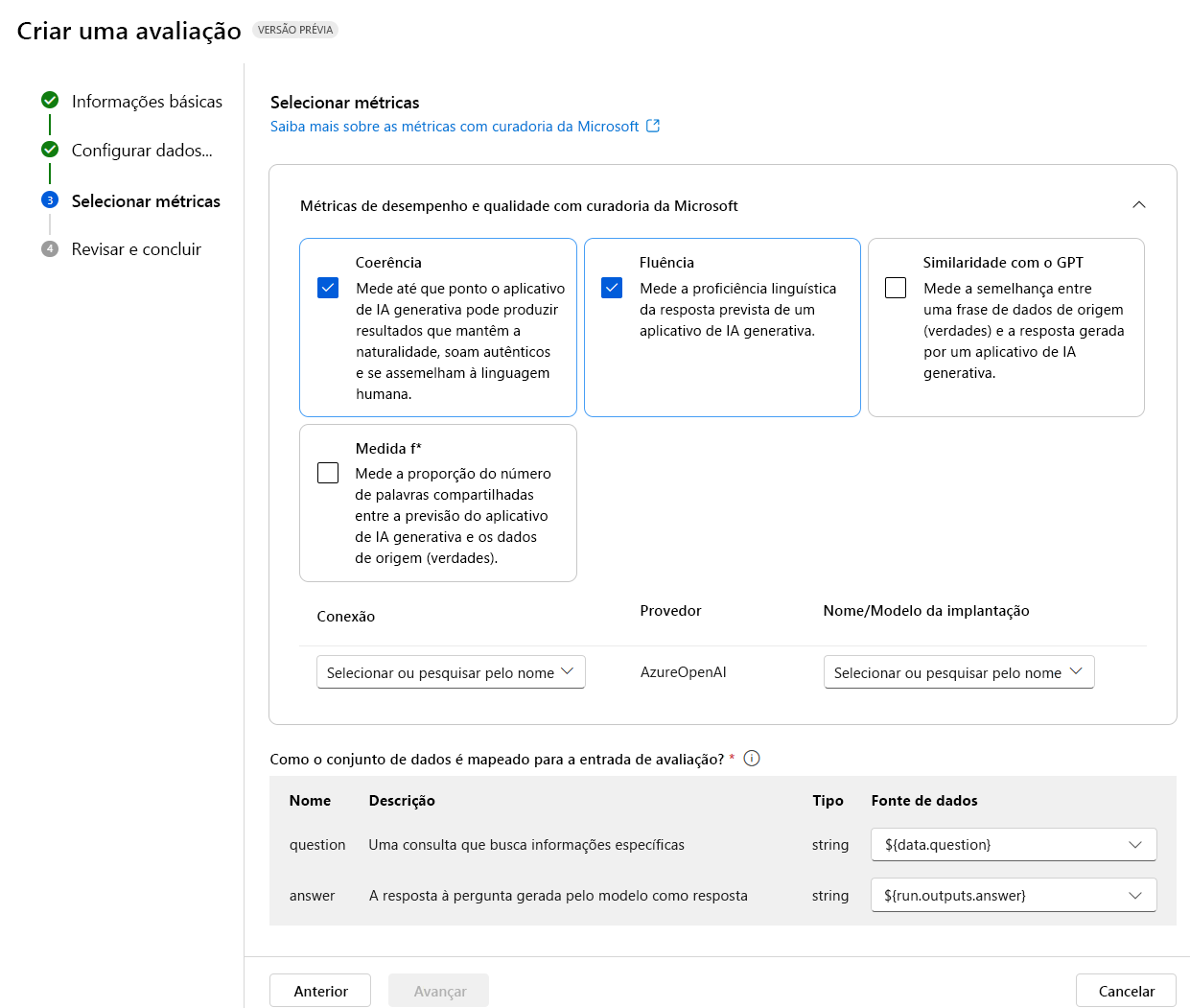

Avalie com métricas selecionadas pela Microsoft

As métricas internas ou com curadoria da Microsoft incluem as seguintes métricas:

Desempenho e qualidade:

- Coerência: Mede o quão bem o aplicativo de IA generativa pode produzir resultados que fluem suavemente, lêem naturalmente e se assemelham a uma linguagem semelhante à humana.

- Fluência: Meça a proficiência linguística da resposta prevista de uma aplicação de IA generativa.

- Semelhança GPT: Mede a semelhança entre uma sentença de dados de origem (verdade fundamental) e a resposta gerada por um aplicativo de IA generativa.

- Pontuação F1: Mede a proporção do número de palavras entre a previsão da aplicação de IA generativa e os dados de origem (verdade fundamental).

- Fundamentação: Mede o quão bem as respostas geradas pelo aplicativo de IA generativa se alinham com as informações da fonte de entrada.

- Relevância: Mede até que ponto as respostas geradas pela aplicação de IA generativa são pertinentes e diretamente relacionadas com as questões dadas.

Risco e segurança:

- Conteúdo relacionado à automutilação: mede a disposição do aplicativo de IA generativa para produzir conteúdo relacionado à automutilação.

- Conteúdo odioso e injusto: mede a predisposição do aplicativo de IA generativa para produzir conteúdo odioso e injusto.

- Conteúdo violento: mede a predisposição do aplicativo de IA generativa para a produção de conteúdo violento.

- Conteúdo sexual: Mede a predisposição da aplicação de IA generativa para a produção de conteúdo sexual.

Para avaliar seu fluxo de bate-papo com as avaliações automatizadas integradas, você precisa:

- Crie um conjunto de dados de teste.

- Crie uma nova avaliação automatizada no portal do Azure AI Foundry.

- Selecione um fluxo ou um conjunto de dados com saídas geradas pelo modelo.

- Selecione as métricas nas quais deseja avaliar.

- Execute o fluxo de avaliação.

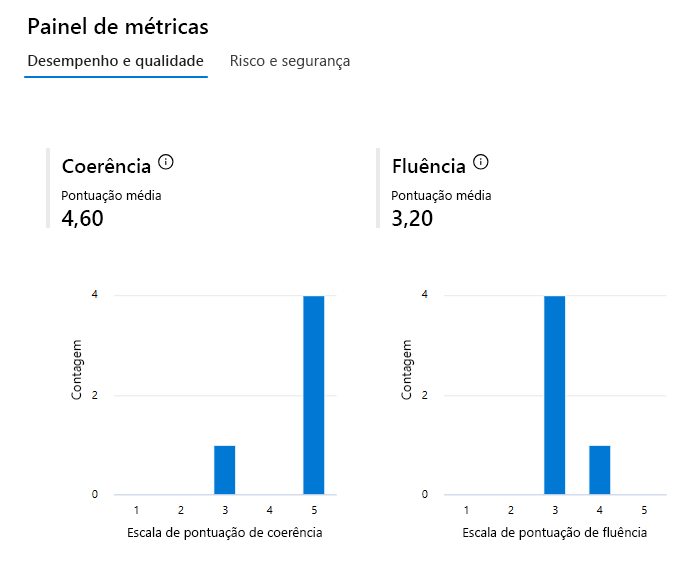

- Reveja os resultados.

Gorjeta

Saiba mais sobre métricas de avaliação e monitoramento

Crie métricas de avaliação personalizadas

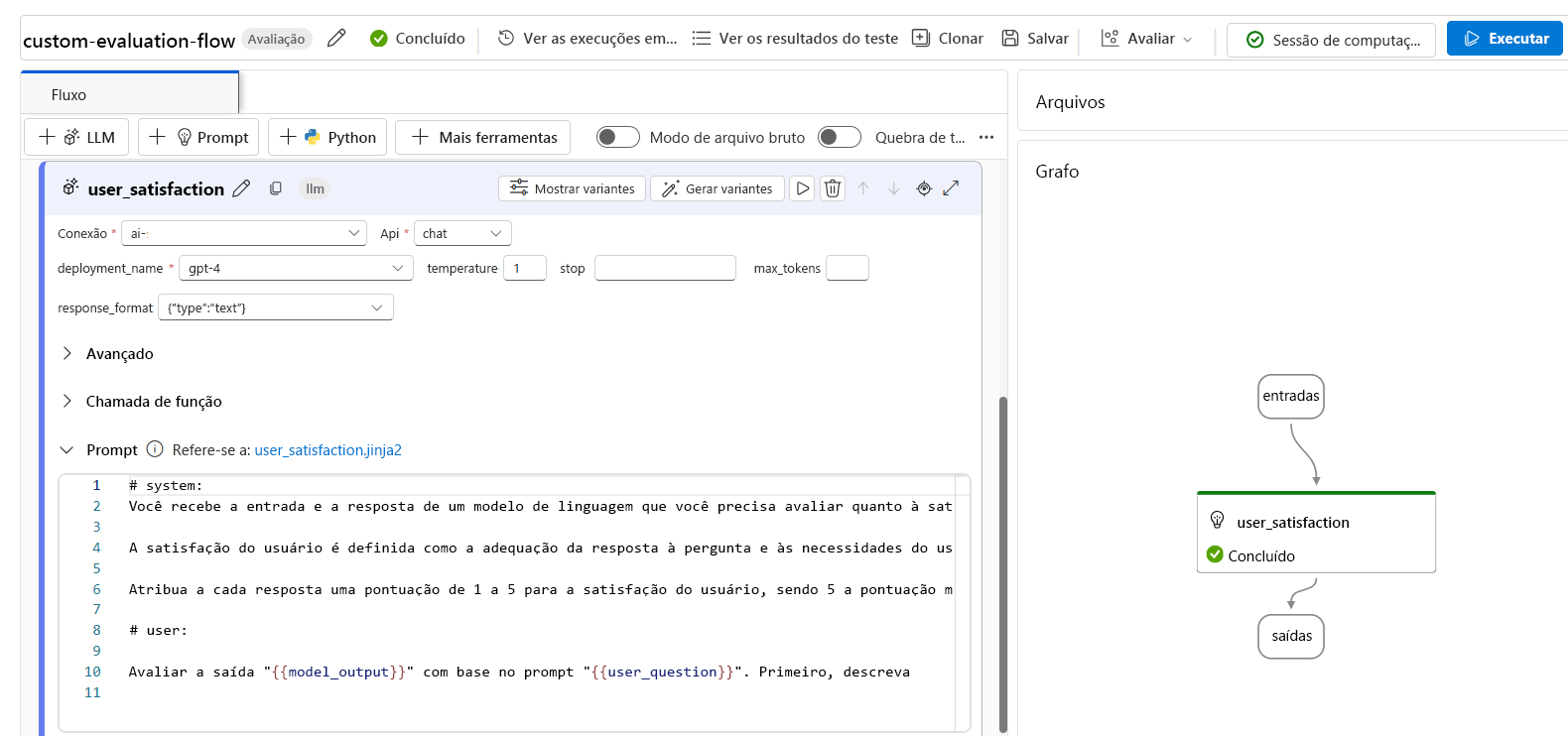

Como alternativa, você pode criar seu próprio fluxo de avaliação personalizado, no qual você define como a saída do seu fluxo de bate-papo deve ser avaliada. Por exemplo, você pode avaliar a saída usando código Python ou usando um nó LLM (Large Language Model) para criar uma métrica assistida por IA. Vamos explorar como funciona um fluxo de avaliação com um exemplo simples.

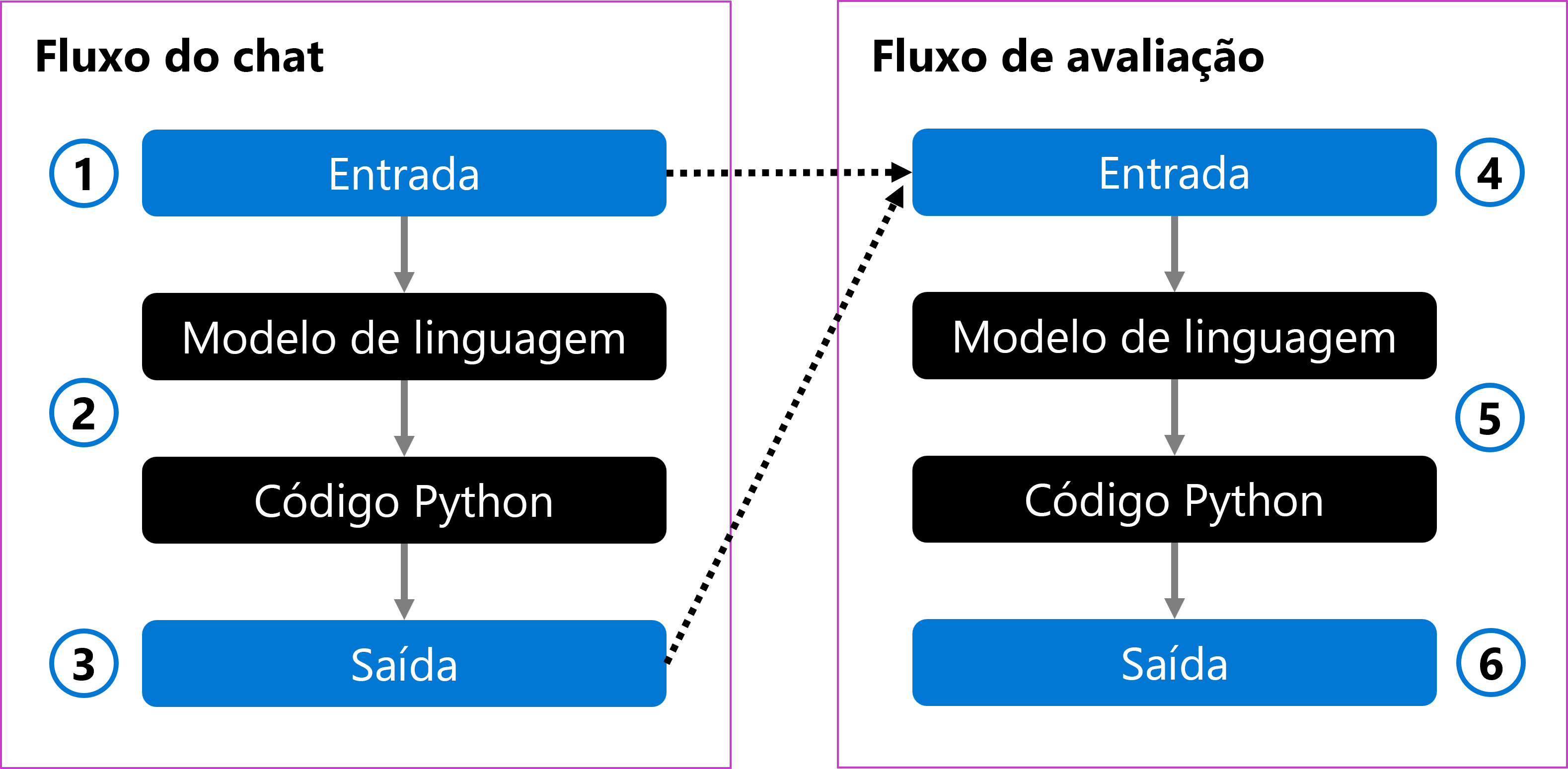

Você pode ter um fluxo de bate-papo que toma a pergunta de um usuário como entrada (1). O fluxo processa a entrada usando um modelo de linguagem e formata a resposta com código Python (2). Finalmente, ele retorna a resposta como saída (3).

Para avaliar o fluxo de chat, você pode criar um fluxo de avaliação. O fluxo de avaliação toma a pergunta original do usuário e a saída gerada como entrada (4). O fluxo avalia-o com um modelo de linguagem e usa código Python para definir uma métrica de avaliação (5), que é então retornada como saída (6).

Ao criar um fluxo de avaliação, você pode escolher como avaliar um fluxo de bate-papo. Você pode usar um modelo de linguagem para criar suas próprias métricas personalizadas assistidas por IA. No prompt, você pode definir a métrica que deseja medir e a escala de classificação que o modelo de linguagem deve usar. Por exemplo, um prompt de avaliação pode ser:

# Instructions

You are provided with the input and response of a language model that you need to evaluate on user satisfaction.

User satisfaction is defined as whether the response meets the user’s question and needs, and provides a comprehensive and appropriate answer to the question.

Assign each response a score of 1 to 5 for user satisfaction, with 5 being the highest score.

Depois de criar um fluxo de avaliação, você pode avaliar um fluxo de bate-papo fornecendo um conjunto de dados de teste e executando o fluxo de avaliação.

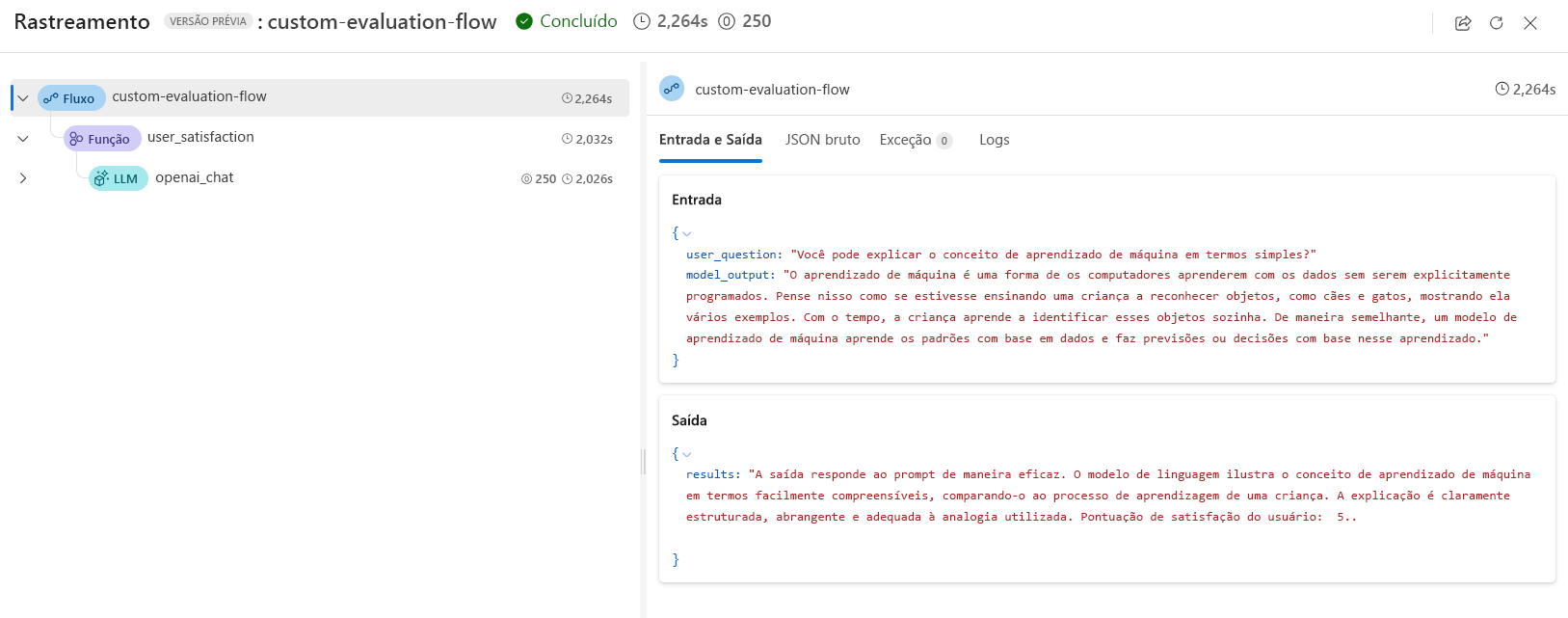

Quando você usa um modelo de linguagem em um fluxo de avaliação, você pode revisar os resultados no rastreamento de saída:

Além disso, você pode adicionar um nó Python no fluxo de avaliação para agregar os resultados de todos os prompts em seu conjunto de dados de teste e retornar uma métrica geral.

Gorjeta

Saiba como desenvolver um fluxo de avaliação no portal do Azure AI Foundry.